带宽、采样率和存储深度是数字示波器的三大关键指标。相对于工程师们对示波器带宽的熟悉和重视,采样率和存储深度往往在示波器的选型、评估和测试中为大家所忽视。这篇文章的目的是通过简单介绍采样率和存储深度的相关理论结合常见的应用帮助工程师更好的理解采样率和存储深度这两个指标的重要特征及对实际测试的影响,同时有助于我们掌握选择示波器的权衡方法,树立正确的使用示波器的观念。

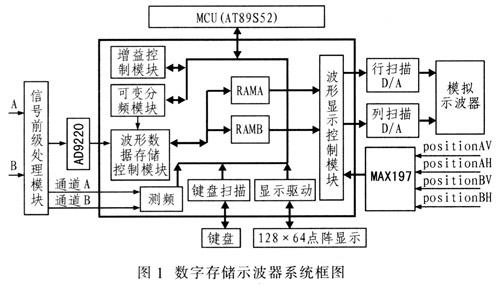

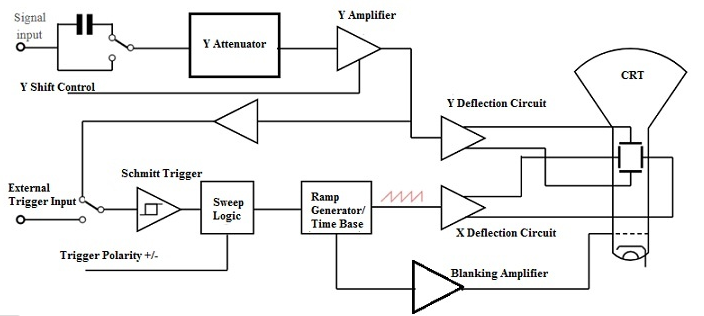

在开始了解采样和存储的相关概念前,我们先回顾一下数字存储示波器的工作原理。

在开始了解采样和存储的相关概念前,我们先回顾一下数字存储示波器的工作原理。

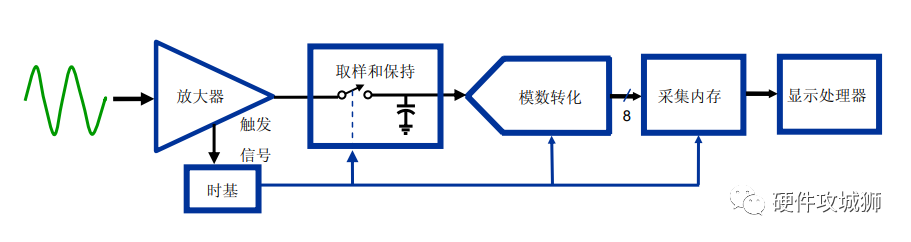

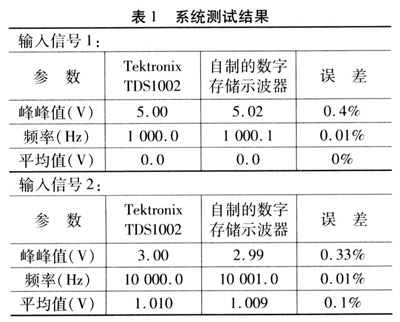

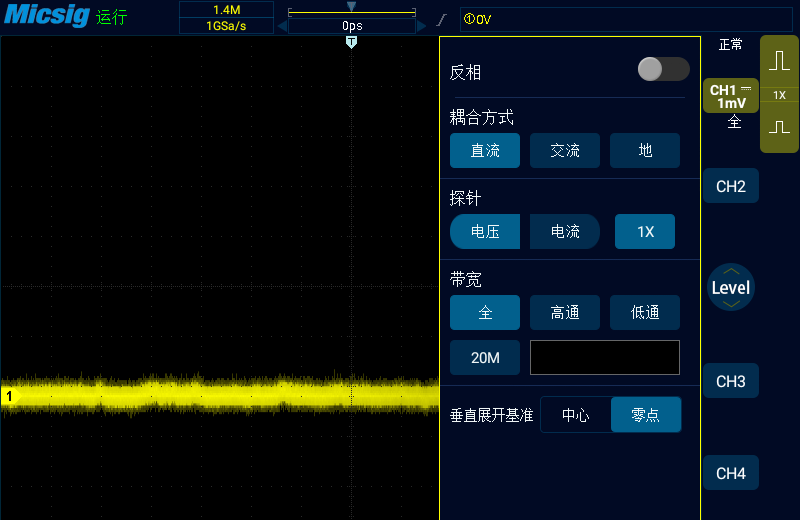

图 1 数字存储示波器的原理组成框图

输入的电压信号经耦合电路后送至前端放大器,前端放大器将信号放大,以提高示波器的灵敏度和动态范围。放大器输出的信号由取样/保持电路进行取样,并由 A/D 转换器数字化,经过 A/D 转换后,信号变成了数字形式存入存储器中,微处理器对存储器中的数字化信号波形进行相应的处理,并显示在显示屏上。这就是数字存储示波器的工作过程。

采样、采样速率

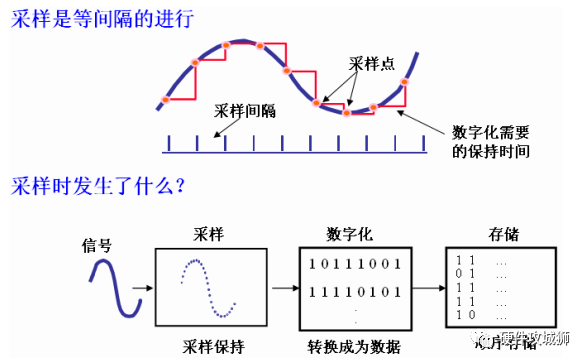

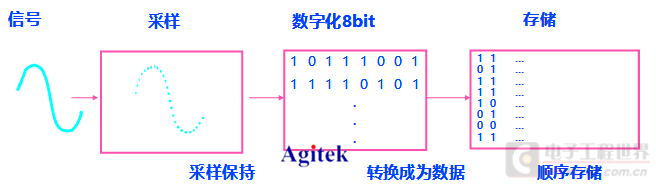

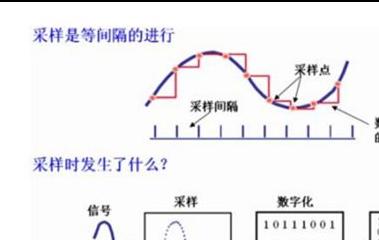

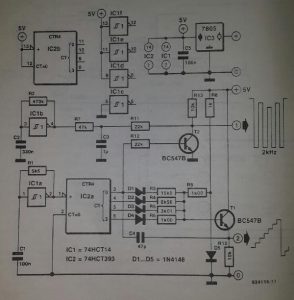

我们知道,计算机只能处理离散的数字信号。在模拟电压信号进入示波器后面临的首要问题就是连续信号的数字化(模/数转化)问题。一般把从连续信号到离散信号的过程叫采样(sampling)。连续信号必须经过采样和量化才能被计算机处理,因此,采样是数字示波器作波形运算和分析的基础。通过测量等时间间隔波形的电压幅值,并把该电压转化为用八位二进制代码表示的数字信息,这就是数字存储示波器的采样。采样电压之间的时间间隔越小,那么重建出来的波形就越接近原始信号。采样率(sampling rate)就是采样时间间隔。比如,如果示波器的采样率是每秒10G次(10GSa/s),则意味着每100ps进行一次采样。

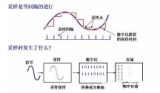

图2 示波器的采样

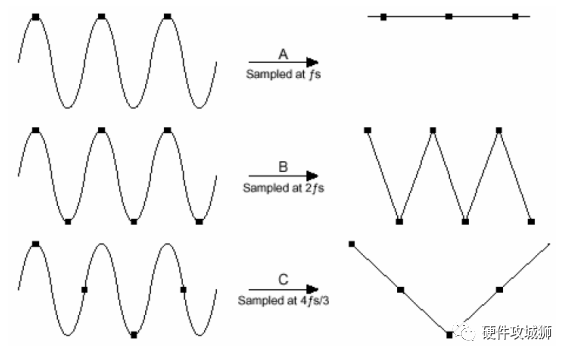

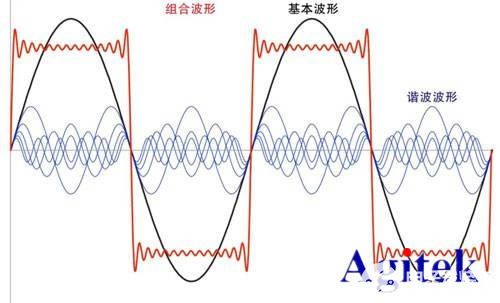

根据Nyquist采样定理,当对一个最高频率为fmax的带限信号进行采样时,采样频率SF必须大于fmax的两倍以上才能确保从采样值完全重构原来的信号。这里,fmax称为Nyquist频率,2f为Nyquist采样率。对于正弦波,每个周期至少需要两次以上的采样才能保证数字化后的脉冲序列能较为准确的还原原始波形。如果采样率低于Nyquist采样率则会导致混叠(Aliasing)现象。

图3 采样率SF<2 f,混叠失真

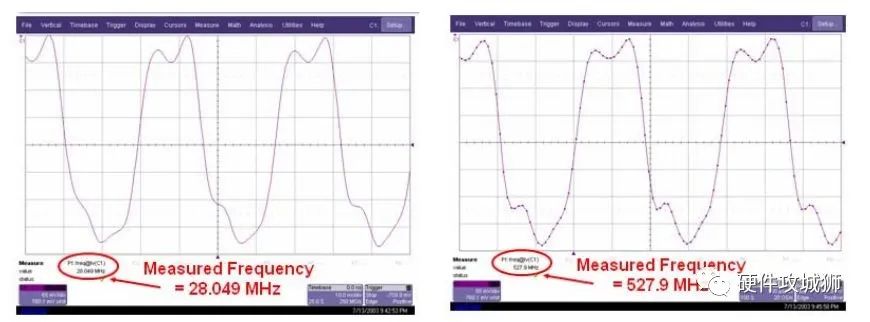

图4和图5显示的波形看上去非常相似,但是频率测量的结果却相差很大,究竟哪一个是正确的?仔细观察我们会发现图4中触发位置和触发电平没有对应起来,而且采样率只有250MS/s,图5中使用了20GS/s的采样率,可以确定,图4显示的波形欺骗了我们,这即是一例采样率过低导致的混叠(Aliasing)给我们造成的假象。

左:250MS/s采样率的波形显示 右:20GS/s采样的波形显示

因此在实际测量中,对于较高频的信号,工程师的眼睛应该时刻盯着示波器的采样率,防止混叠的风险。我们建议工程师在开始测量前先固定示波器的采样率,这样就避免了欠采样。

由Nyquist定理我们知道对于最大采样率为10GS/s的示波器,可以测到的最高频率为5GHz,即采样率的一半,这就是示波器的数字带宽,而这个带宽是DSO的上限频率,实际带宽是不可能达到这个值的,数字带宽是从理论上推导出来的,是DSO带宽的理论值。与我们经常提到的示波器带宽(模拟带宽)是完全不同的两个概念。

那么在实际的数字存储示波器,对特定的带宽,采样率到底选取多大?通常还与示波器所采用的采样模式有关。

采样模式

当信号进入DSO后,所有的输入信号在对其进行A/D转化前都需要采样,采样技术大体上分为两类:实时模式和等效时间模式。

实时采样(real-time sampling)模式用来捕获非重复性或单次信号,使用固定的时间间隔进行采样。触发一次后,示波器对电压进行连续采样,然后根据采样点重建信号波形。

等效时间采样(equivalent-time sampling),是对周期性波形在不同的周期中进行采样,然后将采样点拼接起来重建波形,为了得到足够多的采样点,需要多次触发。等效时间采样又包括顺序采样和随机重复采样两种。使用等效时间采样模式必须满足两个前提条件:1.波形必须是重复的;2.必须能稳定触发。

实时采样模式下示波器的带宽取决于A/D转化器的最高采样速率和所采用的内插算法。即示波器的实时带宽与DSO采用的A/D和内插算法有关。

这里又提到一个实时带宽的概念,实时带宽也称为有效存储带宽,是数字存储示波器采用实时采样方式时所具有的带宽。这么多带宽的概念可能已经看得大家要抓狂了,在此总结一下:DSO的带宽分为模拟带宽和存储带宽。通常我们常说的带宽都是指示波器的模拟带宽,即一般在示波器面板上标称的带宽。而存储带宽也就是根据Nyquist定理计算出来的理论上的数字带宽,这只是个理论值。

通常我们用有效存储带宽(BWa)来表征DSO的实际带宽,其定义为:BWa=最高采样速率 / k,最高采样速率对于单次信号来说指其最高实时采样速率,即A/D转化器的最高速率;对于重复信号来说指最高等效采样速率。K称为带宽因子,取决于DSO采用的内插算法。DSO采用的内插算法一般有线性(linear)插值和正弦(sinx/x)插值两种。K在用线性插值时约为10,用正弦内插约为2.5,而k=2.5只适于重现正弦波,对于脉冲波,一般取k=4,此时,具有1GS/s采样率的DSO的有效存储带宽为250MHz。

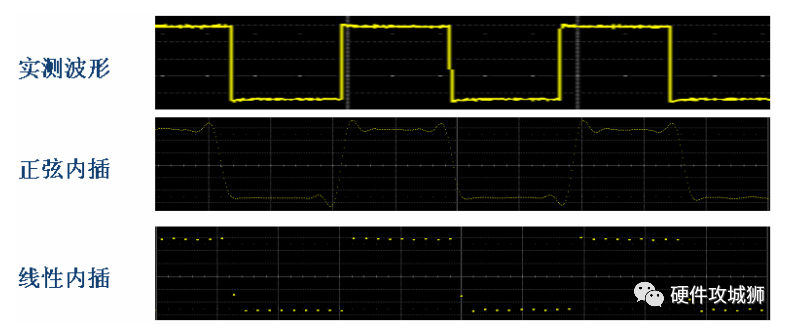

图6 不同插值方式的波形显示

内插与最高采样率之间的理论关系并非本文讨论的重点。我们只须了解以下结论:在使用正弦插值法时,为了准确再显信号,示波器的采样速率至少需为信号最高频率成分的2.5倍。使用线性插值法时,示波器的采样速率应至少是信号最高频率成分的10倍。这也解释了示波器用于实时采样时,为什么最大采样率通常是其额定模拟带宽的四倍或以上。

在谈完采样率后,还有一个与DSO的A/D密切相关的概念,就是示波器的垂直分辨率。垂直分辨率决定了DSO所能分辨的最小电压增量,通常用A/D的位数n表示。前面我们提到现在DSO的A/D转换器都是8位编码的,那么示波器的最小量化单位就是1/256,(2的8次方),即0.391%。了解这一点是非常重要的,对于电压的幅值测量,如果你示波器当前的垂直刻度设置成1v/div的档位,那意味着你的测量值有8V*0.391%=31.25mV以内的误差是正常的!!!因为小于31.25mV的电压示波器在该档位下已经分辨不出来了,如果只用了4位,那测出来的误差更惊人!所以建议大家在测量波形时,尽可能调整波形让其充满整个屏幕,充分利用8位的分辨率。我们经常听到有工程师抱怨示波器测不准他的电压或者说测量结果不一致,其实大多数情况是工程师还没有理解示波器的垂直分辨率对测量结果的影响。这里顺便提一下,关于示波器的测量精度问题,必须澄清一点——示波器本身就不是计量的仪器!!!它是“工程师的眼睛”,帮助你更深入的了解你的电路的特征。做个广告:经常做电源测量或者纹波测量,或者想深入了解示波器量化误差的工程师,大家可以参考我的同事Frankie博客的一片文章《示波器不是垂直量的计量工具》http://blog.sina.com.cn/s/blog_521262a301009ryp.html

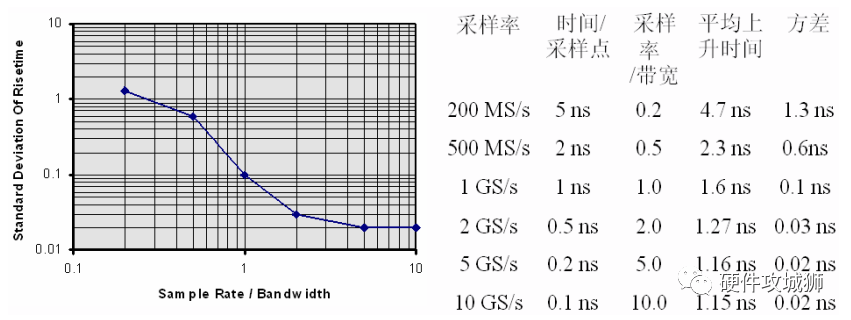

图7 是用模拟带宽为1GHz的示波器测量上升时间为1ns的脉冲,在不同采样率下测量结果的比较,可以看出:超过带宽5倍以上的采样率提供了良好的测量精度。进一步,根据我们的经验,建议工程师在测量脉冲波时,保证上升沿有5个以上采样点,这样既确保了波形不失真,也提高了测量精度。

图7 采样率与带宽的关系

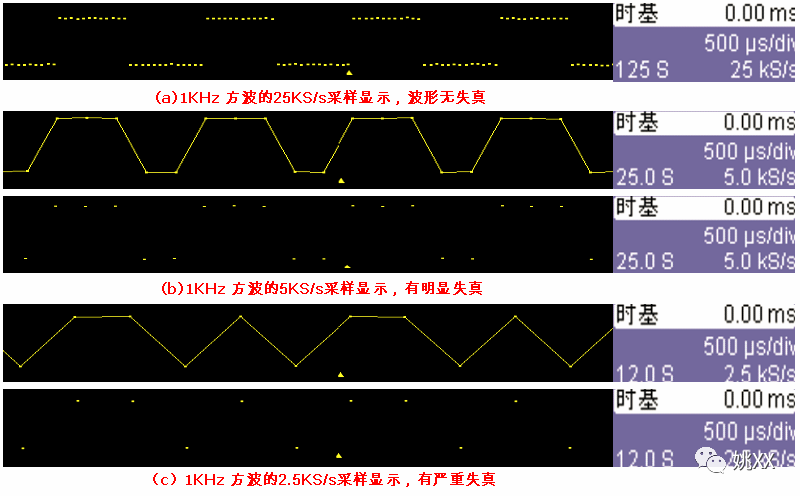

图8 采样率过低导致波形失真

提到采样率就不能不提存储深度。对DSO而言,这两个参量是密切相关的。

存储、存储深度

把经过A/D数字化后的八位二进制波形信息存储到示波器的高速CMOS存储器中,就是示波器的存储,这个过程是“写过程”。存储器的容量(存储深度)是很重要的。对于DSO,其最大存储深度是一定的,但是在实际测试中所使用的存储长度却是可变的。

在存储深度一定的情况下,存储速度越快,存储时间就越短,他们之间是一个反比关系。存储速度等效于采样率,存储时间等效于采样时间,采样时间由示波器的显示窗口所代表的时间决定,所以:

存储深度 = 采样率 × 采样时间(距离 = 速度×时间)

力科示波器的时基(Time Base)标签即直观的显示了这三者之间的关系,如图9所示

图9 存储深度、采样率、采样时间(时基)的关系

由于DSO的水平刻度分为10格,每格的所代表的时间长度即为时基(time base),单位是t/div,所以采样时间= time base × 10.

由以上关系式我们知道,提高示波器的存储深度可以间接提高示波器的采样率:当要测量较长时间的波形时,由于存储深度是固定的,所以只能降低采样率来达到,但这样势必造成波形质量的下降;如果增大存储深度,则可以以更高的采样率来测量,以获取不失真的波形。

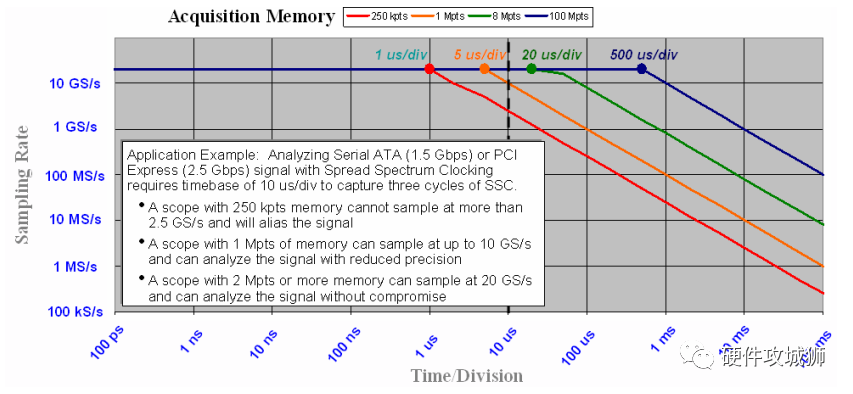

图10的曲线充分揭示了采样率、存储深度、采样时间三者的关系及存储深度对示波器实际采样率的影响。比如,当时基选择10us/div档位时,整个示波器窗口的采样时间是10us/div * 10格=100us,在1Mpts的存储深度下,当前的实际采样率为:1M÷100us=10Gs/s,如果存储深度只有250K,那当前的实际采样率就只要2.5GS/s了!

图10 存储深度决定了实际采样率的大小

一句话,存储深度决定了DSO同时分析高频和低频现象的能力,包括低速信号的高频噪声和高速信号的低频调制。

在谈完采样率和存储深度这两个指标的相关理论后,接下来结合常见的应用,我们一起更深入的了解一下这两个参数对我们实际测试的影响。

电源测量中长存储的重要性

由于功率电子的频率相对较低(大部分小于1MHz),对于习惯于用高带宽示波器做高速信号测量的工程师来说,往往有一种错觉,电源测量可能很简单,事实是对于电源测量应用中的示波器选择不少工程师犯了错误,虽然500MHz的示波器带宽相对于几百KHz的电源开关频率来说已经足够,但很多时候我们却忽略了对采样率和存储深度的选择。比如说在常见的开关电源的测试中,电压开关的频率一般在200KHz或者更快,由于开关信号中经常存在着工频调制,工程师需要捕获工频信号的四分之一周期或者半周期,甚至是多个周期。开关信号的上升时间约为100ns,我们建议为保证精确的重建波形需要在信号的上升沿上有5个以上的采样点,即采样率至少为5/100ns=50MS/s,也就是两个采样点之间的时间间隔要小于100/5=20ns,对于至少捕获一个工频周期的要求,意味着我们需要捕获一段20ms长的波形,这样我们可以计算出来示波器每通道所需的存储深度=20ms/20ns=1Mpts !!!同样,在分析电源上电的软启动过程中功率器件承受的电压应力的最大值则需要捕获整个上电过程(十几毫秒),所需要的示波器采样率和存储深度甚至更高!

很遗憾的是我经常看到有工程师用一台每通道仅有10K存储深度的示波器进行上面的电源测试!!!由此而愈发的感觉到作为示波器厂商有必要付出更多的精力和时间帮助工程师们建立使用示波器的正确观念。这也是我们深圳office写系列文章的初衷。

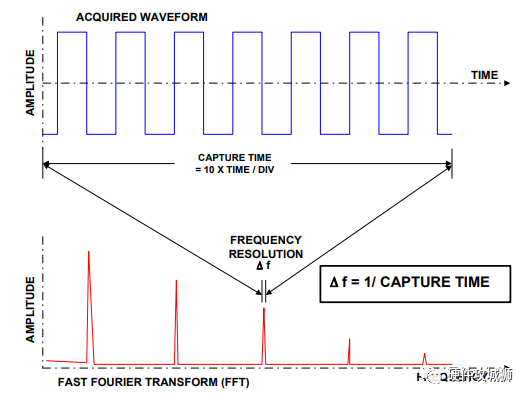

存储深度对FFT结果的影响

在DSO中,通过快速傅立叶变换(FFT)可以得到信号的频谱,进而在频域对一个信号进行分析。如电源谐波的测量需要用FFT来观察频谱,在高速串行数据的测量中也经常用FFT来分析导致系统失效的噪声和干扰。对于FFT运算来说,示波器可用的采集内存的总量将决定可以观察信号成分的最大范围(奈奎斯特频率),同时存储深度也决定了频率分辨率△f。如果奈奎斯特频率为500 MHz,分辨率为10 kHz,考虑一下确定观察窗的长度和采集缓冲区的大小。若要获得10kHz 的分辨率,则采集时间至少为:T = 1/△f = 1/10 kHz = 100 ms,对于具有100 kB 存储器的数字示波器,可以分析的最高频率为:

△f × N/2 = 10 kHz × 100 kB/2 = 500 MHz

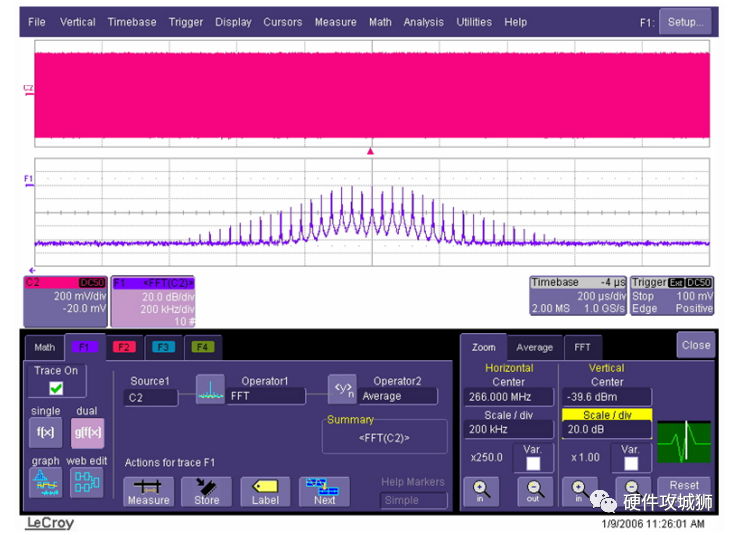

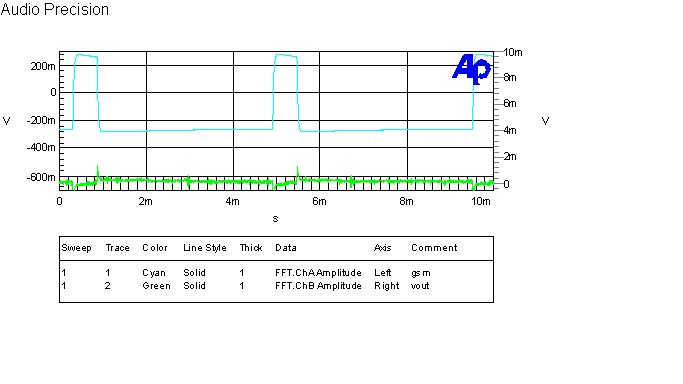

在图12所示的例子中,266 MHz信号受到来自30 kHz噪声源的捡拾噪声的影响。FFT (下方的轨迹)显示了以266 MHz为中间、相距30 kHz的一系列峰值。这种失真十分常见,可能是由于开关式电源、DC-DC转换器或其它来源的串扰导致的。它也可能是由故意使用扩频时钟导致的。

图12 力科示波器的FFT分析

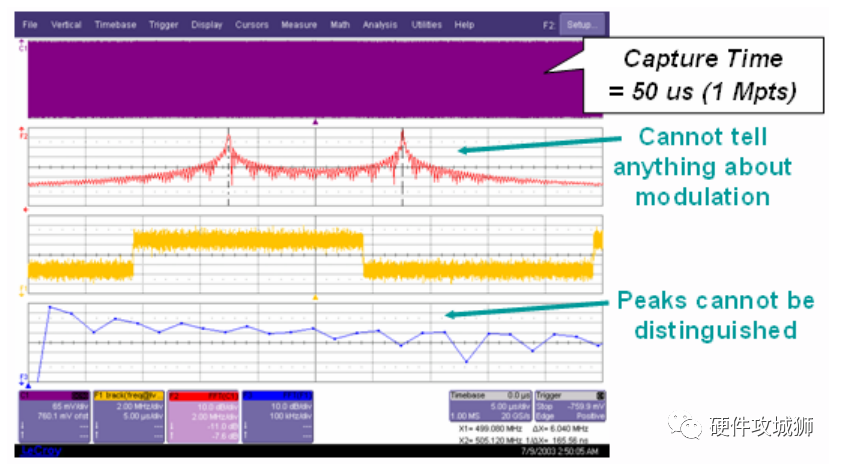

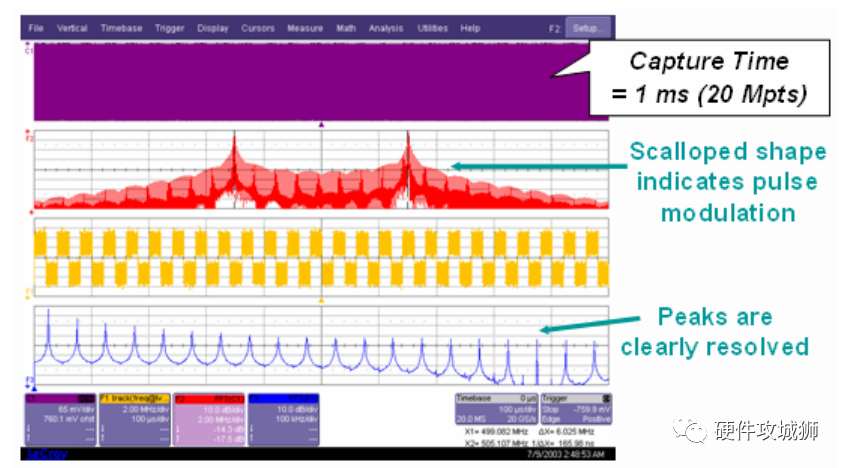

对于DSO来说,长存储能产生更好的FFT结果,既增加了频率分辨率又提高了信号对噪声的比率。另外,针对某些应用,一些非常细节的信息需要在20Mpts的存储深度下才能分析出来,如图13、14所示。

图13 1M点的FFT结果无法了解有关调制的信息

图14 20M点的FFT清晰的确认了时钟的双峰分布及相关调制规律

需要指出的是,对于长波形的FFT分析需要示波器超强的数据处理能力,这往往超出了某些示波器的运算极限。力科示波器最大可以做25M点的FFT,业内T公司的示波器最大则只能做3.125M点的FFT分析。

高速串行信号分析需要真正意义的长存储

抖动分析和眼图测试已成为分析高速串行链路的重要手段,也成为评估高端示波器的重要参考。

当使用示波器进行抖动测试时,高速采集内存长度是示波器进行抖动测试的关键指标。高速内存长度不仅决定了一次抖动测试中样本数的多少,还决定了示波器能够测试的抖动频率范围。这是因为所有的抖动都具有不同的频率分量,其通常从DC直流到高频部分。示波器单次采集时间窗口的倒数即表明了抖动测试的频律范围。例如,你用一个具有 20G 采样/秒(S/s)的采样率和 1M采样内存的示波器捕获一个 2.5Gbps 信号,那么你的示波器屏幕上就能捕捉到50 微秒长的一段波形,意味着你能捕获到一个频率为 20kHz的低频抖动周期。同样的,对于20GS/s采样率100M存储深度(如力科的SDA6000AXXL),则可以捕获到200Hz的低频抖动周期。

而传统示波器设计时采用将高速采集前端(多达80颗ADC)和高速内存在物理上用一颗SoC芯片实现,由于有太多功能在一个芯片内部,导致片内高速内存容量的限制(在40GS/s下一般小于2M),只能测量到20KHz以上的抖动,并且当需要测试低频抖动时,无法对内存扩展升级。对于大多数应用,测试和分析200Hz到20KHz范围内的抖动信息非常重要。为了弥补这种设计结构的缺陷,这类示波器会采用外部的低速存储器弥补片内高速内存,但外部存储器不能在高采样率下工作,一般只能提供2GS/s,无法提供有意义的抖动测试结果。例如,当使用40GS/s实时高速采集时,512K内存一次采集数据量仅为12.5us,只能测试频率范围为80K以上的抖动。在各种串行总线和时钟抖动测试中都很难满足测试要求。

在眼图测试中,由于力科率先采用的软件时钟恢复(CDR)技术已成为行业标准,在高速串行总线大行其道的今天,需要示波器有更强的数据处理能力对大量的数据样本做实时的眼图分析。比如,对PCIE-G2等眼图分析都需要一次对1百万个UI的数据进行测量,并非所有厂商的示波器都能像力科示波器一样能对所有捕获到的数据样本做实时的、动态的眼图测量。例如,T公司的示波器如需对一百万个UI的数据做眼图就只能借助sigtest软件来完成,因为它默认每次只能对12K UI做眼图,我们知道用sigtest做眼图的效率是很低的,对于定位问题及调试而言并不是很好的工具。力科示波器的眼图测量功能则没有这种限制。

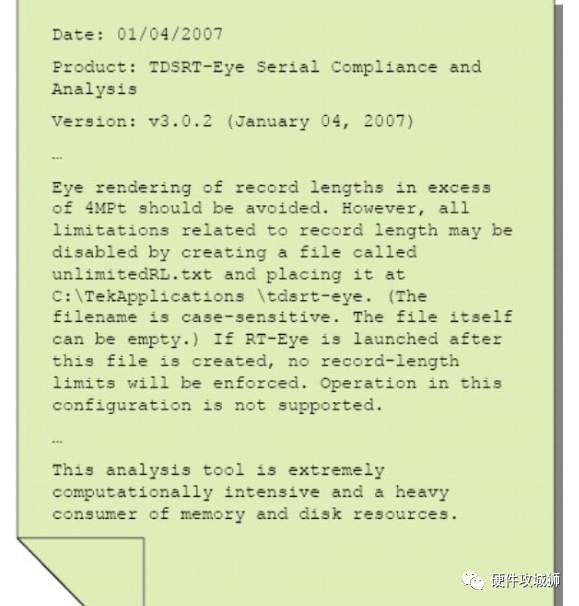

例如,对于PCIE-G2的眼图测试,一个UI = 1/(5 Gb/s) = 200 ps,捕获连续的1个million UI的数据样本即200微秒, 在40GS/s的采样率下,需要的存储深度达到8M,遗憾的是,这个数据量的处理会导致T公司的示波器崩溃死机的!这也是为什么T公司的示波器默认的一次只做12K UI眼图的原因,这也是在做高速串行信号眼图测量时T公司的示波器只相当于一个昂贵的“数据采集卡”,而眼图的测试必须要借助于sigtest软件来完成的原因。图15是T公司内部的一份文档对这个问题作了说明。

图15 T公司对眼图软件的说明

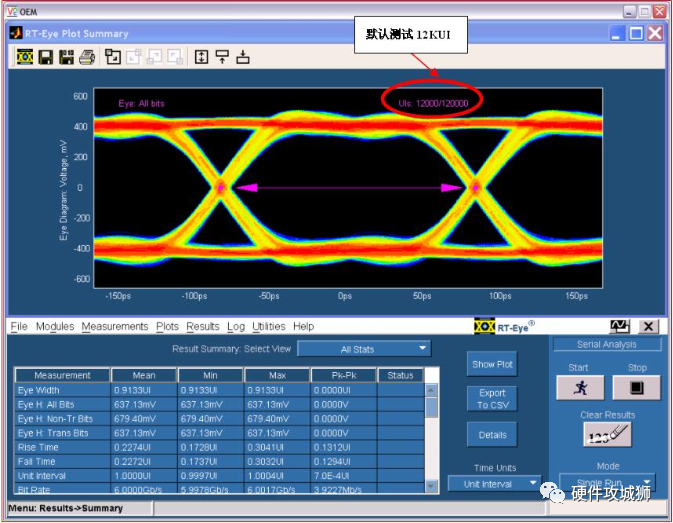

T公司示波器缺省模式下最大只处理12k个UI的眼图,即使当前采集了更长的波形,如果当前采集了250K UI,则眼图中一个lable会显示,第一次触发时为“12000/250000”,第二次触发后为“24000/500000”。

图16 T公司示波器默认测量12K UI的眼图

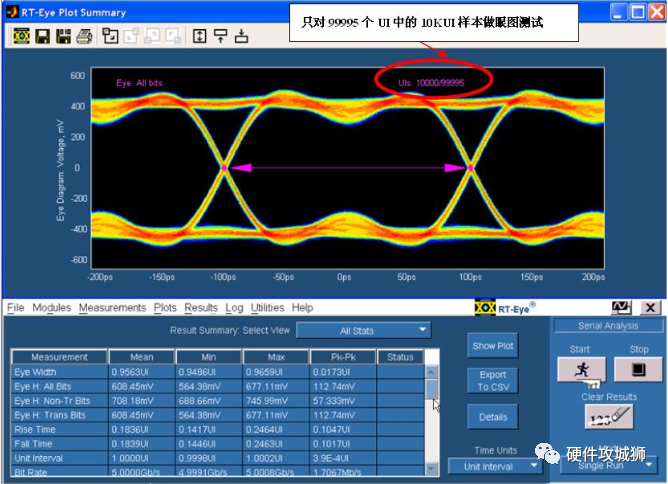

图17 T公司示波器眼图测试数据样本一次不超过12K UI

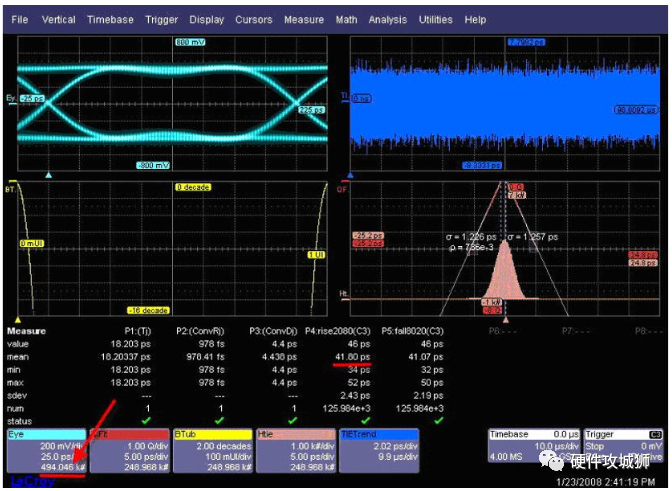

图18 和图19是某次现场PK中T公司示波器对2.875Gbps信号的眼图测试结果,和力科示波器对5Gbps信号的测量结果的对比(当时T公司拒绝测试PRBS信号源发出的5Gbps信号,承认他们测不出来,后来就只测试了2.875Gbps的信号)。

图18 T公司的测试结果,注意--只用了捕获到574996个UI中很少的8k数据

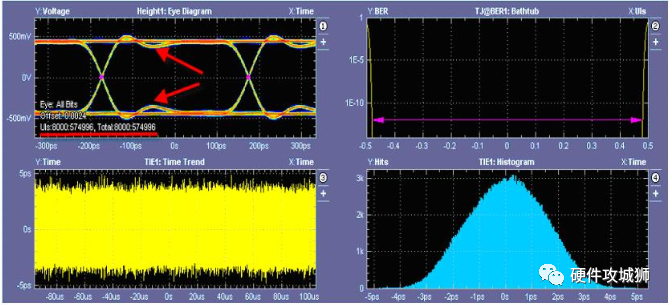

图19

图19 力科示波器对一次性捕获到的494.046K数据做眼图的结果

审核编辑:汤梓红

电子发烧友App

电子发烧友App

评论