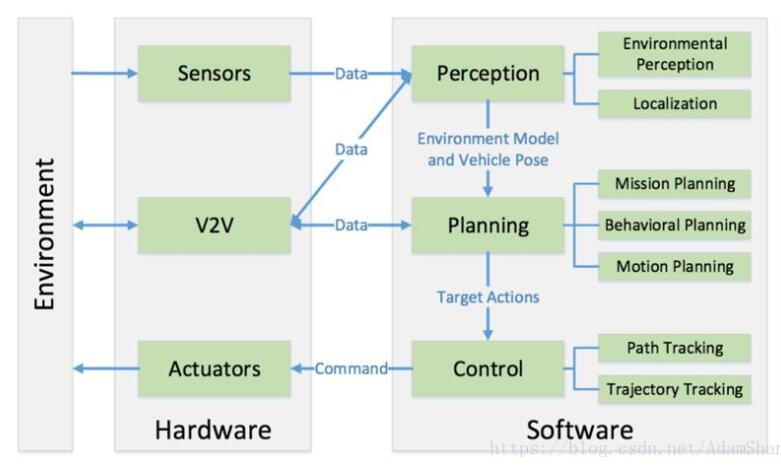

特斯拉在五月份发生的无人驾驶事故,和最近在Defcon上演示的如何干扰传感器,都充分说明了传感器在无人驾驶中的重要性:环境感知是无人驾驶实现的基础,如果不能正确地感知周围环境,那么接下来的认知、决策与控制,都是空中楼台。

从传感器技术发展本身来说,要在接下来十年里保证无人驾驶车安全地上路,硬件性能与背后的软件算法,以及不同传感器之间的数据融合,都是需要提升的地方。

△车辆上的各式各样传感器

传感器在无人驾驶的重要性无需赘言。

特斯拉的Autopilot系统通过摄像头、毫米波雷达与超声波雷达的融合数据来控制车辆在高速路车道行驶、变道以及根据交通情况调整车速。

谷歌的全无人驾驶测试车用的是价格昂贵、结构复杂的远距传感系统LiDAR(激光雷达)。

丰田透露过他们的高速道路无人驾驶汽车上有12个传感器:1个藏在内后视镜里的前摄像头,5个测量周围车辆速度的雷达,和6个探测周围目标位置的激光雷达5。

尽管也有一些企业另辟蹊径,希望通过V2X技术来完成环境感知的工作,但是V2X严重依赖于基础设施,而传感器则不受这个限制。

激光雷达

LiDAR系统使用的是旋转激光束。宝马、谷歌、日产和苹果的无人驾驶试验车用的就是这项技术。但要想在量产车上应用,价格必须大幅下降。业内普遍认为,再过几年这个目标就能实现。

△激光雷达工作原理(图片来自Velodyne)

激光雷达的工作原理是通过发射和接收激光束来实现的。在其内部,每一组组件都包含一个发射单元与接收单元。上图的Velodyne使用了旋转镜面的设计。

这套发射/接收组件和旋转镜面结合在一起,能扫描至少一个平面。镜面不只反射二极管发出去的光,而且也能把反射回来的光再反射给接收器。通过旋转镜面,能够实现90到180度的视角,并且大大降低系统设计和制造的复杂度,因为镜面是这里面唯一的运动机构。

脉冲光以前被用于探测距离。探测距离的原理是基于光返回的时间,激光二极管发出脉冲光,脉冲光照射到目标物后反射一部分光回来,在二极管附近安装一个光子探测器,它可以探测出返回来的信号,通过计算发射和探测的时间差就可以计算出目标物的距离。脉冲距离测量系统一旦被激活就能收集到大量的点云。

如果点云中有目标物,目标物就会在点云中呈现出一个阴影。通过这个阴影可以测量出目标物的距离和大小。通过点云可以生成周围环境的3D图像。点云密度越高,图像越清晰。

通过激光雷达来生成周围环境的3D图像有几种不同的方式。

一种实现方法是让发射/接收组件上下移动同时让镜面旋转,有时也叫这种方法为“眨眼点头”。这种方法能生成高度方向上的点云,但是减少了方位数据点(azimuthdatapoints),因此点云密度会降低,分辨率也不够高。

另一种方法叫“光扫描激光雷达”(flashLiDAR)。这种方法是使用2D焦平面阵列(FocalPlaneArray,FPA)捕捉像素距离信息,同时发出激光来照射大块面积。这类传感器结构复杂,制造困难,因此还没有广泛的商业应用。但是它属于固态传感器,没有运动部件,因此将来有可能替代现有的机械式传感器。

目前虽然有不同的LiDAR结构可以产生很多形式的3D点云系统,但是还没有一种系统能达到无人驾驶导航的应用要求。比如说,有很多系统能生成精致的图像,但是产生一幅图像需要花好几分钟。这种系统就不适合移动传感类的应用。还有一些光扫描系统的刷新率很高,但视角和探测距离又太小。另外还有一些单光束(singlebeam)系统能提供有用的信息,但是如果目标太小或者超出了视角就探测不到了。

要想让LiDAR传感器的使用最大化,必须要能够看到周围所有的地方,也就是所说的需要实现360度视角;最终给用户输出的数据要有实时性,因此必须使数据收集和画面生成之间的时间延迟最小化。驾驶员的反应时间一般是十分之几秒,如果我们要实现无人驾驶导航,那么导航电脑的刷新率至少要达到十分之一秒。视角也不能只看水平方向,还需要有高度方向的视角,否则车就会掉到路上的坑里。垂向视角应该向下尽可能的靠近车辆,以便让无人驾驶适应路面的颠簸和陡坡。

目前,业内有数家生产制造激光雷达的企业,他们的产品也有着各自的特色。

Velodyne拥有高精度激光雷达技术(HDL),据称其HDL传感器能够提供360度水平视角,26.5度的垂直视角,15Hz的刷新率,并可以每秒生成一百万像素的点云。今年Velodyne推出了小型化的32线传感器,可以实现200米的探测距离,垂直视角28°。

△Velodyne固态32线UltraPack激光雷达

Leddar公司同样也有具备360°探测能力的激光雷达产品。并且,因为同时提供ADAS解决方案,Leddar同样也提供传感器融合技术,把不同传感器的数据组合在一起,从而形成车辆周边环境的整体图像。

固态LiDAR——替代摄像头/雷达或者作为它们的补充,可集成到ADAS以及无人驾驶功能中;

为高级别无人驾驶提供高密度点云的LiDAR;

可以支持光扫描或者光束测量的LiDAR(例如MEMS镜面);

Ledaar的激光雷达探测距离可达250m,水平视角可达到140度,每秒可生成48万像素的点云,水平和垂直方向的分辨率可达0.25度。

导读: 特斯拉在五月份发生的无人驾驶事故,和最近在Defcon上演示的如何干扰传感器,都充分说明了传感器在无人驾驶中的重要性:环境感知是无人驾驶实现的基础,如果不能正确地感知周围环境,那么接下来的认知、决策与控制,都是空中楼台。

视觉图像传感器

现在一个很广泛的应用是将2D激光雷达与视觉传感器相结合,不过相比于激光雷达,视觉传感器低成本的特性,也让其成为了在无人驾驶解决方案中不可或缺的存在。

通过视觉传感器的图像识别技术对周边环境进行感知,对于无人驾驶而言,除了知道在什么位置存在什么物体/行人之外,进而像车辆发出减速刹车等指令来避免事故这一功能之外,是以图像识别为基础,能够理解当前的驾驶场景,并学会处理突发事件。

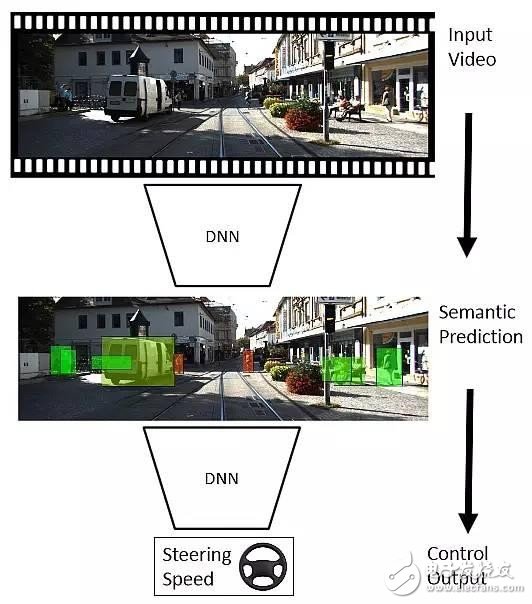

△视觉传感器工作流程

如果说激光雷达的难度在于如何让其性能能够满足无人驾驶导航的需求,那么摄像头的难度则在于从感知拔高到认知的这一过程。

以人眼来进行类比的话,人类驾驶员在看到行人或车辆之后,会基于看到的景象对行人或车辆的下一步行动有个预判,并根据预判来控制车辆。无人驾驶车同样需要这个「预判」的过程,而摄像头就起到观察的作用。无人驾驶汽车必须能够对车内人员、车外行人、车附近人们的行为进行观察、理解、建模、分析和预测。

这个从观察到预测的过程同样适用于道路上的其他车辆,不过,如何获取驾驶场景的整体含义,如何处理突发的场景和目标,如何针对特定目标(行人或车辆)准确进行短时或长时的行为分析,以及如何对周边的人或车辆进行行为预测并决策,这些技术都有待于进一步的深入研究。

车云小结

传感器和算法的研究和相应的工程技术正在快速发展,它们可以使无人驾驶汽车预测人和车辆的不确定行为,并快速响应以避免车辆、财产的损失,更重要的是能够保护珍贵的生命。

当然,无人驾驶的传感器并不只是激光雷达与摄像头两类,毫米波雷达与超声波雷达,以及目前还并没有为无人驾驶所用的声音传感器。

电子发烧友App

电子发烧友App

评论