随着图像传感器和新型传感器的大幅进步,视觉系统正迅速变得无所不在。 虽然传感器本身通常是采用成熟节点芯片开发的,但它越来越多地与在最先进节点开发的视觉处理器相连。这使得每瓦性能达到了最高水平,而且还可以设计使用AI预训练模型的AI加速器,同时仍然保持足够小的尺寸与合适的温度范围,可用于AR/VR头盔、手机和汽车舱内传感器,在这些场景中通常同时采用多个摄像头。

嵌入式视觉峰会总主席、Edge AI和视觉联盟创始人、BDTI总裁Jeff Bier说:“十年前,还没有广泛使用的计算机视觉处理器。今天,有几十个。这很重要,因为计算机视觉算法非常适合用并行处理进行加速。因此,与通用处理器相比,采用专门架构的处理器可以轻松实现100倍的性能和效率。处理器效率的巨大提升使得在数千个新应用中部署计算机视觉成为可能。” 在过去,所有这些都必须从零开始开发。但这些系统正在成熟。如今,半导体和AI公司正在提供现成的视觉处理模型和训练过的数据集的平台,开发者可以将其作为新系统的基础。这在医学领域很明显,例如,计算机视觉正在帮助放射科医生解读X光片。

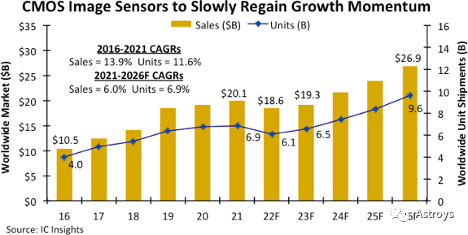

Flex Logix的高级营销总监Sam Fuller说:“AI的出现使人们能够理解图像,并开始减轻人们的负担,比如放射科医生,使他们更有效率。在算法开发及产品转化方面,还有很多工作要做。” Mixel的创始人兼CEO Ashraf Takla表示:“AI/ML和边缘计算的应用发展势头良好,可以最小化视频数据的传输量,从而降低功耗并提高系统效率。” 更小、更智能、更高效的摄像头随处可见。视觉系统涵盖了从手机摄像头到工业自动化、汽车、医疗、安全、监控、无人机、机器人、AR/VR等各个领域。对视觉和图像系统组件的需求在逐年增加。 视觉处理半导体市场分为视觉处理器(VPU)和图像信号处理器(ISP)。Mordor Intelligence的数据显示,这两个市场的CAGR预计都为7%。亚太地区的需求量最大,其次是北美和欧洲。ST、TI、Sigma、Semiconductor Components Industries和Fujitsu是一些较大的半导体公司,但许多新老玩家都在视觉处理市场。Flex Logix、Ambarella、SiMa.ai、Hailo.ai和Brainchip都取得了长足进步。一些EDA公司正在提供具有视觉和AI功能的IP。 IC Insights预测,图像传感器的需求也不能忽视,但由于智能手机需求的下滑,CMOS可能会遭遇暂时的需求放缓。

图1:由于在家办公的需求有所缓解,智能手机和笔记本销量下滑,预计CMOS图像传感器的需求将放缓。(数据来源:IC Insights) 与此同时,根据SkyQuest技术咨询公司的数据,全球图像传感器市场预计将在2022-2028年期间以8.43%的CAGR增长,到2028年将达到301.2亿美元。图像传感器市场占有率排名前六的公司是Sony、Samsung、OmniVision、ST、ONSemi和Panasonic。

新型图像传感器

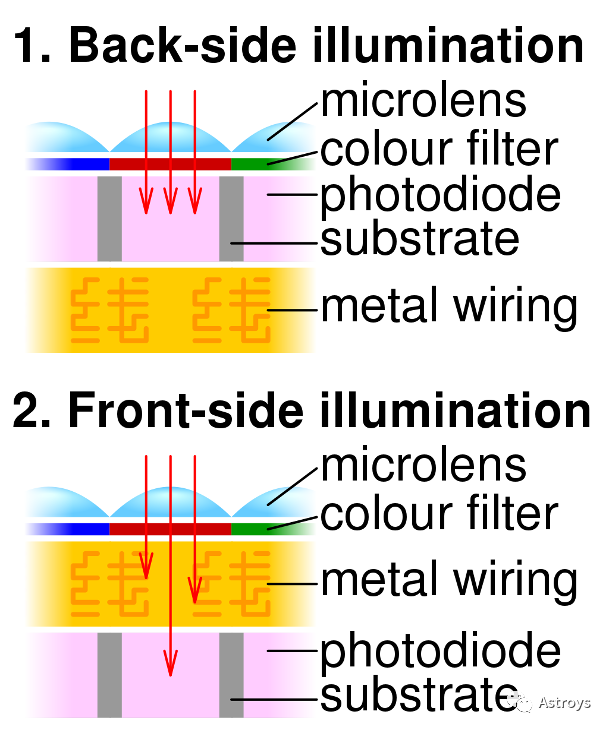

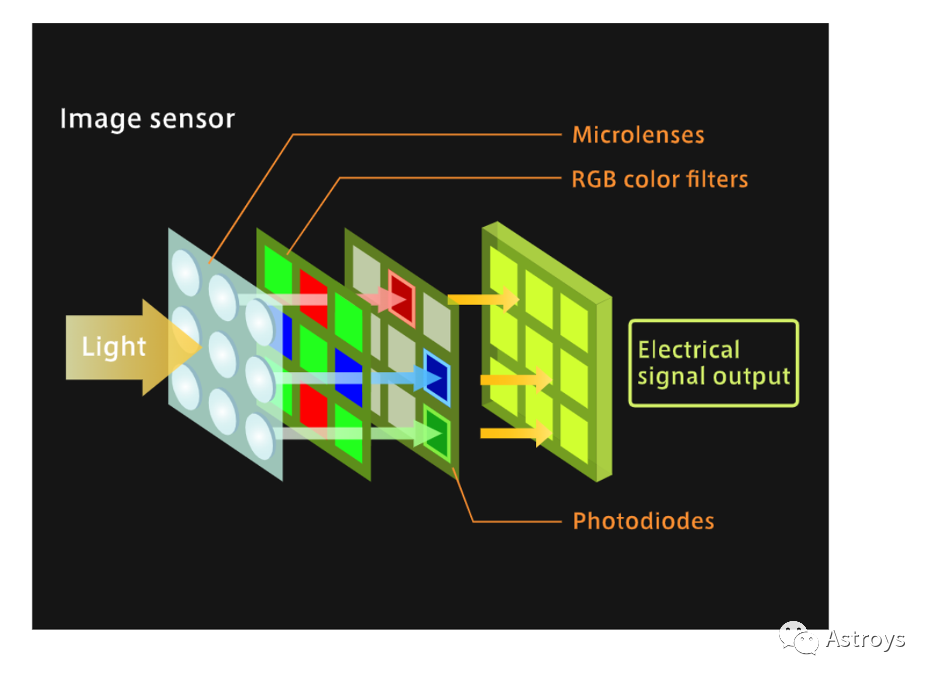

在电子视觉系统中,图像传感器使用光学、像素和感光元件(光电二极管或光电门)将光转换为电信号或比特。然后,数据pipeline将信号发送到处理器,在处理器中将信号转换为数字图像。 图像传感器在传感器上有一层光学器件来聚焦光线,但根据用例,还可以在上面添加另一层更复杂的光学器件。OmniVision的IoT/新兴部门营销总监Devang Patel说:“这意味着基本上传感器只发送原始数据,然后有一个主处理器。例如,Qualcomm或ambarella处理器将完成所有后端处理,转换为YUV、JPEG进行视频录制,” 两种常见的图像传感器类型,CMOS(complementary metal oxide semiconductor)和CCD(charge coupled device)将光转换成电荷,并将其处理成电信号。CCD使用的是高压模拟电路,正如TEL所描述的,它的像素阵列有一个桶状结构,将电荷移动到顶层行,作为一个读数寄存器。然后,读数寄存器将电荷输出到传感器外的处理器。 CCD有两种类型,FSI(frontside illumination)和BSI(backside illumination)传感器。区别在于光电二极管衬底在传感器中的位置。 OmniVision的Patel说:“所有高性能传感器几乎都是BSI。”

图2: BSI和FSI图像传感器示意图(来源:Cmglee)

CMOS传感器的生产成本比CCD低,因为CMOS可以在现有的半导体制造设备上制造。CMOS的能耗也更低。CMOS图像传感器中的每个像素都有自己的光电二极管直接输出信号。 相比之下,CCD基于NMOS,被认为比CMOS噪声更小。因此,它们是科学设备和高分辨率扫描仪的首选。CMOS被用于大多数其他应用,因为它在功耗和成本上占优,且一直在提高精度或分辨率。

捕获图像数据的基本单位是像素。增加图像传感器的像素是提高图像分辨率的一种方法。较小的像素意味着在提高分辨率的同时,可以在相同的区域内放入更多的像素,这称为像素间距,目前图像传感器上的像素密度在增加。 但增加像素会影响图像传感器的测试。近年来,CMOS图像传感器(CIS)设备的像素数呈爆炸式增长,结果是CIS设备的测试往往需要更长时间。

真正影响测试的是传感器的缩小。OmniVision多年来一直在销售微型2层图像传感器。“当你做得越来越小的时候,测试就会面临挑战,因为测试设备和硬件随之面临着挑战。” 图像的使用者可以是人、计算机或某种机器。因此,图像传感器的选择取决于最终用途和最终用户。如果终端使用者不是人类,或者目的是检测特定的事件,则正在考虑使用诸如事件传感器之类的新型视觉传感器。在光线较暗的情况下和车内监控,事件传感器只检测到强度的变化,像素会被变化激活。否则,不需要收集其他图像数据。

图3:CMOS图像传感器(CIS)

将光通过像素,通过光电二极管转换成电信号输出(来源:TEL Nanotec Museum) 图像传感器在200mm和300mm晶圆厂的成熟节点上制造。一些图像和视频传感器包括图像或视频处理模块。这些是SoC。另一种没有视频处理器的图像传感器被称为RAW。 OmniVision的Patel表示:“就普及程度而言,RAW传感器代表了全球大多数(视觉)传感器。视频处理器是很多公司的专利,他们有自己的算法、配方和操作方法。由于这些原因,使用外部VPU总是更好。你还可以使用高级处理节点来集成更高级的图像处理算法。这就是你所看到的,但市场上仍有一些SoC传感器可用。” 有时,由于其他原因,最好将图像传感器与处理元件分离。Patel说:“在汽车领域,有一些用例更倾向于将视频处理分开。汽车的后视摄像头在后备箱的位置,但可以在中控上显示视频。那是一段很长的距离。设计师更愿意使用数字输出,或传统的模拟输出,如NTSC或PAL视频输出,这样你就可以使用较长的线束来显示。”

信号/图像数据是使用并行和串行输出从图像传感器上移走的。这似乎违反直觉,但串行输出正变得比并行更受欢迎,其中MIPI占主导地位。 Mixel的Takla说:“在大多数视觉应用中,功率和延迟是关键参数。MIPI的最初目标是传感器、处理器和显示器之间的视频数据通信,因此我们针对这类应用进行了优化。正因为如此,MIPI标准的发展使得功耗、延迟最小化,并解决了典型视频链接的不对称特性。我们看到C-PHY正在普及,主要是在传感器中。显示器方面的应用正在增长,但却滞后于传感器。” 串行接口在视觉上胜过并行接口。Patel说:“对于并行接口,如果是8位或10位输出,基本上有12行,然后一些其他的信号,这是传统的数据总线。串行接口大致是MIPI联盟的。它们基本上使用串行差分引脚和输出。一条线路包括两个数据对,然后是时钟对,所以是四个引脚,但实际上,与并行相比,这四个引脚能够输出更高的吞吐量。” 并行输出有一个TTL(transistor-transistor logic)摆动,增加了传输时间。Patel说:“当你从零电压切换到更高的电压时,无论是1.2还是1.5,信号的上升和下降都需要时间。

挑战在于你能达到的速度,但从简单的角度来看,并行是最简单的输出方式,因为行业中的大多数微控制器都有某种类型的并行输入数据总线。你可以直接把这些连接起来。” 当涉及到高分辨率、高帧输出时,当速度提高时,并行又出现了不足。“如果你想在高分辨率下输出高帧率,比如在30帧或60帧下输出4K或2K,并行端口将很难输出如此高的帧率。那会是很大的功率。所以这些都是通过串行接口,也就是MIPI接口来处理的。我们看到越来越多的新微控制器也加入了MIPI接口。”

在视觉或图像信号处理器内部,数据处理可能与SoC内部不同。Arteris IP的CMO Michal Siwinski说:“你将视觉作为一种传感器,这实际上是非常数据密集型的,能够获取这种信息,并确保能够捕获它,信息是连接的,数据从芯片的这部分流向其他部分,这样你就可以计算它,解析它,并从中学习。视觉可能比其他类型的传感器产生更多的数据。

由于我们能够很好地处理这个问题,其他的事情基本上都很简单。我们基本上提供了底层的SoC基础设施。” VPU和ISP,视觉IP 电信号一旦离开图像传感器,就在VPU或ISP或两者中进行处理。 典型的计算机视觉应用就是摄像头(带图像传感器)。摄像头有一些预处理。它捕获数据帧,检测对象,跟踪识别,然后进行一些后处理。系统设计者已经使用MPU、CPU和GPU来处理图像。图形处理器是为3D和游戏图形设计的,最初在处理图像方面有一些优势。但现在有VPU,利用AI加速器处理图像。AI只从信号中提取必要的数据,并可以为图像识别编程,或帮助终端用户找到有意义的数据或提高其用例的图像质量。 VPU的例子有:

Flex Logix的InterX内置了AI模型。图像处理是Flex Logix AI推理产品的细分市场之一。该公司的营销高管说:“我们非常专注于高清实时图像处理。我们已经开发了针对这一领域优化的芯片(机器视觉、计算机视觉)。”

Renesas的RZ/V系列是MPU,使用Renesas的专有AI加速器,低功耗DRP-AI(Dynamically Reconfigurable Processor)加速器。RZ/V2M具有支持4K/30fps的高性能ISP;RZ/V2L有一个3D图形引擎。OpenCV加速器使它与各种图像处理设备兼容。两个主要的64位CPU是Arm的Cortex-A55(1.2GHz)或Arm Cortex-A53(1.0GHz)Dual。子CPU是Arm Cortex-M33(200MHz)Single。Renesas的企业基础设施事业部副总裁Shigeki Kato在一份声明中表示:“对于想要实现机器学习的嵌入式系统开发者来说,挑战之一是要跟上不断发展的最新AI模型。通过新的DRP-AI TVM工具,我们为设计师提供了扩展AI框架和AI模型的选项,这些AI框架和AI模型可以转换为可执行格式,允许他们使用新的AI模型为嵌入式设备带来最新的图像识别能力。”

英特尔的Movidius(VPU)包括一个神经计算引擎。

ST为STM32Cube提供了AI和计算机视觉功能包。FP-AI-VISION1功能包运行在基于Arm核的STM32 MCU上。

传统上,ISP用于数码相机中处理为人类观看而优化的数字图像。ISP可以应用白平衡过滤器、原始数据校正、镜头校正、动态范围校正、降噪、锐化、数字图像稳定和各种其他调整。ISP也正在适应计算机视觉应用。ISP可以是将用于SoC或图像传感器本身的IC或IP核,通常与VPU结合使用。一个ISP的例子是Arm的Mali-C52和Mali-C32 ISP,用于IoT设备的实时、更高的图像质量。 VPU和ISP一起使用,可以产生比单独使用VPU更高效的计算机视觉处理。 此外,EDA行业还提供视觉系统的IP和创建和测试视觉系统设计的工具。按供应商分类,应用包括:

Cadence:Tensilica Vision DSP用于汽车SoC和其他用例。

Synopsis:DesignWare ARC EV处理器,用于嵌入式视觉应用的可编程和可配置IP核。

Ansys:用于检查计算机视觉系统的工具,例如它的SCADE vision,它可以检测视觉系统的问题。在汽车领域,SCADE Vision|Driving Perception Software Testing可自动识别自动驾驶汽车基于AI的感知系统的脆弱性。Ansys AVxcelerate Sensors|AV Sensor Simulation Software测试自动驾驶汽车中的ADAS传感器。

预先训练的AI图像推理模型是提取图像意义的一种经济有效的方法。Flex Logix为完成特定任务的视觉应用提供预先训练的模型,如硬帽检测、车牌读取、车辆检测、无人机、PCB缺陷检测等。这种名为EasyVision的AI模型与Flex Logix的InferX AI边缘加速器协同工作。 Fuller说:“算法已经存在,训练也已经进行,但你还想把它构建成一种健壮且具有成本效益的东西。这就是这种服务非常有意义的地方,因为科学开发转化为工程产品,是一个仍然需要完成的过程,也是我们真正专注于帮助客户完成的事情。”

边缘视觉处理

虽然图像传感器可能不会内置在边缘的处理器中,但图像传感器正在与新的处理器和SoC组合,在边缘使用AI进行图像处理。如前所述,Flex Logix是开发边缘图像处理能力的初创公司之一。其他还有SiMa.ai,该公司利用Synopsys的DesignWare ARC嵌入式视觉处理器和Arm的计算IP,创建了计算机视觉的MLSoC平台。其他致力于视觉前沿AI的初创公司包括Ambarella、Brainchip和Hailo。

带有AI的视觉边缘设备的一个例子是Au-Zone的微型AR/VR相机,采用了NXP的i.MX RT1064 MCU(基于Arm Cortex-M7视觉),最高可达600MHz。Au-Zone的摄像头也是为IoT设计的。NXP的i.MX RT1064 MCU是NXP用于IoT和边缘AI的RT Crossover系列的一部分,其中包括音频和视觉应用。

但终极边缘仍然是AR/VR。经过20多年的研发,这一市场才刚刚开始进入消费电子行业的视野,这在很大程度上是由于其所用芯片在速度、功耗和价格开始进入合理区间。

小型化,多层堆叠

摄像头及其集成电路正变得越来越小、越来越复杂,图像传感器也变得更多层。其中一个驱动力是眼镜或头戴式设备中的AR/VR。例如,需要多个微型摄像头聚焦于人类互动的某个特定方面。可能需要一台单独的摄像头来聚焦一个人的嘴唇、眼睛和手势。

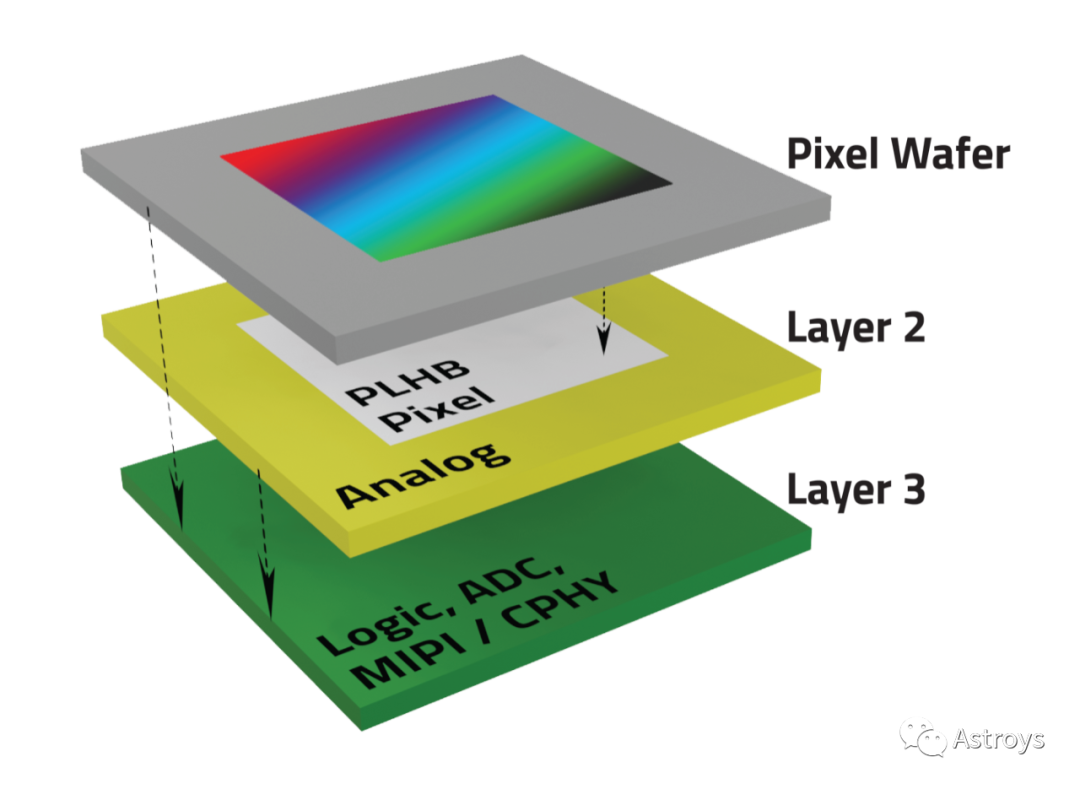

随着AR/VR技术的发展,眼镜的边框需要多个摄像头。OmniVision的Patel说:“性能和尺寸的需求非常重要。我们正在对OG0TB的全球快门图像传感器进行采样,该传感器使用三层叠加。”

图4:OmniVision的三层图像传感器OG0TB,除了像素晶圆,它还具有模拟、逻辑、ADC、MIPI/CPHY(来源:OmniVision)

OmniVision的Patel说:“通过三层堆叠,我们可以制作1.6*1.6毫米的摄像头,而这种尺寸可以让你把它们放在下一代AR/VR设备中。在未来,这些层可能使传感器避免传输不需要的数据。长期愿景是我们经历层层叠加的原因之一。你可以想象,在未来,我们可以把一些模块、CNN网络,或其他一些数字功能,你需要把所有的原始数据发送给他们。但如果目的只是为了眼球追踪,为什么要发送所有的原始数据。相反,只发送x、y坐标。如果传感器本身有这个处理模块,我们就能实现这个目标,这将有助于使用主机上的带宽,因为你可以想象有多少摄像头在争夺这个接口。”

处理多摄像头数据的AI正在被设计成芯片。Renesas刚刚在其RZ/V系列中推出了一款支持AI的微处理器,可以对来自多个摄像头的图像数据进行AI处理,以提高视觉AI应用的图像识别精度,如配有AI的网关、视频服务器、安检门、POS终端和机械臂。

在更大的系统中,比如汽车、无人机、机器人,多摄像头和视觉系统是常态,尽管它们并不总是微型的。Arteris IP的高级技术营销经理Paul Graykowski表示,“通常有不止一个视觉系统。通常情况下,你是通过一系列摄像头等方式传送数据,你必须确保有足够的带宽和延迟来处理这种情况。”

如果是无人机,它使用摄像头作为视觉传感器来避障。“如果它在飞行,处理数据的速度不够快,就会发生碰撞。我们必须确保在数据路径中有紧密耦合,以确保我们为这些处理器提供实时数据。我们显然也不希望他们被闲置。当你在处理视觉时,优化性能是关键,及时地获得数据,这样你就可以对数据进行机器学习,然后做出相应的反应。无论是ADAS、无人机还是机器人,在任何类型的视觉系统中,获得实时数据是非常重要的。”

尽可能接近实时的反应是系统的理想和目的。

Graykowski说:“它能够优化NoC的配置,并具有灵活性,可以指定‘我必须将数据从A点移动到B点,它必须在这个时间到达那里’,以及所有这些服务质量参数,以确保实现目标。”

但实时并不总是必需的。有时候让系统“思考”是可以的。系统设计师需要知道什么数据需要被感知、通过AI加速器移动、通过CPU进行响应,所有这些都是近乎实时的。无人机就是一个很好的例子。无人机可能需要一段时间来改变路线,因为它会考虑各种可能性。不过,一架在空中的无人机可能不会像一辆在地面上的汽车那样面临迫在眉睫的危险,它在ADAS中做实时处理以避免碰撞。

“视觉拥有来自多个来源的大量数据。它基本上是从所有这些来源获取数据,并很快将其送到处理单元或AI单元,这样它们就可以对其进行分析。一旦他们有了分析并确定了发生了什么,这将被传递给CPU去做一些思考。你需要一个非常快速的数据链来及时移动数据,因为大多数视觉系统都是实时对事物做出反应。这是围绕视觉进行优化的关键,及时移动数据。显然,面积、功率和性能总是要考虑的因素,但现实情况是,你必须确保你设计的NoC不会耗尽你的AI引擎,这样它们才能进行所需的计算。”

图像传感器越来越小,像素和层数越来越多,而视觉处理SoC现在增加了AI加速器和边缘AI处理。摄像头越来越多、越来越小、越来越智能和高效。视觉系统涵盖了从手机摄像头到工业自动化、汽车、医疗、安全等各个领域。

但是,系统使用者是计算机、机器还是人对系统设计有很大的影响,因为系统设计可以舍弃不必要的数据。此外,传感器、AI和ML视觉处理的新选择将帮助团队进行更精简的视觉系统设计,并获得更多更高质量的图像。

[参考文章]

AI Feeds Vision Processor, Image Sensor Boom — Susan Rambo

编辑:黄飞

电子发烧友App

电子发烧友App

评论