在科幻小说中,机器人要么是与人类对立,要么是变异成坏人。但如今现实生活中机器人的应用大为不同。机器正代替人眼来看世界并加以行动,它们所到之处让生活变得智慧化。

通过摄取图像模拟人眼的视觉功能,提取信息然后加以分析处理,机器视觉已成为智慧城市过程中不可或缺的“第三只眼睛”,其应用领域也从食品生产流程管理、农业种植控制、医学检测等方面的个体需求到交通及安防等公共项目。其中我司深圳朗锐智科实业有限公司研发的鸡蛋收集线计数器,就被投放到家禽养殖场使用,在使用过程中可以提高效率和降低成本。

随着机器视觉的发展与进步,3D机器视觉迎来了自动化行业的巨大机遇,主要用于质量保证和检测。据数据预测,2017年到2022年期间的复合年增长率将达到11.07%,2022年全球3D机器视觉市场规模有望达到21.3亿美元。

在机器视觉顶会中,差不多会有半壁江山那么多的论文都是跟3D有关。前沿探索可谓疯狂进行,那么有哪些三维图像+机器视觉的新技术趋势,今天正隐藏在未知迷雾中眺望这个世界?今天我们来说几种很有科幻感的技术突破点。说不定这些能力明年就会出现在你的手机、VR设备和无人机中,又或许即将成为某个被资本疯狂亲吻的创业热潮。

超大场景的3D数据感知

3D机器视觉包括很多方面,既有让智能体去理解3D数据,也包括如何通过机器视觉的解决方案,去获取3D模型数据。

传统意义上的3D数据获取,或者称其为3D感知技术,一般来说可以利用多角度拍照或者深度传感器的方式实现3D数据收集。这种技术的局限在于,收集的3D数据不能太大。

然而在3D资料要求不断升级的今天,对于超大场景的3D数据感知,正在成为一个热门议题。比如无人驾驶中使用的城市高精地图,就可以看做一个个超大3D场景的拼接。智能城市领域运用到的很多城市数据推演,也要根植于对城市3D场景的收集。

机器视觉正在为超大场景的3D数据感知提供很多新的方法。比如自动化的成像方法,像视觉SLAM在线处理连续帧的图像,实现实时重建巨大3D场景。再比如说对航拍数据进行点云分割和点云数据的语义理解,帮助快速低成本获取城市3D数据。

总体来看,今天超大场景的3D数据感知,有三个主要应用方向,很可能分别成为各自技术领域中新的投资和创业热点:

1、建筑物的3D高精度模型,运用在工程监理、智能设计、物流和智能城市领域。

2、高精地图与3D数据感知的结合,这是无人驾驶的重要一环。

3、室内外一体的3D建模,这对于智能家居设计、环境监控、VR/AR体验来说都有重要帮助。

手机与3D视觉进入蜜月期

目前,智能手机已经成为AR/AR以及计算视觉等先进技术发展的最大载体,人脸识别、AR功能成为当前智能手机发展的热点,其实无论是在AR/VR领域还是识别技术,都离不开计算视觉。计算视觉领域其实就是运用计算机技术对生物视觉的一种模拟,其中深度识别和多维成像使其核心技术。

深度识别是计算视觉的关键前提,能够对生物视觉进行识别,其中包括当前流行的苹果人脸识别技术,多维成像将包括目前的3D显示结局即对图片以及视频等进行3D画面的再现。利用深度识别和多维成像技术,除了还原我们肉眼所能看到的画面,未来随着技术的不断融合,深度识别技术还能是立体的展示我们肉眼所看不到的东西。例如,未来的智能手机可以在阳光下利用深度识别技术和人工智能技术的分析,识别紫外线的强度,提醒我们的防晒护肤。

AR/VR中的眼球追踪技术

随着技术的进步,我们现在已经能够利用人类眼睛进行虹膜识别,虹膜识别相较面部识别、指纹识别都更加有效和安全,很多手机厂商开始开发使用虹膜识别功能。

除了虹膜识别之外,还有眼球追踪技术。所谓眼球追踪,是指一项技术能够追踪眼球的运动,并利用这种眼球运动来增强某个产品或服务的体验。

眼球追踪技术曾经在智能手机领域火了一阵,这可能要追溯到2013年Galaxy S4手机率先搭载了眼球追踪功能,这项功能主要应用在视频播放上面。举个例子,如果你正在观看一个视频,然后你身后的同学拍了一下你肩膀,在你转过头的时候,由于你的眼睛已经不再看着屏幕,视频会自动暂停,而当你回过头来,视频会自动继续播放。不需要你用手去点击暂停和播放;或者你在手机上看网页,当你眼睛看到屏幕底部的时候,网页会自动翻页。同年,LG也推出了一款拥有眼球追踪功能的LG Optimus G Pro手机。

可惜,眼球追踪未能在手机领域掀起大风大浪,原因大概有两点。首先用户没有需求,一款智能手机的平均尺寸大约只有5英寸,在这么一丁点儿大的地方,人们更喜欢直接用手指进行交互,何况手机绝大部分功能都是使用手指进行交互,所以也不多播放/暂停这个环节;第二个原因就是,当时技术不太成熟,分辨率低,识别不够精准,导致有用户觉得眼睛累。

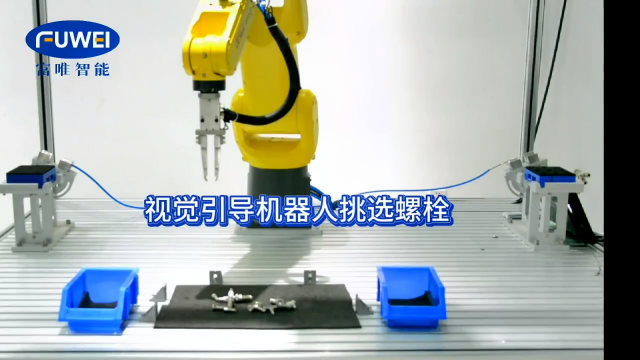

3D视觉助力机器人产业智能化转型

3D视觉作为一项激动人心的新技术,早已经出现在微软Kinect、英特尔RealSense等消费级产品中。近几年,随着硬件端技术的不断进步,算法与软件层面的不断优化,3D深度视觉的精度和实用性得到大幅提升,使得“3D深度相机+手势/人脸识别”具备了大规模进入移动智能终端的基础。作为全球手机当之无愧的龙头,苹果率先大规模采用3D视觉技术,将彻底激活3D视觉市场,开启全新时代。

3D视觉技术不仅仅在识别精度方面大幅提升,更重要的是打开了更加广阔的人工智能应用空间。随着机器视觉、人工智能、人机交互等科学技术的发展,各种高智能机器人开始走进现实,3D视觉技术成为助力制造业实现“智能化”转型的好帮手。

大家耳熟能详的深度摄像头技术和应用有英特尔的RealSense、微软的 Kinect、苹果的 PrimeSense、以及谷歌的Project Tango等。不过可以看到这一技术的研究和开发多为国外公司,国内计算视觉方面的公司或创业团队屈指可数,技术上的壁垒依旧较大。

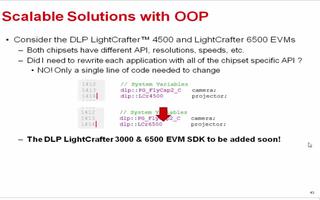

关于目前市场上的深度相机的技术方案主要有以下三种: 双目被动视觉、结构光、TOF。双目被动视觉主要是利用两个光学摄像头,通过左右立体像对匹配后,再经过三角测量法来得到深度信息。此算法复杂度高,难度很大,处理芯片需要很高的计算性能,同时它也继承了普通RGB摄像头的缺点:在昏暗环境下以及特征不明显的情况下并不适用。

结构光的原理是通过红外激光发射相对随机但又固定的斑点图案,这些光斑打在物体上后,因为与摄像头距离不同,被摄像头捕捉到的位置也不尽相同。然后先计算拍到的图的斑点与标定的标准图案在不同位置的位移,引入摄像头位置、传感器大小等参数计算出物体与摄像头的距离。

微软在Kinect二代采用的是ToF的技术。ToF是Time of flight的简写,直译为飞行时间的意思。所谓飞行时间法3D成像,是通过给目标连续发送光脉冲,然后用传感器接收从物体返回的光,通过探测光脉冲的飞行(往返)时间来得到目标物距离。相比之下,结构光技术的优势是比ToF更加成熟,成本更低,更加适合用在手机等移动设备上。

深度摄像头是所有需要三维视觉设备的必需模块,有了它,设备就能够实时获取周围环境物体三维尺寸和深度信息,更全面的读懂世界。深度摄像头给室内导航与定位、避障、动作捕捉、三维扫描建模等应用提供了基础的技术支持,成为现今行业研究热点。如今iPhone X搭载3D深度摄像头势必会大力推动机器视觉领域的发展,助力机器人产业实现完美“智能化转型”。

更好的深度传感器解决方案

还有一个机器视觉技术和3D的交汇,主要发生在无人机领域。

无人机今天进行测绘和航拍时,必须附带对空间的理解能力,否则拍照不准事小,撞了南墙事大。而这个能力主要来自于摄像头和传感器进行空间阅读。

随着消费级无人机的不断升级,人们对无人机拍摄效果要求也不断升高。无人机必须不断在更远的距离、更极端的天气、更复杂的运动中拍摄画面。然而传统的传感系统解决方案已经快要跟不上用户的期许。

今天的消费级无人机,一般采取两种感知解决方案,一种是双目视觉技术,比如大疆的某些产品;一种是结构光传感器,比如微软的Kinect。而这两种主流方案都是有一定局限的,比如感知范围都有限,难以完成远距离作业。再比如双目视觉技术在黑夜中会失灵,所以无人机夜拍一直是个大坑,然而结构光技术应对不来强光,一到中午无人机就石乐志也是很心塞的。

更好的解决方案,在于将传感器与智能摄像头结合起来,达成可以适应不同天候与天气,并且可以长距离感知的新型传感系统解决方案。

今天,用机器视觉技术中的很多算法,协调不同的传感设备工作,让无人机变成“多眼无人机”,正在成为流行的解决方案。机器视觉算法大量加入无人机传感器,还可能带来轨迹拍摄能力提升,让无人机获得拍摄整体环境,或者精准捕捉动态物体,比如说运动中的动物和车辆的能力。

以上几个技术趋势,都可能成为机器视觉和图形学应用的下一步热点。这个领域看似偏门,事实上却能影响今天科技市场中的风吹草动。

让机器看到立体世界的游戏才刚刚开始,机器与人类在某一天可以用同样的视角相互凝视,或许才是这个故事的终点。

编辑:黄飞

电子发烧友App

电子发烧友App

评论