“AR/VR/XR×元宇宙”时代的到来

虚拟现实技术VR通过逼真的、具有三维视、触、嗅、听等多感官体验的虚拟世界,营造出如身临其境的虚拟世界。

增强现实技术AR将文字、图像、三维模型、音视频等数字信息,通过显示终端融入到现实世界,对现实世界信息不断加以完善和增强。

混合现实技术XR融合了VR和AR技术与场景,通过更为多元的场景建构,搭建起现实世界、虚拟世界以及用户之间实时、动态、可持续的交互与反馈,为用户创建出更为多元化的情景内容和空间体验。

从AR、VR到MR,构建虚拟世界与现实世界融合的各项技术以“XR”被统称为扩展现实技术,并以沉浸式的交互模式、大胆的创新正在逐步改变着世界存在的形式。“十四五”规划已明确将虚拟现实和增强现实列为数字经济重点产业之一。

而元宇宙概念的提出彻底撕开了现实与虚拟世界间的面纱。“元宇宙”集成了扩展现实、脑机接口、区块链、云计算、数字孪生、人工智能等多种技术,不再以技术为出发点,而是打破虚拟与现实的空间界限,以多元空间建构为基础,创新场景应用与交互,探索人类社会新的空间关系,并逐渐改变着人们对空间的认知。

当下,基于“AR/VR/XR”融合的多元场景,正越来越多的应用在人类工业生产、教育、医疗、娱乐、运营服务等领域。比如基于复杂工业设备的虚拟操控训练、课堂教学的沉浸式体验、医疗手术中的远程辅助、更具沉浸感的体验游戏、对历史场景的还原、服装购买过程中的衣物试穿等场景。未来,或许这些场景也将成为大元宇宙空间的重要内容。而社交元宇宙、企业元宇宙等概念的提出,也只是元宇宙创新的一种形式,更多的可能正在探索的路上。“AR/VR/XR×元宇宙”时代已经到来。

感知识别或将成为元宇宙空间时代人机交互主要入口与载体

在打破虚拟与现实世界界限的元宇宙空间里,手势、语音交互、脑机接口是最为直接的交互方式,或将成为下一代智能网络时代新的人机交互入口和载体。

在扩展现实技术营造的多元空间场景中,屏显设备建立起人与虚拟世界的视觉联系;座椅、脚踏设备等建立起与人的身体与虚拟世界的运动感知;味道、水汽等物理环境创设辅助人在虚拟空间的嗅觉感知和环境触觉感知;手势识别、语音识别、脑机接口等交互模式建立起人与虚拟世界的持续交互操控。

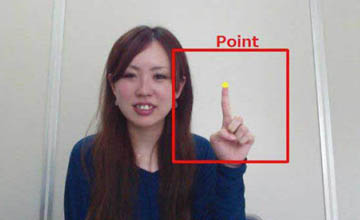

手势识别技术因其技术的成熟性,交互功能多样性,成为当下扩展现实感知交互发展的重要内容与设备。手势识别为身处元宇宙空间的人们提供了即时、高效、立体、多元和可持续的感观交互体验。手势识别技术在扩展现实场景操控与交互过程中发挥越来越重要的作用。

手势识别在沉浸式体验中不可或缺

人手本身属于人的操控器官,当人置身于虚拟世界中时,手眼协调是最自然的操控方式,且无需额外增加操控硬件。基于手势识别技术以及辅助增强手感知和反馈的可穿戴设备,手势识别可以帮助使用者建立起人手与虚拟世界场景间更为自然、真实的操控体验,比如在虚拟世界中拿起一杯水、变形一个物体、打开一扇门等等。

通过手势识别,可以更为直接的建立起手的动作感知与人脑间的自然连接,更为直接的联动人的视觉、触觉、听觉等感知体验,使人在虚拟情境中的感官体验变得更加立体、多元和真实,形成现实世界与虚拟世界间关联性更强的、更具沉浸感和交互性的体验效果,进而,可以创作出更加丰富、细腻、具有想象力的内容情境。

手势识别扩展现实情景交互场景

目前,手势识别技术存在裸手手势识别、触觉手柄、触觉手套、肌电手环等多种实现路径。其中,裸手手势识别通过基于摄像头的多点视觉识别技术分析和识别手的位置和姿态,搭载头显设备的裸手手势识别应用已经落地,并向更高精度发展;触觉手柄在操控手柄原有的定位与操控功能之外,通过震动、抓握等简单的交互方式增加触觉反馈;触觉手套通过搭载密集的执行器反馈点,在手势识别的准确性、流畅性、灵活度以及细微触觉感知等方面独具优势。

同时,在追踪定位方面,搭配摄像头+惯性测量单元的inside-out方案因能够实现三类平移、三类旋转的六自由度操作以及微动作、主体移动等功能,在消费级VR一体机上被广泛应用。

具有高感知的手势识别技术正逐渐走向成熟,推动手势识别应用的不断落地,为扩展现实情景内容交互的发展提供更多可能。

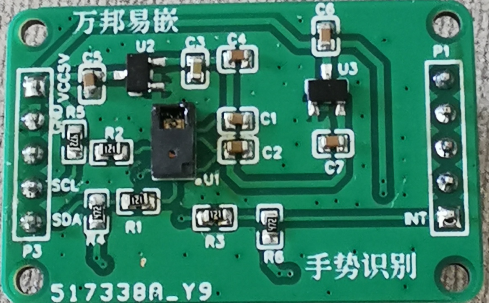

手势识别芯片技术逐渐走向成熟

在VR、AR、MR等扩展现实情景下,感知交互突破了二维屏幕的限制。裸手手势识别技术需要传感器、芯片和算法的协同工作。在传感器方面,需要识别精度更高、响应速度更快、覆盖范围更广,以及价格耕地和体积更小的传感器;在算法上,需要不断改进算法模型,提供更高精度的数据集;在芯片算力上,需要能够支撑更为复杂运算的芯片技术能力。

多角度成像手势识别芯片成为主流

手势识别最关键的技术是对手势动作的跟踪以及通过算法分析出手部的位置和姿态。根据硬件实现方式不同,手势识别芯片方案主要有三种:

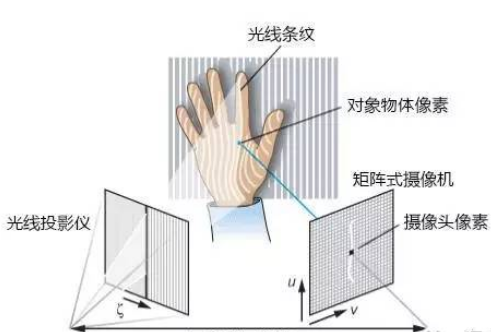

一种是基于结构光原理,通过激光折射以及相应算法计算出物体的位置和深度信息,进而复原整个三维空间,代表产品是微软 KINECT一代,在深度计算和识别距离实现难度较大;一种是基于光飞时间原理,加载一个发光原件,通过CMOS传感器捕捉计算光子飞行时间推算物体的深度信息,代表产品是intel带手势识别功能的三维摄像头;一种是基于多角度成像原理,运用两个或多个摄像头同时采集图像,对比不同摄像头同一时刻获得的图像差别计算深度信息,形成三维图像,业内Leap Motion、MakeSens等公司使用的都是一个或多个普通摄像头组成的手势识别技术方案。

与深度摄像头方案相比,一个或多个普通摄像头实现的手势识别,在综合了实现成本、技术难度以及识别精度等要求下,未来或可成为头显设备主流的手势识别控制模式。

高感知手势识别的必要条件

基于多角度成像算法的手势识别系统,通过背景抠除、运动检测和阈值、轮廓提取等实现手部识别以及区分左右手;通过对单手的21个或26个关键点的动态、实时识别与追踪,确定手在图像中的位置以及识别手势所代表的信息;运用不同摄像头同一时刻获得的图像差别计算图像深度信息;进而,通过手势信息所代表的操作命令实现对界面内容的瞄准、选择和操控等操作。

为实现高感知手势识别,需要高质量的手势模型可以预测出更多的3D关节点;需要足够高精度的数据训练高质量的手势模型;需要基于深度学习的推理运算,则可以处理手的复杂动作,同时抵抗不同环境要素的干扰。因而,在高感知的实现过程中,需要更高效率的算力解决复杂问题,对芯片功耗、时延和成本也有着更高的要求。

与SLAM摄像头的兼容特性

在inside-out追踪成为主流的情况下,近两年,同步定位与建图SLAM技术在扩展现实场景上的应用不断增多。PC端VR头显、移动端VR一体机,AR眼镜等设备几乎全部加入了SLAM定位功能。SLAM摄像头大多采用鱼眼或是广角灰度摄像头,与RGB摄像头相比,SLAM摄像头在手势识别精度上表现更高,且具有良好的兼容性性。

因而,增加SLAM功能的VR、AR设备在采用手势识别时,可以直接采用SLAM灰度摄像头进行手势识别,不再需要增加额外硬件配件,不但其识别精度可以保证,兼容效果良好,也不会增加摄像头的硬件成本,同时也无需考虑设备功耗负担。以MakeSens的产品为例,在同时运行SLAM定位追踪和手势识别的情况下,即使完全使用CPU的模式下,所占用的CPU资源也能够控制在30%以内,大部分的CPU运算都能够留给软件运行实现。MakeSens基于“感算共融”智能芯片架构,以模拟信息转换技术解决能量效率瓶颈,其超低功耗智能AI芯片与传统芯片相比,能耗可以降低三个数量级。

关于MakeSens

MakeSens手势识别芯片上的创新与精进

5月12日,在由中国半导体行业协会IC设计分会(ICCAD)、芯原股份、松山湖管委会主办的“AR/VR/XR×元宇宙”的“2023松山湖中国IC创新高峰论坛”上,国产智能感知芯片厂商MakeSens(MakeSens)智能科技(北京)有限公司总经理和大家交流了传数字芯片处理高功耗形成的原因并阐明了MakeSens在模拟计算架构下是如何实现芯片低能耗的;同时,也发布了公司自主研发的,集成了多核NPU低功耗感算一体的智能芯片。

邹天琦指出: 在摩尔定律运算逻辑下,传统的数字计算架构下,90%的功耗都损耗在了数据在存储和计算单元间的搬移过程中,并没有用在数据处理过程中,且因数据搬移带来了更高的延时,同时,依赖于制程提升的逻辑芯片性能也带来工艺成本和散热的问题。

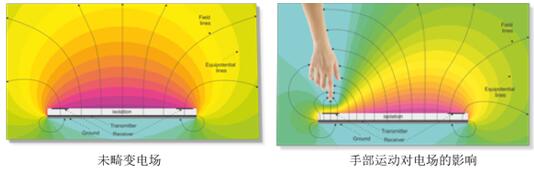

而在传统的感知计算链路下,传感器采集的数据需要经过ADS模数转换器对模拟信号进行数字信号转换,再通过DSP数字信号处理器进行处理,CPU/GPU/FPGA计算芯片进行计算。计算链路较长带来计算效率低、功耗大等问题。

相比之下,模拟计算架构通过近传感计算芯片直接对传感器采集的数据进行计算,将部分DSP芯片需要承担的任务进行前置处理,精简处理器信息后,再将处理后的数据通过ADC模数转换器传递给CPU/GPU/FPGA等计算芯片。主芯片计算的是剔除不必要信息的精简数据,减少了数据迁移量和数据处理量,进而提升了计算效率,也降低了整个计算链路的功耗。同时邹天琦还代表MakeSens发布了公司首款面向面向手势交互应用的低功耗感算一体智能芯片MKS2206。

该芯片集成多核自研NPU,该芯片支持包括图像、语音等多种感知模态。在AR/VR场景应用中,该芯片功能支持双手检测、跟踪与左右手识别;支持双手21关键点和3D坐标检测;支持多种典型手势、自定义手势。可以很好的满足AR/VR场景应用需求;可以实现画面抖动、低视频分辨率、低照度及多目标类别等情况下稳定的手势检测和跟踪功能。

在运算性能上,该芯片定位误差小于10mm;实时处理帧率大于60fps;可实现小于50ms延迟的连续无卡顿交互;检出成功率大于98%。在传感器性能上,支持MIPI-CSI接口;典型配置为640x480单色,双路分辨率最高支持1280x800;典型功耗< 200mW。同时,MakeSens还提供了完整的软件栈,易于与AP集成。

据了解,该芯片基于40nm工艺,将会在今年二季度小规模量产,2023年三季度客户导入,2024年二季度规模出货。此外,MakeSens还计划在2024年推出基于22nm工艺的新一代MK3xxx系列芯片,主要面向SLAM 6DoF定位、手势交互、眼动追踪动等场景应用。

MakeSens公司背景介绍

MakeSens公司源起于清华大学电子系集成智能感知(iVip)实验室,2015首创提出“感算共融”的智能芯片架构,利用模拟计算的高能效特性优势,极大降低了持续智能视觉感知计算下的能耗问题。MakeSens拥有一支经验丰富的模拟计算研发团队,核心人员拥有平均10年以上的行业从业经验,18次流片经验,并且与数家顶尖的公司在持续研发合作。

MakeSens推出的低功耗智能视觉感知平台的核心部件,采用自主创新架构设计,该芯片能够在复杂的识别任务中以低功耗、高精度、高性能和高稳定性脱颖而出,因此有望在AR/VR/MR以及智能座舱等复杂人机感知和交互场景中广泛部署。通过集成轻量级识别交互算法,显著降低系统功耗,提升整体性能,并达到同行业领先水平。

MakeSens的目标是在2024-2025年面向大客户的完整解决方案,并实现亿元以上营收。希望在2026-2028年完成平台服务、生态搭建,建立以自研芯片为核心的全时域智能感知服务平台,并实现IPO。

编辑:黄飞

电子发烧友App

电子发烧友App

评论