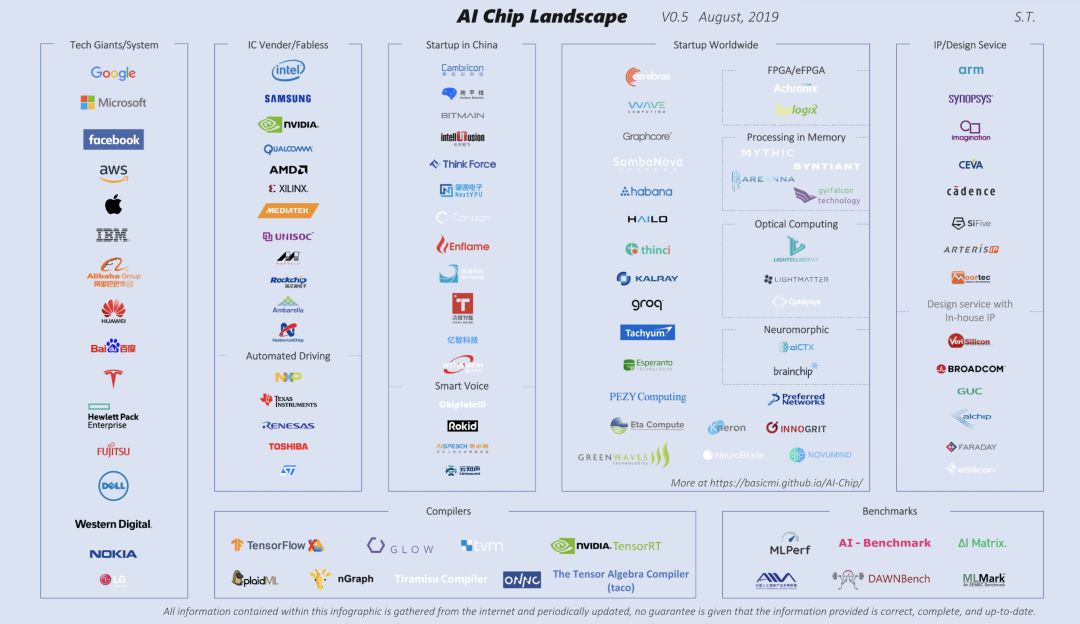

AI芯片厂商知多少?最近,芯片专家唐杉博士更新了“AI芯片全景图”,同时加了版本号和发布时间,介绍了现有的几乎全部深度学习处理器,是值得收藏的超全资料。

AI芯片知多少?

最近,芯片专家唐杉博士更新了“AI芯片全景图”,同时加了版本号和发布时间,介绍了现有的几乎全部深度学习处理器,可能是对AI芯片厂商做的最全面的列表了。

AI芯片全景图(点击阅读原文下载原图)

AI芯片全景图包含5个大类,共介绍了99家AI芯片公司,包括:

IC供应商(15家)

科技巨头&HPC供应商(15家)

IP供应商(7家)

中国芯片初创公司(15家)

全球芯片初创公司(47家)

接下来,我们带来这99家芯片公司的详细介绍:

集成电路供应商

在Hot Chips大会,英特尔强调了“AI Everywhere”思想。

在2019年的Hot Chips大会上,英特尔公布了即将推出的高性能AI加速器的新细节:IntelNervana神经网络处理器,其中NNP-T用于训练,NNP-I用于推理。英特尔的工程师展示了混合芯片封装技术、Intel Optane DC持久内存和optical I/O技术的细节。

Mobileye EyeQ

Mobileye目前正在开发其第五代SoC, 即EyeQ5,作为一个视觉中央计算机,为将于2020年上路的全自动驾驶(5级)车辆执行传感器融合。为了满足功耗和性能目标,EyeQSoCs在最先进的超大规模集成电路工艺技术节点上进行了设计——第5代的FinFET达到了7nm。

Movidius

MYRIAD 2是一个多核、始终在线的芯片系统,支持移动、可穿戴和嵌入式应用程序的计算成像和视觉感知。视觉处理单元包含并行性、指令集体系结构和微体系结构特性,在一系列计算成像和计算机视觉应用程序(包括延迟要求低到毫秒级的应用程序)中提供高度可持续的性能效率。

MyriadX是第一个以神经计算引擎为特征的VPU,这是一个用于在设备上运行深度神经网络应用程序的专用硬件加速器。通过智能存储结构和其他关键组件,神经计算引擎能够在避免数据流瓶颈的情况下,提供行业领先的性能。

英特尔FPGA OpenCL和解决方案。

Loihi

英特尔的Loihi测试芯片是该公司首款自主学习芯片。

Loihi测试芯片包括模拟大脑基本机制的数字电路,使机器学习更快、更高效,同时要求更低的计算能力。神经形态芯片模型的灵感来自神经元交流和学习的方式,使用的是可以根据时间来调节的spikes和plastic 突触。这可以帮助计算机自我组织,并根据模式和关联做出决策。

高通最近宣布,将通过Qualcomm Cloud AI 100将公司的AI专业知识引入云计算,以满足云计算中AI推理处理的爆炸式需求,它利用了高通公司在先进信号处理和能耗效率方面的传统优势。

Snapdragon 855移动平台

高通的第四代设备上AI引擎骁龙855,其AI是前一代的3倍,每秒执行超过7万亿次操作(TOPS)。

NVIDIA TESLA T4张量核心GPU:为TensorRT Hyperscale推理平台提供动力。

NVIDIA揭示了下一代Turing GPU架构:光线追踪,GDDR6等

在英伟达的SIGGRAPH 2018年主题演讲上,公司首席执行官黄仁勋正式公布了备受期待的Turing GPU架构。作为下一代NVIDIA GPU设计,Turing将纳入一些新功能,并将在今年推出。

英伟达的DGX-2系统具有强大的人工智能性能

英伟达于今年3月推出了第二代DGX系统。为了制造半精度2 petaflops 的DGX-2,英伟达必须首先设计并制造一种新的NVLink 2.0 Switch芯片,名为NVSwitch。尽管英伟达目前只将NVSwitch作为其DGX-2系统的一个组成部分,但不排除向数据中心设备制造商销售NVSwitch芯片的可能。

SoC

在边缘,Nvidia提供了用于自动驾驶的AI Car Computer:Nvidia DRIVEPX,以及“用于自动驾驶的嵌入式平台”JETSON TX1/TX2模块。

NVDLA

NVIDIA在GTC2017宣布开源XAVIER DLA深度学习加速器:https://github.com/nvdla/

三星为高端移动设备配备了Exynos 9系列9820处理器的设备上AI处理,第四代定制核心和2.0Gbps LTE高级调制解调器支持丰富的移动体验,包括AR和VR应用

即将发布的AMD Radeon Instinct MI25有望实现12.3 TFlops的SP或24.6 TFlops的FP16。如果你的计算符合英伟达的Tensors,那么AMD就没有竞争力了。Nvidia的带宽为900GB/s,几乎是AMD的484 GB/s的两倍。

据报道,特斯拉正在与AMD合作开发自己的人工智能处理器,用于其自动驾驶系统。特斯拉与英伟达存在合作关系。英伟达的GPU为特斯拉的自动驾驶系统提供动力。

Xilinx赛灵思

Xilinx推出了世界上最快的数据中心和人工智能加速卡:Alveo,旨在大幅提高跨云和内部数据中心的行业标准服务器的性能。

Xilinx提供了“从边缘到云的机器学习推理解决方案”,并且声称他们的FPGA最适合INT8。虽然FPGAs的每瓦性能令人印象深刻,但在价格和性能之间找到平衡是FPGAs的主要挑战。

IBM

神经形态芯片TrueNorth:TrueNorth是IBM的神经形态CMOS ASIC与DARPA的SyNAPSE项目共同开发的。它是一个芯片设计上的多核处理器网络,有4096个核,每个核模拟256个可编程硅“神经元”,总共有100多万个神经元。反过来,每个神经元有256个可编程的“突触”来传递它们之间的信号。因此,可编程突触的总数超过2.68亿个。就基本的构建模块而言,它的晶体管数量是54亿。由于4096个神经突触核都能处理内存、计算和通信,TrueNorth绕过了von- neumann架构的瓶颈,而且非常节能,功耗70毫瓦,大约是传统微处理器功率密度的1/ 10000。

IBM POWER9,人工智能的顺风车:POWER9 处理器芯片专为人工智能设计,计算速度比前代 POWER8 产品高出 1.5 倍。

ST

意法半导体正在设计神经网络技术的第二代产品,该公司在2017年2月的国际固态电路会议(ISSCC)上报告了这一技术。

S32 AUTOMOTIVE PLATFORM

NXP S32汽车平台是世界上第一个可扩展的汽车计算架构。它提供了一个统一的硬件平台和一个跨应用领域的相同软件环境,以更快地将丰富的车内体验和自动驾驶功能推向市场。

ADAS Chip

S32V234是一个用于前置和环绕视图相机、机器学习和传感器融合应用的视觉处理器。

Marvell

Marvell展示了人工智能SSD控制器体系结构解决方案,通过将英伟达的深度学习加速器(NVDLA)技术整合到其数据中心和客户端SSD控制器家族中,为广泛的行业提供AI能力。

MediaTek

联发科宣布推出Helio P90,强调AI处理。

智能手机的麒麟系列芯片

麒麟980,是世界上第一个7nm移动智能芯片。麒麟980创造了多项“全球第一”,是全球首款7nm制程手机SoC芯片组,全球首款cortex-A76架构芯片组,全球首款双NPU设计,全球首款支持LTE cat21的芯片组。麒麟980融合多种技术,引领AI流,为用户提供令人印象深刻的移动性能,创造更便捷、更智能的生活。

移动相机SoC

海思也开发移动相机SoC,如双核 CNN@700 MHz 神经网络加速器。

Rockchip发布了其首款AI处理器RK3399Pro - NPU,性能最高可达2.4 TOPs。

Renesas

Renesas为下一代人工智能芯片开发了新的内存处理技术,使人工智能处理性能达到8.8 TOPS/W。

Ambarella

开发了用于边缘应用的智能视觉处理器

科技巨头和高性能计算提供商

谷歌

边缘硬件Coral 开发板

谷歌已经开始销售售价150美元的Coral Dev Board,这是一款用于加速人工智能边缘计算的硬件套件

TPU

谷歌最初的TPU大大领先于GPU,最初的700MHz TPU被描述为8-bit,95 TFlops,或16-bit计算,23 TFlops,而功耗只有40W。这比当时的GPU要快得多,但现在比Nvidia的V100要慢,但不是按每W计算。

Cloud TPUs可以在谷歌云平台(GCP)中使用。

去年I/O大会,谷歌发布了TPU 3.0,详细分析可以看这篇文章:谷歌 TPU 3.0 到底厉害在哪里?

Edge TPU

如今,从消费者到企业应用程序,AI无处不在。随着连接设备的爆炸式增长,再加上对隐私/机密性、低延迟和带宽限制的需求,在云环境中训练的AI模型越来越需要在边缘运行。Edge TPU是谷歌的专用ASIC,设计用于在边缘运行AI。

更多参考文章:

谷歌TPU3.0到底厉害在哪里?

Google TPU 揭密 Google 的神经网络处理器专利 脉动阵列 - 因 Google TPU 获得新生

亚马逊可能正在为Alexa开发AI芯片,这将使Alexa能够更快地解析信息并得到答案。

AWS Inferentia,是一款高性能机器学习推理芯片,为AWS定制。AWS Inferentia以极低的成本提供高吞吐量、低延迟的推理性能。每个芯片提供数百TOPS的推理吞吐量,允许复杂的模型做出快速预测。为了获得更高的性能,可以同时使用多个AWS Inferentia芯片来驱动数千 TOPS的吞吐量上限。

AWS FPGA实例

Amazon EC2 F1是一个带有现场可编程门阵列(FPGA)的计算实例,你可以通过编程为应用程序创建自定义硬件加速。

微软

如果想了解微软对FPGA在云中的应用前景,基于FPGA的可配置云也是一个很好的参考。“智慧云中的FPGA”这篇文章提供了FPGA的概述和FPGA用于云端推理。

实时AI:微软宣布Project Brainwave

在微软Build开发者大会上,微软宣布了一个集成了Azure机器学习的项目Project Brainwave,该公司表示,这将使Azure成为最高效的人工智能云计算平台。

微软正在招募工程师为其云计算系统设计AI芯片

最近的招聘信息显示,微软正在效仿谷歌,为人工智能设计一款处理器。

苹果

A12仿生芯片是智能手机中最智能、最强大的芯片。

A12仿生,与下一代神经引擎一起,提供了令人难以置信的性能。它使用实时机器学习来改变你体验照片、游戏、增强现实等等的方式。

阿里巴巴

阿里巴巴将于明年推出自研的AI芯片

阿里成立了一家半导体公司,并公布了推出自己的人工智能处理器的计划。该公司希望加强对其云计算和物联网业务的支持。

阿里巴巴正在开发自己的神经网络芯片Ali-NPU,该芯片将用于图像视频分析、机器学习等人工智能应用场景。

阿里云

FPGA云服务器(Beta)是阿里云提供的现场可编程门阵列(FPGA)的计算实例,用户可以在几分钟内轻松创建FPGA设计,并基于阿里云弹性计算框架创建定制的专用硬件加速器。

深度学习(Deep Learning)是一种多层计算模型,可以对复杂输入进行建模,在图像分类、语音识别、自然语言处理中取得了成果,FPGA 实例由于其细粒度并行的硬件特性,非常适合小批量数据的深度学习预测过程,以低功耗、低延迟、高性能著称,以 AlexNet 模型为例,使用 FPGA 计算实例进行图片类别预测,速度比仅用 CPU 的普通实例快 8~15 倍。

腾讯云

腾讯云引入FPGA实例(Beta),基于Xilinx Kintex UltraScale KU115 FPGA,有三种不同规格。在未来,他们将提供更多配置FPGA的选择。

百度

百度自研了AI芯片“昆仑”,瞄准云计算和边缘用例。该芯片采用三星的14nm制程,内存带宽为512GBps,每秒可运行260Tops,功率为100瓦。

在百度内部,FPGA 从 2013 年开始就应用在许多典型的深度学习模型中,如 DNN,RNN,CNN,LSTM 等,涵盖了语音识别,自然语言处理,推荐算法,图像识别等广泛的应用领域。百度 FPGA 云服务器中开放了基于 FPGA 的深度卷积神经网络加速服务,单卡提供 3Tops 的定点计算能力,支持典型深度卷积网络算子,如卷积、逆卷积、池化、拼接、切割等,有效加速典型网络结构如 VggNet、GoogLeNet、ResNet 等。基于 FPGA 的深度学习硬件,深度定制优化了主流深度学习平台如 caffe 等,用户可以直接将深度学习业务切换到 FPGA 平台,而无需考虑底层硬件细节。

华为

华为推出AI芯片,瞄准高通和英伟达等巨头

华为发布了两款新的人工智能芯片昇腾910(Ascend 910)和昇腾310(Ascend 310),其中昇腾910在昨天宣布商用量产。这两款芯片的目标是用于数据中心和联网消费设备,此举使华为与高通和英伟达等主要芯片制造商展开竞争。

FPGA加速云服务

FPGA 云服务器提供 CPU 和 FPGA 直接的高达 100Gbps PCIe 互连通道,每节点提供 8 片 Xilinx VU9P FPGA,同时提供 FPGA 之间高达 200Gbps 的 Mesh 光互连专用通道,让您的应用加速需求不再受到硬件限制。

富士通正在创建的DLU是从零开始的,它既不是基于Sparc也不是基于ARM指令集,事实上,它有自己的指令集和专门用于深度学习的新数据格式,这些都是从零开始创建的。

诺基亚

诺基亚已经为其5G网络解决方案开发了ReefShark芯片组。

Facebook正在组建一个团队来设计自己的芯片

据招聘信息和知情人士透露,Facebook 正在组建一个团队来设计自己的芯片,这加剧了科技公司的一种趋势,即为自己供货,降低对英特尔和高通等芯片制造商的依赖。

HPE

HPE开发了自己的低功耗“神经网络”芯片,

特斯拉

特斯拉开发了自己的自动驾驶芯片:尺寸为 260 平方毫米,拥有 60 亿晶体管,具有双核神经网络阵列,每秒可运行 36 万亿次操作,采用 14 纳米工艺制造。与上一代 Autopilot 硬件(由英伟达硬件驱动)相比,每秒帧数处理能力提高了 21 倍,使每辆车的硬件成本降低约 20%。

LG

LG开发AI芯片用于各种产品,包括扫地机器人,洗衣机和冰箱。

传统的IP供应商

ARM

DynamIQ是嵌入式IP巨头ARM对AI时代的回应。它可能不是一个革命性的设计,但肯定是重要的。

ARM还提供了一个开源计算库,其中包含为Arm Cortex-A系列CPU处理器和Arm Mali系列GPU实现的全面软件功能。

ML处理器专为边缘推理而设计,具有业界领先的4.6 TOP性能,移动设备和智能IP摄像机具有惊人的3 TOP/W效率。

Arm详细介绍了被称为“机器学习处理器(MLP)”的架构。MLP IP在架构实施方面起步空白,团队由从CPU和GPU团队中脱颖而出的工程师组成。

新思科技(Synopsys)

名列美国标普500指数成分股,长期以来是全球排名第一的IC电子设计自动化(EDA)创新公司,也是排名第一的IC界面IP供应厂商,专门提供“硅晶到软件(Silicon to Software)”最佳的解决方案。不论是针对开发先进半导体系统单芯片(SoC)的设计工程师,或正在撰写应用程序且要求高品质及安全性的软件开发工程师,新思科技都能提供所需的解决方案,以协助工程师完成创新、高品质并兼具安全性的产品。

Imagination

Imagination Technologies公司现以硅智财(SIP)授权贩售及DAB收音机为主要业务,PowerVR为其主力销售的一项技术。英特尔及苹果公司分别持有Imagination Technologies 16.02%及9.5%股份。该公司宣布推出2NX NNA系列的首批产品:更高性能的AX2185和更低成本的AX2145。

基华物流(CEVA)

由两大物流巨头TNT物流和EGL宏鹰全球物流于2007年8月合并组成。从2G开始,CEVA的DSP IP就被用在通信基带处理上,TeakLite系列非常成功。在4G时代,联芯基于CEVA DSP打造的SDR平台被小米采用。在CES之前,CEVA宣布了一款名为NeuPro的新型专用神经网络加速器IP。

益华电脑(Cadence)

成立于1988年,是EDA(电子设计自动化)软件与工程服务的重要厂商,主要提供设计集成电路(IC)、系统单芯片(SoC)、以及印刷电路板(PCB)所需的软件工具与硅智财(IP),涵盖类比/数位/混合电路设计、验证、封装/PCB设计等各领域。

芯原股份(VeriSilicon)

芯原的前身是美国思略科技公司(Celestry Design Technologies,Inc.)在上海的分公司。目前是集成电路(IC)设计代工公司,为广泛的电子设备和系统如智能手机,平板电脑,高清电视(HDTV),机顶盒,蓝光DVD播放机,家庭网关以及网络和数据中心等提供定制化解决方案和系统级芯片(SoC)的一站式服务。

videantis

德国videantis有限公司是面向移动、家用和定制多媒体应用的芯片、硅IP及软件解决方案的领先供应商,推出了支持多种标准的视频IP解决方案,包括 H.264/AVC、MPEG-4、H.263、DivX、WMV9/VC-1、MPEG-2和视频增强标准等。Videantis的v-MP6000UDX处理器是一个可扩展的处理器系列,旨在以低功耗的方式运行高性能深度学习,计算机视觉,成像和视频编码应用。

中国AI创业公司

寒武纪(Cambricon Technologies Corp Ltd)

寒武纪在5月3日的上海发布会上推出了两款新产品,一款基于云的智能芯片Cambricon MLU100和一款新版本的AI处理器IP产品Cambricon 1M。

地平线(Horizon Robotics )

受到中国企业和政府推动半导体产业的策略影响,地平线称在其最新一轮融资中筹集了6亿美元,其估值达到30亿美元。

比特大陆(Bitmain)

还不确定比特大陆的最新产品Sophon是否会涉足深度学习。但是,通过赋予它这样一个名字,比特大陆向AI之心已经非常明显了。Sophon将包括比特大陆的第一块定制芯片,用于革命性的AI技术。如果一切顺利,Sophon很快就可以在世界各地的大型数据中心训练神经网络了。

启英泰伦(Chipintelli)

启英泰伦的第一款IC CI1006专为自动语音识别应用而设计。

ThinkForce

中国AI芯片制造商ThinkForce获得6800万美元A轮融资,红杉资本,高瓴资本集团,依图参与。

云知声(Unisound)

云知声筹集了1亿美元投入人工智能芯片开发。

思必驰(AISpeech)

中国的思必驰在Advanced Speech Tech上筹集了7600万美元,瞄准AI芯片。

若琪(Rokid)

中国人工智能创业公司Rokid将大规模生产用于语音识别的自定义AI芯片。

肇观电子(NextVPU)

全球领先的计算机视觉处理IC和系统公司NextVPU推出了AI视觉处理IC N171。N171是NextVPU的N1系列计算机视觉芯片的旗舰IC。

嘉楠耘智(Canaan)

嘉楠耘智推出的Kendryte是一系列专注于物联网的AI芯片。

燧原科技(Enflame Tech)

燧原科技是一家总部位于中国上海的创业公司。燧原科技正在开发深度学习加速器SoC和软件堆栈,针对云服务提供商和数据中心的AI训练平台解决方案。

亿智电子(EEasy Technology)

亿智电子是一家AI系统级芯片(SoC)设计公司和整体解决方案提供商。它的产品包括AI加速,图像和图形处理,视频编码和解码,混合信号ULSI设计能力。

知存科技(WITINMEM)

知存科技成立于2017年10月,专注于基于NOR闪存中处理内存技术的低成本、低功耗AI芯片和系统解决方案。

清微智能科技(Tsing Micro)

清微智能是一家可重构计算芯片企业,提供以端侧为基础,并向云侧延伸的芯片产品及解决方案,其核心技术团队来自清华大学微电子所。

黑芝麻智能科技(Black Sesame Technologies)

黑芝麻智能科技将要完成其1亿美元的B轮融资,未来用于扩大与OEM的合作,加速大规模生产,自动驾驶仪控制器的参考设计开发,以及软件车辆集成。

全球芯片初创公司

Cerebras Systems

为了给人工智能提供动力,这家初创公司制造了一个非常非常大的芯片

Cerebras Systems推出了有史以来最大的半导体芯片,其名为Cerebras Wafer Scale Engine,面积 42225 平方毫米(边长约22厘米),拥有1.2万亿晶体管,40 万核心。晶体管是硅芯片的基本组件,1971年,英特尔的第一个4004处理器拥有2300个晶体管,而最近的一个AMD的处理器拥有320亿晶体管。

Wave Computing

一家位于美国硅谷、致力于推动人工智能深度学习从边缘计算到数据中心的计算加速方案的公司。

Graphcore

Graphcore是一家英国AI芯片公司,去年年底筹集了3000万美元,用于支持其智能处理单元IPU的开发。关于Graphcore的IPU架构,这篇文章做了一些分析:

【XPU 时代】解密哈萨比斯投资的 IPU,他们要分英伟达一杯羹。

PEZY Computing

PEZY Computing是一家日本芯片设计公司,专门为超级计算机设计多核处理器,它的2048核心的PEZY-SC2创造了Green500的记录。

Tenstorrent

Tenstorrent是一家位于多伦多的小型加拿大初创企业,与大多数企业一样,该公司声称,深度学习的效率有了一个数量级的提高。他们没有公开更多细节,但他们在 Cognitive 300名单上。

ThinCI

ThinCI筹集了6500万美元,用于开发用于汽车和联网车辆的AI处理器。ThinCI不仅在开发芯片,还在开发软件和开发工具包,使其硬件平台能够扩展到广泛的用途。

Koniku

成立于2014年的加州初创公司Koniku目前已经获得165万美元的资金,成为“世界上第一家神经计算公司”。?Koniku实际上是将生物神经元集成到芯片上,并且已经取得了一些进展。

Adapteva

Adapteva获得了510万美元的资金,论文“Epiphany-V:一个64位RISC片上系统1024核处理器”描述了Adapteva公司采用16nm FinFet技术设计的1024核处理器芯片。

Knowm

Knowm实际上是一家ORG,但他们似乎在追求营利。到目前为止,这家新成立的公司已经获得了数目不详的种子资金,用于开发一个新的计算框架AHaH Computing(Anti-Hebbian and Hebbian),这项技术旨在将智能机器学习应用程序的大小和功耗降低9个数量级。

Mythic

Mythic正在开发一种AI芯片,它“将桌面GPU计算能力和深度神经网络植入一个纽扣大小的芯片——功率低50倍,数据处理能力也远超竞争对手”

Kalray

Kalray推出了Kalray Neural Network 3.0 (KaNN),一个AI应用开发平台。KaNN允许开发人员将基于AI的算法从著名的机器学习框架(包括Caffe、Torch和TensorFlow)无缝地移植到Kalray的大规模并行处理器阵列(MPPA)智能处理器上。

BrainChip

BrainChip 是第一家提供脉冲神经处理器(Spiking Neural processor)的公司,目前的设备被称为BrainChip加速器,是一种用于快速学习的芯片。

AImotive

AImotive和合作伙伴VeriSilicon正在设计一款22 nm FD-SOI测试芯片,Aimotive的另一个有趣的项目是神经网络交换格式(NNEF)。

DeepScale

DeepScale为感知人工智能(perception AI )筹集了300万美元,以确保自动驾驶汽车的安全性。

Leepmind

Leepmind正在对原有的芯片架构进行研究,以在低功耗的电路上实现神经网络。

Krtkl

“Snickerdoodle开发板”众筹了224,876美元,正在开发手掌大小的芯片,使用来自Xilinix的Zynq SoC。

NovuMind

NovuMind结合大数据、高性能和异构计算将物联网(IoT)改变成智能物联网(I²oT)。

REM

REM(Reduced Energy Microsystems)正在开发更低功耗的异步芯片,以适应CNN的推断。据TechCrunch报道,REM是Y Combinator的第一家ASIC公司。

TeraDeep

TeraDeep正在利用其深度学习FPGA的加速功能打造一款AI芯片。

Deep Vision

Deep Vision 正在为深度学习设计低功耗芯片。

Groq

Groq由曾设计TPU的谷歌前员工创建,声称其第一款芯片每秒可运行400万亿次运算,每瓦的效率最高可达8TOP/s。

KAIST DNPU

KAIST公司开发了人脸识别系统“K-Eye”

Kneron

Kneron获得超过1000万美元的A轮融资,用于加速Edge AI的开发。

Gyrfalcon Technology

Gyrfalcon Technology 自2017年9月推出其生产版本的AI加速器芯片以来,一直在为各种形式的AI推广基于矩阵的专用芯片。

Esperanto

虽然Esperanto将授权他们一直在设计的核心,但他们确实计划生产自己的产品。第一个产品是机器学习计算系统,每瓦特可达最高万亿次浮点运算。

SambaNova Systems

SambaNova Systems是一家专注于构建机器学习和大数据分析平台的计算初创企业。

GreenWaves

GreenWaves开发基于开源IP的物联网应用处理器,其第一个产品是GAP8。

Lightelligence

开发光学计算机,以改进人工智能用途。

Lightmatter

Lightmatter希望改变所有计算的方式,开发的光子芯片本质上是以光速进行计算。

Think Silicon

Think Silicon是开发超低功耗图形IP技术的领导者,开发了世界上第一个用于人工智能卷积神经网络的低功耗“推理加速器”视觉处理单元。

InnoGrit

InnoGrit推出了一套用于固态硬盘(SSD)的控制器。

Kortiq

Kortiq开发了“基于FPGA的神经网络引擎IP核,可扩展的解决方案,低成本的边缘机器学习推理嵌入式视觉”。

Hailo

Hailo发布了一款为人工智能工作负载定制的边缘芯片Hailo-8

Tachyum

Tachyum推出一款代号为“Prodigy”的处理器,主要专注于超大规模的数据中心市场。

AlphaICs

AlphaICs设计了一个针对深度学习、强化学习和其他机器学习任务进行优化的指令集体系结构(ISA)。这家初创公司的目标是生产一系列16到256核的芯片,覆盖2w到200w。

Syntiant

Syntiant是加州一家半导体公司,由博通的前高级工程师领导。

Habana

Habana是一家领先的AI芯片厂商,最近推出了Habana GaudiAI训练处理器。

aiCTX

aiCTX是一家瑞士初创企业,将为其低功耗的神经形态计算和处理器设计开发商业应用程序,并实现其所谓的“神经形态智能”。

Flex Logix

成立四年的初创公司Flex Logix揭开了其用于机器学习的新型芯片设计的面纱,宣称其性能远远高于英伟达。

Preferred Networks

Preferred Networks将在2020年春季推出一款定制的深度学习处理器MN-Core,用于一个新的大规模集群MN-3。

Cornami

Cornami最近披露了其运行神经网络的芯片设计新方法的一些细节,该芯片将最终实现上世纪70年代首次出现的一项技术的最佳实践。

Anaflash

Anaflash提供了新的边缘计算解决方案,它开发了一种测试芯片,用于演示在逻辑兼容的嵌入式闪存中进行的模拟神经计算。

Optalysys

Optalysys开发了光学协同处理技术,与传统计算机相比,该技术能够以大大降低能耗的方式提供新的处理能力。

Eta Cpmpute

Eta Cpmpute为Edge AI设计脉冲神经网络芯片,该芯片可以在100微瓦的范围内自主学习和推理。

Achronix

Achronix开发了7纳米FPGA芯片,以更低的成本提供竞争对手英特尔和Xilinx类似的性能。

Areanna

Areanna开发了新颖的SRAM架构,用于深度学习。

NeuroBlade

NeuroBlade是一家以色列芯片公司,完成了2300万美元的A轮融资。

-

加速器

+关注

关注

2文章

801浏览量

37919 -

深度学习

+关注

关注

73文章

5506浏览量

121258 -

AI芯片

+关注

关注

17文章

1889浏览量

35088

原文标题:一文看全:全球99家AI芯片公司全景图,中国正在崛起

文章出处:【微信号:AI_era,微信公众号:新智元】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

NPU与传统处理器的区别是什么

GPU深度学习应用案例

使用TMS320C6416协处理器:Turbo协处理器(TCP)

使用TMS320C6416协处理器:Viterbi协处理器(VCP)

FPGA做深度学习能走多远?

实测分享,瑞芯微RK3588八核国产处理器性能测评!确实“遥遥领先”!

深度学习中的无监督学习方法综述

深度学习与nlp的区别在哪

深度学习的模型优化与调试方法

全部深度学习处理器,是值得收藏的超全资料

全部深度学习处理器,是值得收藏的超全资料

评论