在本文中,我将向您简要介绍深度学习的基础知识,无论您之后可能选择何种语言,库或框架。

介绍

试图用很好的理解来解释深度学习可能需要一段时间,所以这不是本文的目的。

目的是帮助初学者理解该领域的基本概念。然而,即使是专家也可能会在以下内容中找到有用的东西。

冒着极其简单的风险(请专家请原谅我),我会尽量给你一些基本信息。如果不出意外,这可能只会引发一些人更愿意深入研究这个问题。

一些历史

深度学习本质上是一个新的和时髦的名称,一个主题已经存在了相当长一段时间的神经网络。

当我在90年代初开始学习(和爱好)这个领域时,这个主题已经众所周知了。事实上,第一步是在20世纪40年代(麦卡洛克和皮茨),但从那时起,这个领域的进展一直很大,直到现在。该领域取得了巨大的成功,在智能手机,汽车和许多其他设备上进行了深入的学习。

那么,什么是神经网络,你可以用它做什么?

好吧,让我们关注计算机科学的经典方法:程序员设计一种算法,对于给定的输入,它会生成输出。

他或她准确地设计函数f(x)的所有逻辑,以便:

y = f(x)

其中x和y分别是输入和输出。

但是,有时设计f(x)可能并不那么容易。例如,想象一下,x是面部图像,y是通信者的名字。对于自然大脑来说,这项任务非常容易,而计算机算法难以完成!

这就是深度学习和神经网络发挥作用的地方。基本原则是:停止尝试设计f()算法并尝试模仿大脑。

好的,大脑是如何表现的?它使用几个无限对(x,y)样本(训练集)训练自己,并且在整个逐步过程中,f(x)函数自动形成自身。它不是由任何人设计的,而是从无休止的试错法提炼机制中产生的。

想象一个孩子每天看着他或她周围的熟悉的人:数十亿的快照,从不同的位置,视角,光线条件,每次进行关联,每次纠正和锐化下面的自然神经网络。

人工神经网络是由大脑中的神经元和突触构成的自然神经网络的模型。

典型的神经网络结构

为了保持简单(并且能够利用当今机器的数学和计算能力),可以将神经网络设计为一组层,每层包含节点(大脑神经元的人工对应物),其中层中的每个节点连接到下一层中的每个节点。

每个节点都有一个由两个限制之间的浮点数表示的状态,通常为0和1.当此状态接近其最小值时,该节点被视为非活动(关闭),而当它接近最大值时,该节点被视为活动状态(上)。你可以把它想象成一个灯泡; 不严格依赖于二进制状态,但也能够处于两个限制之间的某个中间值。

每个连接都有一个权重,因此前一层中的活动节点可能或多或少地对下一层中的节点的活动(兴奋性连接)做出贡献,而非活动节点不会传播任何贡献。

连接的权重也可以是负的,这意味着前一层中的节点(或多或少地)对下一层中的节点的不活动性(抑制连接)做出贡献。

为简单起见,让我们描述一个网络的子集,其中前一层中的三个节点与下一层中的节点相连。再简单来说,假设前一层中的前两个节点处于其最大激活值(1),而第三个节点处于其最小值(0)。

在上图中,前一层中的前两个节点是活动的(on),因此,它们对下一层中节点的状态有所贡献,而第三个节点在非活动(关闭)中有所贡献,因此它不会贡献以任何方式(独立于其连接重量)。

第一个节点具有强(厚)正(绿色)连接权重,这意味着它对激活的贡献很高。第二个具有弱(薄)负(红色)连接重量; 因此,它有助于抑制连接节点。

最后,我们得到了来自前一层的传入连接节点的所有贡献的加权和。

其中i是节点i的激活状态,w ij是连接节点i和节点j的连接权重。

那么,给定这个加权和数,我们如何判断下一层中的节点是否会被激活?规则是否简单如“如果总和为正,它将被激活,而如果负数则不会”?嗯,它可能是这种方式,但一般来说,它取决于您为节点选择的激活函数(以及哪个阈值)。

想一想; 这个最终数字可以是实数范围内的任何数字,而我们需要使用它来设置具有更有限范围的节点的状态(假设从0到1)。然后我们需要将第一个范围映射到第二个范围,以便将任意(负数或正数)数字压缩到0..1范围。

执行此任务的一个非常常见的激活函数是sigmoid函数

阈值(y值达到范围中间的x值,即0.5)为零,但通常,它可以是任何值(负或正,导致sigmoid向左移位)或右边)。

低阈值允许以较低加权和激活节点,而高阈值将仅使用该总和的高值来确定激活。

该阈值可以通过考虑前一层中的附加虚节点来实现,其具有恒定激活值1.在这种情况下,实际上,该虚节点的连接权重可以充当阈值,并且总和公式以上可以认为包含阈值本身。

最终,网络的状态由其所有权重的值集合(从广义上讲,包括阈值)来表示。

给定状态或一组权重值可能会产生不良结果或大错误,而另一个状态可能会产生良好结果,换句话说,就是小错误。

因此,在N维状态空间中移动会导致小的或大的错误。将权重域映射到错误值的此函数是损失函数。我们的思想不能轻易想象在N + 1空间中的这种功能。但是,我们可以得到N = 2的特殊情况的一般概念:阅读本文,你会看到。

训练神经网络包括找到最小的损失函数。为什么一个好的最小值而不是全局最小值?好吧,因为这个函数通常是不可微分的,所以你只能借助一些Gradient Descent技术在权重域中游荡,并希望不要:

做出太大的步骤,可能会让你在没有意识到的情况下爬到最低限度

做太小的步骤可能会让你锁定在一个不太好的局部最小值

这不是一件容易的事,是吧?这就是为什么这是深度学习的总体主要问题,以及为什么训练阶段可能需要数小时,数天或数周。这就是为什么您的硬件对于此任务至关重要以及为什么您经常需要停止培训并考虑不同的方法和配置参数值并重新开始它的原因!

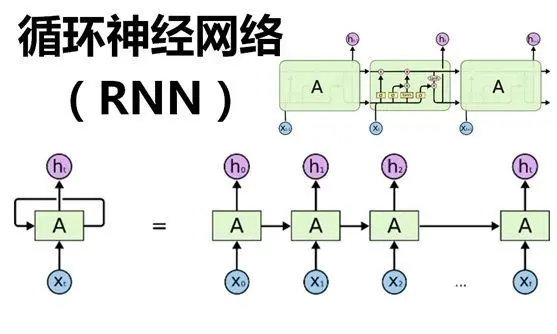

但让我们回到网络的一般结构,这是一堆层。第一层是输入(x),而最后一层是输出(y)。

中间的层可以是零,一个或多个。它们被称为隐藏层,深度学习中的“深层”一词恰好指的是网络可以有许多隐藏层,因此可能在训练期间找到更多关联输入和输出的特征。

注意:在20世纪90年代,你会听说过多层网络而不是深层网络,但这是一回事。现在,已经越来越清楚的是,层越远离输入(深层),它就越能捕获抽象特征。

另请参阅: 从程序员的角度设计Java中的神经网络

学习过程

在学习过程开始时,权重是随机设置的,因此第一层中的给定输入集将传播并生成随机(计算)输出。然后将该输出与所提供输入的所需输出进行比较; 差异是衡量网络错误的指标(损失函数)。

然后,此错误用于对生成它的连接权重应用调整,此过程从输出层开始,逐步向后移动到第一层。

应用的调整量可以很小或很大,并且通常在称为学习率的因素中定义。

该算法称为反向传播,并在Rumelhart,Hinton和Williams研究后于1986年开始流行。

请记住中间的名字:Geoffrey Hinton。他经常被称为“深度学习的教父”,是一位不知疲倦的照明科学家。例如,他现在正在研究一种名为Capsule Neural Networks的新范例,这听起来像是该领域的另一场伟大革命!

反向传播的目标是通过对训练集中每次迭代的权重进行适当的校正来逐渐减少网络的整体误差。再次,考虑到减少误差的这个过程是困难的部分,因为没有任何保证重量调整总是朝着正确的方向进行最小化。

这个问题总结为在n维表面找到最小值,同时用眼罩踩着:你可以找到一个局部最小值,永远不知道你是否能表现得更好。

如果学习速率太小,则该过程可能导致过慢,并且网络可能停滞在局部最小值。另一方面,较大的学习速率可能导致跳过全局最小值并使算法发散。

事实上,在训练阶段,问题往往是减少错误的过程不会收敛,错误会增加而不是缩小!

-

神经网络

+关注

关注

42文章

4767浏览量

100668 -

函数

+关注

关注

3文章

4324浏览量

62527 -

深度学习

+关注

关注

73文章

5497浏览量

121076

发布评论请先 登录

相关推荐

深度学习的基础知识,深度学习神经网络和学习过程的历史

深度学习的基础知识,深度学习神经网络和学习过程的历史

评论