2019云栖大会已经揭开了帷幕,就在9月25日,阿里巴巴集团首席技术官兼阿里云智能总裁、达摩院院长张建锋发表了题为《构建数字经济基础设施》的演讲。在演讲中,张建锋重磅推出AI推理芯片含光800,引发了众多关于它的讨论。

近年来科技热潮一波接着一波。从物联网到可穿戴电子、从人工智能到5G,它们推进了国家的科技发展路径,与其同时也催生出了一大批创新公司:比如专精于安防的旷视科技、专精于视频的极链科技等等。其中的人工智能(AI)便曾在1950年代、1980年代先后热议过,并因多项技术限制与过度期许而回复平淡。而到了2016年,它又随着云端资料的增长和影音辨识的需求,再次进入了公众的视野。

分析AI推理芯片,自然要从人工智能说起。人工智能的运用一般分为两个阶段,即开发与执行,这也与其他大部分应用程序相类似。在实际投入运行前,人工智能需要进行学习与训练,借助大量繁复的运算来使模型获得更佳的参数调整数据,对运算的精准度、细腻度要求都相对较高;而在执行阶段,由于模型已经训练完成,所以不再需要庞大的运算量,再加上效率的考量,往往会采用较低的运算精度。也就是说,在这两个阶段,所需要的芯片能力其实是有所差异的。

目前人类要实现人工智能,只能靠芯片,别无选择。但是现有的CPU、GPU、FPGA等芯片的基本架构早在这次人工智能突破之前就已经存在了,并非为人工智能而专门设计,因此它们并不能完美地承担实现人工智能的任务。人工智能专家MichaelI.Jordan也认为,我们今天所做的还不能算是真正的AI,而只是利用技术来增强一部分的智能而已,也就是所谓的IA(IntelligenceAugmentation:增强智能)。

所以近年来,人们已经开始普遍使用CPU之外的芯片来加速,例如GPGPU、FPGA、ASIC等,特别是GPGPU为多,原因在于GPGPU的高阶软体生态较为完备、可支援多种人工智能框架。相对的,FPGA需要熟悉低阶硬体电路者方能开发,而ASIC通常只针对限定的软体或框架最佳化。虽然FPGA与ASIC较有难度与限制,但仍有科技大厂愿意投入,如Microsoft即主张用FPGA执行人工智能运算,Google则针对TensorFlow人工智能框架开发ASIC,即CloudTPU芯片。

阿里此次推出的含光800,在业界标准的ResNet-50测试中推理性能达到78563IPS,比目前业界最好的AI芯片性能高4倍;能效比500IPS/W,是第二名的3.3倍。在杭州城市大脑的业务测试中,一颗含光800的算力相当于十颗GPU。这固然令人惊喜,但更重要的是,平头哥团队在过去一年中不断探索芯片与场景的融合,如对算力需求较大的图像视频分析、搜索、推荐等业务场景。围绕这一目标,平头哥针对场景深度定制了芯片的软硬件,例如自研了架构、软件编译器、框架、工具链等,如先后发布的玄铁910、无剑SoC平台,后期也针对INT数据类型做了大量优化。这说明中国的AI推理芯片不再满足于IA,而是试图往真正的AI靠拢。

在推理芯片市场之外,人工智能的训练芯片市场也值得观察。由于人工智能应用的开发、训练、参数调整等工作并非时时在进行,通常在历经一段时间的密集开发训练后回归平淡,直到下一次修改调整才再次进入密集运算。因此,企业若为了人工智能应用的开发训练购置大量的伺服器等运算力,每次训练完成后,大量的伺服器将闲置无用,直到下一次参数调整、密集训练时才能再次显现价值。鉴于此,许多企业倾向将密集训练的运算工作交付给云端服务供应商,依据使用的运算量、运算时间付费,而不是自行购置与维护庞大运算系统。这也应该是阿里只售卖基于含光800的阿里云服务,而非芯片本身的原因之一。

目前推理芯片市场的主流想法依然是在规格上做文章,而清华大学微电子研究所所长魏少军教授则认为这是完全错误的思路,“差异化并不是靠规格设计出来的,这样设计出来的差异化只存在于产品产出的那一段时间,之后就无法更改。别人追上来,差异化越来越小,你的产品便出局。”

所以说,如何让推理芯片真正的具有智慧,才是我们当前需要思考的。如果只是单纯的推进芯片的速度,收效只会越来越小。含光800已经踏出了创新的第一步,可剩下的过程,依旧漫长。

发布评论请先 登录

相关推荐

“AI接吻”——AI技术的双刃剑

NVIDIA助力丽蟾科技打造AI训练与推理加速解决方案

《AI for Science:人工智能驱动科学创新》第二章AI for Science的技术支撑学习心得

AMD助力HyperAccel开发全新AI推理服务器

名单公布!【书籍评测活动NO.44】AI for Science:人工智能驱动科学创新

平衡创新与伦理:AI时代的隐私保护和算法公平

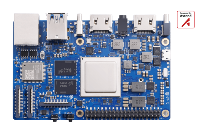

如何基于OrangePi AIpro开发AI推理应用

AMD EPYC处理器:AI推理能力究竟有多强?

Groq LPU崛起,AI芯片主战场从训练转向推理

硅光计算芯片:AI芯片国产化的关键突破口

含光剑出,AI推理芯片如何创新

含光剑出,AI推理芯片如何创新

评论