(文章来源:百家号)

前段时间在社区里有一些关于超融合的弊端、超融合可靠性问题以及超融合场景局限性,以及分布式存储与传统集中式存储优缺点对比的讨论,作为相关产品的从业人员,个人认为对任何一个创新性的架构和产品,用户有各种疑虑都非常正常,但其中有一些误解,也非常有必要做一些澄清;另一方面,有些信息已经随着市场的演进有了很大的变化,也需要给大家做一个更新。以下梳理了一些问题和见解,代表了社区内以及市场上大家对超融合的一些常见观点,个人尝试逐一解释:

观点1:“超融合技术和集中式相比还是省略了很多硬件的,众多的功能有纯软件或者x86服务器自身的硬件来实现,增加了硬件故障风险,最后x86服务器本身的稳定性就不如集中式存储,再次增加的风险”。

回复:这个问题属于很多企业客户对于软件定义数据中心架构的一个常见误解:x86服务器构建的系统可靠吗?单个服务器的可靠性低于基于专有硬件的集中式存储是事实,但超融合本身是以集群方式工作的,尤其对于其核心-分布式存储系统,利用多副本等技术构建具备更高可靠性的大规模系统是架构首先要解决的问题,这些技术都是构建软件定义数据中心的核心,其实早已经过互联网公司大规模的验证,其整体架构承受的负载远高于单套集中式存储,而超融合只是针对企业级数据中心进行了架构上的优化而已。

观点2:“基于x86的服务器的技术栈,其设计思维的初衷就不是稳定性,而是性价比和集群规模”

回复:超融合架构来自于互联网数据中心,是软件定义数据中心理念和分布式存储等技术架构结合企业级数据中心形成的新型架构,其可靠性的的设计是首位,没有可靠性的基础保障,作为在线使用的IT基础架构产品的其他特性都是没有意义的。具体实现技术,在观点1的回复中已经陈述。但需要再次强调的是,基于分布式架构的超融合产品其单套系统承载的负载往往大于之前的集中式存储,所以可靠性的要求是比传统存储要求更高的。

观点3:“超融合的缺点第二是有磁盘或者主机损坏时数据重建过程对性能的影响…还是受限于超融合技术栈自身的原因,数据重建过程都会对性能带来影响,不过这个问题各个厂商也都给出了解决方案,都是处于优化的状态。

回复:数据重建对性能的影响不是超融合的问题而是传统存储也会存在的问题,这个问题的本质是由于数据重建期系统可能处于降级状态,应该尽可能缩短这个过程, 所以在架构实现上需要衡量这个时间窗口和对性能的影响。但相对于集中式存储,由于分布式存储技术的恢复数据压力被分担到了多个节点上,恢复的时间会缩短,所以其实是缓解了类似的问题,另一方面,类似SmartX已经提供了基于业务负载的自动调整恢复速率的特性,可以有效的均衡恢复时间和业务影响。

观点4:XX超融合产品不稳定,看来超融合架构不稳定。

回复:诚然,超融合架构虽然具备很大的价值,但每个厂商的实现的方式和质量也有很大的区别,尤其目前国内有一个普遍情况是很多厂商基于开源存储构建超融合产品,导致有些场景出现问题无法解决,也给用户的信心带来影响。以上也是为什么SmartX一直坚持在最核心的存储方面自主研发的原因。

从当前市场的实际进展来看,不仅Gartner明确超融合场景已经越来越多的覆盖核心业务,SmartX、Nutanix等专业超融合厂商都已经在包括金融行业在内的生产环境里形成了诸多案例并且长时间稳定运行,以SmartX为例,我们在某东区大型知名券商 50+ 节点运行网上交易、行情接入、交易前置、OA 等生产系统;在某大型国有股份制银行运行 C、D 类生产系统;某北区基金公司将主备两个站点全运行在 SmartX 之上,近期有一些基金客户,已经将包括之前运行小机之上的各类业务运行在超融合之上,其核心原因是不仅超融合具备总拥有成本低,易扩展易维护等特点,其可靠性以完全可以承载用户重要的系统。

(责任编辑:fqj)

-

分布式存储

+关注

关注

4文章

174浏览量

19637 -

集中存储

+关注

关注

0文章

4浏览量

1986

发布评论请先 登录

相关推荐

分布式存储和集中式存储有何区别

满足广西地区的配网自动化分布式DTU集中式DTU

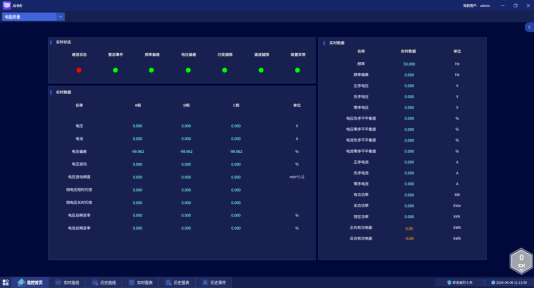

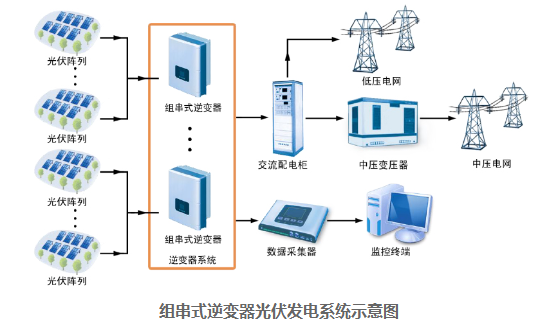

安科瑞分布式光伏集中监控系统

分布式存储费用高吗?大概需要多少钱

曙光存储实现世界级性能突破

集中式与分布式一体化架构,达梦给企业更好的选择

华为分布式存储连续三年荣膺2024年Gartner“客户之选”

集中式抄表是什么?什么叫集中式抄表?

集中式存储和分布式存储的区别以及优缺点分析

集中式存储和分布式存储的区别以及优缺点分析

评论