(文章来源:雷锋网)

美国西部时间 11 月 12 日,2019 英特尔人工智能峰会期间(Intel AI Summit 2019)在旧金山举行,英特尔展示了一系列 AI 相关新产品和相关进展,其中,包括面向训练 (NNP-T1000) 和面向推理 (NNP-I1000) 的英特尔 Nervana 神经网络处理器 (NNP) 都重磅亮相,而英特尔也公布了新一代 Movidius Myriad 视觉处理单元。

随着人工智能的进一步发展,计算硬件和内存都将到达临界点。如果要在该领域继续取得巨大进展,专用型硬件必不可少,如英特尔 Nervana NNP 和 Movidius Myriad VPU。采用更先进的系统级人工智能,我们将从“数据到信息的转换”阶段发展到 “信息到知识的转换阶段”。

对于英特尔来说,Nervana NNP 是它在神经网络处理器方面的重要产品,可以说是第一款 AI 商用芯片,而且这款产品从发布、测试、量产到应用,实际上是经历了一个漫长的产品周期。

新一代 Nervana NNP 首先亮相是在 2018 年 5 月。当时,在英特尔人工智能开发者大会 (AIDevCon 2018) 上,Naveen Rao 发布了新一代专为机器学习设计的神经网络处理器(NNP)芯片,并表示这是英特尔第一款商业 NNP 芯片,将不止是提供给小部分合作伙伴,将在 2019 年发货。

而 Nervana NNP-I,代号为 Spring Hill,是一款专门用于大型数据中心的推理芯片。这款芯片是基于 10nm 技术和 Ice Lake 内核打造的,打造地点是以色列的 Haifa ,Intel 号称它能够利用最小的能量来处理高负载的工作,它在 ResNet50 的效率可达 4.8TOPs/W,功率范围在 10W 到 50W 之间。

按照官方说法,英特尔 Nervana 神经网络训练处理器(Intel Nervana NNP-T)在计算、通信和内存之间取得了平衡,不管是对于小规模群集,还是最大规模的 pod 超级计算机,都可进行近乎线性且极具能效的扩展。英特尔 Nervana 神经网络推理处理器(Intel Nervana NNP-I)具备高能效和低成本,且其外形规格灵活,非常适合在实际规模下运行高强度的多模式推理。这两款产品面向百度、 Facebook 等前沿人工智能客户,并针对他们的人工智能处理需求进行了定制开发。

另外,百度 AI 研究员 Kenneth Church 在现场表示,在今年 7 月,百度与英特尔合作宣布了双方在 Nervana NNP-T 的合作,双方通过硬件和软件的合作来实现用最大的效率来训练日益增长的复杂模型。Kenneth Church 还宣布,在百度 X-Man 4.0 的加持下,英特尔的 NNP-T 已经推向市场。

下一代英特尔 Movidius VPU 的代号是 Keem Bay,它是专门为边缘 AI 打造的一款产品,专注于深度学习推理、计算机视觉和媒体处理等方面,采用全新的高效能架构,并且通过英特尔的 OpenVINO 来加速。按照官方数据,它在速度上是英伟达 TX2 的 4 倍,是华为海思 Ascend 310 的 1.25 倍。另外在功率和尺寸上,它也远远超过对手。

Intel 方面表示,新一代 Movidius 计划于 2020 年上半年上市,它凭借独一无二的高效架构优势,能够提供业界领先的性能:与上一代 VPU 相比,推理性能提升 10 倍以上,能效则可达到竞品的 6 倍。

除了新一代 Movidius,英特尔还发布了全新的英特尔 DevCloud for the Edge,该产品旨在与英特尔 Distribution of OpenVINO 工具包共同解决开发人员的主要痛点,即在购买硬件前,能够在各类英特尔处理器上尝试、部署原型和测试 AI 解决方案。

英特尔方面表示,推进深度学习推理和应用需要极其复杂的数据、模型和技术,因此在架构选择上需要有不同的考量。事实上,业界大部分组织都基于英特尔至强可扩展处理器部署了人工智能。英特尔将继续通过英特尔矢量神经网络指令 (VNNI) 和英特尔深度学习加速技术(DL Boost)等功能来改进该平台,从而在数据中心和边缘部署中提升人工智能推理的性能。英特尔强调称,在未来很多年中,英特尔至强可扩展处理器都将继续成为强有力的人工智能计算支柱。

(责任编辑:fqj)

-

芯片

+关注

关注

457文章

51345浏览量

428262 -

英特尔

+关注

关注

61文章

10025浏览量

172497

发布评论请先 登录

相关推荐

今日看点丨龙芯中科:下一代桌面芯片3B6600预计明年上半年交付流片;消息称英伟达 Thor 芯片量产大幅推迟

英伟达新一代AI芯片过热问题引关注

全球首款!RoboSense全自研专用SoC芯片M-Core获AEC-Q100认证

全球首款!RoboSense全自研专用SoC芯片M-Core获AEC-Q100认证

英特尔向联想交付首款18A工艺CPU样品

联发科新一代天玑旗舰芯片针对谷歌大语言模型Gemini Nano优化

龙芯中科首款GPGPU芯片9A1000计划明年流片

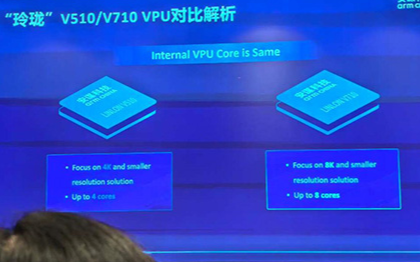

安谋科技发布“玲珑”DPU和新一代VPU

本土自研再上新!安谋科技发布首款“玲珑”DPU和新一代VPU

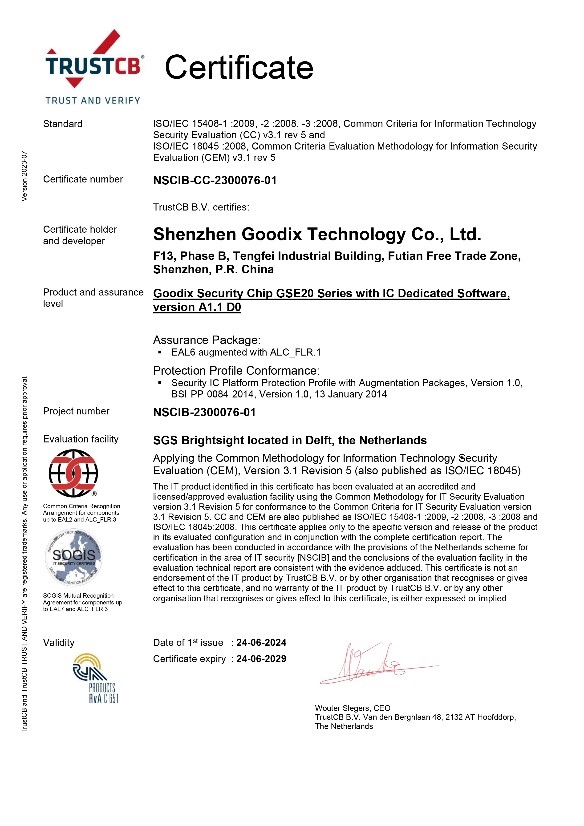

汇顶科技新一代安全芯片荣获CC EAL6+安全认证

再获突破!汇顶科技新一代安全芯片荣获CC EAL6+安全认证

韩国两大芯片公司寻求合并,以开发新一代AI芯片

Arm发布新一代旗舰智能手机芯片设计

英伟达宣布推出新一代GPU Blackwell,SK海力士已量产HBM3E

Intel宣布首款智能芯片已交付,新一代Movidius VPU明年见

Intel宣布首款智能芯片已交付,新一代Movidius VPU明年见

评论