(文章来源:机器之心Pro)

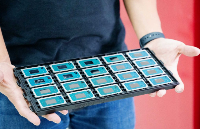

2016 年底,谷歌 TPU 团队的十位核心开发者中的八位悄悄离职,创办了一家名为 Groq 的机器学习系统公司。在此后的三年里,这家公司一直很低调。但最近,他们带着一款名为 TSP 的芯片架构出现在公众视野里。

TSP 的全称是 Tensor Streaming Processor,专为机器学习等 AI 相关需求打造。该架构在单块芯片上可以实现每秒 1000 万亿(10 的 15 次方)次运算,是全球首个实现该级别性能的架构,其浮点运算性能可达每秒 250 万亿次(TFLOPS)。在摩尔定律走向消亡的背景下,这一架构的问世标志着芯片之争从晶体管转向架构。

250 TFLOPS 浮点运算性能是什么概念?目前的世界第一超级计算机 Summit,其峰值算力为 200,794.9 TFLOPS,它的背后是 28,000 块英伟达 Volta GPU。如果 TSP 达到了类似的效率,仅需 803 块就可以实现同样的性能。Groq 在一份白皮书中介绍了这项全新的架构设计。此外,他们还将在于美国丹佛举办的第 23 届国际超算高峰论坛上展示这一成果。

我们为这一行业和我们的客户感到兴奋,Groq 的联合创始人和 CEO Jonathan Ross 表示。顶级 GPU 公司都在宣称他们有望在未来几年向用户交付一款每秒百万亿次运算性能的产品,但 Groq 现在就做到了,而且建立了一个新的性能标准。就低延迟和推理速度而言,Groq 的架构比其他任何用于推理的架构都要快许多倍。我们与用户的互动证明了这一点。

Groq 的 TSP 架构是专为计算机视觉、机器学习和其他 AI 相关工作负载的性能要求设计的。对于一大批需要深度学习推理运算的应用来说,Groq 的解决方案是非常理想的选择,Groq 的首席架构师 Dennis Abts 表示,但除此之外,Groq 的架构还能用于广泛的工作负载。它的性能和简洁性使其成为所有高性能即数据和计算密集型工作复杂的理想平台。

Groq 的这款架构受到软件优先(software first)理念的启发。它在 Groq 开发的 TSP 中实现,为实现计算灵活性和大规模并行计算提供了一种新的范式,但没有传统 GPU 和 CPU 架构的限制和沟通开销。在 Groq 的架构中,Groq 编译器负责编码所有内容:数据流入芯片,并在正确的时间和正确的地点插入,以确保计算实时进行,没有停顿。执行规划由软件负责,这样就可以释放出原本要用于动态指令执行的宝贵硬件资源。

在传统的体系架构中,将数据从 DRAM 移动到处理器需要大量的算力和时间,而且相同工作负载上的处理性能也是可变的。在典型的工作流中,开发人员通过反复运行工作负载或程序来对其进行配置和测试,以验证和度量其平均处理性能。由于处理器接收和发送数据的方式不同,这种处理可能会得到略有差别的结果,而开发人员的工作就是手动调整程序以达到预定的可靠性级别。

但有了 Groq 的硬件和软件,编译器就可以准确地知道芯片的工作方式以及执行每个计算所需的时间。编译器在正确的时间将数据和指令移动到正确的位置,这样就不会有延迟。到达硬件的指令流是完全编排好的,使得处理速度更快,而且可预测。

为了满足深度学习等计算密集型任务的需求,芯片的设计似乎正在变得越来越复杂。但 Groq 认为,这种趋势从根本上就是错误的。他们在白皮书中指出,当前处理器架构的复杂性已经成为阻碍开发者生产和 AI 应用部署的主要障碍。当前处理器的复杂性降低了开发者工作效率,再加上摩尔定律逐渐变慢,实现更高的计算性能变得越来越困难。

Groq 的芯片设计降低了传统硬件开发的复杂度,因此开发者可以更加专注于算法(或解决其他问题),而不是为了硬件调整自己的解决方案。有了这种更加简单的硬件设计,开发者无需进行剖析研究(profiling),因此可以节省资源,更容易大规模部署 AI 应用。与基于 CPU、GPU 和 FPGA 的传统复杂架构相比,Groq 的芯片还简化了认证和部署,使客户能够简单而快速地实现可扩展、单瓦高性能的系统。

Groq 的张量流架构可以在任何需要的地方提供算力。与当前领先的 GPU、CPU 相比,Groq 处理器的每个晶体管可以实现 3-6 倍的性能提升。这一改进意味着交付性能的提升、延迟的下降以及成本的降低。结果是,Groq 的架构使用起来更加简单,而且性能高于传统计算平台。

(责任编辑:fqj)

-

芯片

+关注

关注

452文章

50150浏览量

420512 -

谷歌

+关注

关注

27文章

6126浏览量

104903

发布评论请先 登录

相关推荐

基于迅为RK3588开发板的AI图像识别方案

苹果承认使用谷歌芯片来训练AI

解析OrangePi AIpro:什么是 TOPS,为什么它对 AI PC很重要?

英伟达加速AI芯片迭代,推出Rubin架构计划

两小时“吼出”121次AI,谷歌背后埋伏着Open AI的幽灵

单路运算放大器芯片的作用是什么?

谷歌推新AI音乐工具,发布第六代TPU芯片

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

Cerebras发布WSE-3 AI芯片,性能翻倍达4万亿晶体,能耗不变

AI芯片的技术原理与架构

谷歌发布全新AI模型Genie

骁龙X Elite处理器在AI生成图片性能超群,英特尔亦被超越

谷歌推出AI扩散模型Lumiere

谷歌发布全新AI SDK,简化安卓应用集成

如何打破AI芯片垄断霸权

谷歌全新AI架构,单芯片每秒1000万亿次运算

谷歌全新AI架构,单芯片每秒1000万亿次运算

评论