当地时间8月18日,半导体行业盛会——Hotchips国际大会在美国斯坦福大学举行。在此次会上,芯片初创公司Cerebras在Hot Chips上展出了号称是“世界上最大”的半导体AI芯片Wafer Scale Engine(以下简称“WSE”)。

全球最大AI芯片:46225mm²,1.2万亿晶体管

据介绍,WSE芯片基于台积电16nm工艺,核心面积超过46225mm²,集成了高达1.2万亿个晶体管。这是个什么概念呢?

目前最大的GPU芯片——NVIDIA用于AI加速的GV100大核心,集成了211亿晶体管(核心面积815mm²)。WSE芯片晶体管数量是这个最大的GPU芯片的60倍,面积则是它的56倍多。

以晶圆的面积来作为比较的话,WSE芯片的面积比8英寸的晶圆的面积还要大,当然,比12英寸的晶圆的面积还是要小一些。也就是说一块12英寸的晶圆可能只能产出一个WSE芯片,这确实有点吓人。全球最大芯片确实不是“浪得虚名”。

史上最大芯片跟网球对比

Cerebras 表示,如果没有多年来与台积电(TSMC)的密切合作,他们不可能取得这个创纪录的成就。台积电是全球最大的半导体代工厂,在先进工艺技术方面处于领先地位。WSE芯片由台积电采用先进的16nm制程技术制造。

400000个AI优化的内核

WSE包含40万个AI优化的计算内核(compute cores)。这种计算内核被称为稀疏线性代数核(Sparse Linear Algebra Cores, SLAC),具有灵活性、可编程性,并针对支持所有神经网络计算的稀疏线性代数进行了优化。SLAC的可编程性保证了内核能够在不断变化的机器学习领域运行所有的神经网络算法。

由于稀疏线性代数内核是为神经网络计算进行优化的,因此它们可实现业界最佳利用率——通常是GPU的3倍或4倍。此外,WSE核心还包括Cerebras发明的稀疏捕获技术,以加速在稀疏工作负载(包含0的工作负载)上的计算性能,比如深度学习。

零在深度学习计算中很普遍。通常,要相乘的向量和矩阵中的大多数元素都是0。然而,乘以0是浪费硅、功率和时间的行为,因为没有新的信息。

因为GPU和TPU是密集的执行引擎——引擎的设计永远不会遇到0——所以它们即使在0时也会乘以每一个元素。当50-98%的数据为零时,如深度学习中经常出现的情况一样,大多数乘法都被浪费了。由于Cerebras的稀疏线性代数核心永远不会乘以零,所有的零数据都被过滤掉,可以在硬件中跳过,从而可以在其位置上完成有用的工作。

超大的片上内存

内存是每一种计算机体系结构的关键组成部分。靠近计算的内存意味着更快的计算、更低的延迟和更好的数据移动效率。高性能的深度学习需要大量的计算和频繁的数据访问。这就要求计算核心和内存之间要非常接近,而在GPU中却不是这样,GPU中绝大多数内存都很慢,而且离计算核心很远。

WSE芯片包含了比迄今为止任何芯片都要多的内核和本地内存,并且在一个时钟周期内拥有18GB的片上内存。WSE上的核心本地内存的集合提供了每秒9 PB的内存带宽——比最好的GPU大3000倍的片上内存和10000倍的内存带宽。

低延迟、高带宽的独特通信结构

Cerebras WSE芯片内部拥有高达40万个内核,由于这些内核和片上内存都是集成在单个晶圆上互连的单芯片,核心更靠近内存,所有通信也都在芯片上进行,通信带宽高、延迟低,因此核心组可以以最高效率进行协作。

此外,WSE上还使用了处理器间通信结构Swarm,它以传统通信技术功耗的一小部分实现了带宽的突破和低延迟。Swarm提供了一个低延迟、高带宽的2D网格,它将WSE上的所有400,000个核连接起来,每秒的带宽总计达100 petabits。

要知道NVIDIA的NVLink 2.0最大带宽也不过300GB/s,算下来也就是2.4Tb/s,WSE的内部带宽是现有水平的3.3万倍之多。

路由、可靠的消息传递和同步都在硬件中处理。消息会自动激活每个到达消息的应用程序处理程序。Swarm为每个神经网络提供了一个独特的、优化的通信路径。软件根据正在运行的特定用户定义的神经网络的结构,配置通过400,000个核心的最优通信路径,以连接处理器。

典型的消息遍历一个具有纳秒延迟的硬件链接。一个Cerebras WSE的总带宽是每秒100 PB。不需要TCP/IP和MPI等通信软件,因此可以避免性能损失。这种结构的通信能量成本远低于远低于每比特 1 焦耳,比GPU低了近两个数量级。结合了巨大的带宽和极低的延迟,Swarm通信结构使 Cerebras WSE比任何当前可用的解决方案学习得更快。

为AI而生

正如前面所介绍的,Cerebras WSE中的46,225平方毫米的芯片面积上包含40万个AI优化的核心,无缓存、无开销的计算内核,以及和18千兆字节的本地化分布式超高速SRAM内存,内存带宽为每秒9 PB。这些核心通过细粒度、全硬件、片上网状连接通信网络连接在一起,可提供每秒100 petabits的总带宽。更多核心、更多本地内存和低延迟高带宽结构,共同构成了面向AI加速任务的最佳架构。

“Cerebras WSE”专为人工智能设计而设计,其中包含了不少基础创新,解决了限制芯片尺寸的长达数十年的技术挑战 - 如良品率,功率传送、封装等,推动了最先进技术的发展和包装,每个架构决策都是为了优化AI工作的性能。结果是,Cerebras WSE根据工作量提供了数百或数千倍的现有解决方案的性能,只需很小的功耗和空间。”Cerebras Systems首席执行官的Fieldman说。

通过加速神经网络训练的所有元素来实现这些性能提升。神经网络是一种多级计算反馈回路。输入在循环中移动速度越快,循环学习的速度越快,即训练时间越短。可以通过加速循环内的计算和通信来加速输入的循环速度。

“虽然AI在一般意义上被使用,但没有两个数据集或两个AI任务是相同的。新的AI工作负载不断涌现,数据集也在不断变大,”Tirias Research首席分析师兼创始人Jim McGregor在一份声明中表示。“随着AI的发展,芯片和平台解决方案也在不断发展。Cerebras WSE是半导体和平台设计方面的一项惊人的工程成就,它在单个晶圆级的解决方案中提供了超级计算机级的计算能力、高性能内存和带宽。”

Cerebras面临的挑战

Cerebras Systems公司位于美国加州Los Altos,拥有194名员工。Andrew Feldman是Cerebras Systems公司的CEO,他曾创建微型服务器公司SeaMicro,并以3.34亿美元的价格卖给了AMD。

Cerebras CEOFieldman与SeaMicro box最初版本合影

芯片尺寸在AI任务中非常重要,因为大尺寸芯片可以更快地处理信息,在更短的时间内给出答案。这能够减少“训练时间”,使研究人员能够测试更多想法,使用更多数据并解决新问题。谷歌、Facebook、OpenAI、腾讯、百度和许多企业都认为,今天制约AI发展的基本限制是训练模型需要的时间太长。因此,缩短训练时间有望消除整个行业取得进步的主要瓶颈。

当然,芯片制造商通常不会制造这么大的芯片。在单个晶片的制造过程中通常会出现一些杂质。如果一种杂质会导致一块芯片发生故障,那么晶圆上的多种杂质就会导致多块芯片出问题。实际制造出的芯片产量仅占实际工作芯片的一小部分。如果晶圆上只有一个芯片,它有杂质的几率是100%,杂质会使芯片失效。但Cerebras设计的芯片留有冗余,一种杂质不会导致整个芯片都不能用。

不过即便如此,Cerebras WSE芯片的面积也已经超过了单个8英寸晶圆的面积,这也意味着制造一个WSE芯片可能就需要一个12英寸的晶圆,并且对于这个正方形的芯片来说,用12英寸的晶圆来生产还会有较大的浪费。此外,由于单个12英寸晶圆只能生产一个WSE芯片,这也使得WSE芯片的量产和良率提升将会变得非常的困难,成本也将极其的高昂。

如此大的面积将使得WSE芯片在后续的应用当中也将会遇到很多的问题,比如需要定制巨大的PCB板,贴片也是问题,还需要非常多的周边器件来配合,这也使得最终的终端产品体积将会非常的巨大,另外其功耗、散热也是很大的问题。根据官方的数据显示,WSE芯片的功耗为15千瓦。

所以,有网友质疑称,“这么大的芯片贴在PCB上,要是稍微出现热胀冷缩或者翘曲,焊球阵列可能得崩掉一片”。不过也有业内人士表示,“WSE芯片可以不需要PCB,数据直接接光模块传输”。

此外,要想很好的利用这颗芯片,必须要配套的系统和软件。官方称,WSE仅支持在极少数系统中运行,但是并未指出可以在哪些系统中运行。

而且WSE内部拥有40万个内核,如何合理的调配这40万个内核也是一个大的难题,如果不能最高效的让这40万个内核同时工作,那么做这么大个芯片其实是没有太大意义的。也就是说需要适合的任务和算法来配套发挥出WSE芯片的能力才有实际的意义。这就像超级计算机一样,如果没有适合的足够多的任务来满负荷运转,其实是会存在非常大的浪费的。

值得注意的是,随着摩尔定律的推进越来越困难,芯片的制造封装开始由传统的2D转向2.5D/3D,目前chiplet多个小芯片组合或堆叠在一起的2.5D/3D封装成为大势所趋,再加上新的高速互联技术的不断涌现,未来,WSE芯片这类的单晶圆芯片在低延迟上的优势可能将会被进一步弱化,但是WSE芯片所面临的量产、良率、成本、功耗、散热等问题却是非常难以解决的。

-

gpu

+关注

关注

28文章

4736浏览量

128931 -

晶体管

+关注

关注

77文章

9688浏览量

138157 -

AI芯片

+关注

关注

17文章

1886浏览量

35014

原文标题:4.6万mm²!40万核心!全球最大AI芯片意义何在?

文章出处:【微信号:icsmart,微信公众号:芯智讯】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

晶体管与场效应管的区别 晶体管的封装类型及其特点

NMOS晶体管和PMOS晶体管的区别

CMOS晶体管和MOSFET晶体管的区别

芯片晶体管的深度和宽度有关系吗

PNP晶体管符号和结构 晶体管测试仪电路图

世界第一AI芯片发布!世界纪录直接翻倍 晶体管达4万亿个

苹果M3芯片的晶体管数量

M3芯片有多少晶体管

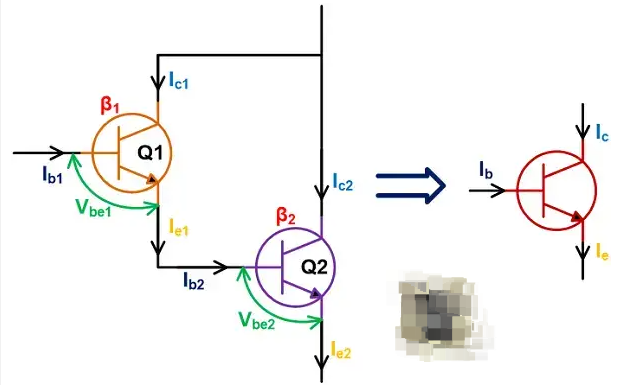

什么是达林顿晶体管?达林顿晶体管的基本电路

晶体管的主要参数

晶体管Ⅴbe扩散现象是什么?

如何走向万亿级晶体管之路?

全球最大AI芯片:46225mm²,1.2万亿晶体管

全球最大AI芯片:46225mm²,1.2万亿晶体管

评论