在加速计算领域25年,英伟达用15亿块GPU的出货量交上了一份学霸成绩单。

这每一块GPU都兼容CUDA,都采用同一个架构——这是黄仁勋的GPU帝国中最可圈可点的一笔。统一的架构,可以用于各种工作负载去实现加速计算;在芯片起点之上,通过完整的堆栈工程可进一步实现加速。

CUDA平台具有丰富的库、工具和应用程序,仅去年就发布了500多个SDK和库,其中既有全新内容,也有更新版本。通过不断优化,深度学习训练在3年内提升了4倍、深度学习推理在1年内提高了2倍。

过去几年内,AI取得了巨大的进展,开始逐步改变各个行业。从图象识别、图象分类到识别不同的物体等,甚至能够识别图象中的每一个像素。这背后,深度学习的驱动力量是巨大的。在今年的GTC上,黄仁勋也重点介绍了英伟达在推荐系统和会话式AI二大方向的重大进展。

在线推荐系统为“双11”提速

推荐系统已经成为互联网的重要引擎。我们在线购物时有数十亿的产品有待选择,上万亿的网页可供浏览、上百万的视频以及应用……如何将合适的内容、产品在合适的时间推送给用户?这是所有电商平台、社交媒体等面临的最大痛点。

这背后需要非常深入地理解每一个用户的偏好、历史行为等,以及每一个产品多种多样的特性,这几乎形成了一个TB级的数据集。

而一个最为生动的案例就是阿里巴巴的年度购物节“双11”。今年“双11”,阿里巴巴创造了380亿美元的销售额,相比于去年的310亿美元,增长了近四分之一,是“黑色星期五”和“网购星期一”的网购销售额总和的两倍多。

对于阿里巴巴来说,推荐系统是一个至关重要的应用程序。该系统可以向用户展示与其喜好相匹配的商品,从而提高点击率。而点击率在电商行业一直都是提高销售量的重要驱动力。点击率的每一次小幅提高都会直接影响用户的体验和商家的营收。

阿里巴巴使用NVIDIA GPU支持资源分配、模型量化和图变换三项优化策略,从而提高吞吐量和响应性。通过NVIDIA T4 GPU,能够为推荐模型提供加速,实现每秒处理780个查询,远远领先于基于CPU每秒3个查询的推理。

英伟达加速计算产品管理总监Paresh Kharya表示,推荐系统所面临的挑战是巨大的,主要体现在两方面:第一,这些模型极其复杂,因为需要处理的数据量是海量的。为了提升推荐的相关度,必须要对所有参数来进行建模。比如:用户的一些购买记录、浏览记录等,要处理的参数非常多。第二,这些模型要做出实时的计算,因为用户在浏览时需要立刻看到推荐结果,不可能等待很长时间。

这两大挑战都需要以非常快的速度完成计算,阿里巴巴从CPU转移到GPU的使用后,点击通过率提升了10%。而事实上,这样的“点击率”每提升一点点都是非常困难的,GPU由于其实时性、大规模运行的特性能够用于这一系统中。

而不仅仅是电子商务领域,只要是需要将产品与人之间进行匹配都需要用到这样的推荐系统。百度、快手、美团、微软必应,甚至一些传统企业如:沃尔玛、美国邮政等等,都在其推荐系统中采用了英伟达的GPU平台。

值得一提的是,其他的处理器如FPGA目前也在发力推荐系统这一领域。Paresh Kharya表示,AI的更新迭代非常快,模型的规模非常大,每隔几分钟就在进行更新,整个推理过程不断在变化,因此需要不断对这些模型进行训练,才可以进行有效的推荐,这需要大量的算力。GPU可以说是AI领域的专用芯片,有指令集优势、全可编程、并且是软件定义的。此外,架构也是向前兼容的,整个硬件架构可以随着软件不断更新,而且是在软件库就可以直接更新。

不光是GPU能提供的算力,英伟达也在通过工具和软件来提供支持。比如通过最新的TensorRT来支持模型在各种情景下的部署,并且支持上百万用户在每秒内做数十亿的搜索。

会话式AI通往真正的人工智能人机交互

在会话式AI方面,黄仁勋宣布了最新版本的推理软件NVIDIA Tensor RT7,它能够实现更智能的AI人机交互,可实现与语音代理、聊天机器人和推荐引擎等应用进行实时互动。

实现会话式AI的难点主要在于什么?Paresh Kharya表示,要实现会话式AI,首先,需要理解用户到底在说什么,然后将他所说的语音转化成文字,然后理解文字的意思,再把它转化成语言,所以涉及很多模型同时发挥作用,需要多种多样的神经网络提供支持。第二,所有这个复杂计算的过程必须要在300毫秒之内完成,假设如果需要几秒钟的话,这在实际的对话中是无法容忍的时延,会话式AI也就失去了意义。

TensorRT 7内置新型深度学习编译器。该编译器能够自动优化和加速递归神经网络与基于转换器的神经网络。与在CPU上运行时相比,会话式AI组件速度提高了10倍以上,从而得以实现所需的300毫秒阈值以下。

对于在会话式AI领域的投入,黄仁勋表示:“我们已进入了一个机器可以实时理解人类语言的AI新时代。TensorRT 7使这成为可能,为世界各地的开发者提供工具,使他们能够构建和部署更快、更智能的会话式AI服务,实现更自然的AI人机交互。”

TensorRT是英伟达的推理优化软件。英伟达的GPU不论是用在自动驾驶、数据中心,还是嵌入式设备等领域,都需要运行在PyTorch、TensorFlow等多个框架中训练自我优化的AI模型,TensorRT能够提供这种优化的模型。

由于AI有多种多样的使用场景,不同场景由不同的神经网络提供支持。而为了优化AI性能,也需要优化各种各样的神经网络。TensorRT 7的推出算是跨出了巨大的一步,Transformer和RNN这些模型,都可以用TensorRT 7来进行优化。其中,Transformer典型的模型是BERT,有很多非常先进的自然语言理解的功能;RNN的典型例子就是语音识别或者将文本转化成语音。

英伟达对TensorRT 7也进行了大量的优化,例如很多数学的运算,确保能够更加高效、并且减少使用的内存。另外,TensorRT 7中引入了内核生成的功能,用任何RNN都可以生成一个优化的内核。对比TensorRT 5仅能支持种类很少的几个神经网络,TensorRT 7基本上可以支持各大类神经网络,这些模型对于“会话式AI”是至关重要的。

首次兼容arm架构做加速计算

在GTC上,英伟达还释放出了一个很值得玩味的信息:宣布推出基于arm的首个参考架构——NVIDIA HPC for arm.双方这一合作,究竟是英伟达加入arm的生态,还是arm拥抱英伟达的江湖?

英伟达方面只是淡淡一句:希望不论是数据中心还是边缘计算,不论是AI还是高性能计算,都能给客户更多选择。之前arm不支持CUDA,客户已反复要求我们使用CUDA加速arm,并将arm服务器打造成HPC和AI的理想选择。

全球有1500亿台基于arm架构的设备,为客户想实现的创新提供多种功能:包括互联、内存、CPU内核、计算能力等多元化的支持。

在边缘计算领域,英伟达已有arm架构许可;超算领域,双方于今年6月宣布了合作。两个强大平台和生态的握手,也并不意外。

-

NVIDIA

+关注

关注

14文章

4996浏览量

103217 -

gpu

+关注

关注

28文章

4744浏览量

129018 -

英伟达

+关注

关注

22文章

3783浏览量

91246

发布评论请先 登录

相关推荐

《CST Studio Suite 2024 GPU加速计算指南》

英伟达与谷歌联手加速量子计算设备设计

英伟达与谷歌携手加速量子计算设备设计

软银升级人工智能计算平台,安装4000颗英伟达Hopper GPU

三星电子HBM3E内存获英伟达认证,加速AI GPU市场布局

英伟达发布新版NVIDIAApp

英伟达数据中心GPU出货量飙升,市场份额持续领跑

英伟达GPU新品规划与HBM市场展望

英伟达去年数据中心GPU出货量占比约98%

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

英伟达、AMD、英特尔GPU产品及优势汇总

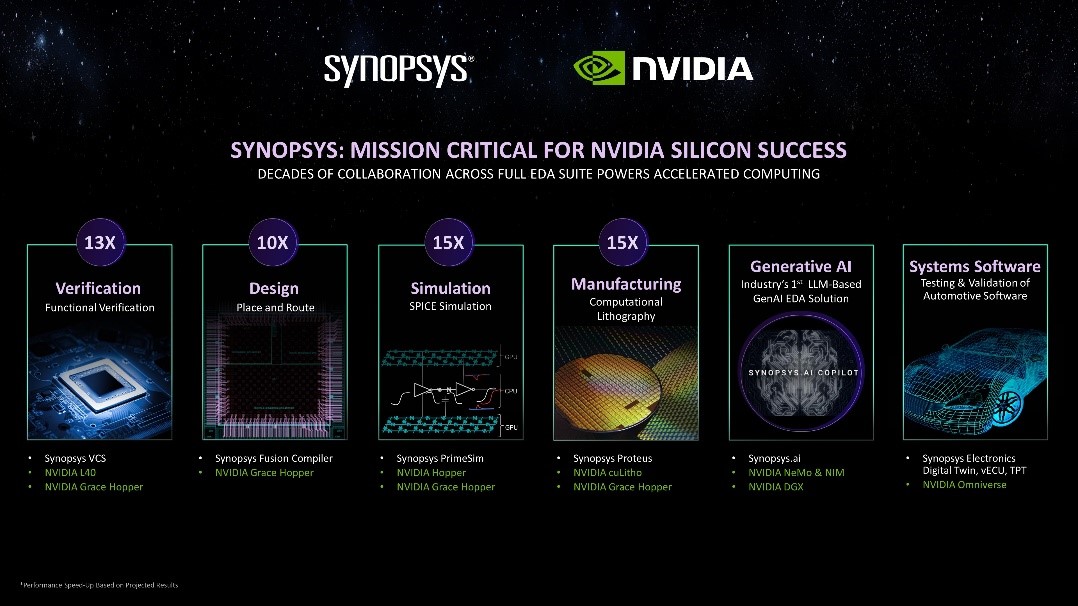

新思科技携手英伟达:基于加速计算、生成式AI和Omniverse释放下一代EDA潜能

加速计算25年,英伟达GPU帝国的三块新版图

加速计算25年,英伟达GPU帝国的三块新版图

评论