从历史上看,半导体行业逐年提高芯片速度的主要方法是通过缩小晶体管,使更多的晶体管可以安装在处理器上。Cerebras Systems Inc.正在采取另一种方法:加利福尼亚的芯片初创公司没有使晶体管变小,而是使处理器变大了-更大。

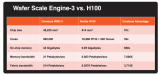

Cerebras今天发布了Wafer Scale Engine,这是一种人工智能芯片,其尺寸是Nvidia Corp.旗舰V100数据中心图形卡的57倍。这家初创公司称赞它是有史以来最大的处理器。

晶圆级引擎(Wafer Scale Engine,简称WSE)是一个8.5英寸乘8.5英寸的琥珀色砖(如图),其中包含不少于1.2万亿个晶体管。相比之下,V100为211亿。WSE的电路分为400,000个处理内核,这些内核专门针对AI和18 GB的高速板载内存进行了优化。

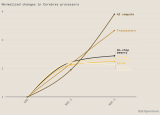

Cerebras将该芯片作为数据中心设备的一部分推向市场,该数据中心设备具有自己的水冷系统,可以吸收所有这些核心的热量。这家初创公司的首席执行官安德鲁·费尔德曼(Andrew Feldman)告诉《财富》杂志,该机器将提供具有多个Nvidia显卡的服务器的150倍的计算能力。Cerebras称磅一磅,它的设备消耗了具有相同处理能力的基于Nvidia的服务器场所需的2%至3%的空间和电力。

该效率是WSE超大型外形的直接结果。在由多个单独的GPU组成的传统AI环境中,要处理的数据必须通过相对较慢的网络链路不断在不同芯片之间传输,这会造成瓶颈。对于WSE而言,这不是问题,因为所有计算都在同一电路板上完成。

将处理操作集中在一个大芯片上以提高效率的想法已经存在了数十年。但是,由于实现此概念涉及巨大的技术挑战,因此Cerebras之前没有一家公司设法实现这一目标。

最大的障碍之一在于制造过程。即使在世界上最现代化的芯片制造工厂,也没有办法生产出WSE大小的处理器,而至少有1.2万亿个晶体管出现问题。有缺陷的晶体管通常会使整个处理器无法使用,但是Cerebras通过在WSE中建立一个可以在故障部件周围路由数据的网络来解决了这个问题。

Cerebras产品管理总监Andy Hock在一篇博客文章中写道,该芯片的设计“具有核心,内存和互连的基本特性,并具有逻辑上的极限。” “通过将所有芯片连接起来,通信速度比InfiniBand等片外技术快了数千倍。”

这家初创公司的技术正引起业界的严重关注。Cerebras已经从包括早期Twitter Inc.支持者Benchmark,前Advanced Micro Devices Inc.首席技术官Fred Weber和OpenAI首席科学家Ilya Sutskever在内的投资者筹集了超过2亿美元的资金。

Cerebras计划从9月开始发货其基于WSE的数据中心设备。该初创公司已向数家早期采用者提供了该机器的原型版本。

-

晶圆

+关注

关注

52文章

4909浏览量

127967 -

晶体管

+关注

关注

77文章

9688浏览量

138157 -

人工智能芯片

+关注

关注

1文章

120浏览量

29103

发布评论请先 登录

相关推荐

卡诺模型为人工智能领域提供了一种全新的视角

嵌入式和人工智能究竟是什么关系?

《AI for Science:人工智能驱动科学创新》第6章人AI与能源科学读后感

AI for Science:人工智能驱动科学创新》第4章-AI与生命科学读后感

《AI for Science:人工智能驱动科学创新》第一章人工智能驱动的科学创新学习心得

risc-v在人工智能图像处理应用前景分析

名单公布!【书籍评测活动NO.44】AI for Science:人工智能驱动科学创新

FPGA在人工智能中的应用有哪些?

人工智能初创企业Scale AI融资10亿美元

5G智能物联网课程之Aidlux下人工智能开发(SC171开发套件V2)

5G智能物联网课程之Aidlux下人工智能开发(SC171开发套件V1)

Cerebras推出性能翻倍的WSE-3 AI芯片

最强AI芯片发布,Cerebras推出性能翻倍的WSE-3 AI芯片

Cerebras发布了Wafer Scale Engine,一种人工智能芯片

Cerebras发布了Wafer Scale Engine,一种人工智能芯片

评论