我们研究视频到视频的合成问题,其目的是学习从输入源视频(例如,一系列语义分割掩码)到精确描述源视频内容的输出真实感视频的映射功能。

虽然它的图像对应物(图像到图像合成问题)是一个受欢迎的话题,但是视频到视频合成问题在文献中很少探讨。在不了解时间动态的情况下,将现有的图像合成方法直接应用于输入视频通常会导致视觉质量低下的时间不连贯视频。

在本文中,我们提出了一种在生成对抗性学习框架下的新颖的视频合成方法。通过精心设计的生成器和鉴别器架构以及时空对抗目标,我们可以通过多种输入格式(包括分割蒙版,草图和姿势)获得高分辨率,逼真的,时间上连贯的视频结果。在多个基准上进行的实验表明,与强基准相比,我们的方法具有优势。

尤其是,我们的模型能够合成长达30秒的街道场景的2K分辨率视频,从而大大提高了视频合成的最新水平。最后,我们将我们的方法应用于未来的视频预测,其性能超过了几个最先进的竞争系统。

我们的模型能够合成长达30秒的街道场景的2K分辨率视频,从而大大提高了视频合成的最新水平。最后,我们将我们的方法应用于未来的视频预测,其性能超过了几个最先进的竞争系统。

我们的模型能够合成长达30秒的街道场景的2K分辨率视频,从而大大提高了视频合成的最新水平。最后,我们将我们的方法应用于未来的视频预测,其性能超过了几个最先进的竞争系统。

-

视频

+关注

关注

6文章

1945浏览量

72903 -

图像

+关注

关注

2文章

1084浏览量

40461 -

鉴别器

+关注

关注

0文章

8浏览量

8758

发布评论请先 登录

相关推荐

PWM信号生成方法 PWM调制原理讲解

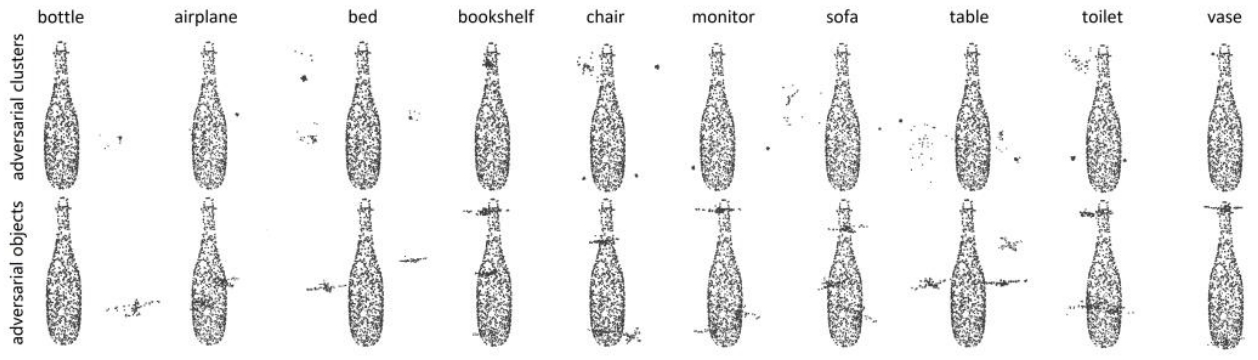

鉴源实验室·如何通过雷达攻击自动驾驶汽车-针对点云识别模型的对抗性攻击的科普

视频时钟合成芯片怎么用

altium designer原理图生成方法

微液滴生成方法及发展趋势

生成对抗网络(GANs)的原理与应用案例

深度学习中的无监督学习方法综述

如何用C++创建简单的生成式AI模型

ESP32-S3-KROVO2如何在ADF框架下实现wifi连接?

阿里云视频生成技术创新!视频生成使用了哪些AI技术和算法

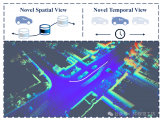

LiDAR4D:基于时空新颖的LiDAR视角合成框架

检索增强生成(RAG)如何助力企业为各种企业用例创建高质量的内容?

深度学习生成对抗网络(GAN)全解析

一种在生成对抗性学习框架下的新颖的视频合成方法

一种在生成对抗性学习框架下的新颖的视频合成方法

评论