(文章来源:网络整理)

互联网用户所创造的“内容”正在迅猛增长,从不同渠道涌现的文本、图像和视频等不同类型的媒体数据以及用户信息更加紧密混合。它们正在以一种新的形式,更为形象综合地表达语义、主题和事件。针对当前媒体数据呈现出的特点进行深入研究已成为学术热点,多种类型媒体数据依赖共存,各种平台和应用的数据来源广泛,个体和群体参与数据产生的用户交互史无前例。

谷歌的前任研究主管皮特·诺文(Perter Norvig)博士曾在2010年《自然》杂志上发表文章《2020愿景》,指出今后10年,文本、图像、视频等数据以及用户交互信息和各种传感器信息将混合在一起,从搜索角度看,搜索引擎对检索结果进行的是内容综合而非数据罗列,这也将是谷歌今后面临的巨大挑战。我国也同样重视“跨媒体”研究,国家科技部于2011年11月启动了973计划项目“面向公共安全的跨媒体计算理论与方法”,对“跨媒体”的表达建模、语义学习、挖掘推理和搜索排序等核心问题开展了理论研究。目前,媒体计算需要重点解决的两个难点是消除“异构鸿沟”和“语义鸿沟。

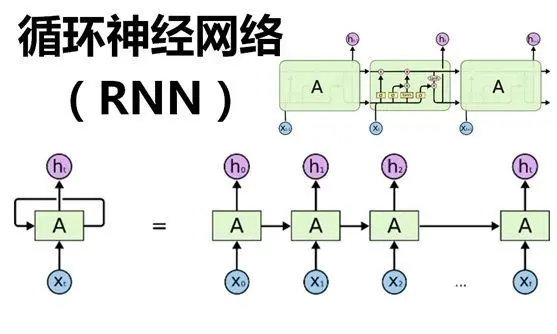

传统的媒体计算研究方法主要从手工构建的底层特征出发,利用机器学习方法填补异构鸿沟和语义鸿沟。与传统方法不同深度学习是通过将无监督逐层预训练与有监督微调(fine-tuning)有机结合,实现端到端方式的特征学习。其基本动机是构建多层网络来学习隐含在数据内部的关系,从而使学习得到的特征具有更强的表达力和泛化能力。

在大规模数据上进行的实验表明:通过深度学习得到的特征表示在自然语言处理(词向量学习)、知识图谱构建、图像分类和语音识别等领域表现出良好的性能。例如谷歌研究组在2014年大规模视觉识别挑战赛中采用改进的卷积神经网络GoogLeNet,将图像识别准确率提升到93.3%。

通常,在媒体语义理解过程中可获取不同类型的媒体数据,如:新闻报道包含了文字和文字对应的图像,视频包含了视觉和听觉信息。不同类型的媒体数据从不同侧面反映了高层语义,因此多模态语义学习需要对不同模态的信息进行整合。1976年,麦格克(McGurk)等人验证了人类对外界信息的认知是基于不同感官信息而形成的整体性理解,任何感官信息的缺乏或不准确,都将导致大脑对外界信息的理解产生偏差,这个现象被称为“McGurk现象”。McGurk现象揭示了大脑在进行感知时,不同感官会被无意识地自动结合在一起对信息进行处理。

由于深度学习具有通过逐层抽象来形成良好特征的能力,因此可利用该方法来形成不同类型数据的联合特征表示。具体方法有深度典范相关分析(Deep Caconical Correlation Analysis,Deep CCA)、多模态深度学习以及多模态玻尔兹曼机等。这些方法的基本思路是通过不同的深层模型对不同类型数据进行逐层学习,将学习得到的结果进行合并,以得到多模态联合特征表示,最后要求多模态联合特征能有效重建原始不同类型数据或表达相关语义概念。为了得到更好的深层模型,一般在深层模型的最顶端设计反映不同类型数据相互耦合的损失函数来对模型进行优化反馈。

将深度学习应用于语义概念识别和理解时,有两种方法:(1)将深度学习得到的特征表示直接输入给判别分类模型(如支持向量机等);(2)通过softmax函数或回归函数对输人数据、隐含层和输出层(语义标签)之间的概率分布进行建模,然后基于互信息熵最小或间隔距离最大等准则对模型进行优化。

有人的理论研究结果表明:在机器学习中,如果对模型本身的假设产生偏差,则会影响学习结果。因此,如何合理引入数据本身所具有的先验知识和结构线索,来构造和微调深层模型使之更好地处理多模态数据,是一个亟待解决的问题。因此,一些研究开始在生成式深层模型或区别式深层模型中引入数据本身所具有的先验结构,以提升特征学习的泛化能力和区别能力。有人在卷积神经网络输出端引入层次化概念树来促进关联语义所具有的共享特征的学习,有人通过非参贝叶斯假设来提高判别性语义特征学习的灵活度。

(责任编辑:fqj)

-

互联网

+关注

关注

54文章

11081浏览量

102667 -

深度学习

+关注

关注

73文章

5485浏览量

120937

发布评论请先 登录

相关推荐

NPU在深度学习中的应用

GPU深度学习应用案例

AI大模型与深度学习的关系

利用OpenVINO部署Qwen2多模态模型

深度学习中的时间序列分类方法

深度学习中的无监督学习方法综述

深度学习与nlp的区别在哪

深度学习与传统机器学习的对比

深度解析深度学习下的语义SLAM

三星正考虑为Bixby添加生成式AI功能

SuperPoint语义 SLAM深度学习用于特征提取

用语言对齐多模态信息,北大腾讯等提出LanguageBind,刷新多个榜单

关于深度学习用于多模态语义学习的简述

关于深度学习用于多模态语义学习的简述

评论