1、类型

主要有两种类型:数据集变换和聚类。

无监督变换:

降维:接受数据的高维表示,找到新的表示方法,以用较少的特征概括重要特性。

找到“构成”数据的各个组成部分。例如,文本的主题提取。

聚类:

将数据划分成不同的组,每组包含相似的物项

2、降维

1. 主成分分析(PCA)

一种旋转数据集的方法,旋转后的特征在统计上不相关。旋转后,通常根据新特征对数据集的重要性来选择它的一个子集。

主成分

方差最大的方向为“成分1”,这是包含包含最多信息的方向。之后找到与“成分1”正交的包含信息最多的方向,得到“成分2”……利用这一过程找到的方向成为主成分。通常,主成分的个数与原始特征相同。

在PCA找到的额旋转表示中,坐标轴之间 不相关。

应用

高维数据集可视化

特征提取:找到一种数据表示,比给定的原始表示更适合于分析。

对PCA模型的另一种理解:仅适用一些成分对原始数据进行重建。

2. 非负矩阵分解(NMF)

在NMF中,目标是分量和系数均为非负。只能应用于每个特征都是非负的数据,因为非负分量的非负求和不可能得到负值。

与PCA不同,减少分量个数不仅会删除一些方向,而且会创建一组完全不同的分量。

NMF的分量没有按任何特定方法排序,所有分量的地位平等。

NMF使用了随机初始化,根据随机种子的不同可能会产生不同的结果。

3. t-SNE与流形学习

流形学习算法 :主要用于可视化,允许进行更复杂的映射。只能变换用于训练的数据。

t-SNE:找到数据的一个二维表示,尽可能保持数据点之间的距离。试图保存那些点比较靠近的信息。

3、聚类

聚类:将数据集划分成组的任务,这些组叫做簇。

1. K均值聚类

原理

试图找到代表数据特定区域的簇中心。

算法过程

① 将每个数据点分配给最近的簇中心

② 将每个簇中心设置为所分配的所有数据点的平均值,如果簇的分配不再变化,结束;反之,执行步骤1

注:聚类算法与分类算法类似,但不存在真实的标签,标签本身没有先验意义。

注意

每个簇仅由其中心决定,这意味着每个簇都是凸型的,因此,只能找到相对简单的形状。

k均值假设所有簇在某种程度上有相同的直径,它总是将簇之间的边界刚好画在簇中心的中间位置

k均值假设所有方向对每个簇同等重要

特点

优点:

容易理解和实现

运行速度相对较快

扩展到大型数据集比较容易

缺点:

依赖于随机初始化

对簇形状的假设的约束性较强

要求制定所要寻找到簇的个数

2. 凝聚聚类

算法首先声明每个点是自己的簇,然后合并两个最相似的簇,直到满足某种停止准则为止。

连接准则:规定如何度量“最相似的簇”。

① ward型:两个簇合并后,使得所有簇中方差增加最小

② average型:平均距离最小的两个簇合并

③ complete型:簇中点之间最大距离最小的两个簇合并

注:凝聚算法不能对新数据点做出预测

凝聚聚类生成了所谓的层次聚类

3. DBSCAN (具有噪声的基于密度的空间聚类应用)

原理

识别特征空间的“拥挤”区域中的点,这些区域成为密集区域。簇形成数据的密集区域,并由相对较空的区域分隔开。在密集区域中的点成为核心样本,指定参数eps和min_samples。如果在一个点eps的距离内至少有min_samples个数据点,则为核心样本。

算法过程

① 任意选取一个点,检查是否是核心样本。

② 若不是,标记为噪声。反之,标记为核心样本,并分配一个新的簇标签。然后检查邻居,若未被分配,分配簇标签;如果是核心样本,依次访问邻居。

③ 选取另一个尚未被访问过的点,重复以上过程。

最后得到三种点:核心点、边界点、噪声。

特点

优点:

不需先验设置簇的个数

可以划分具有复杂形状的簇

可以找出不属于任何簇的点

缺点:

不允许对新的测试数据进行预测

聚类评估

1. 真实值评估

调整rand指数(ARI),归一化互信息(NMI)

二者都给出了定量的度量,最佳值为1,0表示不相关的聚类。

2. 没有真实值

轮廓系数 计算一个簇的紧致度,值越大越好,最高分数为1。虽然紧致的簇很好,但不允许复杂的形状。

聚类小结

k均值

可以用簇的平均值来表示簇。

可被看做是一种分解方法,。每个数据点都由其簇中心表示

DBSCAN

可以检测噪声点

可以自动判断簇的数量

允许簇有复杂的形状

有时会生成大小差别很大的簇,可能是优点可能是缺点

凝聚聚类

可以提供数据的可能划分的整个层次结构

可以通过树状图查看

-

算法

+关注

关注

23文章

4608浏览量

92845 -

无监督学习

+关注

关注

1文章

16浏览量

2754

发布评论请先 登录

相关推荐

时空引导下的时间序列自监督学习框架

【「时间序列与机器学习」阅读体验】全书概览与时间序列概述

【《大语言模型应用指南》阅读体验】+ 基础知识学习

PyTorch如何训练自己的数据集

基于FPGA的类脑计算平台 —PYNQ 集群的无监督图像识别类脑计算系统

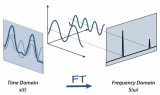

傅里叶变换基本原理及在机器学习应用

机器学习基础知识全攻略

Meta发布新型无监督视频预测模型“V-JEPA”

描绘未知:数据缺乏场景的缺陷检测方案

谷歌MIT最新研究证明:高质量数据获取不难,大模型就是归途

无监督学习的数据集变换和聚类

无监督学习的数据集变换和聚类

评论