2020 年 3 月 25 日,智源研究院学术副院长、清华大学计算机系唐杰教授作客首届中科院,为大家带来《人工智能下一个十年》的主题报告。

唐老师从人工智能发展的历史开始,深入分析人工智能近十年的发展,阐述了人工智能在感知方面取得的重要成果,尤其提到算法是这个感知时代最重要、最具代表性的内容,重点讲解了 BERT、ALBERT、MoCo2 等取得快速进展的算法。最后说到下一波人工智能浪潮的兴起,就是实现具有推理、可解释性、认知的人工智能。

人工智能对社会和经济影响的日益凸显,各国政府也先后出台了对人工智能发展的政策,并将其上升到国家战略的高度。截至目前,包括美国、中国和欧盟在内的多国和地区颁布了国家层面的人工智能发展政策。

时至2019年,中国政府继续通过多种形式支持人工智能的发展。此前,中国形成了科学技术部、国家发改委、中央网 信办、工信部、中国工程院等多个部门参与的人工智能联合推进机制。从2015年开始先后发布多则支持人工智能发展的政策,为人工智能技术发展s和落地提供大量的项目发展基金,并且对人工智能人才的引入和企业创新提供支持。这些政策给行业发展提供坚实的政策导向的同时,也向资本市场和行业利益相关者发出了积极信号。在推动市场应用方面,中国政府身体力行,直接采购国内人工智能技术应用的相关产品,先后落地多个智慧城市、智慧政务等项目。

与其他国家不同,美国虽然在人工智能领域拥有最强实力,但目前尚没有国家层面的人工智能促进计划。在前总统巴拉克·奥巴马在任的最后几个月里,白宫在三份独立报告中为美国的 AI 战略奠定了基础。其中第一份报告《未来人工智能准备》(Preparing for the Future of Artificial Intelligence)明确提出了有关制定 AI 法规、资助研发、自动化、道德、公平与安全的内容。另一份报告《国家人工智能研发战略计划》(National Artificial Intelligence Research and Development Strategic Plan)概述了美国在政府资助 AI 研发上的战略。而最后一份报告《Artificial Intelligence, Automation, and the Economy(人工智能、自动化和经济)》则进一步说明了自动化对社会的影响,以及扩展 AI 有益的方面需要哪些新政策。

自特朗普上任以来,美国政府开始寻求一种截然不同的、自由市场导向的 AI 战略。在2018年 5 月,白宫邀请了业界、学术界和部分政府代表参加了一场人工智能峰会。在会上发言中,白宫科技政策办公室副主任 Michael Kratsios 概述了现总统对于人工智能的态度,他宣布政府目前制定了四大目标:(1)保持美国在人工智能方面的领导地位;(2)支持美国工人;(3)推动政府资助的研发;(4)消除创新的障碍。为了实现这一目标,Kratsios 宣布成立一个 AI 特别委员会,向白宫提供政府层面的、有关人工智能研究与发展方面的建议,同时帮助政府、私企和独立研究者建立合作伙伴关系。他还指出,美国政府将专注于消除创新的监管障碍,让各家公司有更多创新和发展的灵活性。

2018 年 4 月,欧盟委员会通过了《人工智能通讯》。这是一份长达 20 页的文件,阐述了欧盟对 AI 的态度。委员会的目标是:(1)提高欧盟的技术和工业能力,增加公共和私营部门对 AI 的吸收;(2)让欧洲人为 AI 带来的社会经济变化做好准备;(3)确保建立适当的道德和法律框架。主要举措包括承诺将欧盟对 AI 的投资从 2017 年的 5 亿欧元增加到 2020 年底的 15 亿欧元,建立《欧洲人工智能联盟》(人们现在可以加入),以及制定一套新的 AI 道德准则,以解决公平、安全和透明等问题。一个新的「AI 高级别小组」将作为《欧洲人工智能联盟》的指导小组,并将起草道德准则供成员国审议。

▲各国AI政策 在这个时代背景下,我们需要考虑人工智能未来十年会怎样发展。首先,我们需要从人工智能的发展历史中找到灵感。 01AI发展历史 随着克劳德·香农(Claude Shannon)在 1950 年提出计算机博弈,以及阿兰·图灵(Alan Turing)在 1954 年提出“图灵测试”,人工智能这一概念开始进入人们的视野。

到了 20 世纪 60 年代,人工智能出现了第一波高潮,发展出了自然语言处理和人机对话技术。其中的代表性事件是丹尼尔·博布罗(Daniel Bobrow)在 1964 年发表的Natural language input for a computer problem solving system,以及约瑟夫·维森鲍姆 (Joseph Weizenbaum) 在 1966 年发表的 ELIZA—a computer program for the study of natural language communication between man and machine。

此外,还有一个重要的发展——知识库。1968 年,爱德华·费根鲍姆 (Edward Feigenbaum)提出首个专家系统 DENDRAL 的时候对知识库给出了初步的定义,其中隐含了第二波人工智能浪潮兴起的契机。

之后,人工智能进入了一轮跨度将近十年的寒冬。 20 世纪 80 年代,人工智能进入了第二波浪潮,这其中代表性的工作是 1976 年兰德尔·戴维斯 (Randall Davis)构建和维护的大规模的知识库,1980 年德鲁·麦狄蒙(Drew McDermott)和乔恩·多伊尔(Jon Doyle)提出的非单调逻辑,以及后期出现的机器人系统。

在 1980 年,汉斯·贝利纳 (Hans Berliner)打造的计算机战胜双陆棋世界冠军成为标志性事件。随后,基于行为的机器人学在罗德尼·布鲁克斯 (Rodney Brooks)的推动下快速发展,成为人工智能一个重要的发展分支。这其中格瑞·特索罗(Gerry Tesauro)等人打造的自我学习双陆棋程序为后来的增强学习的发展奠定了基础。

20 世纪 90 年代,AI 出现了两个很重要的发展:第一项内容是蒂姆·伯纳斯·李(Tim Berners-Lee)在 1998 年提出的语义互联网路线图,即以语义为基础的知识网或知识表达。后来又出现了 OWL 语言和其他一些相关知识描述语言。第二项内容是杰弗里·辛顿(Geoffrey Hinton)等人提出的深度学习,这标志着第三次人工智能浪潮的兴起。

在这次浪潮中,我们也看到很多企业参与其中,如塞巴斯蒂安·特龙(Sebastian Thrun)在谷歌主导推出的自动驾驶汽车,IBM 的沃森(Watson)于 2011 年在《危险边缘》(Jeopardy)中获得冠军,苹果在 2011 年推出的自然语言问答工具 Siri 等。

以上就是人工智能在 60 多年的发展历史中取得的一些标志性成果和技术。

02AI 近十年的发展

我们再深入分析 AI 近十年的发展,会看到一个重要的标志:人工智能在感知方面取得重要成果。人工智能在语音识别、文本识别、视频识别等方面已经超越了人类,我们可以说 AI 在感知方面已经逐渐接近人类的水平。从未来的趋势来看,人工智能将会有一个从感知到认知逐步发展的基本趋势,如下图所示:

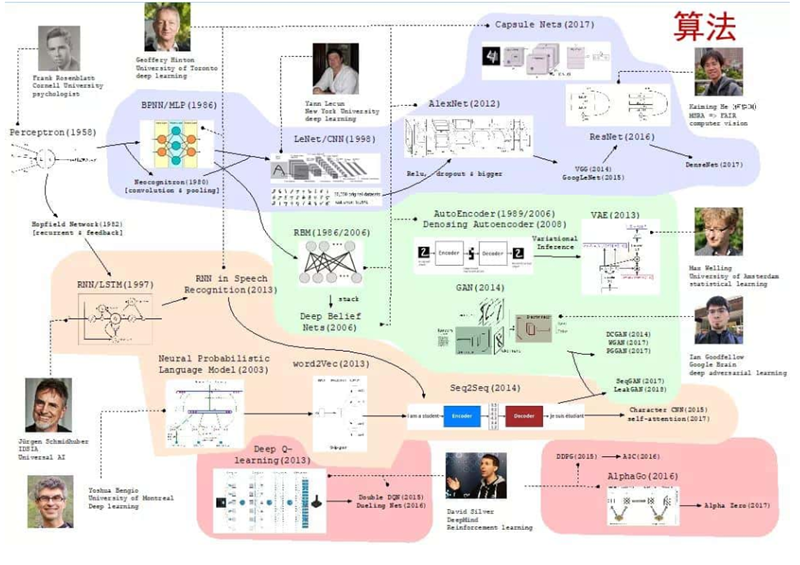

首先,我们来看看 AI 在感知方面做了哪些事情。在感知方面,AlphaGo、无人驾驶、文本和图片之间的跨媒体计算等取得了快速发展。从宏观来看,算法是这个感知时代最重要、最具代表性的内容。如果把最近十年的重要算法进行归类,以深度学习为例进行展示的话,我们可以得到下图所示的发展脉络。

图中最上面浅紫色部分的内容是以前向网络为代表的深度学习算法。第二层淡绿色部分的内容表示一个以自学习、自编码为代表的学习时代。第三层橘色部分的内容代表自循环神经网络(概率图模型的发展)的算法。最下面粉色部分是以增强学习为代表的发展脉络。 总体来讲,我们可以把深度学习算法归类为这四个脉络,而这四个方面都取得了快速的进展。

如果再深入追溯最近几年最重要的发展,会发现 BERT 是一个典型代表。(想深入了解的读者可以阅读https://arxiv.org/pdf/1810.04805.pdf)以 BERT 为代表的预训练算法得到了快速的发展,基本上所有的算法都采用了预训练+微调+ Fine tune 的方法,如下图所示:

BERT 在 2018 年年底通过预训练打败了 NLP 上 11 个任务的经典算法;XLNet 在 2019 年提出来通过双向网络的方法超过了 BERT (想深入了解的读者可以阅读https://arxiv.org/pdf/1906.08237.pdf),如下图所示:

再后来,ALBERT 又超过了 XLNet 和原始的 BERT(想深入了解的读者可以阅读https://arxiv.org/pdf/1909.11942.pdf)。整个 BERT 的发展引发了后续一系列的工作。

在其他方面,也涌现了很多有代表性的工作。如在 2018 年年底,英伟达通过预训练模型实现高清视频的自动生成。(想要了解更多详细信息的读者可以阅读https://arxiv.org/abs/1808.06601) DeepMind 又把代表性的关联关系生成到 graph_net 中,于是在网络中可以实现一定的推理,其结构如下图所示。(想要了解更多信息的读者可以阅读https://arxiv.org/abs/1806.01261)

Facebook 的何恺明等人提出了以 contrastive learning 为基础的 MoCo 及 MoCo2,在很多无监督学习(Unsupervised learning)的结果上超过了监督学习(Supervised learning),这是一个非常重要的进展,这也标志着预训练达到了一个新的高度。(想要了解更多信息的读者可以阅读

https://arxiv.org/abs/1911.05722)

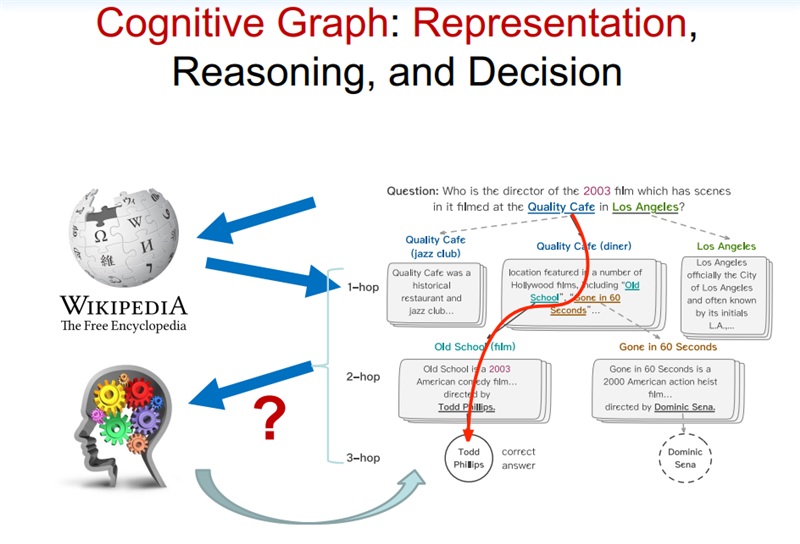

杰弗里·辛顿等人利用 SimCLR,通过简化版的 contrastive learning 超过了 MoCo,后来 MoCo2 又宣称超过了 SimCLR。(想要了解更多信息的读者可以阅读https://arxiv.org/abs/2002.05709) 总体来看,在算法的时代,预训练算法取得了快速的进展。那么未来十年,AI 将何去何从? 03展望未来十年

这里,我想引用张钹院士提出来的第三代人工智能的理论体系。 2015 年,张钹院士提出第三代人工智能体系的雏形。 2017 年,DARPA 发起 XAI 项目,核心思想是从可解释的机器学习系统、人机交互技术以及可解释的心理学理论三个方面,全面开展可解释性 AI 系统的研究。 2018 年底,正式公开提出第三代人工智能的理论框架体系,核心思想为: 建立可解释、鲁棒性的人工智能理论和方法。发展安全、可靠、可信及可扩展的人工智能技术。推动人工智能创新应用。其中具体实施的路线图如下: 与脑科学融合,发展脑启发的人工智能理论。数据与知识融合的人工智能理论与方法。在这个思想框架下,我们做了一定的深入研究,我们称之为认知图谱。其核心概念是知识图谱+认知推理+逻辑表达。 下面展开解释一下。 知识图谱大家很熟悉,是谷歌在 2012 年提出来的。这其中有两个重磅的图灵奖获得者:一个是爱德华·费根鲍姆(1994 年图灵奖得主),他在 20 世界 60 年代就提出来了知识库的一些理论体系和框架;另一个是 1994 年蒂姆·伯纳斯·李(2016 年图灵奖得主、WWW 的创始人、语义网络的创始人)。这里面除了知识工程、专家系统,还有一个代表性的系统 CYC,CYC 可以说是历史上持续时间最长的项目,从 1985 年开始,这个项目直到现在还一直在持续。 说完了知识图谱,我们来说一下认知图谱。 相信很多人对认知图谱都比较陌生,这里我们举一个例子来说明一下。假如我们要解决一个问题“找到一个 2003 年在洛杉矶的 Quality 咖啡馆拍过电影的导演(Who is the director of the 2003 film which has scenes in it filmed at The Quality Cafe in Los Angeles)”。如果是人来解决这个问题的话,可能是先追溯相关的文档,如 Quality 咖啡馆的介绍文档,洛杉矶的维基百科页面等,我们可能会从中找到相关的电影,如 Old School ,在这个电影的介绍文档里面,我们可能会进一步找到该电影的导演 Todd Phillips,经过比对电影的拍摄时间是 2003 年,最终确定答案是 Todd Phillips,具体流程如下图所示:

当我们用传统算法(如 BIDAF, BERT, XLNet)进行解决的时候,计算机可能只会找到局部的片段,仍然缺乏一个在知识层面上的推理能力,这是计算机很欠缺的。人在这方面具有优势,而计算机缺乏类似的能力。 人在解决上述问题的过程中存在推理路径、推理节点,并且能理解整个过程,而 AI 系统,特别是在当下的 AI 系统中,深度学习算法将大部分这类问题都看作是一个黑盒子,如下图所示:

这个基本的思想是结合认知科学中的双通道理论。在人脑的认知系统中存在两个系统:System 1 和 System 2,如下图所示。System 1 是一个直觉系统,它可以通过人对相关信息的一个直觉匹配寻找答案,它是非常快速、简单的;而 System 2 是一个分析系统,它通过一定的推理、逻辑找到答案。

在去年的 NIPS 上,图灵奖获得者 Bengio 在大会主旨报告的 Keynote 也提到,System 1 到 System 2 的认知是深度学习未来发展的重要的方向,如下图所示:

因此,我们大概用这个思路构建了这个新的、我们称为认知图谱的这样一个方法。在 System 1 中我们主要做知识的扩展,在 System 2 中我们做逻辑推理和决策,如下图所示:

可以看到,我们在 System 1 中做知识的扩展,比如说针对前面的问题,我们首先找到相关的影片,然后用 System 2 来做决策。如果是标准答案,就结束整个推理的过程。如果不是标准答案,而相应的信息又有用,我们就把它作为一个有用信息提供给 System 1,System 1 继续做知识的扩展,System 2 再来做决策,直到最终找到答案。

现在,在这两个系统中,System 1 是一个直觉系统,我们用 BERT 来实现,实现了以后,我们就可以做相关的信息的匹配;System 2 就用一个图卷积网络来实现,在图卷积网络中可以做一定的推理和决策。通过这个思路,我们就可以实现一定的推理+决策。

这是一个总体的思路,要真正实现知识和推理,其实还需要万亿级的常识知识库的支持,如下图所示。也就是说,四五十年前费根鲍姆做过的事情,也许我们现在要重做一遍,但是我们要做到更大规模的常识知识图谱,并且用这样的方法,用这样的常识知识图谱来支撑上面的深度学习的计算,这样才能真正实现未来的 AI。

所以说,这一代人工智能浪潮也许到终点还是没有推理能力,没有可解释能力。而下一波人工智能浪潮的兴起,就是实现具有推理、具有可解释性、具有认知的人工智能,我们认为这是 AI 下一个 10 年要发展、也一定会发展的一个重要方向。

-

AI

+关注

关注

87文章

30998浏览量

269314 -

人工智能

+关注

关注

1791文章

47352浏览量

238779

原文标题:人工智能的下个十年

文章出处:【微信号:melux_net,微信公众号:人工智能大趋势】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

嵌入式和人工智能究竟是什么关系?

【书籍评测活动NO.51】具身智能机器人系统 | 了解AI的下一个浪潮!

未来学家展望 2025 年十大人工智能趋势

《AI for Science:人工智能驱动科学创新》第6章人AI与能源科学读后感

《AI for Science:人工智能驱动科学创新》第一章人工智能驱动的科学创新学习心得

沃达丰与谷歌深化十年战略合作

risc-v在人工智能图像处理应用前景分析

名单公布!【书籍评测活动NO.44】AI for Science:人工智能驱动科学创新

报名开启!深圳(国际)通用人工智能大会将启幕,国内外大咖齐聚话AI

FPGA在人工智能中的应用有哪些?

英伟达2024年GTC人工智能大会看点,黄仁勋发布最炸裂的B200 GPU,讲述人工智能奇迹

《人工智能下一个十年》的主题报告

《人工智能下一个十年》的主题报告

评论