人工智能的某些实例是否可能没有我们想象的那么聪明?

称之为人工智能。

一组计算机研究生报告说,仔细研究被誉为人工研究里程碑的数十种信息检索算法,实际上远没有所谓的革命性。实际上,这些算法中使用的AI通常只是对先前建立的例程的细微调整。

麻省理工学院的研究生研究员戴维斯·布拉洛克(Davis Blalock)表示,在他的团队研究了81种开发神经网络的方法后,该方法通常被认为比以前的研究要好,该团队无法确认实际上是否有任何改进。

布拉钟克说:“有50篇论文被收录,很明显,最新的技术水平还不清楚。”

过去十年来,人工智能技术的进步很大程度上归功于硬件的改进,例如图形处理器,计算机处理单元和照相机,这些技术使复杂搜索项目,面部识别,摄影,语言翻译和语音识别以及突破取得了指数级增长在虚拟现实游戏中越来越精彩的可视化效果中。当然,算法上的改进也有帮助。

但是麻省理工学院的团队说,人工智能算法至少有一些改进是虚幻的。

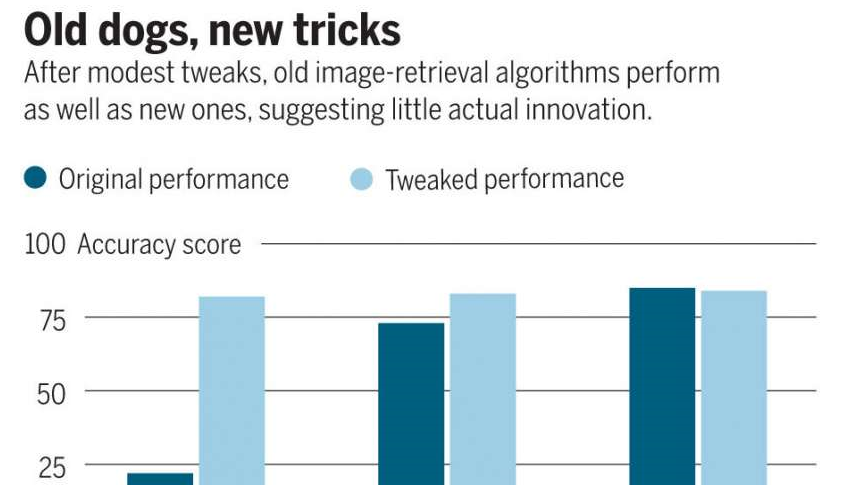

他们发现,例如,通过对长期存在的AI算法进行细微调整,旧程序在本质上可以与高度吹捧的“新改进”程序一起使用。实际上,在某些情况下,发现新的AI模型不如旧方法。

《科学》杂志评估该研究的一篇文章援引了对搜索引擎中使用的信息检索算法的荟萃分析的结果,直到2019年为止,发现“最高分数实际上是在2009年设定的”。流服务使用的神经网络推荐系统的另一项研究确定,所使用的七个过程中的六个未能在几年前设计的简单算法上得到改进。

Blalock指出了用于比较算法的技术上的不一致,从而使声称一种方法比另一种方法更好的准确性尚有待商。。

实际上,据一位麻省理工学院的计算机科学家称,过去十年来,在人工智能的某些领域显然缺乏重大进展,这归咎于无法正确比较和评估竞争方法。Blalock博士John Guttag 顾问说:“这是旧锯,对吗?如果您无法测量某些东西,就很难使其变得更好。”

卡内基·梅隆大学的计算机科学家Zico Kolter推测,给人的名字加上新算法的动机和社会奖励要比仅仅修补和调整已建立的旧方法更为有效。

他研究了图像识别模型,该模型被编程为抵抗黑客所谓的对抗攻击。此类攻击使用巧妙更改的代码来绕过系统安全性。一种称为投影梯度下降(PGD)的早期方法通过训练AI系统来区分真实的和伪造的代码示例来抵御此类攻击。它被认为是一种可靠的方法,但是据说被更新更好的协议所绕过。但是,Kolter的研究人员团队发现,对旧的PGD方法进行简单的调整后,其有效性与新方法几乎没有区别。

“很显然,PGD实际上只是正确的算法,” Kolter说。“这很明显,人们希望找到过于复杂的解决方案。”

-

人工智能

+关注

关注

1793文章

47604浏览量

239526 -

计算机科学

+关注

关注

1文章

144浏览量

11381

发布评论请先 登录

相关推荐

人工智能的某些实例是否可能没有我们想象的那么聪明?

人工智能的某些实例是否可能没有我们想象的那么聪明?

评论