程序员当前解决与人工智能(AI)和自动驾驶汽车(AV)有关的道德问题的方式中存在一个很大的缺陷。也就是说,现有方法无法说明人们可能会尝试使用AV来做一些不好的事情。

例如,假设有一辆无人驾驶的自动驾驶汽车,它即将撞上一辆载有五个人的汽车。它可以通过转出道路来避免碰撞,但随后会撞到行人。

在这种情况下,关于道德的大多数讨论都集中在自动驾驶汽车的AI是自私的(保护车辆及其货物)还是功利的(选择伤害最少的人的行动)。但是,这种或/或道德方法会引发自身的问题。

北卡罗莱纳州立大学科学,技术与社会(STS)计划的助理教授VeljkoDubljević说:“目前的道德和自动驾驶方法过于危险,过于简单,道德判断比这更为复杂。”概述了这个问题以及可能的前进方向。“例如,如果车上的五个人是恐怖分子呢?又如果他们故意利用AI的程序杀死附近的行人或伤害他人呢?那么您可能希望自动驾驶汽车撞上五个人?乘客。

“换句话说,当前用于解决AI和自动驾驶汽车道德问题的简单方法不能说明恶意意图。它应该这样做。”

作为替代方案,Dubljević建议使用所谓的Agent-Deed-Consequence(ADC)模型作为AI可以用来做出道德判断的框架。ADC模型基于三个变量来判断决策的道德性。

首先,代理人的意图是好是坏?第二,行为或行动本身是好是坏?最后,结果或后果是好是坏?这种方法允许细微差别。

例如,大多数人会同意开红灯是不好的。但是,如果您闯红灯以避开急速的救护车怎么办?如果开红灯意味着您避免与那辆救护车相撞怎么办?

Dubljević说:“ ADC模型将使我们更接近人类道德判断中看到的灵活性和稳定性,但AI中尚不存在这种灵活性和稳定性。”“这就是我所说的稳定和灵活。人类的道德判断是稳定的,因为大多数人会同意撒谎在道德上是有害的。但是,这是灵活的,因为大多数人也会同意为保护犹太人而撒谎来纳粹的人在做道德上的事情。好。

“但是,尽管ADC模型为我们提供了一条前进的道路,但仍需要进行更多的研究,”Dubljević说。“我领导了有关哲学家和外行人如何进行道德判断的实验性工作,其结果是有价值的。但是,该工作以书面形式给了人们信息。需要更多的人类道德判断研究,而这需要更直接的交流手段,例如虚拟现实,如果我们想确认我们先前的发现并在自动驾驶汽车中应用它们,那么,在任何公认的“道德”自动驾驶汽车开始与人定期分享道路之前,应进行驾驶模拟研究的严格测试。不幸的是,攻击已变得越来越普遍,我们需要确保不会将AV技术滥用于邪恶目的。”

论文“致力于在自动驾驶汽车中实现道德判断的ADC模型”已发表在《科学与工程伦理学》杂志上。

-

人工智能

+关注

关注

1791文章

46711浏览量

237236 -

自动驾驶

+关注

关注

782文章

13638浏览量

166015

发布评论请先 登录

相关推荐

人工智能的应用领域有自动驾驶吗

自动驾驶技术的典型应用 自动驾驶技术涉及到哪些技术

《AI for Science:人工智能驱动科学创新》第一章人工智能驱动的科学创新学习心得

FPGA在自动驾驶领域有哪些优势?

FPGA在自动驾驶领域有哪些应用?

深度学习在自动驾驶中的关键技术

未来已来,多传感器融合感知是自动驾驶破局的关键

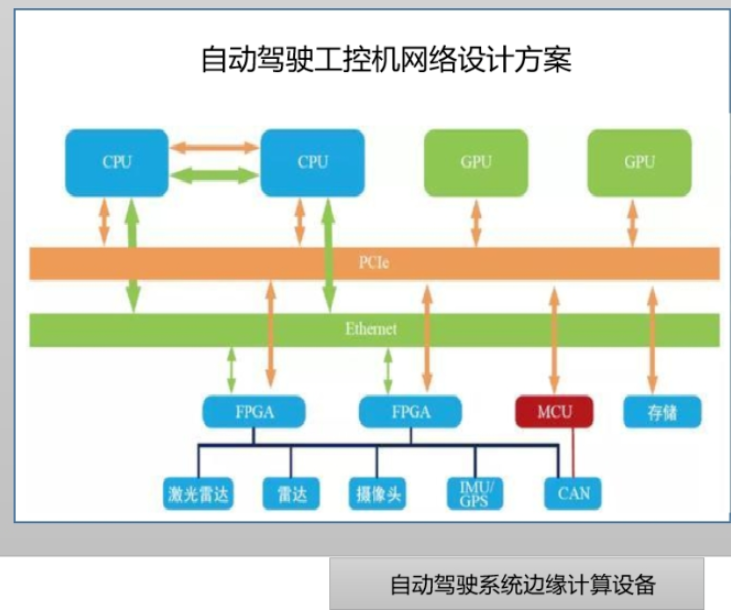

边缘计算与自动驾驶系统如何结合

人工智能和自动驾驶汽车有关的道德问题的方式中存在一个很大的缺陷

人工智能和自动驾驶汽车有关的道德问题的方式中存在一个很大的缺陷

评论