俗语说得好:海水退潮之后,才知道谁没穿裤子。但历史的教训往往证明残酷的事实:结果站在浪里的所有人,全部都没有穿裤子。

处理器业界的年度盛事第32届IEEE HotChips,刚刚在今年8月以全部线上活动型式结束了,连挤4年牙膏的IBM与英特尔总算换了一管全新牙膏,真是可喜可贺。

但另一方面,分别在云端服务和终端硬件执人工智能牛耳的Google与nVidia,却也学到了“挤牙膏”的精髓,前者让2018年就问世的第三代TPU,从2018年Google I/O讲到2020 HotChips,后者在HotChips发表的内容,完全承袭GTC 2000的简报,唯一差别只有把华为Ascend 910人工智能处理器和英特尔支援BF16格式的“新型Xeon”Cooper Lake-P拖出来狠狠打一顿。

总之,我们来瞧瞧HotChips 32 的Google 第三代TPU 与nVidiaA100。

讲了三年总算勉强讲完的Google TPU v3

Google 这家公司最令人称许之处,在于恐怖的“前瞻执行力”,每当众人还在清谈“技术趋势”之际,就突然石破天惊的昭示天下:你们还在嘴炮的东西,我们早就应用到实际产品。诸多丰功伟业的最知名案例,莫过于2013 年底,Google 爆炸性公开“规划部署已达3 年”的B4 数据中心广域网络,开大规模商业化软件定义网络(SDN)之先河。

早在2015年就投入内部应用的Google TPU,更是近年来的经典案例,接着Google也很迅速推陈出新,2017年推出深度学习第二代TPU,第三代TPU更早在2018 Google I/O就亮相了。

但Google 也随即“挤牙膏之神”上身,2019 年HotChips 31 教程仅提到部分资讯,到2020 年才公开细节全貌。

我们都有充分的理由相信,第四甚至第五代TPU,不是早就上线服役也该早在路上了。

2019 年比较对手是nVidia V100,结果2020 年看不到第四代TPU 较量V100,让人感觉有点奇怪。

TPU v3 概观可视为TPU v2 的双倍放大版,散热系统从气冷改为液冷,也是主机板最显眼的特色。

TPU v3 仍旧着重持续提升存储器带宽(+30%)与容量(加倍),拜液冷之赐,时钟频率也有成长(+30%)。

TPU v3 的指令集架构是332 位元长的超长指令集(VLIW),VLIW 指令包内总计有2 个纯量指令、4 个向量指令(其中2 个是存储器载入/回存)、 2 个矩阵(Matrix)指令、6 个立即值(Immediate)与一个杂项(Misc)应用。

强化多芯片互连总线,打造更大规模的“人工智能超级电脑”,更是TPU v3 的重头戏,也就是上图那个“4x Nodes”。

同样一片系统主机板装4 颗TPU,TPU v3 组成的“人工智能超级电脑”,拥有前代8 倍以上效能、8 倍存储器容量、4 倍芯片数量与4 倍的最大装置设定数,可切割成256 个独立运算平台分租给客户。

顺便一提,现今已知关于Google TPU 的专利多达50 份,亦不乏详细描述第三代TPU 的内部架构细节,也是众多有志进军人工智能芯片的冒险者,抽丝剥茧的研究对象。

但这对使用Google Cloud AI 的用户,甚至大多数Google 部门来说,其实并不重要,他们只要用得爽快、不需要“为了喝牛奶自己盖一座牧场”就够了。

靠GPU 基本盘稳扎稳打的nVidia A100

nVidia以通用GPU为基础,站稳高效能运算市场,并将触角逐渐延伸到人工智能和自驾车辆等新兴应用领域,使2020年夏天市值连续超越英特尔和三星,证实外界多么看好“皮衣教主”昭示天下的“美好未来”。无论个人电脑与高效能运算领域,从“电竞笔电非有Max-Q不可”现象到超级电脑Top500清单满满的nVidia GPU,优势地位看似牢不可破。

nVidia 旗舰GPU 也随着制程演进而持续“恐龙化”,Ampere 世代之首A100 是一颗台积电7 纳米制程、540 亿晶体管的巨兽,像更多执行单元、更大存储器子系统带宽、一直更新的DGX 超级电脑等,是各位也都耳熟能详,甚至早就令人哈欠连连的“标准剧情”了。

关于人工智能应用,nVidia A100 最重要的特色,莫过于自行定义的TF32(Tensor Float 32)浮点数格式。讲白了就是“取长补短”,既然Google BF16 牺牲掉FP32 的精度,维持动态范围不变,那就让精度和FP16 一样吧,神奇的19 位元长度TF32就这样诞生了,兼具FP32的动态范围和FP16 的精度。nVidia 之所以这样大费周章创造新格式,根本目的不外乎要降低存储器带宽和容量需求,和Google发明BF16 如出一辙。

理所当然的,TF32 在A100 一定跑得很快,因所需带宽仅为前代V100 一半或三分之一,更能喂饱嗷嗷待哺的庞大Tensor Core。

但这件事的背后,隐隐约约透露nVidia长期领先AMD(ATI)的根本原因与基本思维:存储器带宽,这件事早从2004年NV40(GeForce 6系列)存储器控制器内建压缩传输机能,相关技术持续演进并陆续申请专利,就已埋下了种子。过去十几年来,AMD或ATI的GPU,需要更多存储器带宽,才能实现同等级的效能水准,绝对不是偶然。

大概整批带枪投靠英特尔的前AMD 团队过去吃了不少闷亏,这次替英特尔重新打造Xe 绘图架构时,也很刻意提到“End-To-End Compression”,只是不知道会不会不小心踩到nVidia 的专利地雷。

当GPU 踏入高效能运算和人工智能,“每笔运算可平均分配到的存储器带宽,持续稳定的下滑中”,更让提高运算效能这件事,绝非区区增加几个特化指令与扩张执行单元,即可迎刃而解,更需搞定带宽这件事,一旦带宽不足,就发挥不出完整的运算效能。

听说nVidia 下一代GPU“Hopper”将改弦易辙,改走多芯片Chiplet“包水饺”路线,也许nVidia 在多芯片连结架构部分,将带来让人感到惊奇的技术突破也说不定,让人对明年HotChips 33 多抱持一分期待。

人工智能热潮的消退:先讲求不要饿死再求发展

话说回来,我们就不得不探究一个大哉问:为何越来越多芯片厂商开始“挤牙膏”?要么不是受摩尔第二定律诅咒,产品技术难以短期内飞跃性提升,要么就是讲再多对我也没任何实质好处,还不如少讲一点闷声发大财。

不过这几年,难道人工智能芯片不是很火的话题吗?2017年HotChips 29,不就是从主题演讲到议程,从泛用处理器、GPU、ASIC到FGPA,统统“人工智能满天下”?如此沉默,对公司的未来妥当吗?

很遗憾的,人工智能芯片从2018 年起,以中国相关领域新创公司为首,热潮急速退烧,像中国DEEPHi(深鉴科技)被FPGA 巨头赛灵思收购,已经算是最好的退场。

即使美国企业亦不可免俗,就算公司不会倒,也不保证产品线不会收掉。像这些年来痴迷自驾车和人工智能,耗费数百亿美元“生气乱买公司”的英特尔,2018年宣布中止XeonPhi产品线,决定整个砍掉重练,由2017年底来自AMD的Raja Koduri重建货真价实的GPU。2019年底以20亿美元购并以色列HabanaLabs并在隔年2月停止NNP-T1000(代号Spring Crest,还宣称跟百度合作),也意味着2016年用3.5亿美元买下的Nervana形同弃儿,英特尔人工智能平台事业群负责人、Nervana联合创办人Naveen Rao随即离职,一点都不让人意外。

英特尔连续公开栽了两次(实际上应该更多),事后诸葛的后见之明与背后补刀的内幕爆料,均朝向“做出来的东西根本不能用,也无法符合软件开发者和潜在客户的需求”。

所以这也是当人工智能渐渐在HotChips 退烧后,为何Google 和nVidia 可站在台上活好好的主因:Google 很清楚自身需要,快速演进三代(应该更多)的TPU 就是为了自家Google Cloud AI 和其他服务量身订做(苹果塞在自己芯片内的NPU 也是一样状况)。nVidia 则是拥有庞大GPU 市占率、累积十多年的CUDA 与高效能运算的“基本盘”足以先养活自己,日后再慢慢发展。

反观之前那票一窝蜂狂冲“人工智能新大陆”的勇者,又有几家有本钱和能耐,先不求饿死,再讲求和客户携手并进的共同胜利?讲更白一点,你会相信中国那些开发数字货币挖矿芯片的厂商,被迫转型做出来的人工智能芯片,可以迅速得到指标性客户的青睐?

天下任何一家求生存的企业,无不企求有所谓的“现金母牛”和忠实客户,才为稳定营运的基础。我们可以猜猜看,明年HotChips 33 还剩下哪些幸存者?

责任编辑:tzh

-

处理器

+关注

关注

68文章

19461浏览量

231438 -

芯片

+关注

关注

457文章

51363浏览量

428371 -

英特尔

+关注

关注

61文章

10030浏览量

172508 -

人工智能

+关注

关注

1797文章

47890浏览量

240908

发布评论请先 登录

相关推荐

端侧 AI 音频处理器:集成音频处理与 AI 计算能力的创新芯片

预测2029年全球处理器市场将达4800亿美元

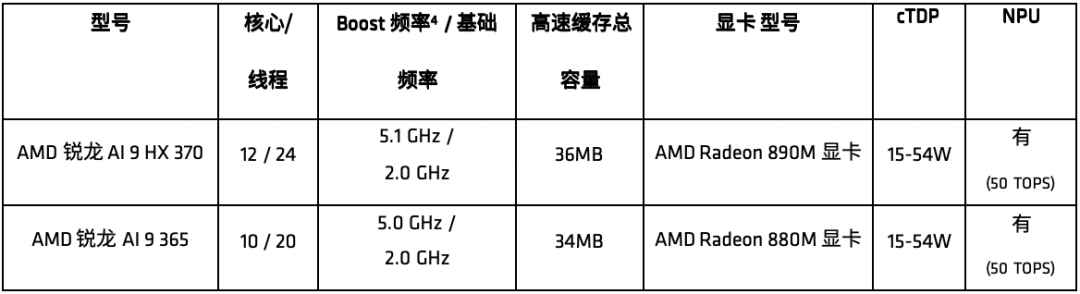

AMD推出全新锐龙AI 300系列处理器

微处理器在人工智能方面的应用

爱芯元智发布“爱芯通元AI处理器”

处理器的定义和种类

英特尔酷睿Ultra处理器突破500个AI模型优化

AMD推AI PC新处理器,挑战英伟达与英特尔领先地位

AI处理器热潮正在退去

AI处理器热潮正在退去

评论