近年来,机器人各个方面的能力都在快速追赶人类,甚至在某些领域已经超过人类。在这一过程中,科学家和工程师们最喜欢在机器人身上打造出类似人类的感官模式,以更好地感知世界。

不过现阶段的很多技术都只专注于再现人类的视觉和触觉,比如炙手可热的计算机视觉技术。相比之下,复制人类其他感官的研究却没有太多进展。

卡内基梅隆大学(CMU)的研究小组近日发表一项新成果——探索如何利用声音开发感知功能更先进的机器人。

他们将机器人命名为 Tilt-Bot,字面意思是 “倾斜机器人”,实际上它是一台通过倾斜托盘研究物体运动和声音之间关系的机器,训练后可以实现一定程度的 “听音识物”,准确率接近 80%。研究成果以论文的形式发表在《机器人学:科学与系统》 Robotics: Science and Systems 上。

图 | 倾斜机器人(来源:Gandhi, Gupta & Pinto.)

听觉与视觉、触觉一样,都是人类收集信息的重要渠道。那么听觉可以为机器人带来什么呢?在回答这个问题之前,我们可以想象一下没有声音的世界。

在这种情况下,我们将极度依赖视觉系统收集信息。看视频必须有字幕,与别人沟通必须用文字和手势,永远不知道背后是不是走过来一个人,除非转过头去看。

即使眼睛和手可以代劳,很多关键信息也无法准确传达,比如语气、声调以及这些变量背后的潜台词和深意。

机器人也面临着相似的苦恼:感知物理世界的渠道太过单一,依赖性过强,因此无法有效利用普遍存在的信息。如果能有效收集声音数据,再配合上视觉信息,它们对环境的感知力将大幅提升。

CMU 团队以此为核心思想,设计出了 Tilt-Bot 机器人。它本质上是一台托盘机器人,由拥有多个关节的机械臂、托盘和固定装置组成,托盘四周有边框,上面贴着用于记录物体撞击的声波捕捉装置。

托盘的正上方还固定了一个摄像头,用于捕捉物体运动轨迹,后期再与声音变化相匹配。

图 | 运动中的物体和声音数据(来源:Gandhi, Gupta & Pinto.)

实验时,研究人员会把不同的物体放到托盘中,机械臂随后开始向前后左右倾斜,托盘中的物体也随之移动。

如果倾斜过大,物体就会撞到边框并发出响声,撞击力度越大,捕捉到的声波波峰也就越高。

团队总共收集了 60 个不同物体的 1.5 万次交互记录,每组记录都包含匹配的视频和音频数据。他们用这些数据创建了全新的图像 + 音频数据集,用于训练机器人在动作、图像和声音之间建立有意义的联系。

一个有趣的发现是,受过训练的机器人只需要分析物体滑动和撞击的声音记录,就可以区分不同物体。

即使同是金属质地的螺丝刀和扳手也可以成功分辨,总体成功率接近 80%。这意味着训练机器人学习物体的音频表示形式是有意义的。

另一个更有价值的发现是,音频有时比视觉提供的有价值信息更多,或者说适用面更广。

由于声音是以声波的形式传播的,其传播轨迹更直观,可以更有效地预测物体未来的运动轨迹,从而帮助机器人更好地控制物体。

用从未见过的物体测试机器人性能时,如果同时使用视频和音频数据,那么它预测如何更好操控物体的表现相较于只使用视频时提升了 24%。

包含音频和视频的数据集可以帮助更多人开发机器人,尤其当它们被派去执行的任务需要两者兼顾时。研究团队表示现在的成果只是第一步,未来将探索声音数据分析还能挖掘出机器人的哪些潜力,进一步提高它们的感知能力,并且将其运用到更实际的任务中。

“这些初步研究成果是令人兴奋的,证明了机器仅凭声音就能识别出物体类型,” 研究人员莱雷尔·平托(Lerrel Pinto)表示,“这样一来,机器人执行任务的时候就可以更有针对性,比如学会区别对待空酒杯和满酒杯。”

原文标题:CMU 发明“听音识物”机器人,准确率接近 80%

-

机器人

+关注

关注

210文章

28252浏览量

206709

原文标题:CMU 发明“听音识物”机器人,准确率接近 80%

文章出处:【微信号:deeptechchina,微信公众号:deeptechchina】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

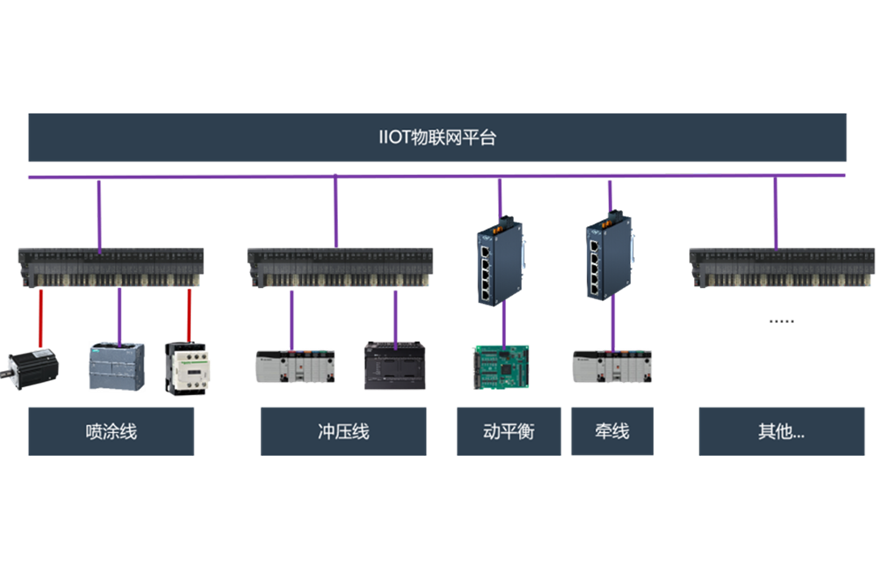

软硬互联——革新机器人非标产线智能制造

微机保护装置预警功能的准确率

优傲机器人升级高负载协作机器人,助力客户生产效率飞跃

ai人工智能回答准确率高吗

NVIDIA在ICRA展示最新机器人研究

NIUSB6009 采集准确率的问题?

开源项目!用ESP32做一个可爱的无用机器人

开源项目!用ESP32做一个可爱的无用机器人

Al大模型机器人

基于FPGA EtherCAT的六自由度机器人视觉伺服控制设计

大象机器人完成Pre-B轮融资,致力打造全新机器人生态!

其利天下技术·搭载无刷电机的扫地机器人的前景如何?

一款基于物联网技术的光热电站机器人解决方案

CMU发表一项新机器人 听音识物准确率接近 80%

CMU发表一项新机器人 听音识物准确率接近 80%

评论