采访讲师|庄泽森

声网Agora架构师,毕业于复旦大学电子工程系,专业方向是信号处理和估计理论,毕业后一直从事音视频相关算法研究和优化。2014年加入声网后,专注于实时音视频方案的架构和实时网络加速相关技术的研究,对拥塞控制算法、丢包对抗技术、FEC、jitter buffer等算法等都有相关经验,多年来和团队一起研发了声网一系列关键产品,包括音频引擎、通信视频引擎、直播SDK、多人视频等等。

以下内容由LiveVideoStack与庄泽森的采访整理而成

您目前的工作以及近期关注的技术和产品?

庄泽森:目前在声网专注于传输和网络相关算法的研究,同时,作为架构师参与声网产品和服务核心质量的技术改进。

所以,对与网络相关算法和技术有关的、旨在提升音视频体验的传输和媒体技术以及机器学习和深度学习应用于音视频场景和网络的技术,都比较关注。

您加入声网的六年间对音视频服务&技术有了哪些新的理解;在您眼中,声网在这期间又历经了怎样的发展和变化?

庄泽森:深刻体会到做好实时音视频服务的不易。实际网络和端设备的复杂性与多样性,对实现不卡、不糊和低延迟的音视频体验有着极大的挑战;另一方面,越来越多的实时音视频需求,需要我们的服务支持高并发,具备高可用性和高可扩展性。这都要求我们在技术上从算法、架构到工程不断迭代,勇攀高度,做到极致。

需要强调的是,相关的配套设施和服务产品也需要跟上,如质量监控和透明,以及客户支持等等。

这些年,声网团队规模一步步从小到大发展起来,声网的产品不断推出,产品线越来越全,业务也从一开始的无人问津到现在的每天亿级分钟数。这一切进步的背后,不变的是团队对技术能力技术高度的追求、对音视频技术和对实际网络的不断探索。

目前为止您所参与的最难忘的项目是什么,可以与LiveVideoStack的读者分享其中的一两个小故事吗

庄泽森:在声网的这些年有太多难忘的经历了,这里就说说刚加入声网时的情况吧。

那时我的第一个项目就是独立负责音频网络jitter buffer优化,这也是当时音频引擎研发中的难点之一。

团队对引擎的网络自适应能力要求很高,而我也发现实际网络jitter情况比想象中复杂得多,各种网络类型和各种网络条件,包括设备和服务器的处理瓶颈等等,都会最终表现为不同的jitter。如何做到在这些pattern下有流畅的音频体验,同时做到延时较低,这些都很有挑战性;而另一方面,那时我刚从稳定的外企来到创业团队,一切都是新鲜的也是让人忐忑的,能否快速适应更高效更快速的工作节奏和氛围,我心里也是没有底的。

针对这些情况,我的做法还是摆正心态,积极融入团队,并把注意力转移到技术上,快速学习相关技术文献和paper,同时进行实际网络pattern的抓取和分析。记得当时还写了一些脚本,对抓取的数据进行分析和可视化展示,进行算法仿真,并最终代码实现,这样才把第一个项目比较完美地交付了。

在您的技术进阶之路上,给您启发最大的是什么?

庄泽森:多年来一直从事技术工作,可以说有不少人都给了我很大的帮助和引导,比如声网的资深技术顾问钱世锷老师,他也是我上一家公司的导师;再比如现在声网的首席科学家钟声老师,大家都是相关领域的专家和学者,在技术上和职业发展上给了我不少引导,他们对学术的追求和求真的态度也对我影响很大。这里边儿还包括我们的CEOTony,他对技术的热忱和敏感判断,以及做事的方法,都给了我很多帮助和启示。

您现阶段正在解决的问题以及您下一阶段的研发目标?

庄泽森:现阶段主要在做下一代网络自适应的传输和媒体算法研发,在复杂的网络和应用场景下希望可以给出更鲁棒更极致的方案,进一步提升音视频体验,应对由于疫情和5G带来的在全世界范围井喷的音视频需求。

音视频服务做到“实时”并不容易,能请老师与大家分享您对构建实时音视频方案架构的相关经验,以及您对于技术意义上的“实时”的理解?

庄泽森:提到实时音视频,也许很多人都会想到低延时,而我想强调的是不要单看延时,除了“低延时”,还有“体验三角形”、“场景”这几个关键词。

音视频体验包括延时、流畅度和清晰度,我称之“体验三角形”。音视频方案如果只优化单一指标,事情会相对简单。举个例子,假如只看延时,我们可以在各种网络条件下尽量降低视频码率,整个传输和媒体方案可以做得很“敏感”,达到相对低的延时。但这样就牺牲了清晰度,最终体验可能也无法满足要求。

所以,实时音视频是在低延时语境下延时、流畅度和清晰度三者的综合体验结果,用现在流行的话说,就是“既要,又要,还要”的表述了。

另一方面,其实不同的业务对“体验三角形”里三方的要求也不一样,这就是“场景”的不同带来要求也不同。比如直播场景,延时的要求可能降低,而对清晰度和流畅度则要求很高;通信场景则对延时和流畅度的要求很高,清晰度相对就排在后面了。实时音视频也可以说是满足场景要求的实时音视频。

所以,实时音视频方案的基础,是需要一个在各种网络条件下鲁棒和高效的传输栈,传输延时和throughput两个指标综合评估能做到最佳结果,同时有根据业务需求向某个体验指标偏倚的能力,即可以方便地场景化;另一方面,在传输栈之上,需要一个具备网络适应和对抗能力的媒体层,如自适应网络的编码器,以及优化的媒体jitter buffer等等。

您觉得实时音视频场景下目前挑战较大的技术难点有哪些,声网的解决思路是什么?

庄泽森:实时音视频场景下从算法、架构到工程,各个方面都有不少难点和挑战。如果挑其中较大的难点来说,可能主要在两个地方:一个是随着疫情的出现和5G技术的发展,音视频服务的体量极大飙升,如何能撑得起这个体量,做到支持高并发,达到高可用和高可扩展;另一个就是如何在各种网络状况和资源条件下,始终提供极致的实时音视频体验。

对于第一个难点,声网团队在架构设计、资源储备和工程实现方面下足了功夫,迭代演进过程中也一直牢记着这些要求。甚至为了保证服务,我们会瞄准比计划的目标负荷更大的负荷;对于第二个难点,声网在算法和版本上快速迭代,对整个音视频pipeline、各个层级、各个模块先定义好边界,然后分别对具体模块具体算法不断探索,快速落地,进而迭代。

为什么您选择在这次LiveVideoStackCon中重点讲网络传输中的拥塞控制算法?

庄泽森:拥塞控制和带宽估计是网络传输里非常关键的部分,算法的设计将大大影响整个传输栈的性能和效率,进而影响上层业务的体验和结果。而复杂多样的网络条件、各个地区网络运营的不同以及应用场景的不同又对算法提出了不同的需求,如何有一个鲁棒的算法设计,确实很有挑战,而能否做到,将最终决定服务的好坏。

人工智能、深度学习在拥塞控制算法中的应用处于什么什么状态,以及未来的展望?

庄泽森:深度学习和机器学习的应用确实是当前拥塞控制算法研究的方向之一,也是热点。可以说,这个方向甚至可能是一把钥匙——最终完美解决目前该领域所有问题的钥匙。

不过,该方向的算法目前实际落地的很少,一些学术界的成果在实际网络或者更复杂的弱网环境下测试效果并不令人完全满意。这里面的原因有多方面,其中之一是实际网络数据及数据标定难以获得,特别是能涵盖所有网络状况和网络类型的数据。

后疫情时代的视频会议服务发生了哪些变化,对相关技术、算法优化提出了哪些新的要求?

庄泽森:关于疫情时代对音视频服务和行业的影响,相信已经有不少文章做过详细论述了,我就简单讲下个人的看法。

教育、办公、社交、娱乐等领域,都在往线上转移,或者说线上线下结合。其实这本来就是一种趋势,但疫情又在一定程度上加速了这种趋势,使得这些在短期内有了一个跳变。加上各种线上产品形态的迸发,又进一步带来了实时音视频服务需求的短期飙升。

其实不止线上办公、线上教育等领域,这次疫情的特殊性还在于,它让大家意识到,把业务搬到线上,可能是绕不开的一个工作,是保障业务对抗未知的“安全”战略。可以预计,更多的领域更多的玩法,都会有线上的形态,而实时音视频服务的需求和体量也许会比我们估计的更大。

一方面线上音视频体量飙升,另一方面,像线上教育线上办公这些应用场景,对实时音视频体验和质量的要求也更高了。同时,随着服务的客户和业务增多,也将碰到更多的场景,更多的网络状况和更多的国家地区以及更多的设备等等。

所以相应的,首先我们要“撑得起”现在的音视频体量,从架构和资源等方面要支持高并发,达到高可用性和高可扩展性。甚至为了保证服务,架构设计和资源储备时还要向前一步,把更大的体量支持考虑进去。

另一方面,从媒体层到传输层,算法能力也需要更上一层,以应对更多的网络状况、设备状况和场景,以保持鲁棒性,提供稳定的极致体验。举个例子,网络优化要考虑不同地区的差异,考虑到音视频用量激增后在传输中可能遇到更多的资源和网络瓶颈等等。

原文标题:实时音视频服务的“既要、又要、还要”

文章出处:【微信公众号:LiveVideoStack】欢迎添加关注!文章转载请注明出处。

责任编辑:haq

-

音频

+关注

关注

29文章

2870浏览量

81507 -

人工智能

+关注

关注

1791文章

47229浏览量

238326 -

机器学习

+关注

关注

66文章

8411浏览量

132594 -

深度学习

+关注

关注

73文章

5502浏览量

121124

原文标题:实时音视频服务的“既要、又要、还要”

文章出处:【微信号:livevideostack,微信公众号:LiveVideoStack】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

华为在UBBF 2024对话瑞士电信

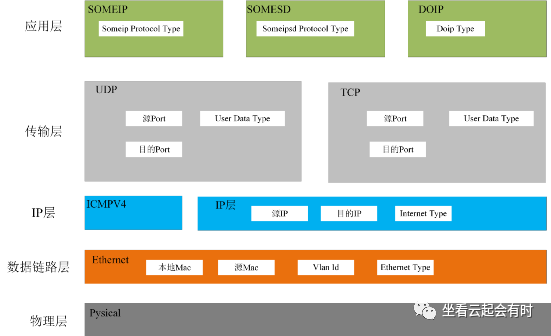

车载以太网的整体架构解析

一位架构师的自述:在尚未踏入的世界成为你自己

授权代理商贸泽电子为工程师提供AMD的全新AI和边缘技术

罗森伯格H-MTD连接器助力汽车制造商设计并实现区域架构

工业、新能源、AI成为厂商布局重点,2024慕尼黑上海电子展采访集锦

中级自动驾驶架构师应该学习哪些知识

初级自动驾驶架构师应该学习哪些知识

贸泽新一期EIT系列带你了解软件定义车辆的Zonal架构

戴森新款吹风机HD16发布对国内厂商的启示

OPPO与哲库科技解散团队,全力研发自研芯片底层架构

华庄科技创业板IPO迎新进展!第一大客户比亚迪,募资4.5亿建设生产基地等

贸泽电子田吉平:新能源汽车渗透率上升利好元器件需求 一站式供应链加速新品上市

车载以太网静态架构介绍

LiveVideoStack采访声网Agora架构师庄泽森

LiveVideoStack采访声网Agora架构师庄泽森

评论