这个教程将带你使用自己的手机摄像头和图片实现从零开始到点云。

这是一个由3部分组成的系列文章。 我注意到,其他大多数关于三维重建的教程都在某种程度上有点欠缺。别误会,我认为它们是十分优秀的成果,但是在某种程度上它们是支离破碎的,或者它们当中有一部分过于深入地研究理论,或者两者兼而有之。 更糟糕的是,他们使用专门的数据集(如Tsukuba),这就会造成对一些数据集之外的任何东西在使用这种算法时,因为参数调微调会产生一些麻烦。 我相信三维重建(广义的计算机视觉)最酷的事情是重建你周围的世界,而不是别人的世界(比如数据集中的世界)。本教程是一个初步的尝试,旨在帮助您使用OpenCV的强大功能重新创建自己的世界。 简单地说,这个教程将带你使用自己的手机摄像头和图片实现从零开始到点云。所以,废话不多说,让我们开始吧。 注意 为了避免写一篇非常长的文章,本教程分为三个部分。 第1部分(理论和需求):概述了一个非常简单的立体三维重建所需要的步骤。 第2部分(相机校正):包括用代码校正你相机的基础设置/知识。 第3部分(视差图和点云):介绍了重建图片基础知识利用前面用代码标定过的相机。 三维重建所需的步骤 有很多方法可以重建周围的世界,但都可以归结为需要得到一张准确的深度图。 深度图中的每一个像素都表示的是深度信息(而不是颜色信息)。它一般都是用灰度图的形式展现出来。

Tsukuba 数据集的深度图。由OpenCV提供 如前所述,获取一张深度图有很多不同的方法,而这些方法都取决于所使用的传感器。一种传感器可以是一个简单的摄像机(从现在起在我们将称为RGB摄像机),但也可以使用其他传感器,如激光雷达或红外线或两者的组合。 传感器的类型将决定深度图的精准程度。根据精确度从大到小排列依次是激光雷达>红外线>相机。深度图也可以着色以更好的显示深度。

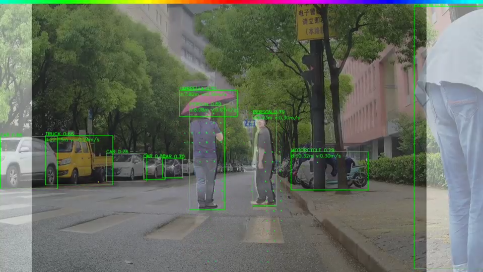

我的Kinect相机自拍图 根据所用传感器的类型,实际获取深度图需要的步骤或多或少。例如,Kinect相机使用结合了RGB相机和红外传感器,因此您可以立即获得一张深度图(因为它是由红外传感器处理的信息)。 但是,如果您除了手机摄像头之外什么都没有,该怎么办?在这种情况下,您需要进行立体重建。立体重建和使用您的大脑和眼睛用来实际理解深度的原理是一样的。 其要点在于从两个不同的角度看同一张图片,并在两张图片中寻找相同的事物,并从位置的差异推断出深度。这称为立体匹配。 为了进行立体匹配,重要的是使两张图片具有完全相同的特征。换一种说法,两张照片都不应该有任何失真。这是一个问题,因为大多数相机的镜头会导致不同程度的畸变。这意味着为了精确地进行立体匹配,需要知道相机的光学中心和焦距。 在大多数情况下,这些信息是未知的(尤其是对于您的手机摄像头),这就是为什么立体3D重建需要以下步骤的主要原因: 1. 相机校正:使用一组图像推断相机的焦距和光学中心 2. 图像畸变:去除重建要用到的图像中的镜头畸变 3. 特征匹配:在两张图片之间寻找相似的特征并构建深度图 4. 重投影点:使用深度映射将像素重投影到三维空间中。 5. 构建点云:生成一个包含三维空间中的点的新文件以进行可视化。 6. 构建网格以获得实际的三维模型(不在本教程的范围内,但很快将在其他教程中提供) 步骤1只需执行一次,除非更换摄像机。而每次你获得一对新照片时,都需要重新执行一遍第2-5步……大概就是这样子。 实际的数学理论(为什么)要复杂得多,但是在本教程之后,它将更容易处理和理解,因为你将在阅读完本文之后获取一个实例,你可以进行各种的实验。 在下一部分中,我们将探讨如何实际校准手机摄像头,以及一些校准的最佳实践操作。

责任编辑:lq

-

iPhone

+关注

关注

28文章

13443浏览量

201363 -

三维

+关注

关注

1文章

492浏览量

28923 -

OpenCV

+关注

关注

29文章

625浏览量

41223

原文标题:使用iPhone相机和OpenCV来完成3D重建(第一部分)

文章出处:【微信号:livevideostack,微信公众号:LiveVideoStack】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

基于FPGA的摄像头心率检测装置设计

使用esp-iot-solution master分支的usb_stream摄像头颜色不对是怎么回事?

如何运用无人机摄像头改装成监控

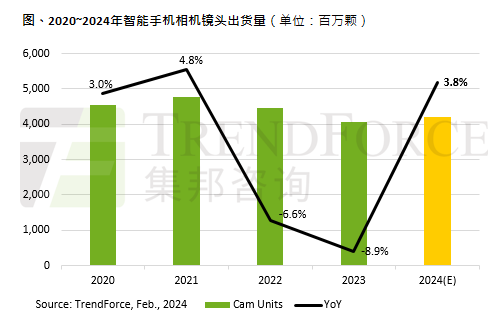

2024年全球智能手机摄像头出货量将增长3.8%

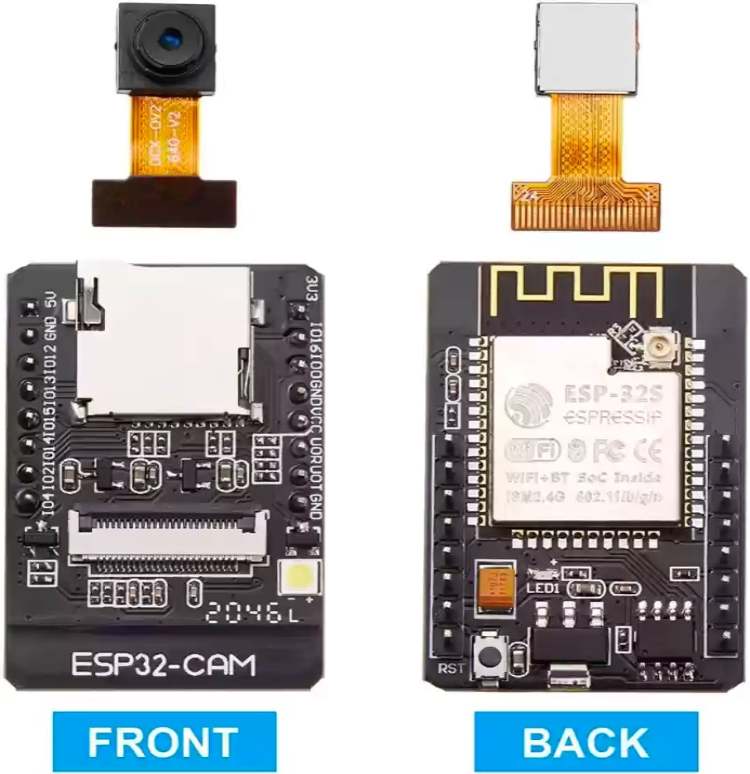

如何使用ESP32摄像头模块构建简单的CCTV安全摄像头

使用自己的手机摄像头和图片实现从零开始到点云

使用自己的手机摄像头和图片实现从零开始到点云

评论