十年前,AWS(Amazon Web Services)发布了首个采用 NVIDIA M2050 GPU 的实例。当时,基于 CUDA 的应用主要专注于加速科学模拟,AI 和深度学习还遥遥无期。

自那时起,AW 就不断扩充云端 GPU 实例阵容,包括 K80(p2)、K520(g3)、M60(g4)、V100(p3 / p3dn)和 T4(g4)。

现在,已全面上市的全新 AWS P4d 实例采用最新 NVIDIA A100 Tensor Core GPU,开启了加速计算的下一个十年。

全新的 P4d 实例,为机器学习训练和高性能计算应用提供 AWS 上性能与成本效益最高的 GPU 平台。与默认的 FP32 精度相比,全新实例将 FP16 机器学习模型的训练时间减少多达 3 倍,将 TF32 机器学习模型的训练的时间减少多达 6 倍。

这些实例还提供出色的推理性能。NVIDIA A100 GPU 在最近的 MLPerf Inference 基准测试中一骑绝尘,实现了比 CPU 快 237 倍的性能。

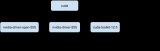

每个 P4d 实例均内置八个 NVIDIA A100 GPU,通过 AWS UltraClusters,客户可以利用 AWS 的 Elastic Fabric Adapter(EFA)和 Amazon FSx 提供的可扩展高性能存储,按需、可扩展地同时访问多达 4,000 多个 GPU。P4d 提供 400Gbps 网络,通过使用 NVLink、NVSwitch、NCCL 和 GPUDirect RDMA 等 NVIDIA 技术,进一步加速深度学习训练的工作负载。EFA 上的 NVIDIA GPUDirect RDMA 在服务器之间可通过 GPU 传输数据,无需通过 CPU 和系统内存,从而确保网络的低延迟。

此外,许多 AWS 服务都支持 P4d 实例,包括 Amazon Elastic Container Services、Amazon Elastic Kubernetes Service、AWS ParallelCluster 和 Amazon SageMaker。P4d 还可使用所有 NGC 提供的经过优化的容器化软件,包括 HPC 应用、AI 框架、预训练模型、Helm 图表以及 TensorRT 和 Triton Inference Server 等推理软件。

目前,P4d 实例已在美国东部和西部上市,并将很快扩展到其他地区。用户可以通过按需实例(On-Demand)、Savings Plans、预留实例(Reserved Instances)或竞价型实例(Spot Instances)几种不同的方式进行购买。

GPU 云计算发展最初的十年,已为市场带来超过 100 exaflops 的 AI 计算。随着基于 NVIDIA A100 GPU 的 Amazon EC2 P4d 实例的问世,GPU 云计算的下一个十年将迎来一个美好的开端。

NVIDIA 和 AWS 不断帮助各种应用突破 AI 的界限,以便了解客户将如何运用 AI 强大的性能。

编辑:hfy

-

NVIDIA

+关注

关注

14文章

5026浏览量

103270 -

gpu

+关注

关注

28文章

4754浏览量

129080 -

AI

+关注

关注

87文章

31158浏览量

269505 -

机器学习

+关注

关注

66文章

8428浏览量

132778 -

AWS

+关注

关注

0文章

432浏览量

24410

发布评论请先 登录

相关推荐

《CST Studio Suite 2024 GPU加速计算指南》

GPU云服务器租用多少钱

AMD与NVIDIA GPU优缺点

亚马逊云科技宣布Amazon EC2 P5e实例正式可用 由英伟达H200 GPU提供支持

GPU云服务器架构解析及应用优势

NVIDIA全面转向开源GPU内核模块

首个采用NVIDIA M2050 GPU的实例 开启GPU云计算下个十年

首个采用NVIDIA M2050 GPU的实例 开启GPU云计算下个十年

评论