根据英伟达官方的消息,在 AWS 运行 NVIDIA GPU 十周年之际,AWS 发布了采用全新 A100 的 Amazon EC2 P4d 实例。

IT之家了解到,现在已全面上市的全新 AWS P4d 实例采用最新 NVIDIA A100 Tensor Core GPU。A100 计算卡采用了 7nm 工艺的 GA100 GPU,这款 GPU 拥有 6912 CUDA 核心和 432 张量核心。GPU 封装尺寸为 826mm2,集成了 540 亿个晶体管。

英伟达表示,全新的 P4d 实例,为机器学习训练和高性能计算应用提供 AWS 上性能与成本效益最高的 GPU 平台。与默认的 FP32 精度相比,全新实例将 FP16 机器学习模型的训练时间减少多达 3 倍,将 TF32 机器学习模型的训练的时间减少多达 6 倍。

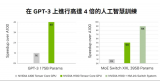

这些实例还提供出色的推理性能。NVIDIA A100 GPU 在最近的 MLPerf Inference 基准测试中一骑绝尘,实现了比 CPU 快 237 倍的性能。

每个 P4d 实例均内置八个 NVIDIA A100 GPU,通过 AWS UltraClusters,客户可以利用 AWS 的 Elastic Fabric Adapter(EFA)和 Amazon FSx 提供的可扩展高性能存储,按需、可扩展地同时访问多达 4,000 多个 GPU。P4d 提供 400Gbps 网络,通过使用 NVLink、NVSwitch、NCCL 和 GPUDirect RDMA 等 NVIDIA 技术,进一步加速深度学习训练的工作负载。EFA 上的 NVIDIA GPUDirect RDMA 在服务器之间可通过 GPU 传输数据,无需通过 CPU 和系统内存,从而确保网络的低延迟。

责任编辑:PSY

-

cpu

+关注

关注

68文章

10869浏览量

211869 -

gpu

+关注

关注

28文章

4742浏览量

128966 -

机器学习

+关注

关注

66文章

8420浏览量

132680 -

英伟达

+关注

关注

22文章

3778浏览量

91146 -

A100

+关注

关注

0文章

27浏览量

7794

发布评论请先 登录

相关推荐

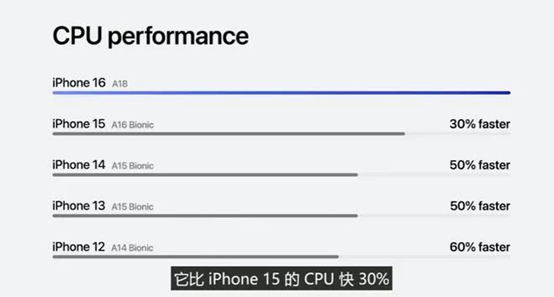

苹果 A18 芯片发布:CPU 提升 30%、GPU 提升 40%

开箱即用,AISBench测试展示英特尔至强处理器的卓越推理性能

英伟达 A100 GPU 全面上市,推理性能比 CPU 快 237 倍

英伟达 A100 GPU 全面上市,推理性能比 CPU 快 237 倍

评论