在发布A100 80GB加速卡之后,NVIDIA也更新了自家的DGX A100产品线,最多可达640GB HBM2e显存了。此外,还有全新的DGX Station A100工作站,配备了4个A100 80GB显存,还上了压缩机制冷。

上半年发布A100加速卡之后,NVIDIA推出了基于A100的DGX A100,这算是个mini超算了,最多可配备8路A100加速卡,而现在的DGX A100 640GB系统是它的升级版,显存容量可达640GB HBM2e。

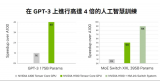

升级之后的DGX A100 640超算性能提升也跟A100 80GB加速卡一样,AI大模型训练中提升最为明显,性能增加了200%,其他应用中性能提升25%到100%不等。

DGX A100 640GB超算的价格没公布,会提供给之前的客户升级选择。

还有一款新品是DGX Station A100,是A100家族中首款、也是唯一一款面向工作站的机器,配备了4块A100 80GB加速卡,320GB HBM2e显存,支持NVLink 3.0,带宽超过200GB/s。

其他方面,DGX Station A100使用的还是AMD的64核EPYC处理器,支持PCIe 4.0,内存可达512GB,1.92TB NVMe系统盘,M.2规格,数据盘最多可达7.68TB,U.2规格。

网络方面,DGX Station A100支持2个10Gbe万兆网卡,还支持4个mini DP输出4K,同时还有1个1Gbe千兆网卡用于远程管理。

当然,DGX Station A100最重要的升级是散热系统,之前的DGX使用的是水冷而已,这次DGX Station A100上了压缩机制冷,可以更好地控制温度,噪音也会降低,毕竟工作站跟DGX A100超算的使用环境不同,噪音还是有点影响的。

DGX A100 640GB、DGX Station A100的价格都没公布,不过现在已经量产上市了,并且已经用于部分超算,比如英国的Cambridge-1就用50台DGX A100 640GB超算,其他商业性销售要到明年1月份,2月份会扩大规模。

责任编辑:pj

-

处理器

+关注

关注

68文章

19138浏览量

228989 -

数据

+关注

关注

8文章

6854浏览量

88778 -

NVIDIA

+关注

关注

14文章

4863浏览量

102760

发布评论请先 登录

相关推荐

创业公司转向RTX 4090因NVIDIA中国特供芯片价格高昂

先导中心推出1200V 100A三电平全碳化硅模块新品

Dynamic Load Tool 100 A 评估板数据手册

NVIDIA推出搭载GB200 Grace Blackwell超级芯片的NVIDIA DGX SuperPOD™

大模型训练:为何A100更胜4090一筹?

解读六大科技巨头自研AI芯片进展,谁将领跑未来?

NVIDIA特供中国的芯片,AI性能大降10%售价依然高

2024年,GPU能降价吗?

英伟达和华为/海思主流GPU型号性能参考

英伟达vs.华为/海思:GPU性能一览

NVIDIA推出了基于A100的DGX A100

NVIDIA推出了基于A100的DGX A100

评论