当临床医生将AI应用于女性患者时,主要接受男性X射线训练的AI将表现不佳。如果患者皮肤黝黑并且大多数训练图像来自皮肤白皙的患者,则用于皮肤病学照片诊断皮肤癌的算法将使这项工作陷入困境。等等。这种偏见的例子在医疗保健AI的装甲中积蓄了不可忽视的缺点。

当然,即使可行,也很难从各种各样的患者群体中收集适合AI的培训数据。但是,如果医疗保健中的AI无法帮助某些最脆弱的患者人群,那么它如何帮助改善美国在人口水平上的健康的事业呢?

11月17日发表在《科学美国人》上的一篇观点文章中,三位斯坦福大学的医学博士/博士对该主题提出了最好的想法。

“人工智能的偏见是一个复杂的问题;仅提供各种培训数据并不能保证消除偏见。” Kaushal,Altman和Langlotz写道。“还提出了其他一些问题,例如,人工智能工具的开发商和出资者之间缺乏多样性;从多数群体的角度看待问题的框架;关于数据的隐含偏见假设;以及使用AI工具的输出来无意或无意地使偏差永久化。”

他们指出,研究人员正在尝试通过构建可从有限输入中推断出广泛输出的算法来解决数据不一致的问题。

作者写道:“通过这些创新,可能会出现减少AI对海量数据集需求的新方法。”“但是目前,确保用于训练算法的数据的多样性对于我们理解和缓解AI偏差的能力至关重要。”

为此,他们呼吁建立所需的技术,法规,经济和隐私基础架构,以收集不仅大而且足够多样化的数据,以培训医学AI,使世界各地的所有患者受益。

责任编辑:lq

-

医疗保健

+关注

关注

4文章

314浏览量

30699 -

AI

+关注

关注

87文章

30315浏览量

268570 -

人工智能

+关注

关注

1791文章

46927浏览量

237783

发布评论请先 登录

相关推荐

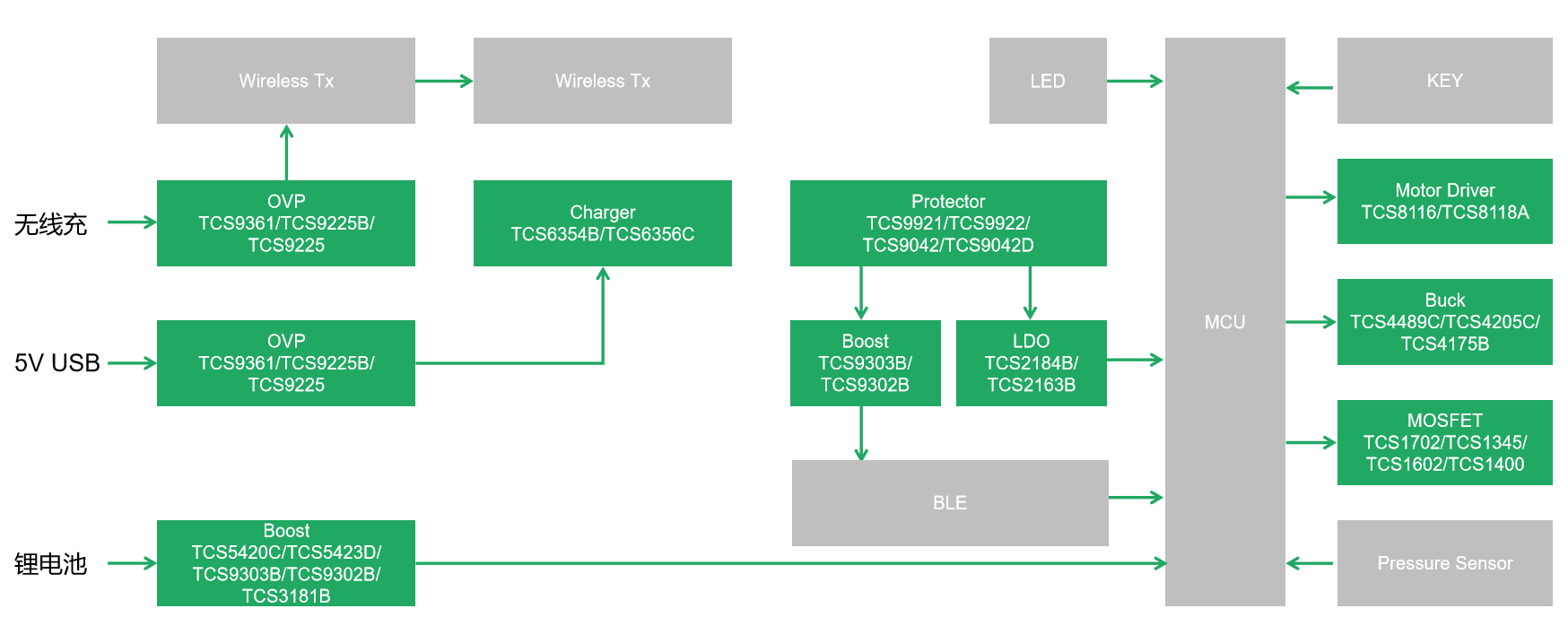

汤诚科技电动牙刷芯片解决方案,口腔健康新选择

TAS6424的开关频率2.MHz 在EMC CE电压法测试中出现超标情况,请问如何改善?

怎么样提高verilog代码编写水平?

LMH7322怎样去改善输出波形呢 ?

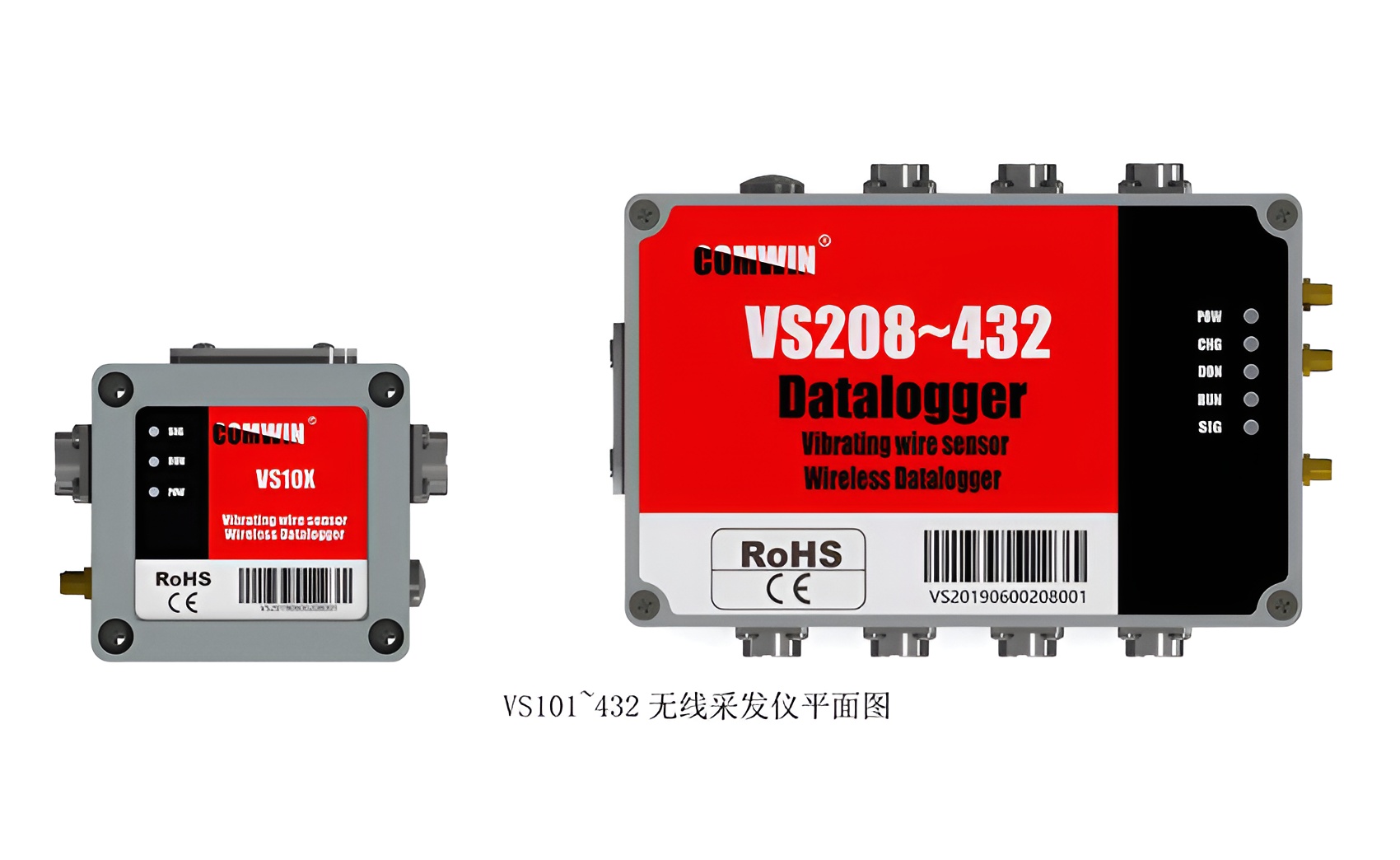

振弦采集仪:帮助工程师准确评估结构健康状况的利器

蓝牙模块在健康医疗领域的创新应用

微软与可汗学院携手,提供人工智能工具免费课程给美国教师

在选择美国硅谷站群服务器时需要特别注意什么?

辐射RE整改:科学应对辐射环境,建设健康未来?|深圳比创达电子EMC a

简述MinewSemi的GNSS模块引领体育与健康科技革新

振弦采集仪在桥梁健康监测中的应用与分析

如何帮助改善美国在人口水平上的健康的事业呢?

如何帮助改善美国在人口水平上的健康的事业呢?

评论