近年来,各类短视频、视频应用如雨后春笋般涌现, “AI+ 视频"的模式也是近期的热点方向。奇观是爱奇艺原创推出的 AI 创新应用产品,它融合了多模态人物识别、卡通角色识别、台词实体抽取、BGM 识别等 AI 技术,支持用户在观影过程中识别视频中的明星人物、卡通角色、背景音乐和台词梗等视频内信息。

为了进一步了解爱奇艺在“AI+ 视频”方向上的探索,在 QCon 上海站前夕,InfoQ 有幸采访了爱奇艺技术总监朱俊敏,听他分享爱奇艺奇观如何融合了多模态人物识别、卡通角色识别、BGM 识别、台词实体抽取等多种 AI 技术来挖掘视频的周边内容。

爱奇艺在“AI+ 视频”上的探索

作为视频平台,爱奇艺一直致力于人工智能与视频、娱乐产业的结合,并陆续推出了针对内容创作、用户推荐等方面的智能产品。奇观 是爱奇艺原创推出的 AI 创新应用产品,截至今年 7 月,奇观功能累计使用量已超 20 亿次。

据爱奇艺技术总监朱俊敏介绍,作为一款融合了多模态人物识别、卡通角色识别、台词实体抽取、BGM 识别等 AI 技术的产品,奇观的萌芽需求来源于用户。当时爱奇艺在分析用户的弹幕时发现,有一定比例的用户都在询问“当前的演员是谁?”, “背景音乐是啥?” 等跟视频强相关的问题。原来用户获取该类问题的答案路径是通过爱奇艺搜索或者百度搜索,但是效果并不是很好,造成这一结果的原因主要有两方面:一方面是因为用户需要打破原来沉浸式的观影体验;另一方面在于搜索无法做到海量内容实时索引,内容热播的时候一般是无法搜索到用户想要的结果的。

为了解决上述问题,爱奇艺于 2019 年首先在 TV 端进行了一些尝试。用户在观影时(当时的名字叫 AI 雷达),可以通过遥控上键识别视频中的明星,奇观产品推出后得到用户的一致好评,功能渗透率超出团队的预期。

后来,研发团队又将该功能扩展到移动端,通过双指双击的简单手势触达更多的用户群体,满足用户了解内容背后知识的需求。识别能力也逐渐从原来的明星识别, 扩展到背景音乐识别,台词实体知识,卡通角色识别等。

对纷繁复杂的明星、背景音乐、卡通角色等元素的精准识别并不是件容易事。就拿多模态人物识别来说,爱奇艺针对视频中人物身份识别的难点进行了全方位的优化改进,利用人脸质量模型显著减低了误检、差脸的干扰,综合利用人脸、人头、人体、声纹等多维度特征信息,通过局部加全局聚类的方式,对视频中的人物进行识别,大幅度提高了识别精度和召回。同时,团队还提供人脸的多维度属性标签,如年龄、男女、颜值等,并将属性标签和人脸识别模型进行整合,在保证精度的情况下,显著降低资源开销、提高资源利用效率。目前线上模型包含 10+ 个属性,相较于工业界的其他模型更加全面。爱奇艺人脸识别与属性模型十五合一,一个模型可以同时识别身份属性,且各项属性的识别精度也比较高。目前线上奇观服务的明星识别准确率达 99.5%。

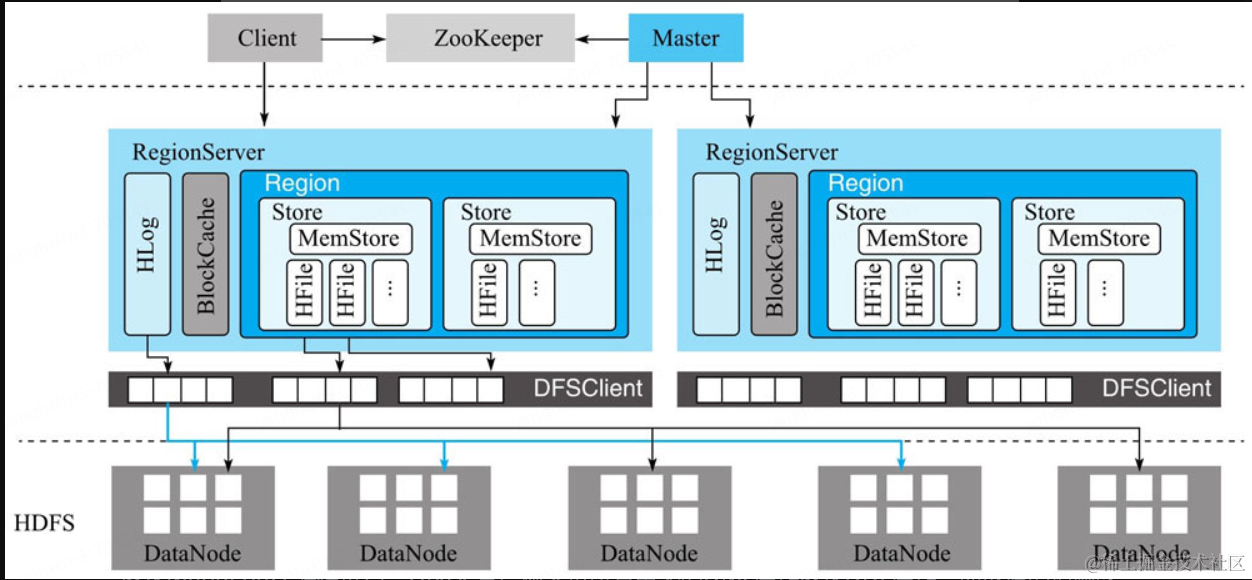

多模态人物识别技术的技术实现框图如下:

朱俊敏坦言,为了达到 99.5% 的明星识别准确率,算法团队付出了诸多努力。首先,他们分别训练了人脸、人头、人体和声纹特征的提取模型。再在人脸的帧级特征上增加了一个 NetVLAD 模块,将帧级特征转换成视频维度的特征,这样可以充分利用帧级人脸信息,提高特征的表达能力。在特征融合层,为了充分利用多模态特征,并且降低了噪声的干扰,团队还创新性地提出了 Multi-model Attention 模块来自适应地对各个模态分配不同的权重,并基于这些权重来进行多模态特征的融合,显著提高了算法的鲁棒性,大幅度提高了视频人物识别的精度。

下面的表格是研发团队从人脸特征开始逐渐增加多模态特征信息、NetVLAD 和 MMA 模块的精度收益情况,从表中可以得出,随着多模态信息的增加,爱奇艺的人脸识别精度稳定提升,这充分验证了爱奇艺多模态人物识别方法的有效性。

这样一项识别准确度高、广受好评的产品,其实它的研发周期并没有十分漫长。朱俊敏表示,多年来,爱奇艺在 NLP、声音和视觉的 AI 能力方面有深厚的积累,得益于爱奇艺长期对算法团队的投入,当决定做奇观产品时,大部分的算法和基础设施已经比较成熟。团队只需从用户需求出发,根据实际场景对算法和方案进行策略调整,快速实现产品化。朱俊敏称:

如果将奇观比喻为一栋房子,多模态人物识别、卡通角色识别、BGM 识别等 AI 技术就是地基。正是因为对 AI 长期的投入,有坚实的地基以支撑爱奇艺盖出更漂亮的房子。

识别方案如何从云迁移到端

从奇观萌生开始,研发团队就决定采用纯云端的识别方案,之所以会做出这样的决定,朱俊敏介绍,主要是考虑到算法的复杂度,在客户端既要播放视频(需要处理解码和上屏),又要处理 AI 算法,芯片性能可能跟不上,而且手机的散热和电池问题也会比较突出,所以奇观一开始定方案的时候是采用纯云端的识别方案。

后来,随着算法的优化和解耦,以人物识别为例,实现检测和识别的解耦,而且人脸检测的算法做到足够轻量级,实现 CPU 可流畅推理。团队开始寻求实现云 + 端的模式, 把算法解耦,检测部署在端上,识别部署在云端。这样做的好处是:一方面,在端上做检测,可以过滤很多无人物的情况,减少网络传输和云端识别的计算资源浪费;另一方面,端上做检测,在用户交互体验可以更优,实现人物区域可跟踪。

端上的识别方案不是云端方案的简单复刻,朱俊敏提到,在实现“云 + 端”的过程中,其难点主要在于两方面:一方面是芯片的适配,原来云端 GPU 的算法,考虑到客户端上 GPU 的参差不齐,需要把算法改造成 CPU 推理模式。另一方面,算法模型迁移到客户端,需要考虑到客户端本身的限制,不能显著增加整体 app 安装包的大小。所以为了适配客户端,算法本身需要做 CPU 迁移,并通过蒸馏压缩模型大小,同时还需要客户端的工程师配合集成相应的算法 runtime,同时建立模型动态加载的机制,尽可能地减少客户端的包的大小。

“云 + 端”模式将更快普及和应用

随着 5G 的逐步发展,朱俊敏认为,“云 + 端”这种模式会得到更快的普及和应用。5G 将作为一种全新的网络架构,提供 10Gbps 以上的峰值速率、更佳的移动性能、毫秒级时延和超高密度连接。而且客户端的性能越来越强,前面提到的云 + 端难点将不再是问题。这样可以给算法部署和应用更多的灵活性,业务可以根据自己场景和用户体验来决定是否将更多的算法部署到客户端。

而且 5G 网络的特性,决定其更加去中心化,需要在网络边缘部署小规模或者便携式数据中心,进行终端请求的本地化处理,也就是人们所说的边缘计算,将来的服务可能会进一步从“云 + 端”过度到“云 + 边 + 端”的模式上。

除了在“云 + 端”模式上继续发力外,奇观下一步的重点会继续扩展识别的品类。比如:动植物的百科实体类识别;电子产品和汽车等标准品的识别;以及各类穿着垂类商品的识别。另一方面会继续优化现有的识别体验,提高整体有结果率,目标是实现应有尽有的识别。

因为身处在内容行业,朱俊敏还表示,他会继续关注 AI 在声音和视觉上的算法创新,探索交互方面的新场景,未来,希望看到 AI 在内容创意和创作方面也能发挥上赋能提效的作用。

嘉宾介绍:

朱俊敏,爱奇艺技术总监。上海交通大学硕士,拥有 3 篇美国专利, 8 篇中国专利。2015 年加入爱奇艺,负责 AI 产品落地和创新应用开发,先后孵化了 HomeAI(智能语音交互平台), 奇观(智能识别平台),逗芽(表情生产和分发平台) 等创新应用。

本文转自 公众号:AI前线 ,作者李冬梅,点击阅读原文

审核编辑:符乾江

-

人工智能

+关注

关注

1791文章

47314浏览量

238662 -

深度学习

+关注

关注

73文章

5503浏览量

121207

发布评论请先 登录

相关推荐

从TMS320VC5509迁移到TMS320VC5509A

从TMS320DM6467迁移到TMS320DM6467T

从TMS320DM6446 594MHz迁移到810MHz

IT资源迁移到云服务器的关键因素

华纳云:企业迁移到云端的主要原因是什么?

龙智Atlassian ITSM解决方案、云迁移解决方案详解:高速ITSM实施+端到端的云迁移服务

爱奇艺技术总监:奇观识别方案从云迁移到端的探索和实践

爱奇艺技术总监:奇观识别方案从云迁移到端的探索和实践

评论