模块安装

pip3 install beautifulsoup4

模块导入

from bs4 import BeautifulSoup

示例html内容

获取html内容代码

import requests

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.94 Safari/537.36 115Browser/9.0.0"

}

response = requests.get("https://www.xbiquge6.com/xbqgph.html",headers=headers)

response.encoding = "utf-8"

html = response.text

print(html)

获取的html内容

小说排行榜列表

-

作品分类作品名称最新章节作者更新时间状态 -

[都市言情]我本港岛电影人今天有更再来一盘菇凉2019-11-16连载中 -

[玄幻奇幻]艾泽拉斯新秩序第一百三十六章 卡拉赞的收获想静静的顿河2019-11-16连载中 -

[都市言情]超级狂婿第654章:他不够格我本幸运2019-11-16连载中 -

[都市言情]我在都市修个仙完本感言一剑荡清风2019-11-16连载中 -

[都市言情]都市超级医圣第2613章 战后处理断桥残雪2019-11-16连载中 -

[都市言情]祖传土豪系统第二百零五章 我能试试吗第九倾城2019-11-16连载中 -

[都市言情]都市红粉图鉴第1510章 我,才是坐馆龙头!秋江独钓2019-11-16连载中 -

[武侠仙侠]胜天传奇第三百八十章 游历天宫骑牛者2019-11-16连载中 -

[都市言情]总裁爸比从天降第1748章奈何自己是婆婆一碟茴香豆2019-11-16连载中 -

[玄幻奇幻]太古魔帝第一千三百二十四章 魂帝草根2019-11-16连载中

构建BeautifulSoup对象

常用四种解释器

| 解释器 | 标识 | 特点 |

|---|---|---|

| Python标准库 | html.parser | Python内置,执行速度中 |

| lxml的HTML解释器 | lxml | 速度快 |

| lxml的XML解释器 | xml | 唯一支持XML解析 |

| html5lib | html5lib | 容错性最好,以浏览器方式解析 |

soup = BeautifulSoup(html, 'html.parser')

还可以解析本地html文件

soup1 = BeautifulSoup(open('index.html'))

.prettify()格式化输出节点

略

通过 . 获取节点

title = soup.head.title

print(type(title))

print(title)

结果是

对于名称唯一的节点,可以省略层级

title = soup.title

print(type(title))

print(title)

结果同样是

名称不唯一的节点,直接获取只会获取第一个匹配的节点

li = soup.li

print(li)

结果是

find_all根据条件获取节点

find_all( name , attrs , recursive , text , **kwargs )

name :查找所有名字为 name 的tag,字符串对象会被自动忽略掉;

attrs:根据属性查询,使用字典类型;

text :可以搜搜文档中的字符串内容.与 name 参数的可选值一样, text 参数接受 字符串 , 正则表达式 , 列表, True ;

recursive:调用tag的 find_all() 方法时,Beautiful Soup会检索当前tag的所有子孙节点,如果只想搜索tag的直接子节点,可以使用参数 recursive=False ;

limit:find_all() 方法返回全部的搜索结构,如果文档树很大那么搜索会很慢.如果我们不需要全部结果,可以使用 limit 参数限制返回结果的数量.效果与SQL中的limit关键字类似,当搜索到的结果数量达到 limit 的限制时,就停止搜索返回结果;

class_ :通过 class_ 参数搜索有指定CSS类名的tag,class_ 参数同样接受不同类型的 过滤器 ,字符串,正则表达式,方法或 True。

根据标签名字

lis = soup.find_all(nam)

for item in lis:

print(item)

结果是

-

首页 -

永久书架 -

玄幻奇幻 -

武侠仙侠 -

都市言情 -

历史军事 -

科幻灵异 -

网游竞技 -

女频频道 -

完本小说 -

排行榜单 -

临时书架 -

作品分类作品名称最新章节作者更新时间状态 -

[都市言情]我能举报万物第九十六章 巡抚视察【第三更】必火2019-11-16连载中 -

[科幻灵异]女战神的黑包群第3046章 恶毒女配,在线提刀45二谦2019-11-16连载中 -

[玄幻奇幻]花岗岩之怒第一百五十二章 意外到来的断剑咱的小刀2019-11-16连载中 -

[网游竞技]超神机械师1090 韭菜的自觉齐佩甲2019-11-16连载中 -

[武侠仙侠]无量真途第六百三十二章 突然出现的神智燕十千2019-11-16连载中 -

[科幻灵异]我的细胞监狱第四百五十九章 白雾穿黄衣的阿肥2019-11-16连载中 -

[武侠仙侠]前任无双第三百章 事急速办跃千愁2019-11-16连载中 -

[武侠仙侠]元阳道君第四十章 洞开剑扼虚空2019-11-16连载中 -

[历史军事]逆成长巨星655:不是办法的办法葛洛夫街兄弟2019-11-16连载中 -

[历史军事]承包大明第一百九十三章 真会玩南希北庆2019-11-16连载中

根据标签属性

属性和值以字典形式传入

lis = soup.find_all(attrs={"class":"s2"})

for item in lis:

print(item)

结果是

作品名称

我能举报万物

女战神的黑包群

花岗岩之怒

超神机械师

无量真途

我的细胞监狱

前任无双

元阳道君

逆成长巨星

承包大明

限制搜索范围

find_all 方法会搜索当前标签的所有子孙节点,如果只想搜索直接子节点,可以使用参数 recursive=False

遍历获取子节点

.contents获取所有子节点

以列表形式返回所有子节点,要注意,列表里面还会掺杂 '/n'

ul = soup.ul

print(ul)

print(ul.contents)

结果是

['/n',

-

首页, '/n', -

永久书架, '/n', -

玄幻奇幻, '/n', -

武侠仙侠, '/n', -

都市言情, '/n', -

历史军事, '/n', -

科幻灵异, '/n', -

网游竞技, '/n', -

女频频道, '/n', -

完本小说, '/n', -

排行榜单, '/n', -

临时书架, '/n']

.children获取所有子节点

返回一个list生成器对象

ul = soup.ul

print(ul.children)

print(list(ul.children))

结果是

['/n',

-

首页, '/n', -

永久书架, '/n', -

玄幻奇幻, '/n', -

武侠仙侠, '/n', -

都市言情, '/n', -

历史军事, '/n', -

科幻灵异, '/n', -

网游竞技, '/n', -

女频频道, '/n', -

完本小说, '/n', -

排行榜单, '/n', -

临时书架, '/n']

.descendants遍历所有子孙节点

ul = soup.ul

for item in ul.descendants:

print(item)

结果是(中间很多'/n'空行我删掉了)

首页 首页

永久书架 永久书架

玄幻奇幻 玄幻奇幻

武侠仙侠 武侠仙侠

都市言情 都市言情

历史军事 历史军事

科幻灵异 科幻灵异

网游竞技 网游竞技

女频频道 女频频道

完本小说 完本小说

排行榜单 排行榜单

临时书架 临时书架

获取其父节点

a = soup.li.a

print(a)

p = a.parent

print(p)

结果是

首页

提取节点信息

节点名称

感觉没什么用

title = soup.title

print(title.name)

结果是

title

节点属性

a = soup.li.a

print(a)

print(a.attrs) # 获取所有属性,返回字典形式

print(a['href'])# 获取a节点的href属性值

结果是

首页

{'href': '/'}

/

节点文本

a = soup.li.a

print(type(a.string)) # 节点内文本的类型

print(a.string) # 获取节点内的文本内容

print(a.get_text()) # 也是获取节点内的文本内容

结果是

首页

注意!!!如果节点内文本是注释,则用string取出文本时会自动去除注释标记

注释的类型:,可以通过类型判断

遍历获取所有子孙节点中的文本

for string in soup.stripped_strings: # 去除多余空白内容

print(repr(string))

想进一步了解编程开发相关知识,与我一同成长进步,请关注我的公众号“松果仓库”,共同分享宅&程序员的各类资源,谢谢!!!

审核编辑 黄昊宇

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

JAVA

+关注

关注

19文章

2978浏览量

105301 -

人工智能

+关注

关注

1797文章

47888浏览量

240897 -

python

+关注

关注

56文章

4811浏览量

85113 -

爬虫

+关注

关注

0文章

82浏览量

7043

发布评论请先 登录

相关推荐

IP地址数据信息和爬虫拦截的关联

IP地址数据信息和爬虫拦截的关联主要涉及到两方面的内容,也就是数据信息和爬虫。IP 地址数据信息的内容丰富,包括所属地域、所属网络运营商、访问时间序列、访问频率等。 从IP地址信息中可以窥见

Python常用函数大全

在 Python 世界里,有一些宝藏函数和模块,它们可以让你编程更轻松、代码更高效。这篇文章将带你一一认识这些神器,让你的开发生活瞬间轻松不少!

详细解读爬虫多开代理IP的用途,以及如何配置!

爬虫多开代理IP是一种在爬虫开发中常用的技术策略,主要用于提高数据采集效率、避免IP被封禁以及获取地域特定的数据。

如何实现Python复制文件操作

Python 中有许多“开盖即食”的模块(比如 os,subprocess 和 shutil)以支持文件 I/O 操作。在这篇文章中,你将会看到一些用 Python 实现文件复制的特殊方法。下面我们开始学习这九种不同的方法来实现

python训练出的模型怎么调用

使用pickle模块 pickle 是Python的一个内置模块,用于序列化和反序列化Python对象结构。使用 pickle 可以方便地保存和加载模型。 import pickle

用pycharm进行python爬虫的步骤

以下是使用PyCharm进行Python爬虫的步骤: 安装PyCharm和Python 首先,您需要安装PyCharm和Python。PyCharm是一个流行的

常见的数据采集工具的介绍

Scraping) 网络爬虫是一种自动化的程序,用于从互联网上提取信息。它们可以访问网页,解析HTML内容,并从中提取所需的数据。 Scrapy : 一个快速且强大的Python框架,用于抓取网站数据。 Beautiful

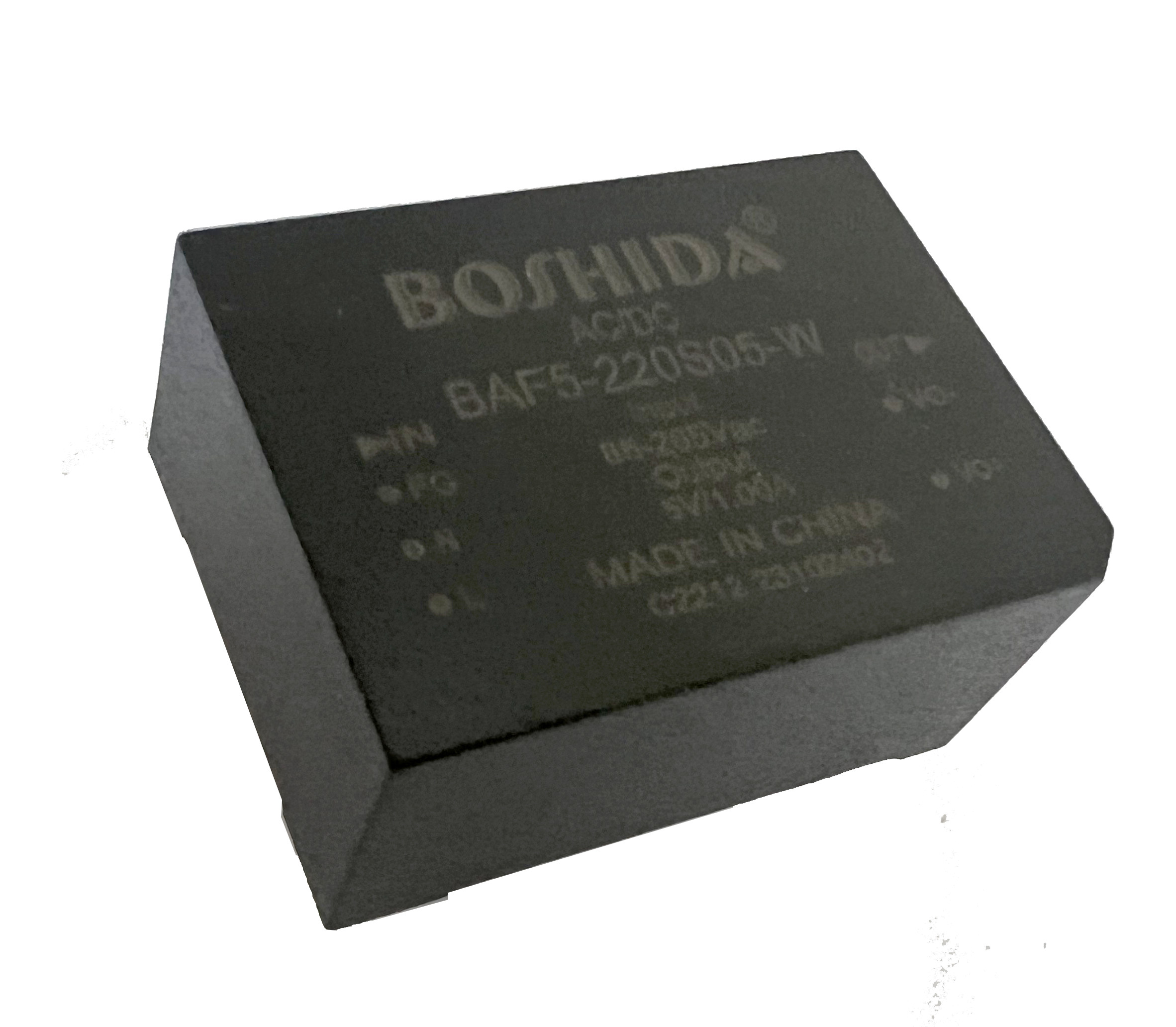

AC/DC电源模块:跟踪技术的创新之选

BOSHIDA AC/DC电源模块:跟踪技术的创新之选 AC/DC电源模块是一种将交流电转换为直流电的设备,广泛应用于各个领域的电子设备中。随着现代科技的发展,对电子设备的要求越来越高,需要

如何使用Python生成四位随机数字

为了实现这些目标,Python 为我们提供了random() 模块。random() 是一个内置的 Python 模块,用于生成随机数。

全球新闻网封锁OpenAI和谷歌AI爬虫

分析结果显示,至2023年底,超半数(57%)的传统印刷媒体如《纽约时报》等已关闭OpenAI爬虫,反之电视广播以及数字原生媒体相应地分别为48%和31%。而对于谷歌人工智能爬虫,32%的印刷媒体采取相同措施,电视广播和数字原生媒体的比率分别为19%和17%。

Python爬虫之Beautiful Soup模块

Python爬虫之Beautiful Soup模块

评论