这项工作的意义在于,帮助医学研究工作者更好地选择医学临床试验,特别在新冠疫情下,更好的医学临床试验或许就意味着能更快地找到有效的治疗方案。 日前,AI领域顶会EMNLP 2020落下帷幕。

今年全球仅有754篇论文被接受,接收率为24%,阿里巴巴凭借28篇论文成为入选论文数最多的中国科技公司。

据雷锋网《医健AI掘金志》了解,阿里相关研究成果覆盖情感分析、文本生成及医疗NLP等领域。

在今年疫情的大环境下,医疗领域的研究与成果产出也不断提速。

在名为《Predicting Clinical Trial Results by Implicit Evidence Integration》的论文中,达摩院研究团队设计了针对医学临床试验的进一步预训练任务,并提出全新的模型,帮助医学研究工作者更好地选择医学临床试验,以更快地找到有效的治疗方案。

研究团队在COVID-evidence数据集上完成了试验,并证明了模型的有效性。

为此,该论文作者、达摩院算法专家谭传奇进行了解读。

自18年谷歌BERT横空出世以来,预训练语言模型一跃成为自然语言处理领域的研究热点,“Pre-training + Fine-tune”也成为NLP任务的新范式,将自然语言处理由原来的手工调参、依靠机器学习专家的阶段,进入到可以大规模、可复制的大工业施展的阶段。

这篇论文在BioBERT(在医学数据上训练的BERT模型)的基础上,设计了针对医学临床试验的进一步预训练任务(Post-Pre-training),最终在真实医学临床试验数据上微调(Fine-tune)后,取得了超过10个百分点的结果提升。

而这项工作的意义在于,帮助医学研究工作者更好地选择医学临床试验,特别在COVID-19疫情下,更好的医学临床试验或许就意味着能更快地找到有效的治疗方案。

剑指临床试验的设计难题

在循证医学的时代,任何的治疗都要有相应的临床证据支持。证据往往来自于高质量的临床试验。然而,实施临床试验耗时耗力,需要大量资源支持。

并且,设计有缺陷或者难以成功的临床试验占用了宝贵的病人资源,可能会使亟待实施的临床试验因招募不到足够的患者而被迫终止。

新冠肺炎疫情中的瑞德西韦临床试验就是一个例子:

因其他设计有缺陷或者难以成功的临床试验占用了不少病人资源,该试验没有招募到足够的病人资源,而没有得到统计学上显著的结果。

所以,研究者需要在设计阶段就去预测临床试验的结果,并优先进行成功概率较高的临床试验。

提出新的临床试验需要过往临床证据的支持,比如WHO为新冠肺炎推荐优先检测氯喹/羟氯喹,瑞德西韦,干扰素和洛匹那韦/利托那韦四种药物优先进行临床试验。

推荐的理由就是,这些药物在过往的实验室或人体试验中对相关冠状病毒有效。然而,人类综合过往临床证据的能力有限。

谭传奇引用了一个数据:一项研究发现大概86.2%的临床试验最终会失败,WHO专家推荐的某些新冠肺炎治疗方法,如氯喹/羟氯喹,也没有得到好的结果。

临床试验设计难题的核心是临床试验的结果无法准确预测。

所以,如果能准确地预测临床试验的结果,就可以有针对性地进行成功概率的临床试验,从而大大提高临床试验实施的效率。

因此,谭传奇团队表示,在本工作中,我们的贡献就在于:

第一、创新地从NLP的角度重新定义了临床试验结果预测任务;

第二、提出了一种基于大规模隐式临床证据预训练的模型EBM-Net(Evidence-Based Medicine Network)用以解决该任务,EBM-Net在各种指标上远超医学大规模语言模型BioBERT,如在标准数据集上有10.7%的相对F1提升,并且在新冠肺炎相关的临床试验上也被证明有效。

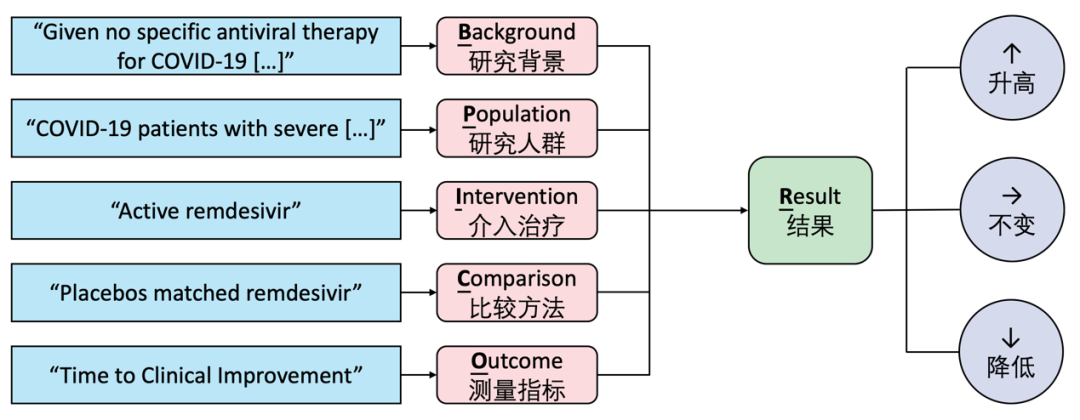

在上面这张图中,参考医学临床试验在填报提案时需要的基本信息,输入是自然文本的形式的:

临床试验背景B,如“最新研究发现瑞德西韦在体外对新冠肺炎病毒有效……”;

要研究的人群P,如“重症新冠肺炎病人”;

治疗方法I,如“静脉注射瑞德西韦”;

对照方法C,如“与瑞德西韦相匹配的安慰剂”;

测量指标O,如“死亡率”

输出是其结果R,即在研究人群P中,治疗组I和对照组C的测量结果O的比较关系,有升高、降低和不变三种。

EBM-Net

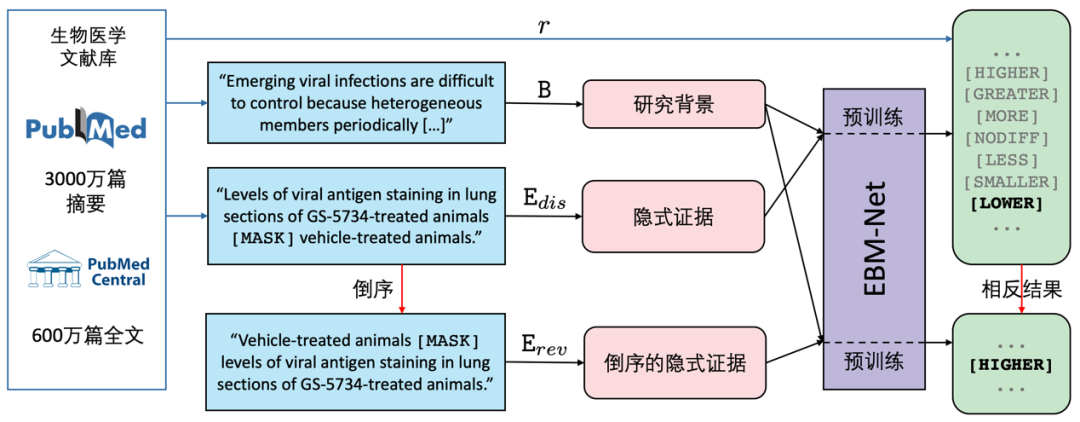

为了解决上述临床试验结果预测任务,达摩院的团队提出了针对循证医学的EBM-Net模型,其结构如图2所示,具体分为三步进行:

首先,用启发式方法收集隐式证据;

然后,用隐式证据预训练比较语言模型;

最后,用预训练的模型进行临床试验结果预测。

收集隐式证据

临床证据常常以一种比较的形式表达,如“瑞德西韦比对照组有更好的治疗新冠肺炎的疗效”,而找到这些证据就可以为我们提供训练文本。

研究团队发现,PubMed和PubMed Central是一个提供生物医学方面的论文搜寻以及摘要,文献资源中就包含需要的证据文本(注:医学领域最好的大规模语言模型BioBERT的训练数据即来自PubMed)。

这篇论文提出用关键词匹配的方法,收集PubMed和PubMed Central中所有含有比较语义的句子:

为寻找表达升高和降低的语义,匹配含有“than”的句子,再进一步匹配形容词或副词的比较级,如“higher”,“smaller”等,同时含有“than”和一个或更多比较级的句子被收集;为寻找表达相似的语义,匹配含有“no difference between”和“similar to”模式的句子。

这些句子被称为隐式证据,因为它们往往隐式地含有临床证据所需要的PICO组分。他们还收集这些句子对应的文章摘要里的背景和方法的部分,作为隐式证据的背景B。

这种方法可以从PubMed和PubMed Central中提取出1180万条隐式证据,其中240万条表达结果降低,350万条表达结果相似,590万条表达结果升高。

预训练比较语言模型

将收集到的隐式证据中提示结果语义的词去除,就构造了一个类似语言模型训练的问题,通过给定上下文信息,预测去除的比较词。

论文中改进语言模型,提出用比较语言模型预训练一个Transformer编码器模型,即EBM-Net,以获取预测临床试验结果的能力。具体地,两组样本被用于预训练:

1、用正序的隐式证据预测其结果;

2、用反序的隐式证据预测相反的结果。

加入反序的例子有利于模型学到治疗组和对照组之间的比较,而不是语言模型里的共现关系。

临床试验结果预测

在微调和测试时,团队将一个新临床试验要研究的PICO要素拼接成E,将E和其研究背景B输入到上述预训练好的EBM-Net模型中,输出其预测的比较结果,从而预测临床试验的结果。

标准数据集的试验结果

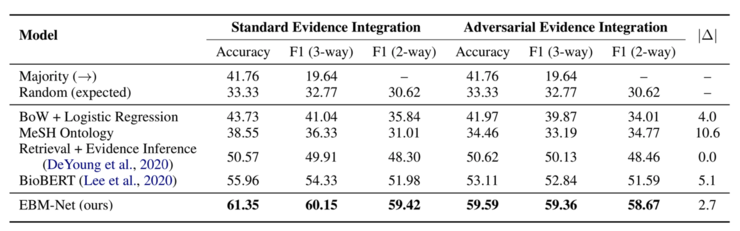

EBM-Net在临床试验结果预测任务的标准数据集Evidence Integration试验结果如图3所示:

从结果中可以看出:

1、EBM-Net相比其他方法,包括随机预测、词袋+逻辑回归、利用MeSH知识图谱、信息检索+阅读理解模型以及目前生物医学NLP领域的SOTA模型BioBERT,都有很大的提高:BioBERT作为最强的基线模型,也比EBM-Net低了10.7%的相对macro-F1和9.6%的准确率;

2、EBM-Net相比其他方法在对抗攻击下更鲁棒:用|Δ||Δ|,即在对抗数据集上的accuracy的相对减少的值来衡量模型的鲁棒性,|Δ||Δ|越大表示模型越易受攻击。

BioBERT的|Δ||Δ|几乎是EBM-Net的两倍(5.1%比2.7%),说明EBM-Net远比BioBERT鲁棒;

EBM-Net用于新冠肺炎相关临床试验

达摩院团队还基于COVID-evidence数据库提取了截止5月12日前完成的22篇临床试验的结果,以本工作定义的临床试验结果预测的格式构建了一个小型数据集。

达摩院团队提出的EBM-Net模型在该数据集上进行留一法验证得到的macro-F1和accuracy都远高于BioBERT,分别是45.5%比36.1%和59.1%比50.0%,再一次验证了EBM-Net的有效性。

总结

为了优化临床试验的设计过程,本文从NLP的角度定义了临床试验结果预测任务,并且提出了一种基于大规模隐式证据预训练的EBM-Net模型来解决这个任务。

EBM-Net在标准数据集和新冠肺炎相关临床试验上都有较好的表现,大幅超过生物医学NLP的SOTA模型BioBERT。

未来,临床试验可以在EBM-Net等相关模型的协助下进行设计:

当我们固定了想要研究的疾病人群(P)和观察指标(O)后,可以固定以现有的标准治疗为对照(C),遍历每种可能的新型治疗方式(I)以及其相关的背景介绍(B),用模型预测其成功的概率,优先选取所有可能的治疗方式中成功概率高的做临床试验。

当然,模型在技术上还需要进一步地提高才能更好地辅助临床试验设计。

后续,我们可以把团队构建的大规模医学知识图谱集成在模型中,使其拥有更准确和鲁棒的预测能力。

责任编辑:lq

-

AI

+关注

关注

87文章

30348浏览量

268602 -

语言模型

+关注

关注

0文章

514浏览量

10252 -

数据集

+关注

关注

4文章

1205浏览量

24656

原文标题:剑指临床试验的设计难题!达摩院提出新模型EBM-Net,比最强基线模型准确率高9.6%

文章出处:【微信号:IoT_talk,微信公众号:医健AI掘金志】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

AI在环境可持续发展方面的作用

安全可靠,高效防爆:顶坚单北斗防爆终端在工业领域的创新应用

RISC-V在AI领域的发展前景怎么样?

经纬恒润功能安全AI 智能体论文成功入选EMNLP 2024!

华怡丰2024华南国际工业博览会精彩回顾

AI4Science黑客松光子计算挑战赛成功举办

2020-2022-2024年TI杯全国大学生电子设计竞赛官方推荐芯片对比分析比较

奥拓电子携多款AI+视讯产品亮相北京InfoComm

云天励飞首届渠道大会落下帷幕,多家企业现场签约

AI领域顶会EMNLP 2020落下帷幕

AI领域顶会EMNLP 2020落下帷幕

评论