随着信息科技的进步,数据的收集变得十分便利。不同来源的信息与数据,通过数据挖掘技术,又可以进一步影响着我们的生活,并提升我们的生活品质。近日,在英特尔召开的主题为“颠覆性研究 开启计算未来十年”的“2020英特尔研究院开放日”上,英特尔高级院士、副总裁、英特尔研究院院长Rich Uhlig率众专家为我们分享了英特尔研究院在集成光电、神经拟态计算、量子计算、保密计算和机器编程五个领域所做的前沿研究及其科研成果。

Rich介绍说:“我们认为这五个领域能够真正大规模释放数据价值,并且变革人们与数据互动的方式。其实未来早已到来,只是分布不均。英特尔的目标是让每个人都能获得百亿亿次级计算。”英特尔正致力于多个数量级的提升,他们将其简称为“追求1000倍提升”(In pursuit of 1000X)”

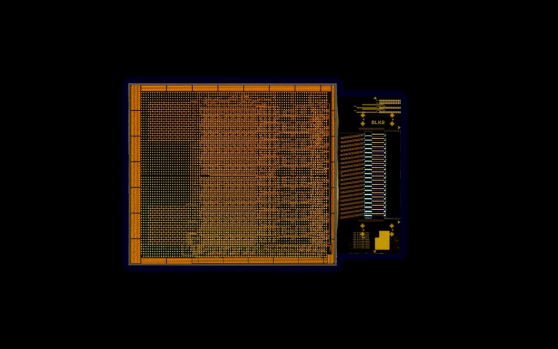

集成光电 集成光电旨在将光科学与大规模芯片生产的成本效益相结合。众所周知,光互连(optical)在长距离、远程和地下传输中占主导地位,而电气互连(electrical)在短距离、主板互连(board to board)和封装互连(package to package)中占主导地位。

英特尔首席工程师、英特尔研究院PHY研究实验室主任James Jaussi介绍说:“英特尔的愿景是将光互连引入到服务器中,为此他们开发出了硅光子技术,让光互连具备硅的高产量、低成本等属性。”借助集成光电技术,英特尔能够将 I/O 数量从几百万个扩展到几十亿个,实现 1000 倍的提升。据介绍,未来的光链路将让所有的I/O连接直接从英特尔的服务器封装中发出,全面覆盖整个数据中心。这项技术将彻底改变数据中心网络架构,并释放数据,显著提高数据传输效率。

虽然这项技术已经取得了长足的进步,已经为客户提供了超过 400 百万个英特尔 100G 收发器产品。不过目前鉴于硅光子模块和运行功率的成本和物理体积,光互连I/O还不适合短距离传输。这也是英特尔要跨越的下一个巨大障碍。此外,James预测说:“展望通信和数据中心性能的未来,光互连和电气互连方法之间有一个明显的拐点,主要原因有两点:首先,我们正快速接近电气性能的物理极限。

如果不进行根本性创新,高能效电路设计将存在诸多限制。第二是 I/O 功耗墙。计算的带宽需求大约每三年翻一番。遗憾的是,电气性能扩展跟不上带宽需求的增长速度,导致了I/O“功耗墙”,即I/O 功耗会逐渐高于所有现有的插接电源,导致无法计算。”

光互连技术涉及六大技术要素:光产生、光放大、光检测、光调制、CMOS 接口电路和封装集成。最近,英特尔在其他五大技术构建模块上实现了重大创新,这也加速实现其为集成光电构建的关键技术模块的愿景。James认为,这些构建模块将从根本上革新计算 I/O,并彻底改变未来的数据中心通信趋势。

首先是光调制。传统硅调制器体积巨大,占据过多空间,因此放置在 IC 封装上的成本很高。英特尔实现的一个最新突破就是开发了微型微射线调制器。它们的体积缩小了 1000 倍,因此服务器封装上可以放置几百个这样的器件。

第二项突破是光探测--全硅光电探测器(all-silicon photo detector)。几十年来,业界一直认为硅几乎不具备光探测能力。英特尔证明了事实并非如此。这项突破的一个主要优势是降低了成本。

第三个是光放大。它和激光器一样重要。如果要降低总功耗,那么集成半导体光学放大器将是不可或缺的技术。因此,如果没有集成激光器,就不可能有这些放大器。

最后,英特尔通过协同集成将CMOS 电路和硅光子技术整合起来。今年二月,英特尔发布了 3D 堆叠 CMOS 电路,在该电路中两个 IC 上下堆叠,与光子直连。截至目前,其他公司没有展示过将集成激光器、半导体光学放大器、全硅光电探测器和微型环调制器集成在一个与CMOS硅紧密集成的单个技术平台上。

神经拟态计算

近几年,随着深度学习的出现,人工智能领域取得了惊人的进展,但与此同时,进展的代价是人工智能系统功耗不断增加。训练一个现代人工神经网络需要使用数千台集群服务器,功耗高达数百万瓦。它正逐渐变成人工智能不断发展、以及广泛普及的瓶颈。那么,如何才能将人工智能任务的能效提高 1000 倍呢?

英特尔试图找到一种更通用的人工智能架构,能实时解决各种类型的问题,从规划问题到优化问题并且能够以比今天的常规方法快得多的速度,实现模式匹配和深度学习模型所能做到的,并且使用更加节能的解决方案。它是一种非常基本的、自下而上的角度,直接从神经科学中获取灵感。目标是要开发出比现有的更通用的可编程架构。

2015年英特尔开始以现代神经科学理解作为灵感开发了一种新型计算机架构。相比传统计算机架构,神经拟态架构完全模糊了内存和处理之间的界限。和大脑一样,它利用的是数据连接、数据编码和电路活动中所有形式的稀疏(sparsity)。处理就发生在信息到达时,二者同步进行。计算是数百万个简单处理单元之间动态交互的发展结果,就像大脑中的神经元一样。

这种新型计算机架构旨在将能效、实时数据处理速度、学习数据的效率等提升多个数量级。英特尔高级首席工程师、英特尔研究院神经拟态计算实验室主任Mike Davies 介绍说:“我们的目标是支持广泛的工作负载,而不仅仅只有深度学习。因为大脑解决问题的范围很大,所以我们认为这个目标是可以实现的。我们认为还可以将这种架构从边缘扩展到数据中心,鉴于自然界中大脑容量的巨大差异,从蚂蚁到鹦鹉,再到人类的大脑。”

2017 年英特尔发布了首款神经拟态研究芯片Loihi。该芯片采用英特尔主流的14 纳米制程技术制造而成。相比其他神经拟态芯片,Loihi 具有前所未有的灵活性、集成性和速度。它还具有片上学习功能,远远超出了目前使用的所有芯片。Loihi 没有深度学习硬件中普遍存在的浮点数和乘法累加器单元。

Loihi 没有片外内存接口。和大脑一样,所有计算都在芯片上进行,通过二进制脉冲信息和低精度信号。内存来源于芯片神经元之间的连接。Loihi 采用同质架构,将许多小神经拟态核实例化,每个核的大小只有针头的一部分。通过将神经拟态结构从几核扩展到几百核,可以将小型的专用工作负载扩展至 CPU 或 GPU 大小的芯片。甚至还可以无缝排列这些芯片。

此外,英特尔特别成立了英特尔神经拟态研究社区,简称 INRC,借此与世界各地不同类型的学术界、政府实验室和企业的研究人员交流合作。到截至目前,INRC 已经发表了40 多篇经过同行评审的论文,其中许多论文中都记录了量化结果,证明这项技术能够带来有效的性能提升。部分机器人工作负载显示,Loihi 的功耗比传统解决方案低 40-100 倍。Mike表示:“尽管 Loihi 的基准评测结果令人惊叹,但我们仍然缺乏统一的编程框架将这些示例整合到更大规模的功能系统中。这些问题代表着神经拟态研究的最前沿。”

据介绍,短期内,由于成本问题,该技术要么仅适用于边缘设备、传感器等小规模设备,要么仅适用于对成本不敏感的应用,如卫星、专用机器人。随着时间的推移,英特尔预计内存技术的创新能够降低成本,让神经拟态解决方案扩大适用范围,运用于各种需要实时处理数据但受限于体积、重量、功耗等因素的智能设备。今年是英特尔针对神经拟态计算研究的第五年,他们非常看好神经拟态计算的前景,并且坚信,神经拟态计算未来将帮助各种应用实现巨大突破。Mike分享说:“我们将在 2021 年第 1 季度发布下一代Lava软件开发框架的开源版本,以此能够触及到更庞大的软件开发人员社区。”

量子计算

量子计算是近年来一个非常活跃的研究领域,如果我们能够解决相关的科学与工程问题以支持它们大规模运行,它们将变得非常强大。比如设计新药物和改进药物会对医疗健康产生重要影响,而这也是量子计算未来的一个潜在应用领域。其他应用领域包括设计新型材料和化学催化剂。在这些应用领域,很多材料都是经典计算机无法模拟的。

英特尔高级首席工程师、英特尔研究院量子应用与架构总监Anne Matsuura认为:“商用级量子计算机将支持模拟这些材料,方便将来设计具有独特属性的材料、化学用品和药物。但目前仅仅有 100 个量子位甚至数千个量子位的量子计算系统,我们需要开发包含数百万个量子位的全栈商用级量子计算系统,才能达到量子实用性来解决这类复杂问题。”据介绍,英特尔的量子研究主要集中在自旋量子位技术、低温控制技术和全栈创新等关键领域。每一个领域都旨在解决通往量子计算可扩展性道路上的关键挑战,英特尔正在系统地布局每一个领域,以实现量子扩展。

首先,扩展量子的最大挑战,就是如何批量生产高质量量子位。重点其实并不只是量子位的数量。目前我们看到的小型量子计算系统中所使用的量子位,其质量对于商用级量子系统来说是远远不够的。我们需要寿命足够长、相互之间连接性足够强的量子位,以便扩展至包含数百万量子位的商用级量子计算机,能够在实际的应用领域执行有效的量子程序或量子算法。自旋量子位与英特尔的晶体管技术非常相似,可提供最佳的发展路径。英特尔量子研究的优势在于,他们构建量子位的晶圆厂实际上同样用于开发最新、最出色的制程节点。

量子计算面对的第二个挑战是量子位控制。英特尔在这一领域取得了巨大进展。当前,量子位主要由许多机架(rack)的控制电路进行控制,这些电路通过复杂的布线连接至量子位,并且被放置在低温冰箱中,以防止热噪声和电噪声影响脆弱的量子位。对于商用级量子计算系统,需要将数百万根导线引入量子位室(qubit chamber)。这样不具备可扩展性。英特尔采用支持可扩展互连的低温量子位控制芯片技术,以解决这一挑战,并开发了世界一流的低温控制芯片,该芯片基于 22 纳米 FinFET 技术,可以在低温冰箱内进行集成。

量子计算面对的第三个挑战是纠错。全面纠错需要数十个量子位形成一个逻辑量子位。英特尔正在开发抗噪量子算法和错误抑制技术,帮助在目前的小型量子位系统上运行这些算法。

量子计算面对的第四个挑战是,需要可扩展的全栈量子计算机。由于量子计算是一种全新的计算类型,运行程序的方式完全不同,因此需要开发量子专用的软件、硬件和应用。这也意味着,从应用、编译器、量子位控制处理器、控制电路,到量子位芯片器件,量子计算的整个堆栈都需要采用全新组件。英特尔正在开发整个量子计算堆栈的所有组件,并这些量子组件协同工作。

英特尔正在逐步实现商用级量子计算的愿景。Anne分享说:“英特尔发展量子计算的方法就是利用英特尔的优势,特别是利用英特尔在芯片和电路制造工艺方面的专长。目标是达到数百万个量子位的规模,并且我们相信,我们所选择的自旋量子位技术在低温测试和控制方面所取得的进步,集成光子以及所采用的全栈系统方法,将引领我们率先实现这一目标。”

保密计算

释放数据潜力除了传输数据方面的挑战外,保护数据隐私也是当前所面临的障碍之一,尤其是在医疗、金融服务等许多领域,数据所有者可能需要遵循相关法规,最大的数据集往往都被限制在所谓的数据孤岛中。然而,这些数据孤岛对使用机器学习工具从数据中获取重要洞察造成了巨大障碍。为了解决这些问题,英特尔一直在推动保密计算的发展。

本世纪初,英特尔研究院就开始研究如何隔离应用,结合硬件访问控制技术和加密技术,以提供保密性和完整性保护。例如最新的英特尔软件保护扩展(Software Guard Extensions )技术,它将保密性、完整性和认证功能整合在一起,确保使用中的数据安全无虞。英特尔研究院安全智能化项目组首席工程师Jason Martin介绍,当前加密解决方案主要用于保护在网络中发送以及存储的数据。但数据在使用过程中依然容易遭遇攻击。保密计算旨在保护使用中的数据。为此,英特尔提供数据保密性以防止机密泄露,提供执行完整性以防止计算被篡改,并提供认证功能,以验证软硬件的真实性。此外,英特尔还在研究另一种不需要解密数据的方法,叫做同态加密(homomorphic encryption)。

据了解,完全同态加密是一种全新的加密系统,它允许应用在不暴露数据的情况下,直接对加密数据执行计算操作。该技术已逐渐成为委托计算中用于保护数据隐私的主要方法。例如,这些加密技术允许直接对加密数据进行云计算,不需要信任云基础设施、云服务或其他使用者。传统加密要求云服务器访问密钥,才能解锁数据用于处理。同态加密允许云对密文或加密数据执行计算操作,然后将加密结果返回给数据所有者,从而简化并保护了这一过程。结果表明,任何计算都可以由加法和乘法构成。Jason分享说:“在完全同态加密中,你可以用任意复杂度的算法对加密数据执行这些基本操作。之后解密数据时,这些操作适用于纯文本。”

不过,Jason也表示,目前仍存在一些挑战,阻碍了完全同态加密的采用。在传输和存储数据时,传统加密机制的开销相对来说可以忽略不计,但在完全同态加密中,同态密文的篇幅比纯数据大得多,有时候大 1,000-10,000 倍。数据激增将导致计算激增。密文的增加,要求处理能力随之增加。处理开销不仅会随着数据的增加而增加,还会随着计算复杂性的增加而增加。就是因为这些巨大的开销,导致同态加密尚未得到广泛使用。英特尔正在研究新的软硬件方法,希望普及这项技术,并与生态系统和标准机构开展合作。

机器编程

编程目前出现了两种对立的趋势。首先,计算资源变得越来越异构化,因为我们对某些种类的工作负载进行了专业化处理。所以需要专家级的程序员,因为他们非常了解硬件以及如何最大限度地利用硬件。但与此同时,软件开发人员越来越青睐于使用更抽象的语言,以提高工作效率。这反过来会导致硬件难以发挥出它本身的性能。并且这种差距正在扩大。为此。英特尔一直致力于引入新的方法教计算系统自己编程,即机器编程。

机器编程与机器学习有很大的不同,机器编程是教系统自己编程。它的核心原则是,人类向机器表达他(她)的意图,机器会自动创建完成该意图所需的所有软件。自动生成软件领域是机器编程的核心重点。机器编程实际上是构建系统,然后由系统自行构建自己的软件系统。而硬件系统作为副产品,也随之构建起来。英特尔致力于让机器编程同时从两个方向发力。首先,希望机器编程系统能够提高编码员和非编码员的工作效率。第二,希望确保机器编程系统生成的是高质量、快速、安全的代码。如果做不到这两点,就不能真正地帮助到开发人员。

基于这两个核心价值观,英特尔首席科学家、英特尔研究院机器编程研究主任及创始人Justin Gottschlich认为,机器编程关键的第一步是改进软件调试(Debug)。软件Debug在本质上就是识别、分析和纠正软件缺陷的过程。然而,Debug严重影响了程序员的工作效率。2017 年剑桥大学开展的一项调查显示,美国程序员平均花费 50%的时间用在Debug上,这是很长的时间。除了提高鲁棒性,英特尔还希望能够减少Debug时间。

Justin介绍,机器编程有三大支柱,分别是意图(intention)、创造(invention)和适应(adaptation)。这三大支柱,是英特尔创新方法的核心驱动力之,也是许多学术界和产业界合作伙伴的核心驱动力之一。Justin分享说,英特尔已经开发了两个具体的系统,现在正在将它们集成到生产级系统中。

l 2019年,英特尔在NeurIPS 上发布第一个可以自动检测性能漏洞的机器编程系统。这个系统实际上发明了用于检测性能问题的测试。有了这个系统,人类不用编写一行代码。最重要的是,同一个系统可以自动将发明的测试应用于不同的硬件架构上。这就解决了硬件异构问题。

l 2020年,英特尔构建了第二个系统,并且已经在NeurIPS 2020上展示了这项研究。该系统也是尝试查找漏洞,但它不仅限于查找性能漏洞,它可以在无人监督的情况下识别漏洞。在机器学习领域,这意味着它可以在没有任何人类生成的数据标签下学习。最近该系统刚刚突破了从超过 10 亿行代码中学习的极限。并且每次添加更多数据,它似乎都能学到以前没有观察到的新事物。

责任编辑:xj

原文标题:英特尔披露集成光电、神经拟态计算、量子计算等五大前沿最新进展

文章出处:【微信公众号:MEMS】欢迎添加关注!文章转载请注明出处。

-

英特尔

+关注

关注

61文章

9985浏览量

171964 -

量子计算

+关注

关注

4文章

1105浏览量

34973 -

神经计算

+关注

关注

0文章

12浏览量

4166

原文标题:英特尔披露集成光电、神经拟态计算、量子计算等五大前沿最新进展

文章出处:【微信号:MEMSensor,微信公众号:MEMS】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

英特尔与火山引擎等合作,夯实AI应用智能底座

IC China 2024北京开幕:英特尔分享洞察,促智能计算应用落地

祝贺!亿达科创荣获高交会“优秀科研成果创新奖”

中科曙光铸稳算力底座,赋能科研成果落地

海康微影DV式手持测温热像仪助力提升科研效率

芯海科技edge BMC首秀2024英特尔网络与边缘计算行业峰会

芯海科技edge BMC首秀2024英特尔网络与边缘计算行业峰会

【《计算》阅读体验】量子计算

英特尔推出集成光学计算互联OCI Chiplet芯片

英特尔实现光学IO芯粒的完全集成

英特尔集成光电、量子计算等五大领域前沿研究及其科研成果

英特尔集成光电、量子计算等五大领域前沿研究及其科研成果

评论