“不管是在今天 GPU 能够做的事情上,还是 GPU 不能做的事情上,IPU 都有它的价值点和价值定位。” 日前,在英国 AI 芯片初创公司 Graphcore 中国区的媒体沟通会上,Graphcore 高级副总经理兼中国区总经理卢涛和 Graphcore 中国工程总负责人、AI 算法科学家金琛,就 Graphcore 的新产品性能以及该公司在中国的落地策略向 DeepTech 等媒体进行了同步。

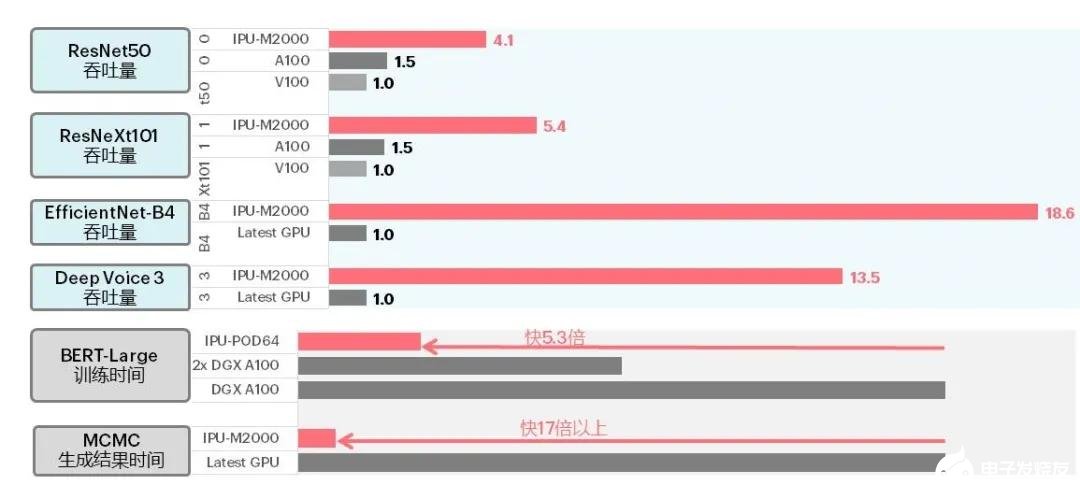

沟通会上,Graphcore 解读了其于本月公布的大规模系统级产品 IPU-M2000 的应用测试数据。公布数据显示,在典型 CV 模型 ResNet、基于分组卷积的 ResNeXt、EfficientNet、语音模型、BERT-Large 等自然语言处理模型以及 MCMC 等传统机器学习模型中,IPU-M2000 在吞吐量、训练时间和学习结果生成时间方面都有较好表现。比如,在 IPU-M2000 上 EfficientNet 的吞吐量达到 A100 的 18 倍。

图 | IPU-M2000 与 GPU 的吞吐量、训练及结果生成时间对比(来源:Graphcore)

此前,IPU-M2000 与 Graphcore 第二代 IPU 处理器 GC200 已于今年 7 月 15 日发布。据介绍,GC200 芯片基于台积电的 7nm 工艺制造,集成 250 TFlops AI-Float 算力和 900MB 处理器内存,相较第一代产品性能提升 8 倍。而对于第三代 IPU,卢涛在此次沟通会上并未透露发布的具体时间表,不过他表示下一代产品正在研发中,将依旧重点解决存储问题。

支持 PyTorch、TensorFlow,在 IPU 与 GPU 间无缝衔接

另外,Graphcore 还发布了 Poplar SDK 1.4 版本和 PyTorch 的 IPU 版本。

Graphcore 对 Poplar SDK 1.4 版本在易用性和速度上进行了优化,能够支持模型和数据并行,同时能够实现模型的横向扩展 —— 从 1 个 IPU 横向扩展到 64 个 IPU。金琛表示,下一版本的 Poplar SDK 有望实现横向扩展到 128 个 IPU。

值得关注的是,除支持 Graphcore 的自研框架 PopART 外,Poplar SDK 1.4 还支持 Facebook 的 PyTorch 框架、以及 Google 的 TensorFlow 框架。

据金琛介绍,Graphcore 在 PyTorch 代码中引入了 PopTorch 轻量级接口,通过这一接口,用户可基于当前的 PyTorch 模型进行封装,以实现 IPU 和 CPU 之间的无障碍衔接。

对于实现这一功能的核心技术,金琛做进一步解释说,Graphcore 采用 PyTorch 里的 jit.trace 机制对计算图进行编译,转化为 IPU 和 PyTorch 兼容的表达格式,最后用 Graphcore 自研框架 PopART 后端的 audiff 功能自动生成反向图,便可以实现同一个模型在不同平台的无差别运行。

目前,PyTorch 因其直观易懂、灵活易用等优势受到开发者的广泛喜爱和应用。Poplar SDK 1.4 增加了对 PyTorch 的支持,策略上是希望用户在 IPU 上也能体验 PyTorch,让用户多一个转战 IPU 的理由。不过目前英伟达的 GPU 已经在 AI 计算领域占据大部分市场,此时 IPU 能够提供的价值、转场到 IPU 的成本等,都是用户所要考虑的问题。

在迁移成本上,卢涛表示,经过几年来对 Poplar SDK 的打磨,现在从 GPU 到 IPU 的软硬件迁移难度已经比大家认为的小得多。

金琛补充道,在训练上,针对一个不太复杂的模型,一般一周可以迁移完成,对于复杂的模型大概需要两周;在推理上,基本上是 1-2 天的工作量。

谈及性能,卢涛表示:“IPU 在训练推理、语音、图像模型处理上基本全面超越 GPU。” 不过他也坦言:“不能说 100% 超越了 GPU,因为算法模型确实非常多,比如说语音有不同的语音模型、图像也是有不同的图像模型。”

未来:持续优化性能,进一步压缩迁移成本

IPU 在机器学习性能上的明显优势是不可否认的,但前有身强体壮且努力奔跑的巨头英伟达,Graphcore 更是一刻也不容懈怠。卢涛在沟通会上也多次提到,“目前 Graphcore 面对的压力最主要还是来自英伟达”。

“重压” 之下,Graphcore 短期内的计划是聚焦在数据中心高性能训练和推理市场上,持续打磨 IPU 和软件平台,持续优化性能和提高可用性。卢涛说,“只有在我们聚焦的领域跑得更快,Graphcore 和英伟达之间的距离才会越来越短,甚至在某些领域超过英伟达”。

他还表示,Graphcore 希望未来数年内,能在数据中心的 AI 训练、推理批量部署、以及发货和体量上做到除英伟达以外的另一个头部地位。

为实现该目标,Graphcore 也将从增加 AI 框架支持、以及模型覆盖两个维度着手,以期进一步减少用户的迁移成本。此外,除目前 AI 应用最广泛的互联网和云计算两个场景外,卢涛表示公司明年还将在金融、汽车、智慧医疗、智慧教育、智慧城市和政府服务等领域,至少突破一到两个比较主流的领域。

责任编辑:PSY

-

gpu

+关注

关注

28文章

4700浏览量

128679 -

数据中心

+关注

关注

16文章

4673浏览量

71944 -

IPU

+关注

关注

0文章

34浏览量

15546

发布评论请先 登录

相关推荐

超云亮相2024数据中心标准大会,展示AI全栈推理硬件创新成果

华迅光通AI计算加速800G光模块部署

SK电讯将与Lambda合作打造AI数据中心

AI时代,我们需要怎样的数据中心?AI重新定义数据中心

英伟达数据中心GPU出货量飙升,市场份额持续领跑

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

AI推理,和训练有什么不同?

AI训练,为什么需要GPU?

Meta将于今年在数据中心部署新款定制AI芯片

微模块数据中心的优势

Microchip CEO博文《AI将如何重新定义数据中心?》

IPU 与 GPU 间无缝衔接,未来聚焦数据中心的AI训练和推理部署

IPU 与 GPU 间无缝衔接,未来聚焦数据中心的AI训练和推理部署

评论