2020年即将结束,半导体产业今年都有哪些亮眼的成绩呢?今天我们就来盘点一下今年半导体产业十大先锋技术,一起来看看都有谁上榜:

台积电2nm工艺研发突破,或采用环绕栅极晶体管技术

9月,产业链消息,台积电2nm工艺的研发进展超出预期,甚至快于原计划。

2nm已极度接近当前半导体产业所采用工艺所能达到的极限,此前,在8月底举办台积电第26届技术研讨会上,台积电确认了其5nm工艺将在明年推出N5P增强版,更先进的3nm、4nm也一并被公布。此外,台积电还正式宣布建设新的研发中心,预计将投入8000多名工程师的人力到一条先进工艺生产线上,着力攻克2nm工艺。

据消息人士透露,台积电的2nm工艺不会继续采用成熟的鳍式场效应晶体管技术(FinFET),而会采用环绕栅极晶体管技术(GAA)。

在3nm工艺节点上,台积电选择了采用FinFET而放弃了GAA,三星却在3nm工艺上一直坚持着GAA路线,台积电率先来到2nm工艺路口,其作出的选择也基本意味着接下来半导体行业整体的到前进方向。

晶体管技术的演化与半导体产业发展进程息息相关,晶体管中一个重要影响因素就是场效应,是指通过施加一个电场来实现对电流的控制,所以也就有了场效应晶体管(Field-Effect Transistor,FET)一说。

FinFET就是源自于场效应晶体管,在FinFET的架构中,闸门的形状类似鱼鳍的叉状3D架构。这种设计可大幅改善电路控制并减少漏电流,也可大幅缩短晶体管的栅长。

然而,芯片工艺节点发展到5nm之后,FinFET开始面临一系列难题。随着栅线之间间距的减小,以往在一个单元内填充多个鳍线的做法已不再现实,而栅线间距的减小还会导致FinFET的静电问题大大加剧并直接制约晶体管性能的提升,FinFET的出现虽然突破了平面晶体管的短沟道效应限制让电压得以降低,但在理想情况下沟道应该被栅极完全包围。因此,在5nm之后,业界迫切需要一个新的结构来替代鳍式晶体管结构,这就带来了全环绕栅极晶体管,也就是GAA。

然而,受限于摩尔定律等因素,采用GAA结构也需要满足一些条件,如:1、需要的生产工艺应与FinFET相似,从而让现有设备继续发挥作用;2、应实现对通道更好的控制,例如栅极与通道之前的接触面积更大;3、带来的寄生电容和电阻问题应得到显著改善。

以台积电2nm的研发进度来看,预计台积电2023年下半年可望进入风险性试产,2024年正式量产。

编辑点评:台积电已长期占据晶圆代工产业的制高点,按目前的进展看,它还将保持相应优势至少好几年。2nm之后,业界就面临着在商业而不是科研领域让挑战传说中的1nm硅材料技术极限的重大考验。这场大考将如何重塑产业生态呢?目前我们还难以预判。但对于中国大陆而言,最领先的企业中芯国际,本就是一个技术水平相比行业领先者落后好几代的追赶者,在美国「实体清单」制裁的阴影下,这场大考,是会给中国大陆相关企业带来「弯道超车」的机遇呢?还是进一步拉大与行业领先者的距离呢?

植入式芯片的未来:马斯克展示“活猪注入芯片”

今年8月29日,“钢铁侠”马斯克又完成了一项常人难以完成的“壮举”,他在15万直播用户的围观下,通过无线装置连接植入猪大脑中的芯片,实时监控猪的大脑活动。

脑机接口公司Neuralink朝一只名叫格特鲁德的小猪身上被植入了Link V0.9,当马斯克抚摸格特鲁德的鼻子时,在电脑上呈现了数据化的信息状态,当格特鲁德围绕着一支笔嗅来嗅去时,同样可以看到设备传输出来的数据,显示小猪脑部活动情况。这背后所蕴含的技术,是通过让大脑和计算机之间建立数字连接,从而产生相应的电极信号并让小猪大脑活动可视化呈现。

重点在于,植入脑机接口手术的小猪与未植入设备的猪没有什么两样。而植入式芯片Link V0.9大小约为一枚硬币,直径23mm,厚度8mm,可采集传输上千(1024个)通道的神经放电信号,拥有全天续航能力,支持远程数据传输,可感知温度、压力等数据。其植入方式与传统的医院手术开刀不同,Link V0.9的植入全程由自动化机器人完成,无需麻醉,耗时不到一小时。

据Neuralink介绍,他们最初希望利用这项技术帮助瘫痪患者控制自己的电脑和智能手机。下一步,该技术可以用于治疗脑疾病患者,如帕金森氏症,以及应对大脑和脊髓损伤或治疗自闭症和肌萎缩性侧索硬化症(ASL)等疾病。

编辑点评:目前,人们已经看到了植入芯片带来的科技价值,但最重要的是,人们自身愿不愿意接受体内植入芯片?周围一起生活的人又能否接受植入芯片的人?另一方面,即使很多植入人体的芯片都经过了严格的组织相容性实验,对材料有特殊的要求,但依然不能保证百分之百的安全。到底芯片植入大脑,是不是解决部分脑部相关疾病的最佳手段,或许要等到马斯克下一阶段的实验才能见得分晓。

ASML 研发下一代 EUV ***:分辨率提升70% 逼近 1nm 极限

像台积电在晶圆代工领域的地位,在***领域,荷兰ASML公司也占据了行业鳌头。

进一步的,在当前市场上最先进的EUV***领域,ASML更是独上了这块细分市场。2019年,ASML出货26台EUV***,为半导体产业探索更先进制程工艺量产的行动提供了强有力后盾。

3月,据媒体报道,ASML公司正在研发新一代EUV***,预计将在2022年开始出货。据ASML此前公布的报告,在2019年出货26台EUV***的基础上,预计2020年将交付35台,2021年则会达到45-50台的交付量,是2019年的两倍左右。

ASML出货的EUV***主要还是以NXE:3400B及改进型的NXE:3400C为主,两者基本结构相同,但NXE:3400C采用模块化设计,维护更加便捷,平均维修时间将从48小时缩短到8-10小时,支持7nm、5nm。

此外,NXE:3400C的产能也从之前的125WPH(每小时处理晶圆数)提升到了175WPH。

不论NXE:3400B还是NXE:3400C,都还是第一代EUV***,主要特点是物镜系统的NA(数值孔径)为0.33。

ASML披露他们在研发新一代EUV***EXE:5000系列,NA指标达到了0.55,主要合作伙伴是卡尔蔡司、IMEC比利时微电子中心。与之前的***相比,新一代***意味着分辨率提升了70%左右,可以进一步提升***的精度,毕竟ASML之前的目标是瞄准了2nm甚至极限的1nm工艺的。

编辑点评:新一代EUV***预计至少到2022年才能出货,大规模出货要到2024年甚至2025年,届时,台积电和三星按预期也应该在推进3nm及以下制程工艺的生产了。

半导体产业链很长,但每一项巨大进步背后都是产业链各环节大量小进步积累的结果。***是半导体产业非常重要且关键的一个环节,它的进步对于整个产业整体的进步非常重要。

全国首台亿级神经元类脑计算机发布

9月1日,浙江大学联合之江实验室在杭州发布一款包含1.2亿脉冲神经元、近千亿神经突触的类脑计算机Darwin Mouse。

这是我国第一台基于自主知识产权类脑芯片的类脑计算机,该计算机使用了792颗由浙江大学研制的“达尔文二代”类脑芯片,支持1.2亿脉冲神经元、近千亿神经突触,神经元数量规模相当于小鼠大脑,典型运行功耗只需要350-500瓦。值得一提的是,Darwin Mouse也是目前国际上神经元规模最大的类脑计算机。

研究团队还针对类脑计算机研发出了专用的操作系统——达尔文类脑操作系统(DarwinOS),实现对类脑计算机硬件资源的有效管理与调度,支撑类脑计算机的运行与应用。

这台类脑计算机展示了统一调度多个机器人抗洪抢险场景下的协同工作。3台机器人可分别承担巡逻、抢险、营救任务。还展示了听歌识曲、记忆语音、意念打字等功能。

编辑点评:由于类脑芯片巨大的发展潜力和广阔的市场前景,类脑智能技术已成为各国科技战略重点和力推的核心科技发展领域。随着美日德英等发达国家类脑研究发展战略的出台,中国的类脑科学研究项目也已经正式启动。但是类脑研究需要基于对人类大脑的深入认知,虽然近10年来,人们对这个大脑这个神秘器官的认知迅速增长,但大脑的终极奥秘依然是一个谜团。

总而言之,尽管当前类脑芯片无论在规模还是智力上与真实的人脑仍存在很大差距,但是它也具备人脑无法企及的优势。如今,全世界类脑科学研究的新赛道已经形成,相信接下来会涌现出不少颠覆性理论和革命性技术成果。

英国研发新一代革命性内存技术:10ns延迟、功耗仅有1%

2020年1月下旬消息,美光、三星等公司年内会推出新一代的DDR5内存,最高速率可达6400Mbps,将逐步取代DDR4内存。

然而,尽管现今的DRAM内存技术一直在做技术升级,但其技术瓶颈也日益显现。

科研人员正在寻找新的替代性内存技术,英国科研人员的这种研究成果,或许将是内存产业的未来新方向——延迟可低至10ns,功耗仅为现有技术的1%。

业界一直在寻求完美的「内存」芯片——低延迟、高带宽、功耗低、容量大,成本低,同时,不能因断电而损失数据……Intel的傲腾内存基于PCM相变内存技术,在可靠性、延迟等方面已大幅领先现今的闪存,更接近DRAM内存芯片了,但超越内存还达不到。

据外媒报道,英国的研究人员找到了一种新型的「内存」,使用的是III-V族材料,主要是InAs砷化铟和AlSb锑化铝,制成的NVDRAM非易失性内存具备优秀的特性,在同样的性能下开关能量低了100倍——即功耗只有现有DRAM内存的1%,同时,其延迟可低至10ns。

编辑点评:这种新型材料制成的内存芯片宣称具备三大特性——超低功耗、写入不破坏数据、非易失性。虽然其性能相比现今DRAM内存并没多大提升,10ns级延迟也与DDR4内存差不多,但三大特性,尤其是非易失性,即足以掀起「内存」革命了。

当然,作为理论性的科研,英国研发人员暂时还只是找到了新一代III-V材料内存的理论方向,真正大规模商业生产的时候还难以预见,甚至最终是否会是这种技术打败其他技术实现落地量产也不一定……

超级存储?新技术让存储芯片容量提高上千倍

让存储芯片容量提高1000倍的超级存储技术要来了?

8月,韩国技术信息部宣布,该国UNIST 能源与化学工程学院李俊熙教授带领的研究团队,提出了一种新的物理现象,利用FRAM(铁电体存储器)技术,可以替代当前主流的DRAM或NAND闪存,有望将指甲大小的存储芯片存储容量提高1000倍。

据介绍,FRAM技术通过极化现象来存储信息,其中电偶极子(如铁电内部的NS磁场)被外部电场对准。通过向铁电体物质氧化铪(HfO2)中施加3-4V的电压,可以让原子间的力量断裂,每个原子都可以自由移动,从而可以控制四个单独的原子来存储1位数据。现有的存储技术研究显示,最多只能在数千个原子的组中存储1位数据。因此,通过FRAM技术可以让半导体存储器存储容量达到500 Tbit/cm2,是当前可用闪存芯片的上千倍。理论上,线幅也可被缩小至0.5nm。

李俊熙教授表示:「在原子中储存信息的技术,在不分裂原子的情况下成为半导体产业终极储存技术的几率很高。」虽然还处在实验室阶段,但这项研究也普遍被业界看好,最大的原因在于FRAM是当前已经存在的半导体材料,被认为商用化的可能性非常高。

资料显示,FRAM中的F即Ferromagnetic,FRAM即「铁电体随机存取存储器」。

FRAM实现数据存储的原理是利用铁电晶体的铁电效应,「铁电效应」指,在铁电晶体上施加一定的电场时,晶体中心原子在电场的作用下运动,并达到一种稳定状态。当电场从晶体移走后,中心原子会保持在原来的位置。由于晶体的中间层是一个高能阶,中心原子在没有获得外部能量时不能越过高能阶到达另一稳定位置,因此FRAM保持数据不需要电压,也不需要像DRAM一样周期性刷新。

编辑点评:随着市场需求的增加,用户也对企业级存储系统的访问性能、存储协议、管理平台、存储介质以及其他各种应用配置提出了更高的要求。尤其是以云计算、大数据为主要业务的企业,在存储芯片、设备、系统等方面将迎来更多的选择。

超级存储技术区别于传统的闪存或DRAM,预计将更多的被用在移动计算、航天航空、军事应用、企业系统、汽车行业、物联网以及工业市场等。基于超级存储技术,最普通的设备也有望达到T级别的数据容量,大大方便人们的存储需求。

与此同时,超级存储技术还涉及到存储和数据容灾、虚拟化、数据/安全/压缩、重复数据删除、自动精简配置等功能特性,这些方面完善和优化都需要占用不少能耗资源,如何在满足超大存储的同时,实现低功耗、多功能等特性,是存储产业的重要努力方向。

Nature:芯片散热技术重大创新,冷却性能增加 50 倍

芯片散热问题在一定程度上能够反映出芯片的能耗水平,高速的运算产生的热量如果无法及时散发出去,就会对芯片性能造成严重影响。电脑中可以为CPU配备一个小风扇进行散热的,但是在5G行业,传统数据中心需要将30%至40%的能耗花费在冷却散热上,要消耗大量的能源和水资源。如何解决芯片散热问题成为了业界广为关注的话题。

(截图自Nature)

今年9月9日,瑞士洛桑联邦理工学院的 Elison Matioli 教授及其研究团队在Nature上发表了一项最新研究成果,在芯片冷却技术方面实现了新突破。研究人员使用微流体电子协同设计方案,在同一半导体的衬底内将微流体和电子元器件进行协同设计,生产出一个单片集成的歧管微通道冷却结构,可以有效地管理晶体管产生的大热通量。

研究人员开始探索使用冷却剂与设备直接接触的方式,来实现更高的冷却性能。他们提出在具有外延层的单晶硅衬底上设计的单片集成的多歧管微通道(mMMC)散热器。由于器件的设计和散热器的制造是在同一过程中结合在一起,冷却通道直接嵌入在芯片的有效区域下方。因此冷却剂可以直接撞击热源,提供局部和有效的散热。

结果显示,该冷却结构仅使用 0.57 瓦/平方厘米的泵送功率,就可以输送超过 1.7 千瓦/平方厘米的热通量,其冷却效果超出当前所使用的结构的效果。

编辑点评:近年来,研究人员开始探索将液体冷却模块直接嵌入芯片内部,以实现更加高效的制冷效果的新技术,但这一技术仍未解决电子设备和冷却系统分开处理的困境,从而无法发挥嵌入式冷却系统的全部节能潜力。而mMMC这种冷却技术能够设计出更加紧密的电子设备,并大大减少全球因系统冷却而消耗的能源。显然,这项设计可以直接去除当前数据中心对于大型外部散热器的需求。

首次突破1开尔文!Intel掌握「热」量子计算机技术

4月,Intel与其合作伙伴QuTech在权威学术杂志《自然》上发布了一项全新的研究成果——「热」量子计算机技术。

该技术据称可在温度大于1开尔文的情况下,成功控制「热」量子计算的基本单位。

提高量子计算的工作温度对于将其扩展应用到更多的应用领域非常重要。

量子比特对应经典的计算比特,可以通过超导电路实现或在半导体(比如硅)内形成。存储在这种量子比特中的信息通常会很快丢失,因为热量产生的振动会干扰量子比特,进而影响性能,要解决这种问题,就需要在接近绝对0度的环境下进行,要创造这种环境,需要投入大量费用用于制冷。

Intel成功实现了在1.1开尔文温度的「热」环境下运行量子电路的成就,在运行温度上的要求比以往更宽松,更易实现。

据悉,这项研究把限制在硅中的电子自旋作为量子比特,并与周围能在超过1开尔文温度下正常运作的材料很好地隔离开来。在这个温度下,可以引入定域电子来操控量子比特,研究人员认为,这是将这类量子处理器扩展至百万量子比特的先决条件。

尽管此次升温幅度不大,但这是量子计算机技术一个重要的里程碑,因为温度提升至1开尔文以上后,搭建平台的成本将大幅降低,这有助于量子计算机技术的进一步研发普及。

据悉,Intel的这项研究建立在推进全栈量子系统开发方向持续工作的基础上,包括去年年底推出的首款马脊低温量子控制芯片。

编辑点评:今年12月,中科大宣布,该校潘建伟等人成功构建了76个光子的量子计算原型机「九章」,求解数学算法高斯玻色取样(Gaussian Boson Sampling)只需200秒。2019年9月,Google悬铃木量子计算机的实现「量子优越性」的消息也早已传开。

量子计算的种种美好前景,需要更多企业、机构参与进来,一步步克服各种困难,才有希望实现。

芯片上的“大脑”:麻省理工人工大脑突触研发新进展

今年6月,麻省理工学院(MIT)的研究人员发表了关于新型人工大脑神经突触的论文,其中提到与目前已有的人工突触相比,这种突触在性能上有很大提升,它的物理体积比一片纸屑还小,却可以容纳数以万计的硅基元件。在体积小且节能的同时,新型芯片有助于研究人员开发出能够在不连接数据中心的情况下,也可以执行复杂AI计算任务的设备。

在研究中展示了一种新颖的“忆阻器”(Memristors)设计,其本质上是用硅来模拟大脑的信息传输突触,但也可以用银和铜的合金。这种芯片能够有效地“记住”并重现出非常详细的图像,与已有的同类型技术相比,它能“记住”的图像更加清晰和详细。

据悉,MIT研发的芯片,其包含的忆阻元件在表示信息时更像是大脑,也就是最原始的模拟计算机。大脑和计算机在处理和表达信息时虽然有相似之处,但有些神经元的信息输出是通过分级的电信号传输的,其大小可以连续变化,可以比晶体管采用的数字信号传输出更多的信息。忆阻元件还可以记住特定的状态,之后在多次接收相同的输入电流时,很轻易就能重现相同的信号。

此外,冶金学也为研发团队提供了不少灵感。在冶金学中,当冶金学家想改变一种金属的性能时,他们会把它与另一种具有所需性能的金属结合,制造出一种合金。受此启发,研究人员也发现一种可以与被用来作为忆阻器正极的银相结合的元素,从而使其能够更稳定地沿着非常薄的传导通道传递离子。这就是芯片研发的关键所在。

不仅能够倚靠“记忆”准确地重现图像,也可以执行推断任务,比如基于命令提高或模糊原始图像,这块芯片的表现性能要远远优于之前研发出的其他记忆电阻器。

编辑点评:虽然新型人工突触的研发还有很长的路要走,但是MIT的研究必定会促进便携式人工大脑计算机的出现。人工大脑计算机最大的好处就在于,可以像目前的超级计算机一样执行非常复杂的任务,但是却不需要任何网络连接。

中科院低维半导体技术:纳米画笔“画”芯片

今年3月,中科院宣布研发出了一种简单的制备低维半导体器件的方法——用“纳米”勾勒未来光电子器件,它可以“画出”各种需要的芯片。

中科院表示,可预期的未来,需要在更小的面积集成更多的电子元件。针对这种需求,厚度仅有0.3至几纳米(头发丝直径几万分之一)的低维材料应运而生。

这类材料可以比作超薄的纸张,只是比纸薄很多,可以用于制备纳米级别厚度的电子器件。由于二维材料如同薄薄的一张纸,它的性质很容易受到环境影响。利用这一特性,研究人员在二维材料表面覆盖一层铁电薄膜,使用纳米探针施加电压在铁电材料表面扫描,通过改变对应位置铁电材料的性质来实现对二维材料性质的精准操控。

当设计好器件功能后,科研人员只需发挥想象,使用纳米探针“画笔”在铁电薄膜“画布”上画出各种各样的电子器件图案,利用铁电薄膜对低维半导体材料物理性质的影响,就能制成所需的器件。

实验中,“画笔”是原子力显微镜的纳米探针,相当于传统晶体管的栅电极,可以用来加正电压或负电压。但不同于传统栅电极,原子力显微镜的针尖可以任意移动,在水平空间上可以精确“画出”纳米尺度的器件。

在这个过程中,研究人员通过控制加在针尖上电压的正负性,就能轻易构建各种电子和光子器件,比如存储器、光探测器、光伏电池等等。

据悉,本研究由中国科学院上海技术物理研究所与复旦大学、华东师范大学、南京大学,中国科学院微电子研究所等多个课题组合作完成。研究成果已于2020年1月24日发表于《自然-电子学》。

编辑点评:“神笔马良”的故事想必大家都听过,如今随着技术的发展,人们对半导体技术的要求越来越高,但是半导体制造难度却是越来越大,10nm以下的工艺极其烧钱,芯片制造若是迎来这根“神笔”,或许也是一大福音。

责任编辑:xj

-

芯片

+关注

关注

455文章

50786浏览量

423459 -

半导体

+关注

关注

334文章

27346浏览量

218474 -

晶圆

+关注

关注

52文章

4908浏览量

127964

发布评论请先 登录

相关推荐

基本半导体荣获2024年深圳市充电设施十大先锋应用

逐点半导体熊挺:AI技术赋能视觉处理,空间视频未来可期

村田(中国)投资有限公司副总裁桥本武史:展望2025年半导体产业新趋势

2024年半导体IPO:关键词是什么?

中国半导体的镜鉴之路

国内半导体封装测试企业盘点,长电华润微万年芯在列

喜讯 | MDD辰达半导体荣获蓝点奖“最具投资价值奖”

度亘核芯荣获“2023年度中国十大光学产业技术”奖

2023年半导体行业收益超出预期,2024年预期增长24%

并购、扩产、合作——盘点2023年全球第三代半导体行业十大事件

2023年半导体设备国产化成绩单:亮点与期待

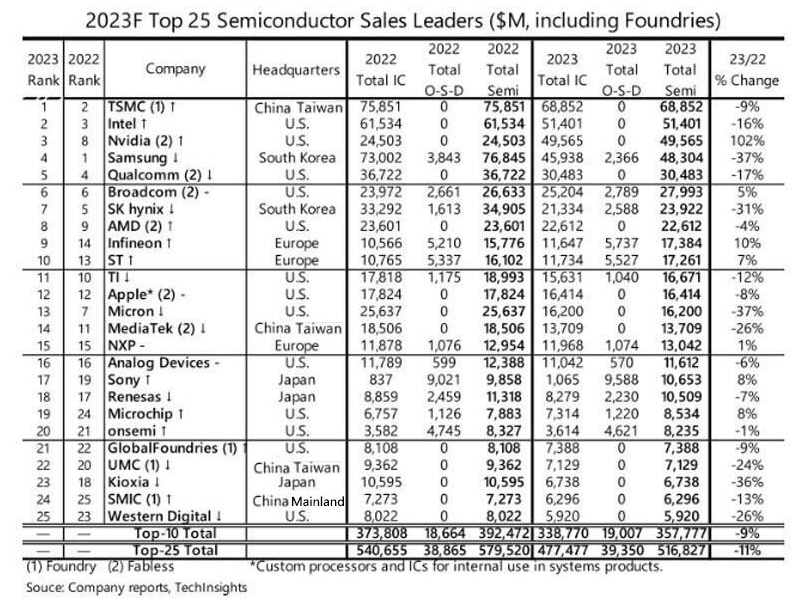

2023年半导体企业销售业绩排名

Transphorm:氮化镓应用进一步扩展,2024年下半年半导体市场将回暖

盘点2020年半导体产业十大先锋技术

盘点2020年半导体产业十大先锋技术

评论