这是一篇关于实体关系联合抽取的工作。关于现有的联合抽取工作,作者提出了两点不足之处:

Feature Confusiong: 用于同样的特征表示进行NER和RE(关系分类)两项任务,可能会对模型的学习造成误解;

现有的基于Table-Filling方法去完成联合抽取的工作,会将表结构转化成一个序列结构,这样导致丢失了重要的结构信息。

因此本文的工作有以下特点:

针对NER和RE,分别学习出不同的序列表示(sequence representations)和表格表示(table representations); 这两种表示能分别捕获任务相关的信息,同时作者还涉及了一种机制使他们彼此交互;

保持表格的结构,通过神经网络结构来捕捉二维表格中的结构信息;同时,引入BERT中的attention权重,进行表格中元素表示的学习。

模型的核心部分包括以下模块:

Text Embedding: 对于一个输入的包含n个words的句子,其词向量、字符向量和BERT词向量的共同构成了每个word的表示。

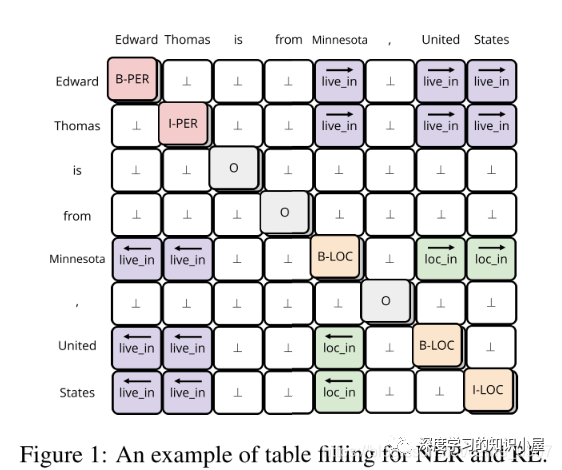

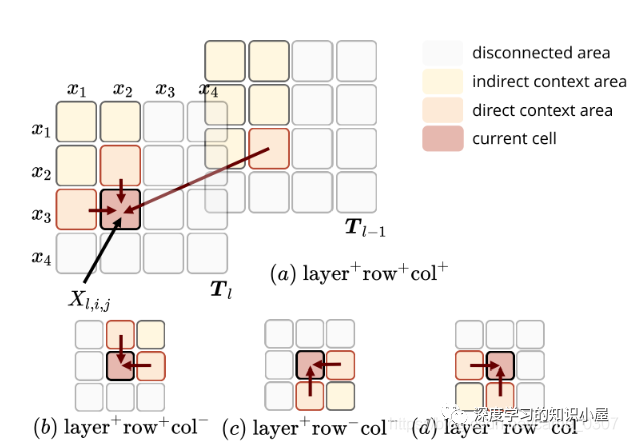

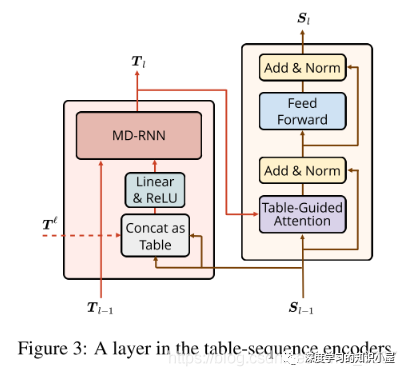

Table Encoder: 目标在于学出 N×N 表格下的向量表示,表格第i行第j列的向量表示,与句子中的第i个和第j个词相对应,如Figure1所示。文中使用基于GRU结构的MD-RNN(多维RNN)作为Text Encoder,在更新表格中当前cell的信息时,通过MDRNN融合其上下左右四个方向上的信息,从而利用了表格的结构特点;同时引入当前cell所对应的两个词在Sequence Encoder下的表示,使得Table Encoder和Sequence Encoder之间发生信息的交流;

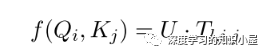

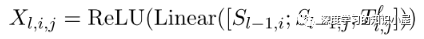

Sequence Encoder: Sequence Encoder的结构与Transformer类似,不同之处在于将Transformer中的scaled dot-product attention 替换为文中提出的 table-guided attention。具体地,将Transformer中计算Q,K之间分值的过程直接替换为对应两个word在table中对应的向量:

由于 T_ij 融合了四个方向上的信息,能够更加充分的捕捉上下文信息以及词与词之间的关系,同时也使Table Encoder和Sequence Encoder之间产生了双向的信息交流。

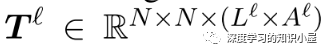

Exploit Pre-trained Attention Weights: Text Embeddings部分有用到BERT,因此将BERT中各个层上多头attention每个头上的atention权重堆叠起来,得到张量T l ∈ R N × N × ( L l × A l ) T^{l} in mathbb{R}^{N imes N imes (L^l imes A^l)} T和 Text Embedding中每个词的表示,来构成Table的初始输入:

作者通过在不同数据集上的实验证明了模型的有效性,并通过消融实验进行了相关的分析。

责任编辑:xj

原文标题:【EMNLP2020】用填表的方式进行实体关系联合抽取

文章出处:【微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

-

自然语言处理

+关注

关注

1文章

620浏览量

13665 -

nlp

+关注

关注

1文章

489浏览量

22126

原文标题:【EMNLP2020】用填表的方式进行实体关系联合抽取

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

求助,使用ADS8326IDGKT遇到的疑问求解

PIC单片机的优势和不足之处

nlp逻辑层次模型的特点

nlp神经语言和NLP自然语言的区别和联系

nlp自然语言处理框架有哪些

nlp自然语言处理的主要任务及技术方法

nlp自然语言处理模型怎么做

nlp自然语言处理的应用有哪些

NLP技术在人工智能领域的重要性

什么是自然语言处理 (NLP)

特斯拉频繁调价,马斯克解释传统经销商模式价格不稳

UART转RS485电路的不足之处

汽车转向器轴承滑动力测试深度解析

NLP:现有联合抽取工作的不足之处

NLP:现有联合抽取工作的不足之处

评论