01

—

研究动机

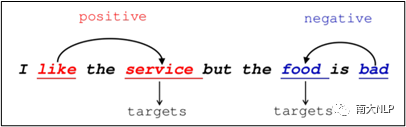

方面级情感分类(英文叫Aspect-level Sentiment Classification,简称ASC)旨在检测句子中给定意见目标的情感极性。意见目标(也称为方面术语)是指评论中描述实体方面的单词或短语。如图1所示,"服务很好,但食物却很糟糕"这句话包含两个意见目标,即"食物"和"服务"。用户对目标"服务"的看法是正面的,而对目标"食物"的看法却是负面的。

图1: 包含多个意见目标的句子示例

从上面的例子中我们可以看到,一个句子有时会包含多个意见目标,并且它们可能表达不同的情感极性,因此ASC的一个主要挑战是如何为不同的意见目标获取到不同的情感上下文。为此,大多数方法运用注意力机制(Bahdanau et al., 2014)来捕获与给定目标相关的情感词,然后将其汇总以进行情感预测。尽管注意力机制是有效的,但我们认为由于ASC标注数据是有限的,因此它未能充分发挥注意力机制的潜力。众所周知,深度学习的结果很大程度上取决于训练数据的多少。但是,在实际情况中,ASC数据的注释费时且昂贵,因为注释者不仅需要识别句子中所有的意见目标,而且还需要判断其相应的情感极性。注释困难导致现有公开的数据集都相对较小,这严重限制了注意力机制的潜力。

尽管缺少ASC数据,但是在线评论网站(例如Amazon和Yelp)可以提供大量的文档级情感分类(DSC)标记数据。这些评论中包含了大量的情感知识和语义模式。因此,一个有意义但具有挑战性的研究问题是如何利用资源丰富的DSC数据来提升低资源任务ASC。为此,He et al. (2018) 设计了PRET + MULT框架,通过共享浅层的embedding嵌入和LSTM层将情感知识从DSC数据传递到ASC任务。受胶囊网络的启发(Sabour et al., 2017),Chen and Qian (2019)提出TransCap模型,它共享底部的三个胶囊层,然后仅在最后一个ClassCap层中分离了两个任务。从根本上说,PRET + MULT和Transcap通过共享参数和多任务学习来提升ASC,但是它们不能准确地控制和解释要传输的知识。

为了解决上述提到的两个问题,在这项工作中,我们提出了一种新颖的框架,即注意力转移网络(ATN),它从DSC任务中显式的转移注意力知识,以提高ASC任务中意见目标的注意力能力。与PRET + MULT和Transcap相比,我们的模型获得了更好的结果并保留了良好的可解释性。

02

—

解决方案

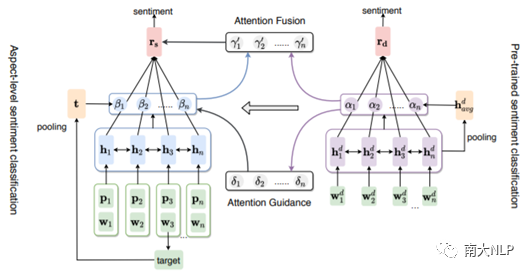

图1显示了注意转移网络(ATN)的总体组织结构。在ATN框架中,我们分别采用了两个基于注意力的BiLSTM网络作为DSC和ASC的基础模块,并提出了两种将DSC中的注意力知识迁移到ASC的新方法。

图2: 注意力迁移网络(ATN)的整体架构

第一种迁移方法称为注意力引导。具体来说,我们首先在大规模的DSC数据集上预训练一个基于注意力的BiLSTM网络,然后利用DSC模块中的注意力权重作为学习信号来引导ASC模块更准确地捕捉情感线索,从而取得很好的结果。注意力引导通过辅助监督信号学习DSC模块的注意力能力,但是,它不能在测试阶段利用DSC模块的注意力权重,并且浪费了预先训练的知识。为了充分利用额外的注意能力,我们进一步提出了注意力融合方法来直接将它们合并。

这两种方法虽然工作方式不同,但是都有各自的优点。注意力引导的目的是学习DSC模块的注意力能力,由于在测试阶段不使用DSC的外部注意力,因此具有更快的推理速度,而注意力融合可以利用DSC模块在测试阶段的注意力知识,做出更全面的预测。

03

—

实验

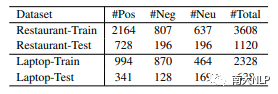

我们在SemEval 2014 Task 44 (Pontiki et al., 2014)的两个ASC基准数据集上评估了模型的性能。 它们分别包含来自laptop和restaurant领域的商品评论。我们在所有数据集中删除了极性冲突的样本。ASC数据集的统计数据如表1所示:

表1:ASC数据集的统计信息

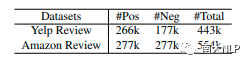

为了对DSC模块进行预训练,我们使用了两个DSC数据集,分别是YelpReview和AmazonReview(Li et al., 2018a)。DSC数据集Yelp Review包含的注意力知识迁移到ASC数据集Restaurant。而laptop的注意力知识来自AmazonReview。表2显示了它们的统计信息。在这项工作中,我们采用Accuracy和Macro-F1作为评估ASC任务中不同方法的性能指标。

表2:DSC数据集的统计信息

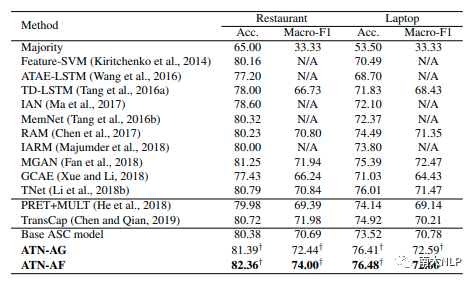

主要结果如表3所示。我们将结果分为三类:第一类列出了ASC任务的经典方法,第二类给出了两种基于迁移的现有方法,最后一类是我们的基础ASC模型和两个增强版本。我们分别使用ATN-AG和ATN-AF来表示使用了注意力引导和注意力融合的ATN。

表3:主实验结果(%)

我们的基础ASC模型-基于注意力的BiLSTM通过位置嵌入得到了增强,其性能优于某些基于注意力的模型(如ATAE-LSTM和IAN)。这个结果表明位置嵌入对于在ASC任务中建模目标信息是有益的。在此基础上,我们的注意力转移模型ATN-AG和ATN-AF在restaurant数据集上的Accuracy分别提高了约1%和2%,在laptop数据集上提高了2.8%。此外,它们超过了两种使用了转移知识的现有方法,即PRET + MULT和Transcap。

这些结果证明了我们提出的将注意力知识从资源丰富的DSC数据转移到ASC任务的有效性。与ATN-AG相比,ATN-AF在restaurant数据集上具有更好的性能。这是合理的,因为在测试阶段,ATN-AG无法利用DSC模块的注意力权重。尽管如此,ATN-AG仍在laptop数据集上获得了有竞争力的结果,并且推理速度比ATN-AF快。

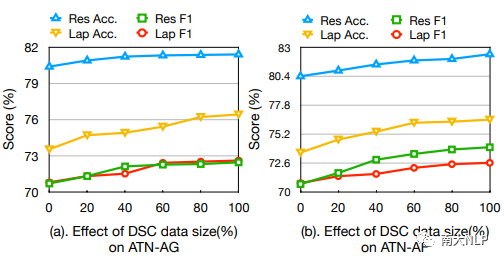

为了研究DSC数据集大小对我们方法的影响,我们将DSC数据的百分比从0%更改为100%,以报告ATN-AG和ATN-AF的结果。临界值0%和100%分别表示无DSC数据和使用完整的DSC数据集。结果如图2所示:

图3: 在不同百分比的DSC数据下ATN-AG和ATN-AF的性能

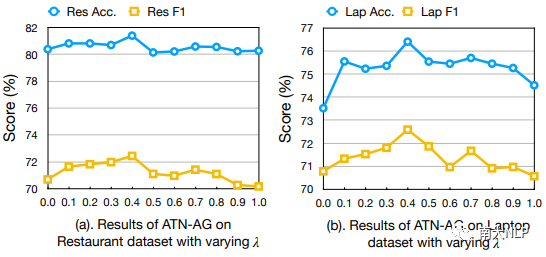

为了分析超参数λ对ATN-AG的影响,我们在[0,1]中对其进行调整以进行实验,步长为0.1。 图3显示了restaurant和laptop数据集上具有不同λ的ATN-AG的性能:

图4: 超参数λ对ATN-AG的影响

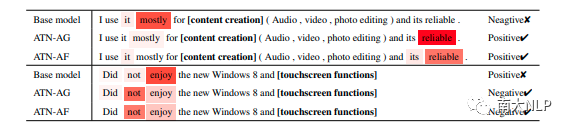

在ATN模型中,我们提出了注意力指导和注意力融合的方法,以帮助ASC模块更准确地捕获情感线索。为了验证这一点,我们分析了数十个测试集中的示例。与基础ASC模型相比,我们发现注意力转移方法可以处理低频情感词和诸如否定之类的复杂情感模式。表4显示了两个示例的注意力可视化结果以及在模型ATN-AG和ATN-AF下的相应情感预测。

图5: ATN-AG和ATN-AF的注意力可视化结果,较深的颜色表示较高的注意力权重

04

—

总结

标注数据不足会限制基于注意力的模型对ASC任务的有效性。 本文提出了一种新颖的注意力转移框架,其中设计了两种不同的注意力转移方法,以利用资源丰富的文档级情感分类语料库中的注意力知识来增强资源贫乏的方面级情感分类的注意力过程,最终达到改善ASC性能的目标。 实验结果表明,我们的方法优于最新技术。 进一步的分析验证了从DSC数据转移注意力知识到ASC任务的有效性和好处。

责任编辑:xj

原文标题:【COLING2020】面向方面级情感分类的注意力转移网络

文章出处:【微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

-

情感识别

+关注

关注

1文章

10浏览量

7550 -

自然语言

+关注

关注

1文章

287浏览量

13337 -

nlp

+关注

关注

1文章

487浏览量

22016

原文标题:【COLING2020】面向方面级情感分类的注意力转移网络

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

基于LSTM神经网络的情感分析方法

一种基于因果路径的层次图卷积注意力网络

BP神经网络在语言特征信号分类中的应用

nlp神经语言和NLP自然语言的区别和联系

nlp自然语言处理基本概念及关键技术

nlp自然语言处理的主要任务及技术方法

llm模型有哪些格式

NLP模型中RNN与CNN的选择

卷积神经网络在文本分类领域的应用

【大规模语言模型:从理论到实践】- 阅读体验

基于神经网络的呼吸音分类算法

纽约时报回应“黑客入侵”说:OpenAI试图转移公众注意力

工业级路由器如何网络过滤

理解KV cache的作用及优化方法

NLP:面向方面级情感分类的注意力转移网络

NLP:面向方面级情感分类的注意力转移网络

评论