进入2021年,随着越来越多的组织采用新技术,人工智能在技术和网络安全方面的未来将继续发展。根据最近的一项调查,三分之二的组织已经在将智能技术用于网络安全目的。使用这些工具可以使公司为使用网络犯罪技术而不断发展的创新攻击做好更充分的准备,也可以使用AI技术。例如,仅在去年,犯罪分子就使用了基于AI的软件来复制CEO的声音,要求现金转移220,000欧元(约合243,000美元)。

对于希望在2021年将更多的AI集成到其安全堆栈中的企业而言,遵循以下六个步骤以确保有效使用AI而不至于损害其他任何地方的安全至关重要。

鼓励将AI负责任地用于网络安全

最近的数据发现,四分之三的高管认为使用AI可使他们的组织对违规行为做出更快的响应。威胁形势继续迅速变化,网络安全领导者必须采用AI来应对网络犯罪分子制定的新策略。反过来,企业必须集中精力确保政策支持这种拥抱。例如,美国对AI计划的出口管制应确保企业在使用AI方面继续在全球网络安全市场中保持竞争力。

确保AI概念参与威胁建模和风险管理

AI的部署在全球范围内不断增长,已经有超过四分之一的AI计划已经投入生产,而超过三分之一的项目则处于高级开发阶段。但是,谨慎考虑攻击者可能如何试图破坏这种增长和新集成的AI系统的稳定性。尽管尚未广泛使用,但随着数据攻击被广泛采用,包括数据中毒攻击和训练模型后门在内的网络攻击可能会针对机器学习系统进行部署。结合了AI系统的威胁模型很少见,而且往往不成熟。业务领导者应努力开发方法,以确保AI处于风险管理活动范围之内,以最大程度地减少此类威胁。

制定和推广AI系统的道德准则

公共部门和私营部门都应在AI应用程序中使用道德准则,并鼓励在这些道德框架中纳入强大的安全性和透明度控制。有很多方法可以将AI应用于网络安全程序,并且重要的是要确保认可诸如Microsoft AI原则之类的框架。可以支持道德AI的原则包括:消除AI偏见,保护AI数据以及确保人们对AI技术如何影响世界负责。

支持透明度并公开分享新发现

有关AI的新研究以及新的对抗性攻击和防御经常在会议论文集和学术期刊上发表。但是,有时,这些贡献没有足够深入地解释如何得出这些发现,并且许多论文没有提供或链接到代码,这将导致结果的准确再现。同样,进行AI研究的企业通常是秘密进行的,这给AI进步的验证和实施带来了负担。这给安全从业人员提供了一个更具挑战性的环境,以评估针对这些模型的可能攻击,最终使企业更难应对这些威胁。

优先进行AI系统的进攻性研究

在将AI技术应用于产品之前,企业必须验证针对这些新技术的潜在风险。组织应确保AI应用程序和相关的机器学习系统对当前的安全程序监视和测试范围有意义。监视和测试应包括两家企业自发采取的措施,以支持发现可能未注意到的无法预料的AI缺陷,以及安全框架和指导以及与安全研究人员的合作。

敦促创建和整合隐私保护机器学习

尽管机器学习和AI技术继续变得越来越流行,但对隐私的影响尚待广泛探讨。特别是神经网络可以从训练数据中记住特定的例子。因此,AI系统可能容易受到模型反转攻击的攻击,这些攻击导致通过重复查询模型重新创建训练示例的方式,窃取了模型所训练的数据。如果模型是针对敏感数据进行训练的,则攻击者可能能够恢复有关训练数据的信息。隐私漏洞的风险不断增加,导致人们越来越需要采用和开发保留隐私的机器学习系统。这不仅可以保护业务,还可以保护使用数据来训练模型的消费者。

将AI集成到网络安全计划中并非易事。企业领导者必须认识到合并所带来的挑战,并开发解决方案以增强网络安全计划,同时保持道德并保护私有数据。负责任地使用人工智能技术,除了遵循明确的公共准则外,鼓励进行威胁建模和持续的人工智能研究是必不可少的步骤,这些步骤将在将AI集成到网络安全程序中时带来成功。

责编AJX

-

网络安全

+关注

关注

10文章

3159浏览量

59752 -

AI

+关注

关注

87文章

30887浏览量

269075 -

机器学习

+关注

关注

66文章

8418浏览量

132628

发布评论请先 登录

相关推荐

加密算法在网络安全中扮演什么角色?

IP地址库在网络安全中有哪些作用

如何安全有效的删代码?

逻辑异或在网络安全中的应用实例

最有效的云服务器网络安全防护措施

IBM和微软加强在网络安全领域的合作

IP地址与网络监控

3芯M16接头在网络工程中的应用

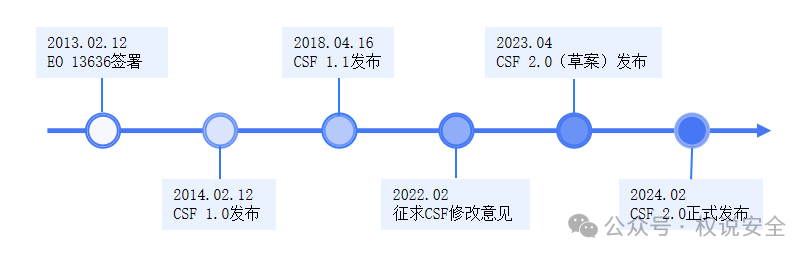

专家解读 | NIST网络安全框架(1):框架概览

微软即将发布AI安全产品

智慧路灯杆AI监测应用,让高速出行更安全

如何在网络中有效地更安全使用AI?

如何在网络中有效地更安全使用AI?

评论