本文发表在ICLR2021,将文本转化成图,从图的角度对NLP结果进行解释。

图数据的天然优势是为学习算法提供了丰富的结构化信息,节点之间邻接关系的设计成为了重要的先验信息和交互约束。然而,有一部分边上的消息是可以忽略的,论文首先提出方法在不影响模型预测效果的情况下,将图结构中冗余的边drop掉。通过分析剩余边上具有怎样的先验知识,实现对GNN的预测过程加以解释。

0. Abstract

GNN 能够将结构归纳偏置(structural inductive biases) 整合到 NLP 模型中。然而,却鲜有工作对于这种结构偏置的原理加以解释,特别是在理解图结构的哪些部分有助于模型的预测方面。因此,本文介绍了一种事后(post-hoc)方法,来对 GNN 的预测加以解释,它能够识别出不必要的边。给定一个训练过的GNN模型,本文通过学习一个简单的分类器,对于每一层中的每条边,预测那条边是否可以被丢弃。作者证明了这样的分类器的训练可以用完全可微分的方式,使用随机门,并通过范数促进稀疏性。此外,作者还进行了非常有意义的实验,将提出的技术作为归因方法,同时分析了两个 NLP 任务中的GNN模型——问题回答和语义角色标注,并提供了对这些模型中信息流的理解。实验结果表明,可以丢弃大量的边却不会影响到模型的性能,同时通过分析剩余的重要边来解释模型的预测过程。

1. Introduction基于GNN的NLP任务

1.应用现状

近年来,图神经网络(GNNs)成为了一种可扩展和高性能的方法,能够将语言信息和其他结构偏置整合到NLP模型中。GNN 能够用于文本数据的表示,例如:语法和语义图、共指结构、知识库与文本链接等。也能够用在多种NLP任务中,例如:关系抽取,问题回答,语义语法解析,文本摘要,机器翻译,社交网络中的滥用语言检测等。

2.应用瓶颈——在NLP任务中的可解释性

虽然 GNN 性能较好,但模型还是相对复杂的,很难理解模型预测背后的“原因”。对于NLP从业者来说,知道给定的模型编码了哪些语言信息以及编码是如何发生的是非常重要的,GNN 可解释性差是实现这种分析的障碍。此外,这种不透明性降低了用户的信任,阻碍了有害偏置的发现,并使错误分析复杂化;在这篇论文中,着重于对 GNN 的事后分析,并对解释GNN的方法制定了以下要求:

能够识别层之间的相关路径,因为路径是向用户展示 GNN 推理模式的最自然的方式之一;

易于处理,适用于现代基于 GNN 的 NLP 模型;

尽可能的提升可信度,为模型如何真正的达到预测效果提供解释。

前置知识:擦除搜索(erasure search)

1.定义

执行解释的一个简单方法是使用擦除搜索[1],这是一种归因的方法,在不影响模型预测的情况下,查找到可以被完全删除的最大特征子集。删除意味着模型丢弃的所有特征信息都能够被忽略。

2.擦除搜索应用于GNN

对于GNN 而言,擦除搜索需要找到可以完全丢弃的最大子图。对于上面提到的三点需求,擦除搜索只能满足(1)和(3),在易处理性上失败了。在实际场景中是不可行的,一次只删除一个特征的花销非常大,并且由于饱和性会低估特征的贡献;此外,在擦除搜索中,优化是针对每个例子单独进行的。由于使用另一个可选择的较小子图也可以做出类似的预测,即使是非冗余的边也会被积极地修剪,这可能会导致过拟合,作者将这个问题称为事后偏差(hindsight bias)。

GRAPHMASK 方法

论文提出的 GRAPHMASK 旨在通过可扩展的方式实现与擦除搜索相同的优点,从而满足上述的需求。也就是说,作者的方法对保留或丢弃边做出了可解释的硬性选择,从而使被丢弃的边与模型预测没有相关性,同时保持了易处理性。GRAPHMASK 可以理解为子集擦除的一种可微的形式。其中,作者不是为每个给定的例子找到一个需要擦除的最佳子集,而是学习一个参数化的擦除函数,该函数可以预测是否应该保留第层的每条边 。给定一个示例图 ,作者的方法为第 层返回一个子图 ,这样就可以认为 之外的任何边都不会影响模型的预测。由于作者的模型依赖于参数化的擦除函数,而不是对每条边单独进行选择,作者可以通过在训练数据集上摊开参数学习,这种策略避免了事后偏差。

论文的贡献

作者提出了一种新的针对GNN可解释性的方法,适用于任何以GNN为组件的端到端神经模型(作者将发布代码)。

作者用人工数据证明了现有最新方法的缺点,并展示了论文的方法如何解决这些缺点并提高可信度。

作者使用GRAPHMASK来分析两个NLP任务中的GNN模型:语义角色标注和多跳问题回答。

2. MethodsGNN

给定输入图 ,GNN 第层的工作机制能够通过一个消息函数 和一个聚合函数 定义:

其中, 表示节点 和 之间的关系类型, 是节点 的邻居集合, 是第 层节点的表示。

GRAPHMASK

目标:获得原始图数据中的冗余信息,检测在不影响模型预测的情况下,第 层的哪些边上的消息 可以被忽略,作者将这些边和边上的消息视为冗余的。

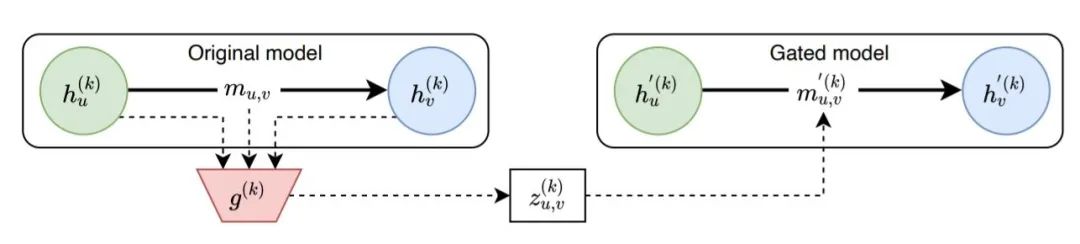

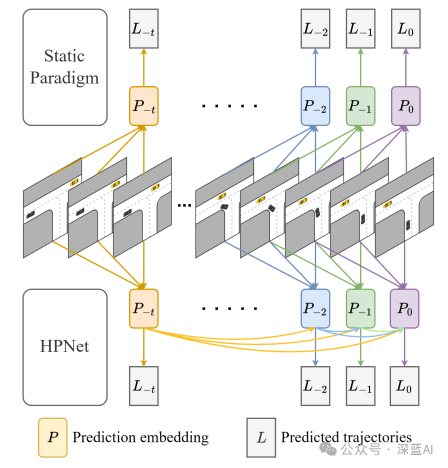

整体思路(如下图):节点的隐藏状态和消息被喂入一个分类器 ,预测得到一个掩码 ,作者用 来代替第 层的消息,并使用修改后的节点状态重新计算前向传播。分类器 在不改变模型预测的情况下,尽可能多的遮蔽隐藏状态。

模型框架

Original Model 当节点 和 之间有边连接时,那么消息 能够自由的传递给节点 ;

Gated Model 训练一个分类器 控制原始消息 是否要被遮蔽,若原始消息被遮蔽,则计算一个新的消息 ,再传递给节点 。

Gated Model 中消息的计算

作者通过一个二元选择模型 查找需要丢弃的边, 并通过一个可学习的基线 替换被丢弃的消息:

即,当 时,原始消息被遮蔽掉,使用学习到的参数 作为新的消息。

二元选择模型的局限

不满足作者在 Introduction 中提出的要求:1)该过程涉及到对所有可能被丢弃的候选边进行搜索,所以不是易处理的。2)搜索过程是对每一个例子单独进行的,存在事后偏见的危险。

为了克服这些问题,作者通过一个简单的函数来计算 ,对每个任务跨数据点学习一次:

其中 是分类器 的参数,以单层神经网络的形式实现。

分类器 的优势

不是根据给定的预测值来选择门值 ,而是在多个数据点上训练参数 ,并用于解释在训练阶段未见的例子上的预测。

的计算仅依靠模型在当前阶段的可用信息(即 , , ),而不是让模型提供一个lookahead.

这两个方面的设计,防止了事后偏差。作者把这种策略称为 amortization。另一种选择是为每个门独立的选择参数,不在门间共享任何参数,直接在测试样本上执行优化,作者将这种策略称为 GraphMask 的 non-amortized 版本。将在后面看到,与 amortization 版本不同的是,它容易受到事后偏见的影响。

计算过程

当获得训练好的分类器 后,使用论文提出的 GRAPHMASK 方法分析一个数据点过程如下:

1)在该数据点上执行原始模型,得到 , , 。

2)对每一层的每一条边进行门计算,并执行如图1所示模型的稀疏化版本。根据公式3对原始模型的消息进行门控。

3)对于后续各层,使用公式2对被遮蔽后的消息进行聚合,以获得顶点嵌入 ,然后用它来获得下一组被掩蔽的消息。

GRAPHMASK 唯一学习的参数是擦除函数的参数 和学习到的基线向量 ,原 GNN 模型的参数保持不变。只要依靠稀疏化图的预测与使用原始图的预测相同,我们就可以将被掩盖的信息解释为冗余的信息。

模型参数估计

问题定义

给定:具有 层的 GNN 函数 , 图 , 输入嵌入

任务:找到一个信息量大的子图集合 , ,也就是每一层GNN网络对应一个子图,找到边数目最少的子图,并使得:。

约束优化过程

用约束优化的语言来形式化上述问题,并采用一种能够实现梯度下降的方法,如拉格朗日松弛。一般来说,不可能保证)和 相等,因为是一个平稳函数,输入数据的最小变化也无法产生完全相同的输出。

为了衡量两个输出的不一致程度,作者引入了一个散度:,和一个容忍度:, 在该范围内的差异是可接受的。 的选择取决于原始模型的输出结构。最小化分类器 预测的非零值数目(即未被遮蔽的边的总数),比较常见的方法是最小化 范数。因此,从形式上讲,在数据集 上定义本文的目标函数为:

其中1是指示函数, 是拉格朗日乘子。

以上目标函数不可微,由于:1) 不连续,导数几乎处处为0;2)输出的二值需要一个不连续的激活,如阶跃函数。因此没办法使用基于梯度的优化方法,作者采用稀疏松弛解决以上问题,并采用 Hard Concrete 分布(封闭区间[0,1]上的混合离散连续分布)。

4. Experiments作者进行了三个系列的实验,本文将呈现重要的表格和结果,具体实验细节和分析参阅论文。

综合实验

作者首先将GRAPHMASK应用在一个已知真实属性的 Toy 数据集中,对方法的忠诚度进行评估。

任务描述 给定一个星形图 ,有一个单独的中心顶点,叶节点,以及边,图中每条边都事先分配好了一种颜色 。然后,给定一个查询 ,

需要预测的是 分配给颜色 的边数是否大于分配给颜色 的边数。我们事先明确已知与 两种颜色相匹配的边是重要的,除此之外的其它边都不影响预测。作者定义了一个忠实度的黄金标准:对于,所有 和 类型的边都应该被保留, 而所有其他的边都应该被丢弃。

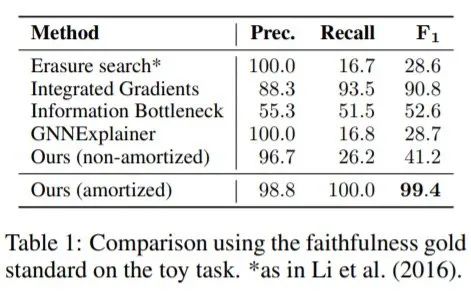

GRAPHMASK与三个基线方法比较

只有本文提出的方法的 amortized 版本近似复制了黄金标准,事实上,擦除搜索、GNNExplainer 和 non-amortized 的GRAPHMASK只召回了一小部分非冗余边。

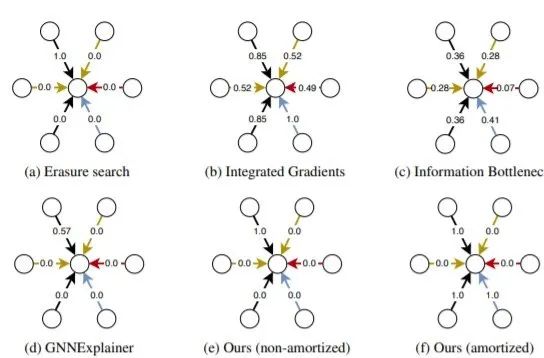

图2 可视化每种方法的分数分配情况

擦除搜索、GNNExplainer 和 non-amortized 版本 GRAPHMASK 只保留一条黑色边,造成过拟合。集成梯度和信息瓶颈方法给出了不满意的结果,因为所有边边都有属性。只有amortized -GRAPHMASK能够正确地将属性分配给且仅分配给黑色和蓝色边,amortized 可以防止目标过拟合。

问题回答任务

任务描述 给定一个查询句和一组上下文文档,在上下文中找到最能回答查询的实体。GNN图中的节点对应于查询和上下文中实体的提及,并在这些实体之间引入了四种类型的边:字符串匹配(MATCH)、文档级共现(DOC-BASED)、核心参考解析(COREF),没有任何其他边(COMPLEMENT)。

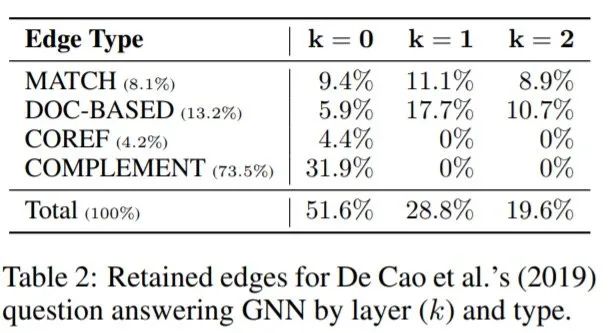

GRAPHMASK复制了原始模型的性能,虽然准确度下降0.4%,但是仅有27%的边被保留,保留的边大部分存在于底层(底层的边比较重要)。作者测量了每一层保留边的百分比,这些边发生在源于查询实体的路径上。观察发现,发生在源于查询的提及的路径上的边的比例按层急剧增加,从0层的11.8%,到1层的42.7%,在顶层达到73.8%。与预测答案相对应的一些提及在99.7%的情况下是一些保留边的目标。然而,预测实体与查询连接的几率(72.1%)与平均候选实体的几率(69.2%)几乎相同。因此,GNN不仅负责通过图传播证据到预测答案,还负责传播证据到备选候选实体。大多数路径采取两种形式之一,即一条COMPLEMENT边之后是一条MATCH或一条DOC-BASED边(22%),或者一条COMPLEMENT边之后是两条MATCH或DOC-BASED边(52%)。

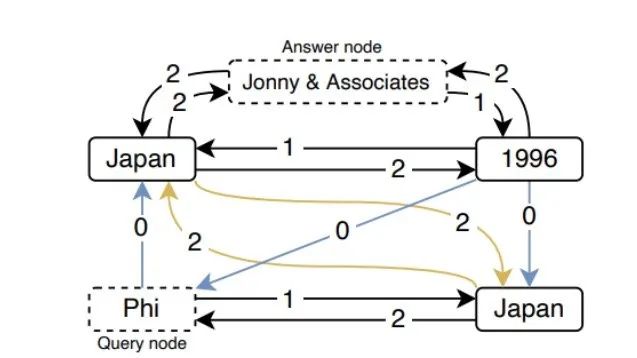

图3 QA任务中边的保留情况

查询 “record label Phi” 的保留子图(占原始边的21%)。黑色边类型是DOC-BASED,蓝色是COMPLEMENT,黄色是MATCH,其中边上的数字表示在哪一层保留了这种边。可以看到 Japan 和 Johnny & Associates 之间第2层中的 DOC-BASED 类型边的情况。事实上,在第0层、第1层和第2层中,分别有49%、98%和79%的保留边也保留了它们的逆向边。换句话说,提及之间 “不定向 ”的信息交换,使得它的表征更加丰富。

语义角色标注任务

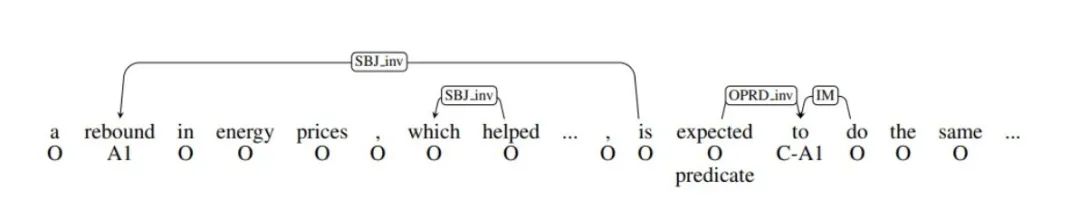

图4 GNN+LSTM模型的语义角色标注的实例分析(丢弃冗余弧)

任务描述 基于GNN的语义角色标注系统,识别给定谓词的论元,并将它们分配到语义角色上,见图4中句子下面的标签。该 GNN 模型依赖于自动预测的句法依赖树,允许信息双向流动。作者针对[2]中性能最好的模型,包括BiLSTM+GNN,以及GNN-only 模型。对于LSTM+GNN,遮蔽模型的性能变化非常小,F1 仅下降0.62%,却只保留了其中4%的消息。GNN-only 模型的性能变化同样很小,F1 下降了 0.79%,保留了16%的消息。

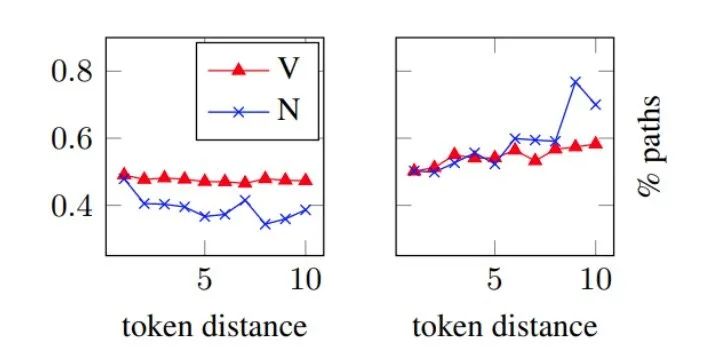

LSTM+GNN 模型(左)和 GNN-only 模型(右)的预测中使用的路径百分比(纵坐标),横坐标是谓词和预测角色之间距离。

[2] 的原始研究结果表明,GNN对于预测远离谓词的角色特别有用,LSTM对于传播信息的可靠性较低。GNN可以实现这一目标的方式是使用图中的路径;要么依赖整个路径,要么部分依赖路径中的最后几条边。其中连接谓词和论元的路径代表语义角色标注任务的重要特征。为了研究这个问题,作者在图5中绘制了从谓词到预测论元的路径的百分比,从而保留了以预测论元为终点的子路径(即至少一条边),通过观察图5发现:

LSTM+GNN 模型:随着与谓词距离的增加,对路径的依赖性会降低。

GNN-only 模型:随着与谓词距离的增加,对路径的依赖性会增加。

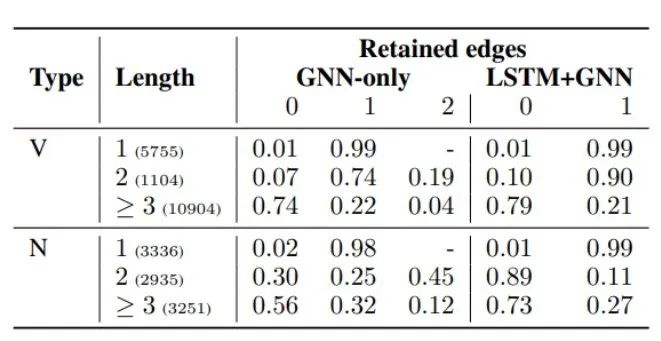

表3 两种模型保留0、1或2条边的路径百分比,按路径长度和谓词类型划分

通过观察表3发现:

几乎所有的谓词和角色之间的直接连接都被保留了下来,因为这些边构成了它们句法关系的最直接的指示。

较长的路径在两种模型中都是非常有用的--然而,在LSTM+GNN模型中,名词谓词对长路径的使用率要低得多。

在这种特殊情况下,LSTM捕捉到了路径上存在的信息,在其他情况下,GNN通过对连接谓词和论元的路径进行建模来补充LSTM。

5. Conclusion论文介绍了GRAPHMASK,这是一种适用于任何GNN模型的事后解释方法。通过学习每条消息的端到端可微分的hard gates,并在训练数据上进行摊销,GRAPHMASK 可扩展到其它的GNN模型,并且能够识别边和路径如何影响预测。作者应用提出的方法分析了两个NLP模型的预测——语义角色标签模型和问题回答模型。GRAPHMASK发现了这些模型依赖于哪些类型的边,以及它们在进行预测时如何运用路径。

参考文献[1] Jiwei Li, Will Monroe, and Dan Jurafsky. Understanding neural networks through representation erasure. arXiv preprint arXiv:1612.08220, 2016.

[2] Michael Roth and Mirella Lapata. Neural semantic role labeling with dependency path embeddings. In Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), pp. 1192–1202, Berlin, Germany, August 2016. Association for Computational Linguistics. doi: 10.18653/v1/P16-1113. URL https://www.aclweb. org/anthology/P16-1113.

编辑:lyn

-

人工智能

+关注

关注

1792文章

47440浏览量

238989 -

模型参数

+关注

关注

0文章

4浏览量

6437 -

深度学习

+关注

关注

73文章

5507浏览量

121296 -

GNN

+关注

关注

1文章

31浏览量

6357

原文标题:【GNN】别用Attention了,用GNN来解释NLP模型吧

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

运动控制中如何实现路径轨迹预测

电流探头在辐射预测试的原理分析

PLC对模拟量信号的处理过程及方法 详解版

更好的预测方法:使用前后控制图

神经网络预测模型的构建方法

深度学习模型训练过程详解

自动控制原理及过程控制方法

示波器实现原理与操作方法详解

基于自回归模型的海上风电功率预测方法

基于设备监控运维管理平台实现预测性维护

详解对GNN的预测过程的实现与应用方法

详解对GNN的预测过程的实现与应用方法

评论