标注多跳问答(Multi-hop QA)数据集费时费力!本文首次研究了无监督的多跳问答的可能性,提出了MQG-QA,一种无监督的框架,从同构和异构数据源中自动生成多跳问答对。使用生成的数据预先训练QA系统将大大减少对人工标注训练数据的需求。

多跳问答(QA)训练数据的获取是非常耗时费力的。为了解决这个问题,我们探索了无监督的多跳QA问答对生成的问题,可以在没有标注的QA对场景下使用,非常的适合真实场景。

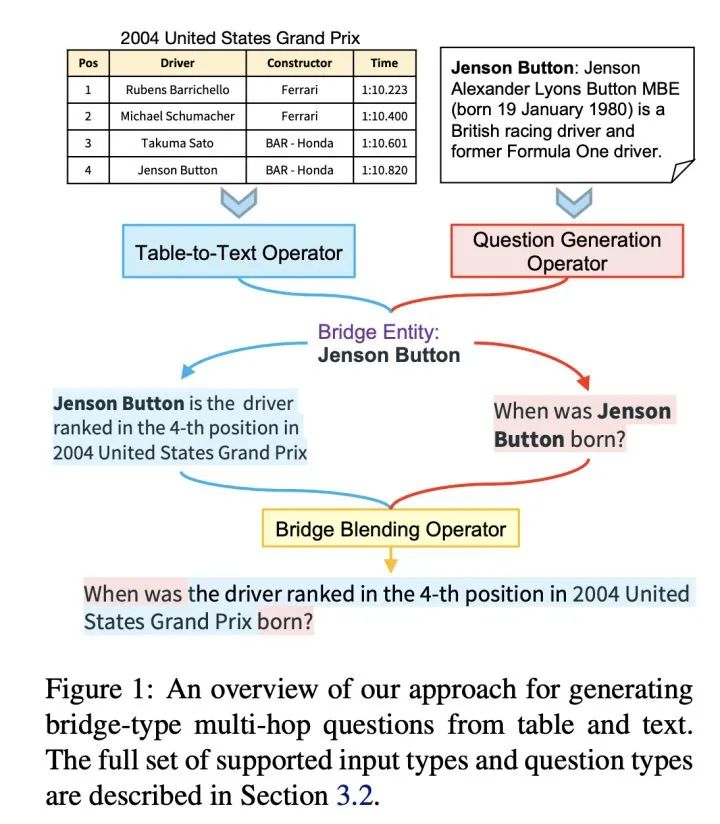

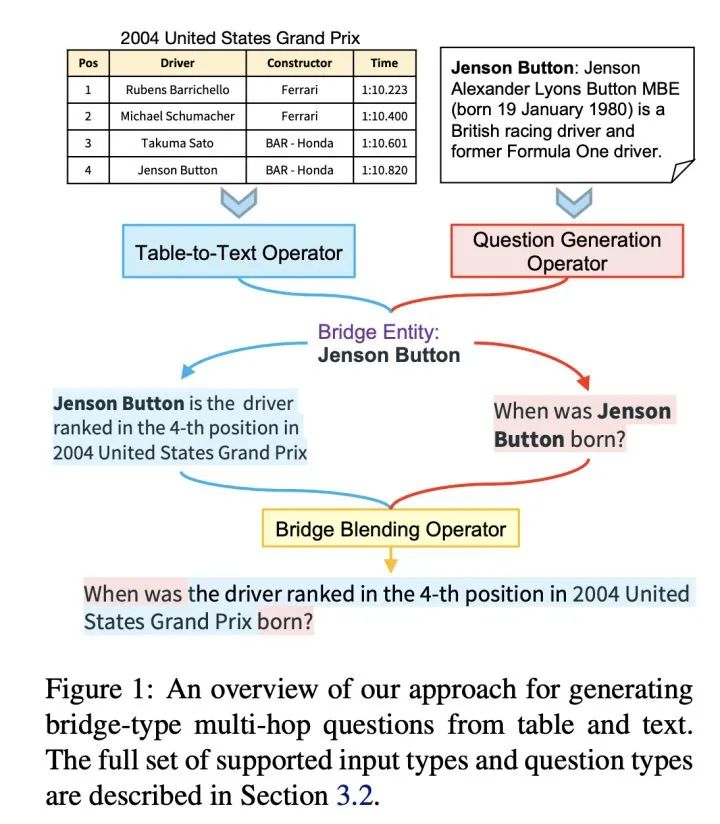

我们模型首先通过首先从每个数据源中选择或生成相关信息,然后将多个信息整合起来,形成一个多跳问题。我们发现,用我们模型产生的训练数据训练出来的模型,性能和完全监督模型之间的F1差距较小。这个现象是非常激动人心的,表明我们可以通过无监督预的构造数据来大大减少对人工标注的训练的需求。

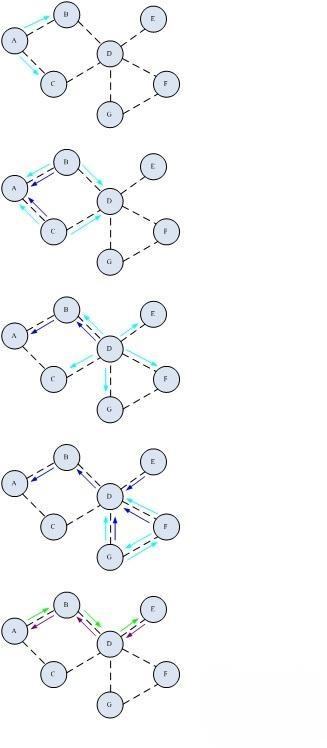

下图是该方法的简易用法演示:

原文标题:【NAACL2021】初探无监督的多跳问答对

文章出处:【微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

责任编辑:haq

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

原文标题:【NAACL2021】初探无监督的多跳问答对

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

相关推荐

大功率永磁无刷直流电机驱动系统由于运行效率高、调速性能好、可靠性高等优点,在国外已成功应用于对系统效率、可靠性有特殊要求的推进领域中。然而,国际上关于大功率永磁无刷电机及其驱动系统的成套技术一直对我

发表于 02-26 16:24

AI(人工智能)对产品设计带来了广泛而深远的可能性,这些可能性主要体现在以下几个方面 1.创新设计的激发 创意生成:AI能够学习和模仿人类设计师的创作过程,通过深度学习等技术生成全新的、独特

![的头像]() 发表于

发表于 10-15 11:29

•381次阅读

客户使用TI的ADC芯片ADS131A02,发现从AIN1P采到的ADC值不准,于是将AIN1P和VREF_2V5相连,发现也没法读出满量程的AD值,换算出来只有2.45V左右。请问有哪些可能性会造成这样的影响?

谢谢!

发表于 10-14 07:04

在科技行业并购传闻频发的背景下,高通公司被曝已探索收购英特尔部分业务的可能性,特别是其客户端PC芯片设计业务,旨在进一步丰富和增强其产品组合。据多位知情人士透露,高通对英特尔的这部分资产表现出浓厚兴趣,而英特尔则正积极寻求现金流,考虑剥离非核心业务及出售资产以优化财务结构。

![的头像]() 发表于

发表于 09-09 17:21

•647次阅读

芯片设计复杂性的快速指数级增长给开发者带来了巨大的挑战,整个行业不仅要向埃米级发展、Muiti-Die系统和工艺节点迁移所带来的挑战,还需要应对愈加紧迫的上市时间目标、不断增加的制造测试成本以及人才短缺等问题。早在AI大热之前,芯片设计行业就把目光放到了AI,探索AI+EDA的更多

![的头像]() 发表于

发表于 08-29 11:19

•613次阅读

据韩国政府方面的最新消息透露,三星电子的越南分公司正积极探讨在越南设立半导体组装工厂的可能性,尽管具体的选址尚未尘埃落定,但有线索指向富士康投资活跃的北江地区附近,这一区域因其得天独厚的地理位置而备受瞩目。

![的头像]() 发表于

发表于 08-23 15:19

•708次阅读

8月7日,国际媒体传来新消息,据知情人士透露,苹果公司正积极探索为即将推出的Apple Watch SE系列引入塑料表壳的可能性,此举旨在通过材料创新进一步压缩成本,增强市场竞争力。这一变化不仅预示着成本效益的显著提升,还可能开辟新的市场细分领域,特别是满足家长为孩子选购

![的头像]() 发表于

发表于 08-07 17:03

•675次阅读

信息有助于模型更深入地理解文本的含义和意图。

3. 推理与判断

在问答任务中,大语言模型不仅需要理解问题的字面意义,还需要进行推理和判断以得出准确的答案。例如,在处理多跳推理问题时,模型需要综合多个事实

发表于 08-02 11:03

频、空中干扰并提高无线通信的健壮性和稳定性,,经典蓝牙跳频技术应运而生,本文主要介绍经典蓝牙跳频技术相关内容。

![的头像]() 发表于

发表于 07-10 09:14

•3216次阅读

神经网络作为深度学习的重要组成部分,其训练方式多样,其中无监督学习是一种重要的训练策略。无监督学习旨在从未标记的数据中发现数据内在的结构、模式或规律,从而提取有用的特征表示。这种训练方

![的头像]() 发表于

发表于 07-09 18:06

•985次阅读

应用中往往难以实现。因此,无监督学习在深度学习中扮演着越来越重要的角色。本文旨在综述深度学习中的无监督学习方法,包括自编码器、生成对抗网络、聚类算法等,并分析它们的原理、应用场景以及优

![的头像]() 发表于

发表于 07-09 10:50

•1085次阅读

用基于脉冲前馈卷积网络,运用 STDP 无监督学习算法,相较于 CNN 等传统神经网络,更具有生物真实性,事件触发型的权重更新模式使计算需求降低,能耗减少。

(2)利用 SNN 仿真器能够大规模分布式

发表于 06-25 18:35

通过多个跳数进行通信,从而实现大范围的覆盖。然而,随着数据量的增加和带宽需求的提高,如何在蓝牙Mesh网络中实现高效、稳定的多跳大数据量高带宽传输数据成为了一个亟待解决的问题。本文将介绍一种基于蓝牙Mesh模块的

![的头像]() 发表于

发表于 05-28 11:23

•907次阅读

,掌握无创血压测量技术对于医学研究具有重要意义。

不同动物种群之间的差异性:不同动物种群之间存在一定的生理差异,这些差异可能会影响到无创血压测量结果的准确

发表于 04-22 09:40

从延长便携式设备电池寿命,到提高处理效率和响应能力,瑞萨的40纳米MCU技术正在重新定义嵌入式系统的可能性。

![的头像]() 发表于

发表于 03-11 15:11

•600次阅读

无监督的多跳问答的可能性研究

无监督的多跳问答的可能性研究

评论