引言

知识图谱嵌入 knowledge graph embedding是将包含实体和关系的知识图谱三元组嵌入到高维向量空间中,获得实体和关系的数值表示,提取图中相关信息,并进行后续运算推断。常用于知识图谱补全 (KG completion),关系提取 (relation extraction),实体分类 (entity classification),实体决议 (entity resolution)等等。

本次Fudan DISC实验室将分享三篇关于知识图谱嵌入模型的论文,分别介绍其训练策略、概率校准、模型设计三个方面取得的进展。

文章概览

知识图谱嵌入模型的训练策略(You CAN Teach an Old Dog New Tricks! On Training Knowledge Graph Embeddings)

论文地址:https://openreview.net/pdf?id=BkxSmlBFvr

该篇文章在两个常见数据集上对比了五种知识图谱嵌入 (Knowledge Graph Embedding) 方法在同样的训练框架和参数设置下的性能,总结并评测了不同模型架构和不同训练策略对模型的影响,正如文章标题所说“你可以教给老狗新的技巧”,训练策略对模型的性能有重大影响,并且可能占最近几年进展的很大一部分。

知识图谱嵌入模型的概率校准(Probability Calibration for Knowledge Graph Embedding Models)

论文地址:https://openreview.net/pdf?id=S1g8K1BFwS

该篇文章将概率校准的两种方法运用到知识图谱嵌入模型中,解决了当前知识图谱嵌入模型对于实体推断的打分不是概率的问题。

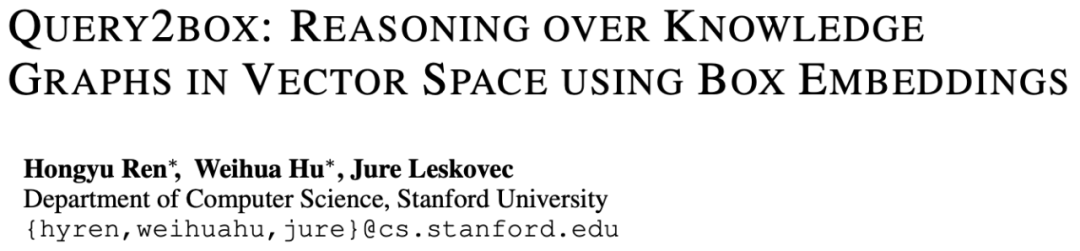

使用盒嵌入在知识图谱上推断(Query2box: Reasoning over Knowledge Graphs in Vector Space Using Box Embeddings)

论文地址:https://openreview.net/pdf?id=BJgr4kSFDS

该篇文章将盒嵌入引入知识图谱推断中,将原有的基于点嵌入的模型升级为基于高维矩形嵌入的模型,解决推断过程中“一推多”、合取、析取的问题。

论文细节

1

论文动机

目前有很多知识图谱嵌入模型,是近期的热点;

这些模型缺少统一的训练策略消融对比;

通常没有考虑最先进的基线。

以此带来的问题是难以评估模型和训练的贡献。因此文章将热门的5个模型在2个广泛使用的数据集上控制训练策略进行实验对比。

方法

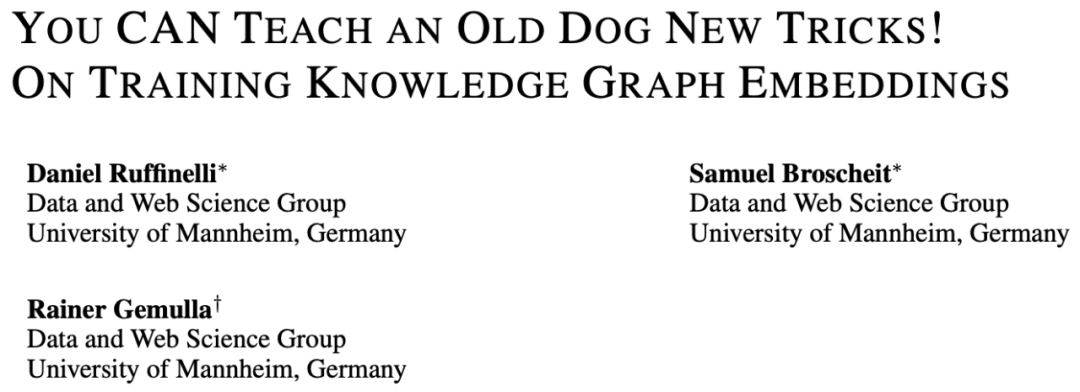

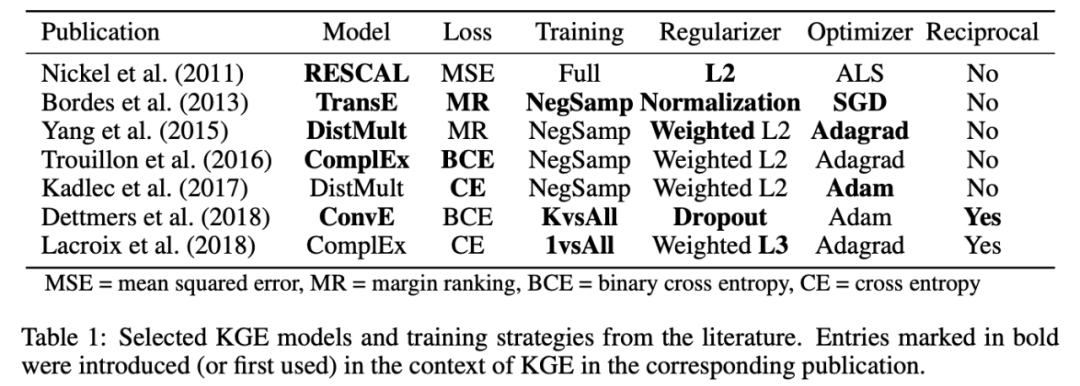

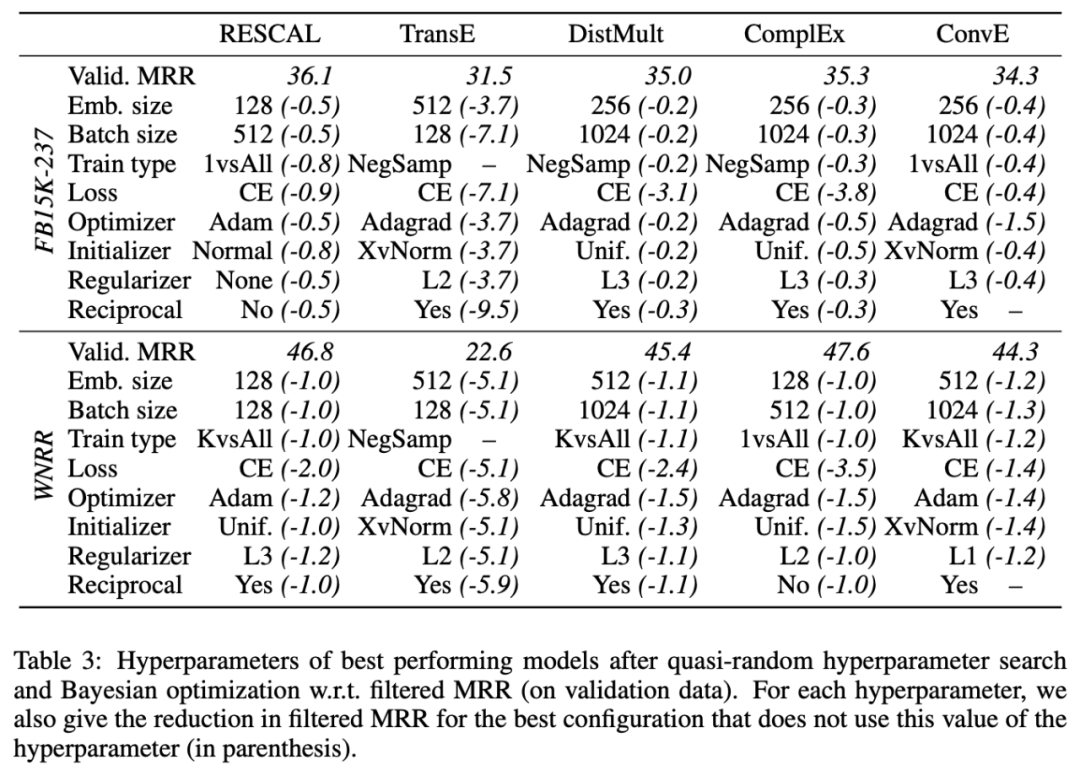

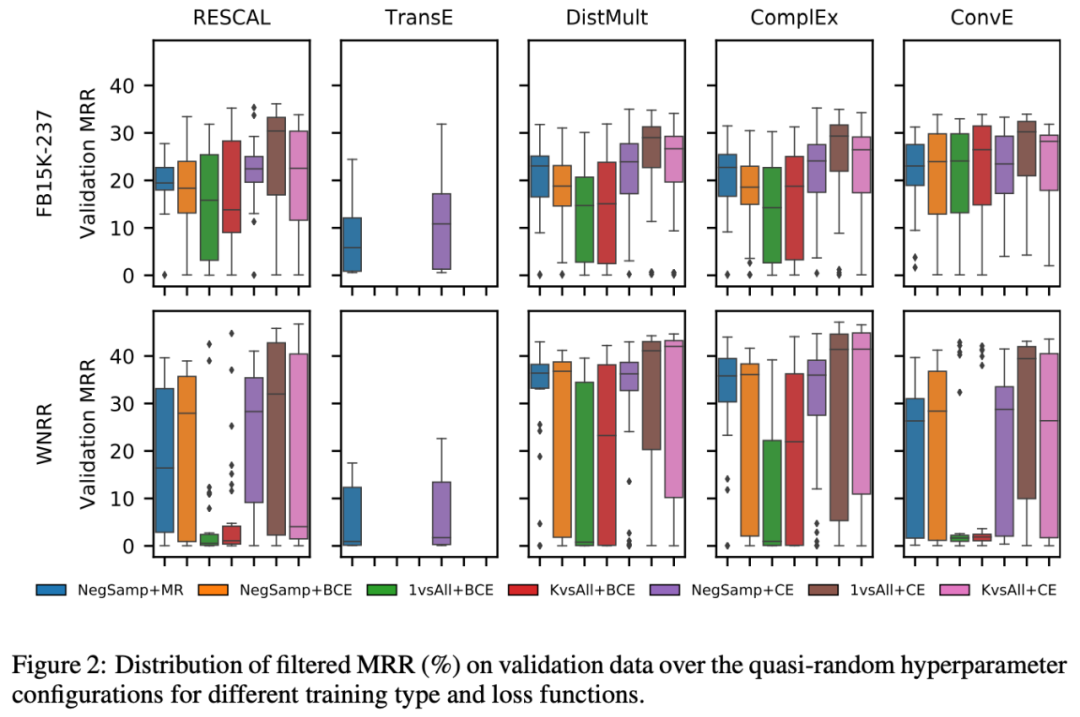

本文使用上表中的5个模型对比了如下的训练参数设置,篇幅有限不做过多介绍。

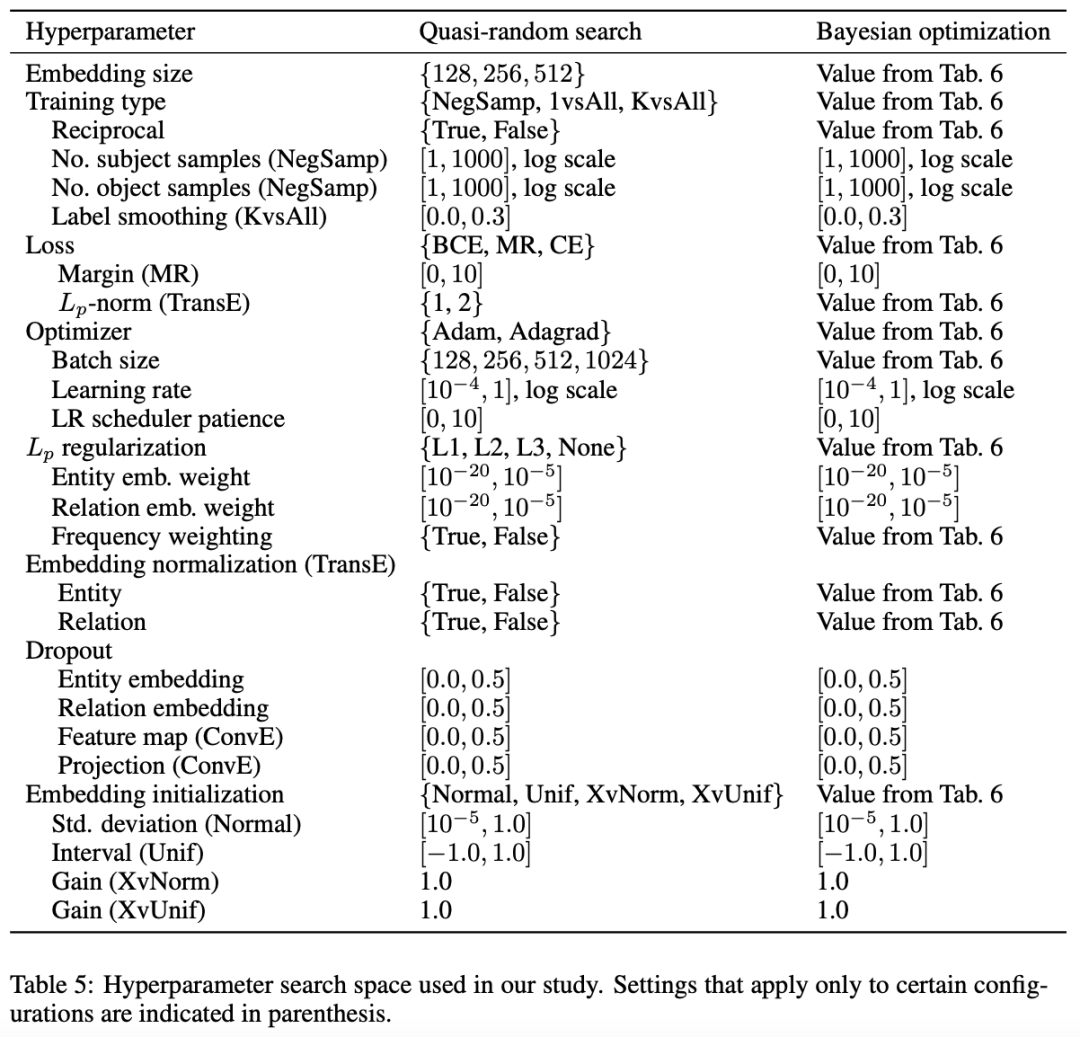

实验结果

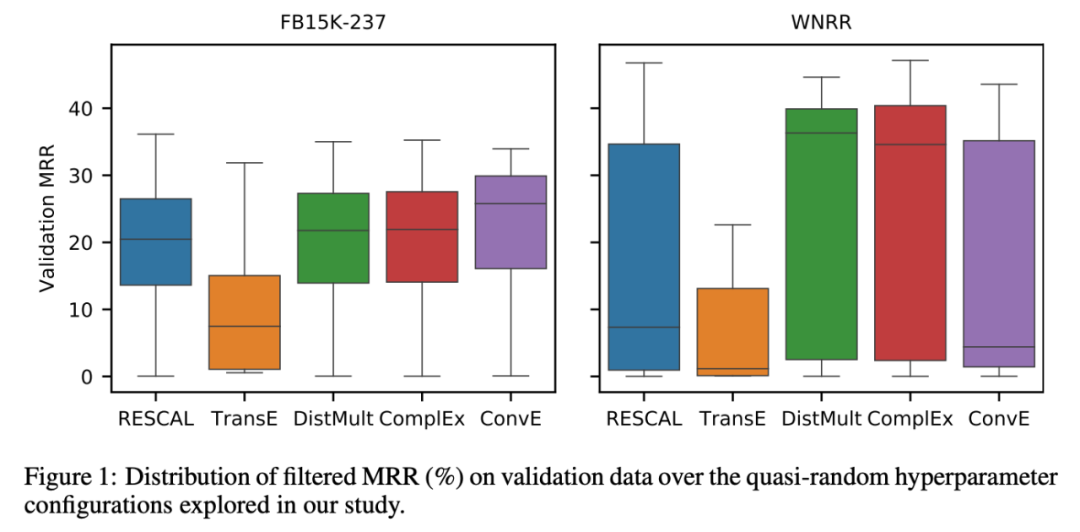

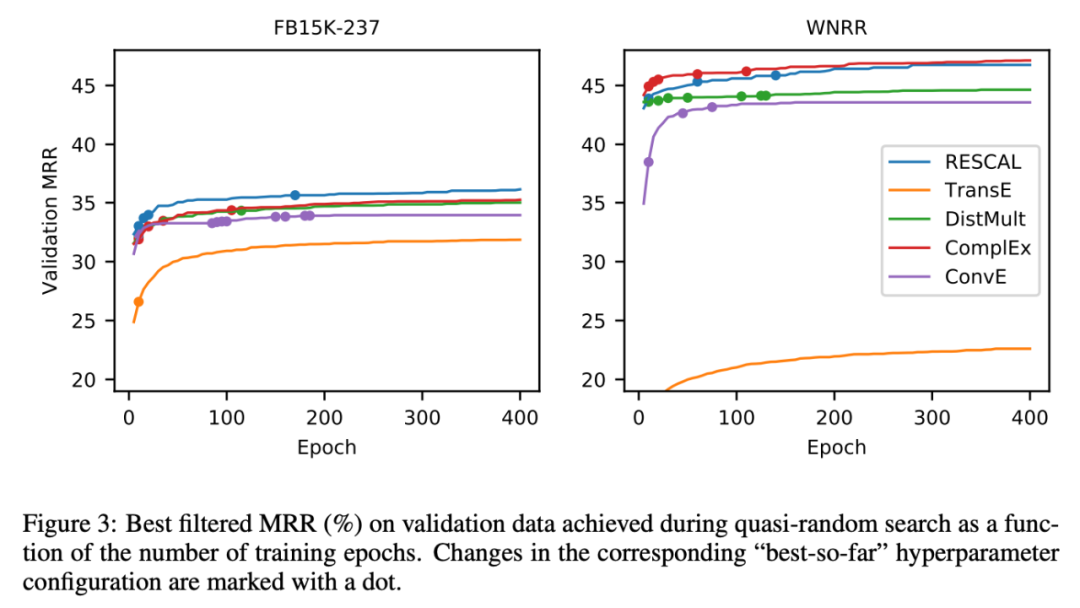

结果表明通过好的训练策略,热门模型都比他们论文刚发表时发布的性能有所提升,甚至有些模型可以超过后来提出的模型,如RESCAL;同时,文中也对比了重新实现的模型与更新的模型性能,发现最新的模型并没有比之前的模型在训练策略调优后的效果上有明显提升。

同时,每个模型在不同训练策略下的方差都比较大,并没有完全特别好的模型。

此外,文章还对比了不同参数的作用,以及训练的过程。

2

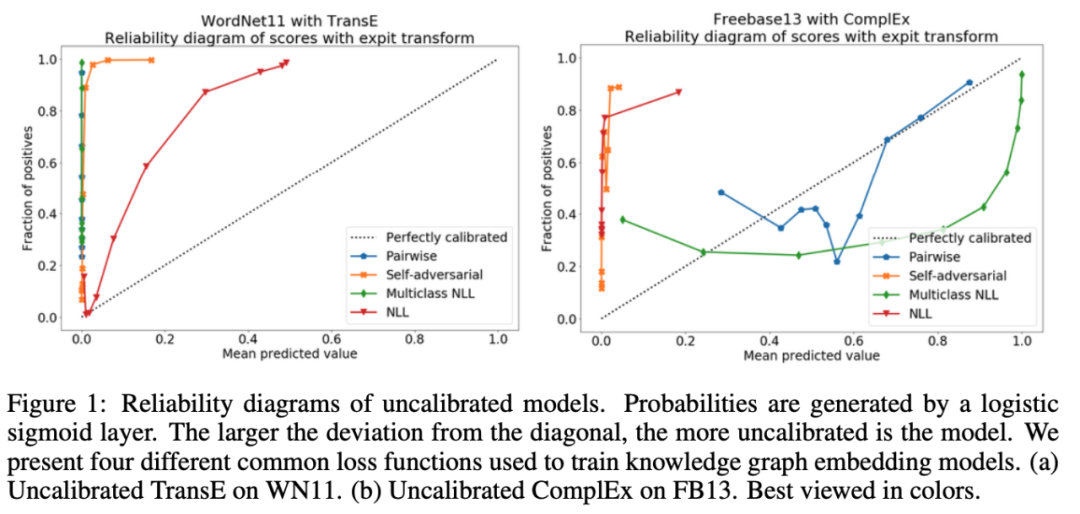

论文动机

知识图谱嵌入研究忽略了概率标定问题。

流行的知识图谱嵌入模型没有校准。

知识图谱嵌入得到分数的概率都是不可靠的。

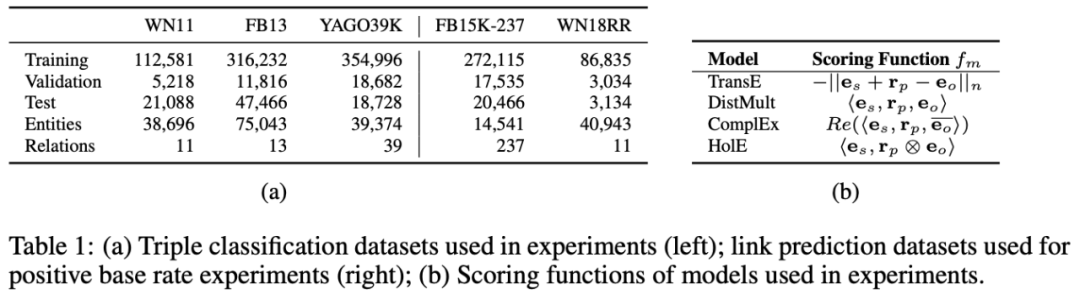

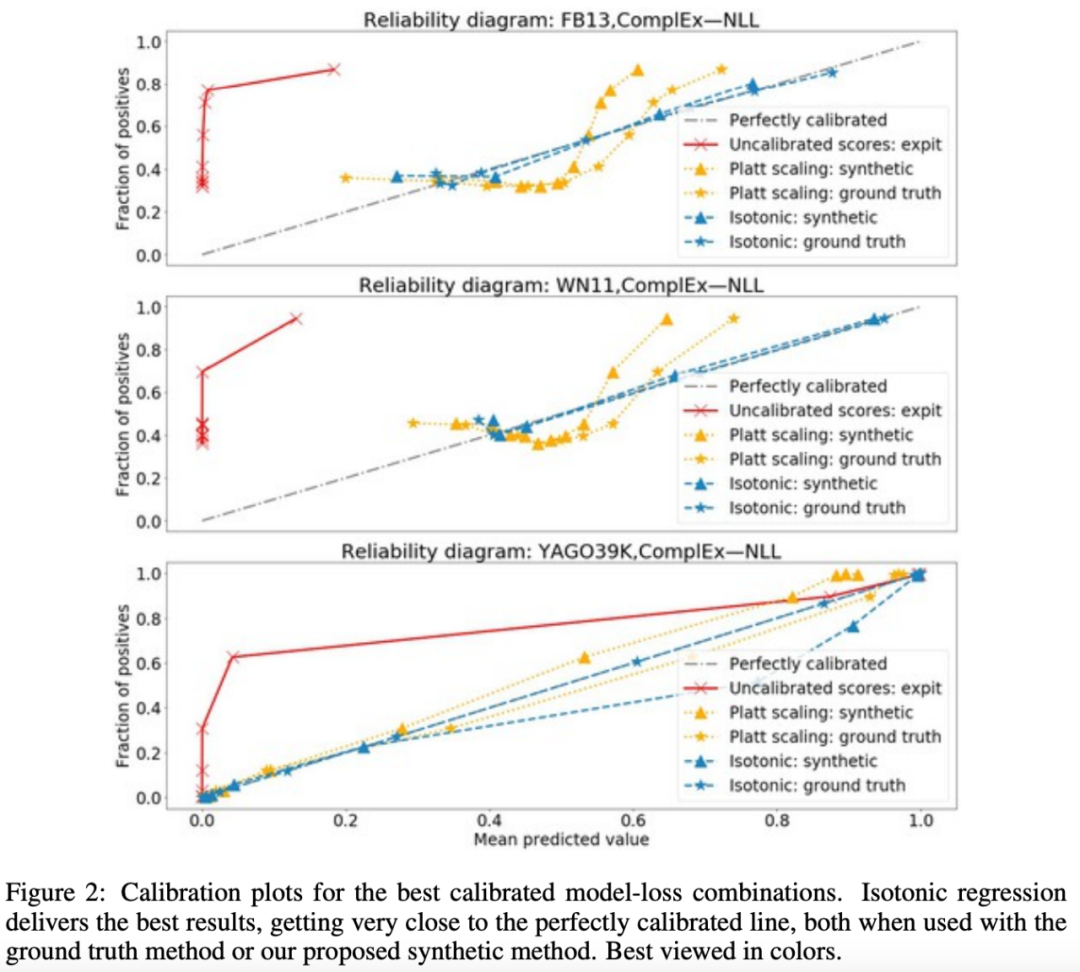

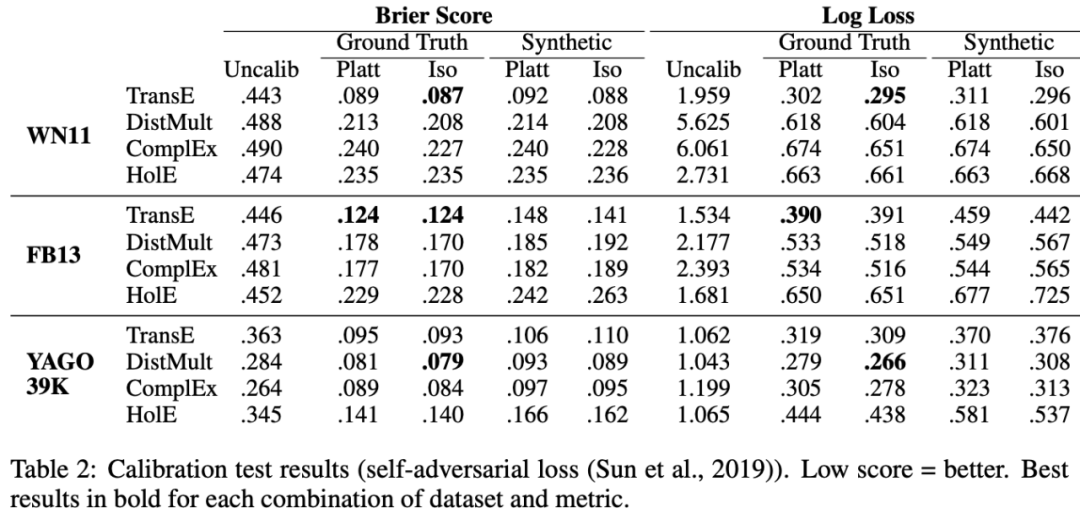

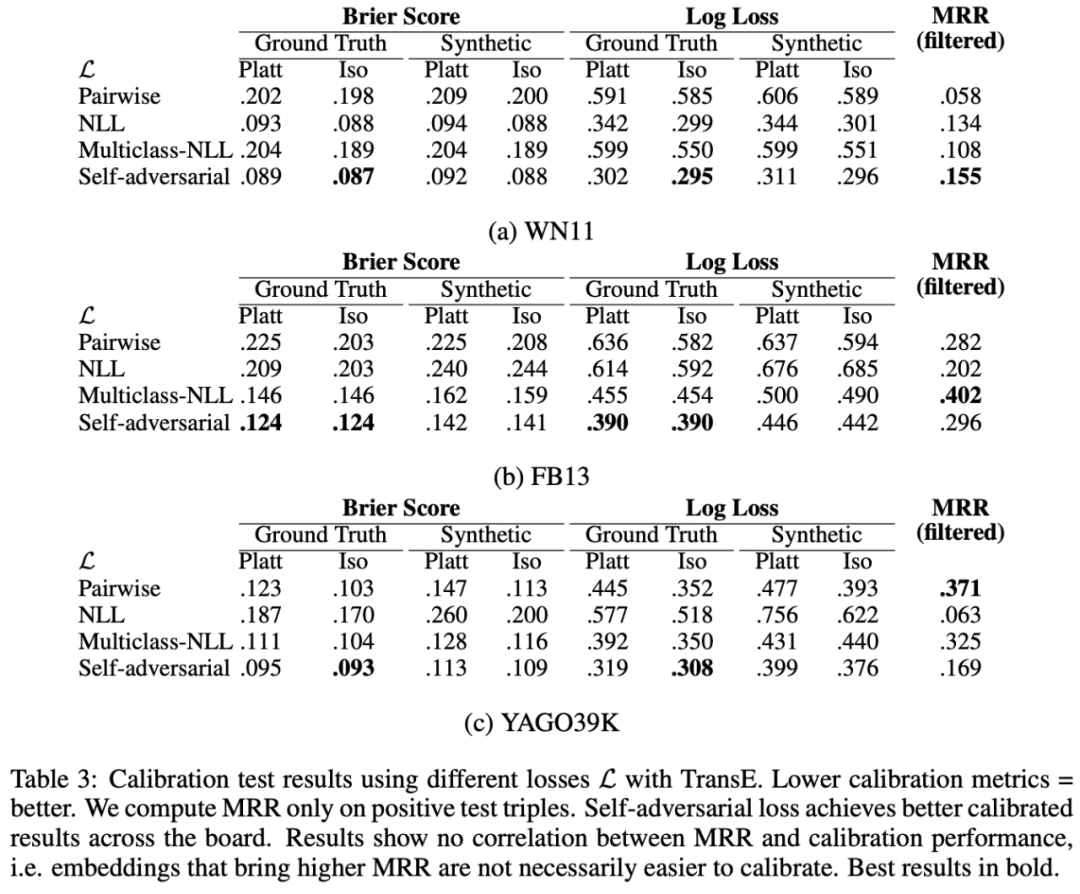

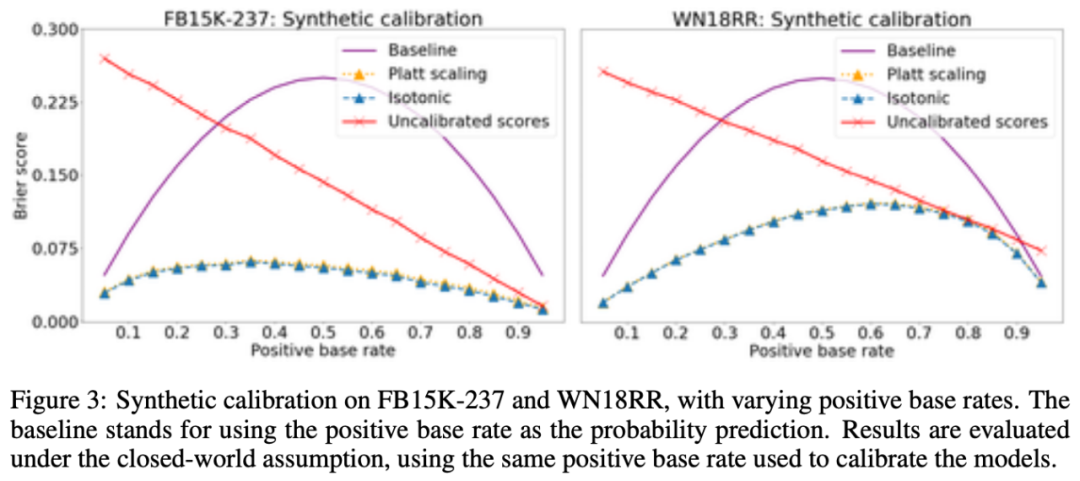

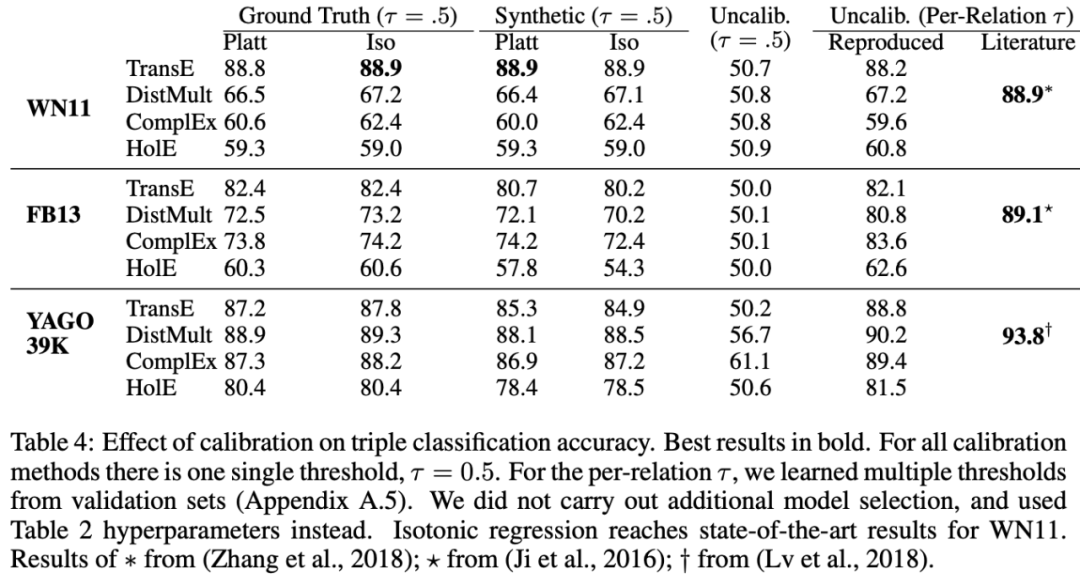

因此,本文提出了一种知识图嵌入模型的标定方法,使用Platt标度和等渗回归,对概率进行了校准。

方法

论文主要的研究对象是基于知识图谱嵌入的评分,使用Platt标度和等渗回归,对评分概率进行了校准。

实验结果

实验结果表明,Platt标度和等渗回归的校准效果良好。

3

论文动机

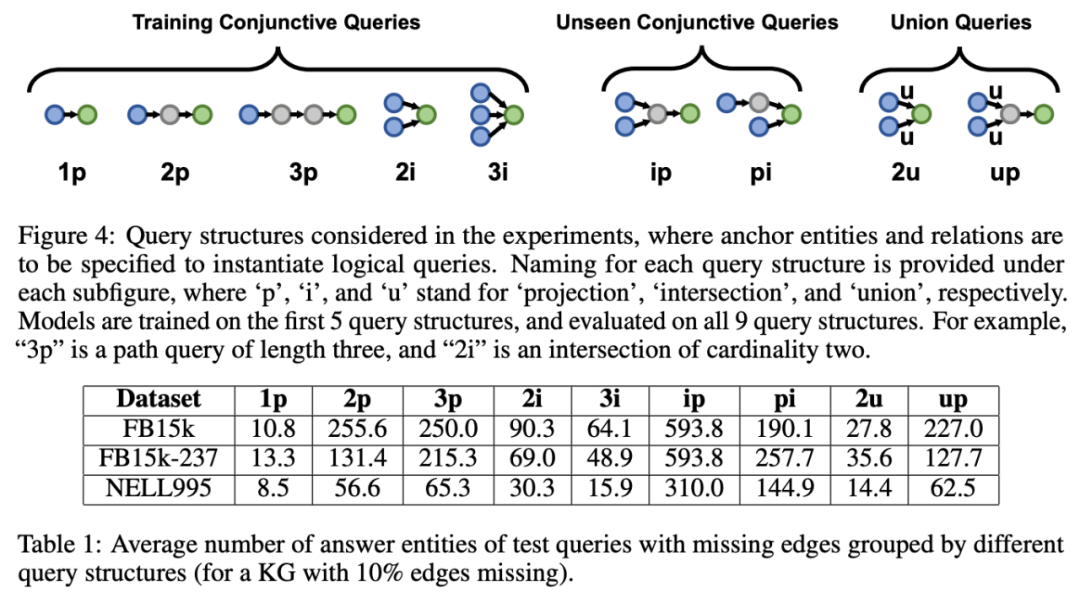

在知识图谱的链接预测(link prediction)中,存在多步推理的情况,以及有的时候推理并不是一一对应,而是存在同样满足条件的多个实体集合的情况。当前的研究主要关注于单步的点推理,也没有考虑推理中集合的操作。因此,本文提出将盒嵌入模型用于回答知识图谱的推理问题,从而解决推理中多步集合推理的问题。

方法

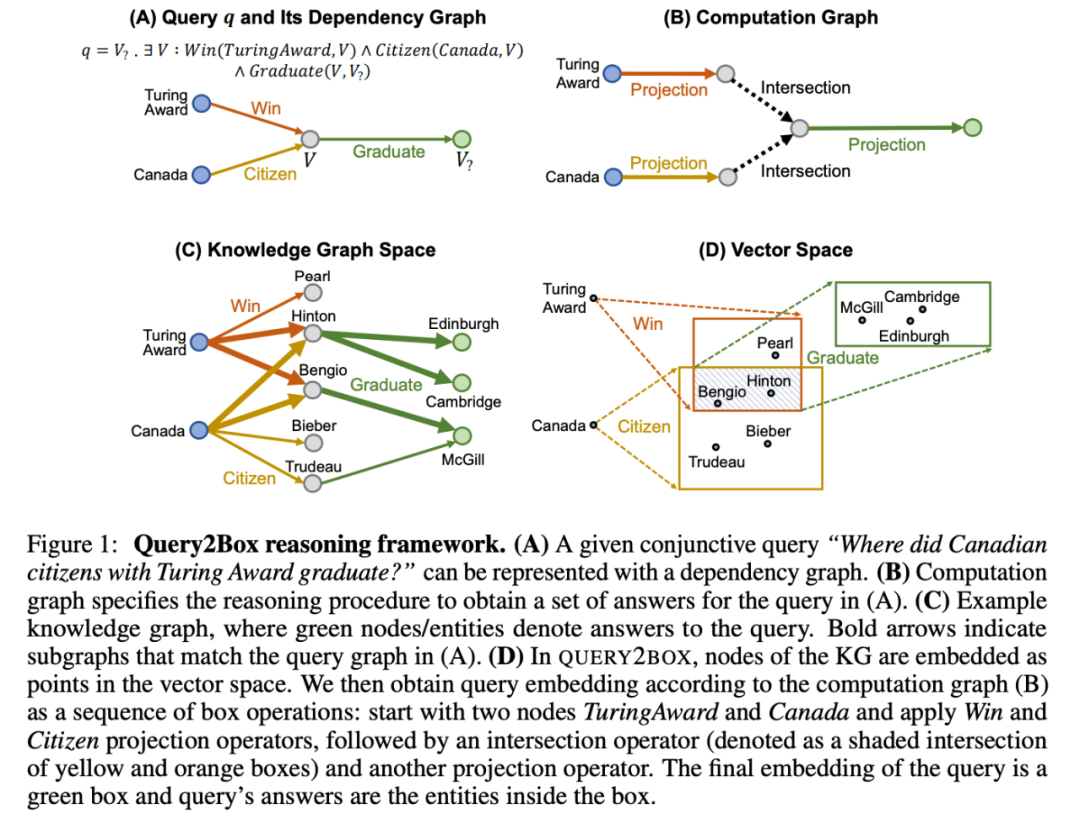

文中定义了盒嵌入向量的构造和投影合取的操作,以及距离的计算方式。

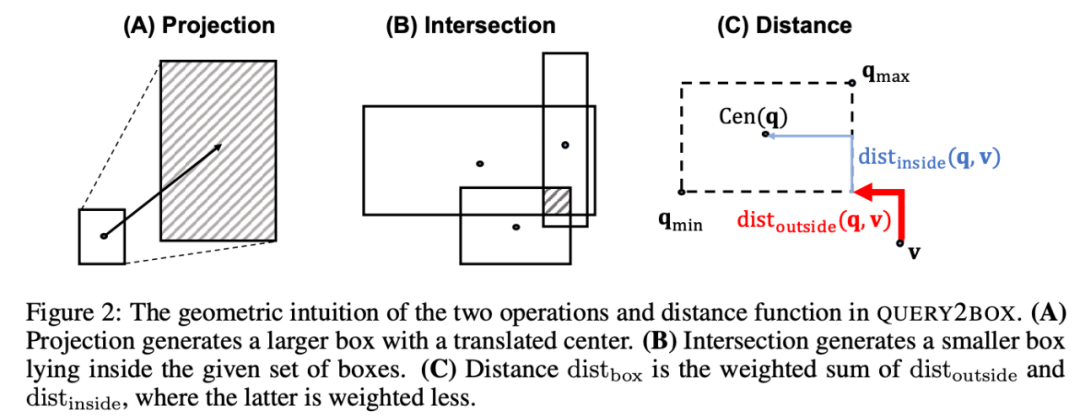

此外,文中还证明了任何一个命题都可以转化为标准形式。

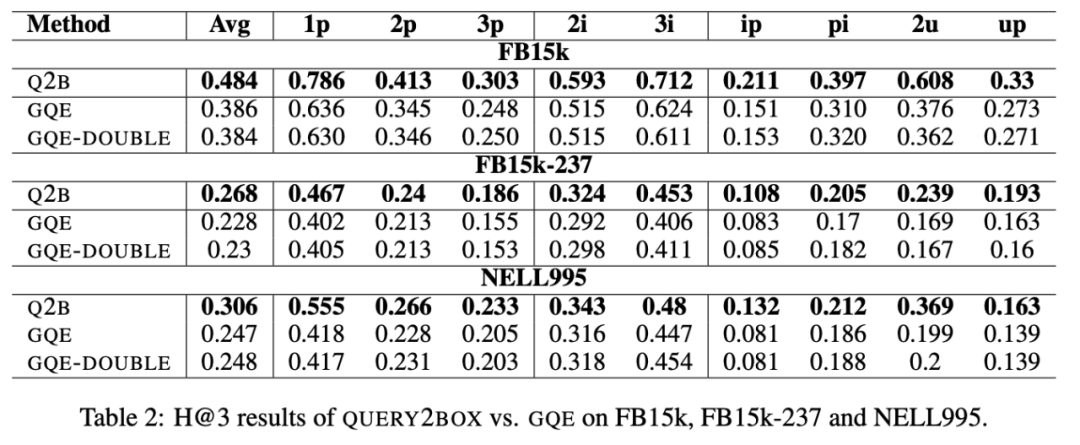

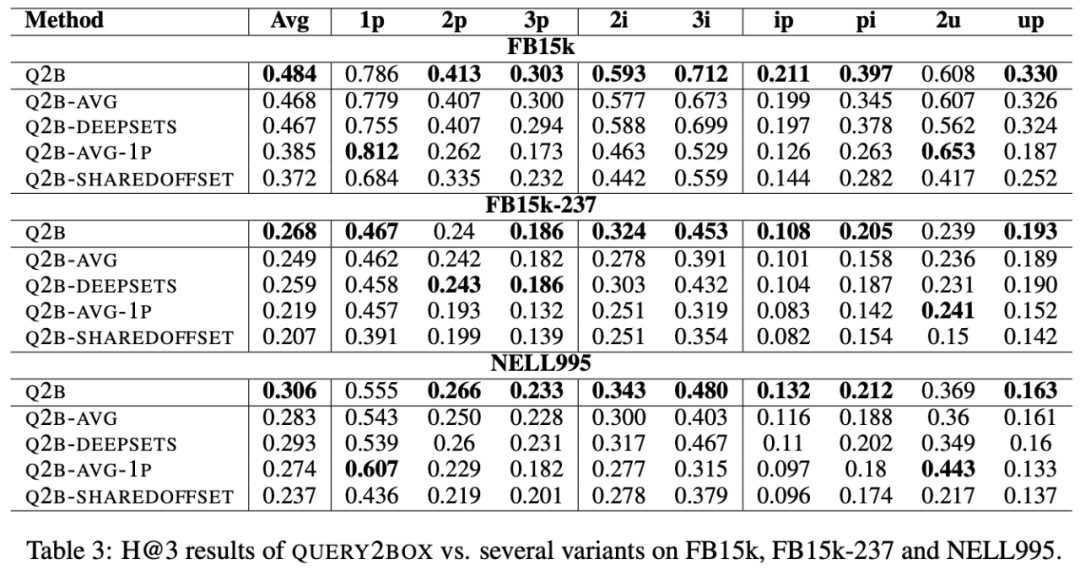

实验结果

实验结果表明盒嵌入模型相比于点嵌入模型拥有更好的推理效果。

总结

此次 Fudan DISC 解读的三篇论文围绕知识图谱嵌入模型展开,训练策略对于嵌入模型的训练影响很大,由知识图谱嵌入模型得到的打分可以通过概率校准的手段使其变成概率,盒嵌入模型的引入解决了复杂集合推断的问题。

责任编辑:lq

-

模型

+关注

关注

1文章

3432浏览量

49543 -

数据集

+关注

关注

4文章

1215浏览量

25036 -

知识图谱

+关注

关注

2文章

132浏览量

7808

原文标题:知识图谱嵌入的一点小事 - ICLR2021

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

Fudan DISC实验室将分享三篇关于知识图谱嵌入模型的论文

Fudan DISC实验室将分享三篇关于知识图谱嵌入模型的论文

评论