阿里云震旦异构计算加速平台基于NVIDIA Tensor Core GPU,通过机器学习模型的自动优化技术,大幅提升了算子的执行效率,刷新了NVIDIA A100、A10、T4的GPU单卡性能。并基于8张NVIDIA A100 GPU和开放规则,以离线场景下每秒处理107.8万张图片的成绩,打破MLPerf 1.0推理性能测试纪录。

阿里云自研震旦异构计算加速平台,适配GPU、ASIC等多种异构AI芯片,优化编译代码,深挖和释放异构芯片算力,支持TensorFlow、Caffe、PAI等多种深度学习框架,可实现AI框架及算法的无缝迁移适配,支持云变端多场景快速部署,大幅提升AI应用开发效率。

在MLPerf推理性能测试结果1.0版中,震旦异构计算加速平台,基于8卡NVIDIA A100 GPU配置上性能夺魁,在开放规则的离线场景下取得每秒处理107.8万张图片的成绩。

首先在顶层算法模型上,使用基于自动机器学习(AutoML)的模型设计方式,这种方式可以获得比人工设计更高效的模型。震旦基于MIT的先进的神经网络架构搜索算法Once-For-All。

使用了基于强化学习的自研搜索算法获得了高性能子网络;之后通过INT8量化获得硬件加速继续提高性能,并在量化前进行深度重训练,以保证量化后的精度能够达到测试的精度要求。

IRB即反转残差块(Inverted Residual Block),是用于网络架构搜索的基本模块。每个反转残差块包括三层卷积算子,图上反转残差块的长度代表了该块的输出channel数量。

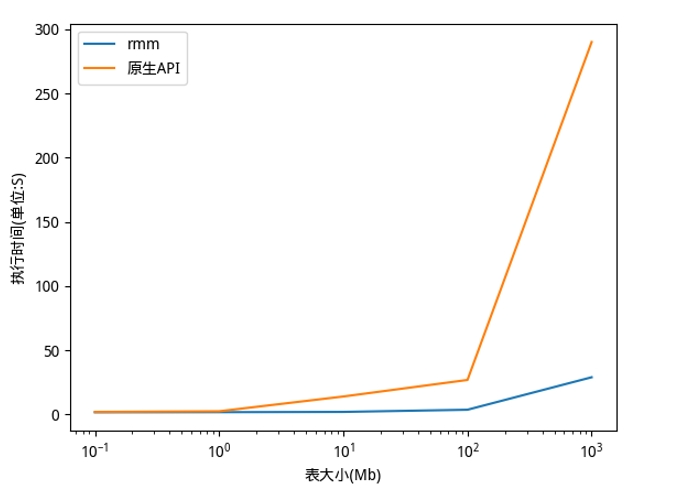

一般机器学习框架的算子实现专注于优化主流的神经网络架构,而对于NAS的反转残差块则效率不佳,震旦使用了基于自动调优的大规模算子融合技术,大幅提高了推理时算子对GPU的利用率,并且可根据不同的架构自动调优到最佳算子实现。

因此能快速发掘全新GPU架构的潜力,例如对于A100上通过MIG(多实例GPU)技术产生的具有不同计算资源的GPU实例,震旦算子优化技术可以通过自动调优来进一步提升计算资源利用率。

打破纪录的背后,在硬件平台上也得益于NVIDIA A100 GPU 强大的算力支持,近5倍于上一代的INT8性能使得超越百万级性能成为可能。另外,NVIDIA GPU的通用性,即通过CUDA直接对硬件编程,使得用户可以针对其特有的神经网络模型进行定制优化,这让震旦基于GPU的自动算子调优技术成为了现实。

最终获得的调优算子可以更高效地利用A100最新的Tensor Core硬件指令以及更大的共享内存,从而交出了软硬件协同优化的满意答卷。

在MLPerf推理性能测试结果1.0版本图像分类性能测试中,阿里云震旦异构计算加速平台,基于NVIDIA A100 GPU平台和开放规则,在离线场景下以每秒处理107.8万张图片的成绩,打破了此前谷歌保持的绝对性能榜单的世界纪录。这也是阿里在通用GPU平台第一次取得100万+这样的成绩。

此次阿里云震旦异构计算加速平台基于NVIDIA通用GPU硬件,通过机器学习模型的自动优化技术,大幅提升了算子的执行效率,刷新了NVIDIA GPU单卡性能。无论是新推出的A100和A10,还是已面市3年的T4,都带来了单卡性能的大幅提升。

编辑:jq

-

asic

+关注

关注

34文章

1200浏览量

120513 -

gpu

+关注

关注

28文章

4742浏览量

128965 -

AI芯片

+关注

关注

17文章

1887浏览量

35040

原文标题:NVIDIA A100 GPU助力阿里云打破MLPerf推理性能测试纪录

文章出处:【微信号:murata-eetrend,微信公众号:murata-eetrend】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

《CST Studio Suite 2024 GPU加速计算指南》

【一文看懂】什么是异构计算?

详解Arm计算平台的优势

《算力芯片 高性能 CPUGPUNPU 微架构分析》第3篇阅读心得:GPU革命:从图形引擎到AI加速器的蜕变

NVIDIA加速计算如何推动医疗健康

利用NVIDIA RAPIDS加速DolphinDB Shark平台提升计算性能

打造异构计算新标杆!国数集联发布首款CXL混合资源池参考设计

AvaotaA1全志T527开发板AMP异构计算简介

NVIDIA 通过 CUDA-Q 平台为全球各地的量子计算中心提供加速

基于NVIDIA Megatron Core的MOE LLM实现和训练优化

阿里云震旦异构计算加速平台基于NVIDIA Tensor Core GPU

阿里云震旦异构计算加速平台基于NVIDIA Tensor Core GPU

评论