来自:哈工大SCIR

本期导读:近年来研究人员在计算机视觉和自然语言处理方向均取得了很大进展,因此融合了二者的多模态深度学习也越来越受到关注。本期主要讨论结合文本和图像的多模态任务,将从多模态预训练模型中的几个分支角度,简述文本与图像领域的多模态学习有关问题。

1. 引言

近年来,计算机视觉和自然语言处理方向均取得了很大进展。而融合二者的多模态深度学习也越来越受到关注,在基于图像和视频的字幕生成、视觉问答(VQA)、视觉对话、基于文本的图像生成等方面研究成果显著,下图1展示了有关多模态深度学习的应用范畴。

在这些任务中,无论是文本还是语音,自然语言都起到了帮助计算机“理解”图像内容的关键作用,这里的“理解”指的是对齐语言中蕴含的语义特征与图像中蕴含的图像特征。本文主要关注于结合文本和图像的多模态任务,将从多模态预训练模型中的几个分支来分析目前图像与文本的多模态信息处理领域的有关问题。

2. 多模态预训练模型

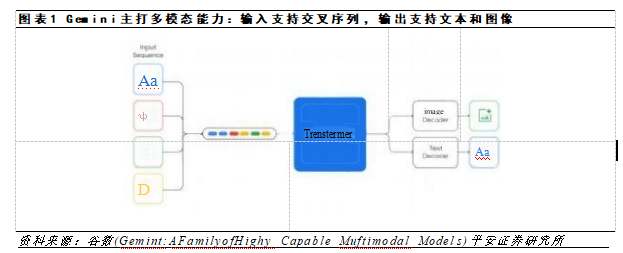

学习输入特征的更好表示是深度学习的核心内容。在传统的NLP单模态领域,表示学习的发展已经较为完善,而在多模态领域,由于高质量有标注多模态数据较少,因此人们希望能使用少样本学习甚至零样本学习。最近两年出现了基于Transformer结构的多模态预训练模型,通过海量无标注数据进行预训练,然后使用少量有标注数据进行微调即可。

多模态预训练模型根据信息融合的方式可分为两大类,分别是Cross-Stream类和Single-Stream类。

(1)Cross-Stream类模型是指将不同模态的输入分别处理之后进行交叉融合,例如ViLBERT[1]。2019年Lu Jiasen等人将输入的文本经过文本Embedding层后被输入到Transformer编码器中提取上下文信息。

使用预训练Faster R-CNN生成图片候选区域提取特征并送入图像Embedding层,然后将获取好的文本和图像表示通过Co-attention-transformer模块进行交互融合,得到最后的表征。

(2)Single-Stream类模型将图片、文本等不同模态的输入一视同仁,在同一个模型进行融合,例如VL-BERT[2]。2020年,Su Weijie等人提出了VL-BERT,它采用transformer作为主干,将视觉和语言嵌入特征同时输入模型。

3. 统一多模态模型

在之前的模型中,单模态数据集上训练的模型只能做各自领域的任务,否则它们的表现会大幅下降。要想学习多模态模型必须图文结合才行。这种多模态图文对数据数据量少,获取成本高。2021年,百度的Li Wei等人[3]提出的UNIMO模型,统一了单模态、多模态模型的训练方式,既可以利用海量的单模态数据,又能将多模态信号统一在一个语义空间内促进理解。

UNIMO的核心网络是Transformer,同时为图像和文本输入学习统一的语义表示。图像和文本数据分别通过预训练的Faster R-CNN和Bert进行特征提取和表示,多模态图文对数据被转换为图像表示序列和文本表示序列的拼接。

这三种类型数据共享模型参数,经过多层注意力机制后得到图像文本信息统一的语义表示,UNIMO结构如图4所示。其训练方式类似Bert, 此外论文还提出了一种跨模态对比学习的新预训练方法。

在多模态任务上, UNIMO超过了诸如ViLBERT、VLP、UNITER、Oscar、Villa等最新的多模预训练模型。而且在单模态任务上也取得了不错的效果,如图5(b)所示。

4. 视觉物体锚点模型

前面的几个模型只是将图像区域特征和文本特征连接起来作为输入,并不参考任何对齐线索,利用Transformer的self-attention机制,让模型自动学习整张图像和文本的语义对齐方式。Oscar的作者[4]提出把物体用作图像和文本语义层面上的锚点(Anchor Point),以简化图像和文本之间的语义对齐的学习任务。

使用Faster R-CNN等预训练物体检测器 ,将图像表示为一组图像区域特征,每个图像区域特征分配一个物体标签,同时使用预训练后的BERT得到物体标签的词嵌入表示。

该模型在共享空间中显式地将图像和文本关联在一起,物体则扮演图像、文本语义对齐中锚点的角色。在此例中,由于视觉重叠区域,“狗”和“沙发”在图像区域特征空间中相似,在单词嵌入空间中有所差异。

经过实验测试,该模型的性能在多个任务上已经超过SOTA模型。下表中 SoTAS、 SoTAB、和SoTAL分别表示小规模模型、与Bert-base和Bert-large规模相近的VLP模型。OscarB和OscarL分别是基于Bert-base和Bert-large训练的Oscar模型。

5. 总结

目前多模态研究已经取得了较大进展,但如果以构建能感知多模态信息并利用多模态信息跨越语义鸿沟的智能系统为目标,那么现在的研究仍处于初级阶段,既面临着挑战,也存在着机遇。在未来,多模态表示学习、多模态情感分析以及任务导向的大规模多模态人机交互系统等方向的发展值得我们关注。

Reference

[1] Lu J , Batra D , Parikh D , et al. ViLBERT: Pretraining Task-Agnostic Visiolinguistic Representations for Vision-and-Language Tasks[J]。 2019.

[2] Su W , Zhu X , Y Cao, et al. VL-BERT: Pre-training of Generic Visual-Linguistic Representations[J]。 2019.

[3] Li W , Gao C , Niu G , et al. UNIMO: Towards Unified-Modal Understanding and Generation via Cross-Modal Contrastive Learning[J]。 2020.

[4] Li X , Yin X , Li C , et al. Oscar: Object-Semantics Aligned Pre-training for Vision-Language Tasks[M]。 2020.

原文:李晓辰

编辑:jq

-

图像

+关注

关注

2文章

1078浏览量

40364 -

计算机视觉

+关注

关注

8文章

1694浏览量

45889 -

深度学习

+关注

关注

73文章

5456浏览量

120855 -

自然语言处理

+关注

关注

1文章

593浏览量

13473

原文标题:多模态预训练模型简述

文章出处:【微信号:NLP_lover,微信公众号:自然语言处理爱好者】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

Meta发布多模态LLAMA 3.2人工智能模型

卷积神经网络在文本分类领域的应用

李未可科技正式推出WAKE-AI多模态AI大模型

韩国Kakao宣布开发多模态大语言模型“蜜蜂”

自动驾驶和多模态大语言模型的发展历程

语音识别技术最新进展:视听融合的多模态交互成为主要演进方向

人工智能领域多模态的概念和应用场景

大模型+多模态的3种实现方法

千亿参数多模态大模型,“紫东太初”规模化应用加速

任意文本、视觉、音频混合生成,多模态有了强大的基础引擎CoDi-2

用语言对齐多模态信息,北大腾讯等提出LanguageBind,刷新多个榜单

简述文本与图像领域的多模态学习有关问题

简述文本与图像领域的多模态学习有关问题

评论