AMD祭出杀手锏,首个百亿亿级GPU

在不久前结束的 “加速数据中心”发布会上,AMD正式公开了下一代服务器CPU Milan-X和GPU加速卡Instinct MI200。这两大产品系列不仅面向数据中心,也将面向一系列HPC和超算应用,把通用计算和AI性能推向极致。Instinct MI200作为GPU加速卡,更是成为超级计算机百亿亿级(Exascale)的算力的基本构成单元。

在市场合作上,AMD更是开始了新一轮的攻城略地,前不久刚和腾讯联合发布了星星海服务器产品后,如今Azure等一众公有云厂商也开始部署基于Milan-X的服务器,甚至将刚改名为Meta的Facebook也被拉拢至AMD阵营,宣布将在其数据中心部署AMD的服务器产品。

Milan-X:6nm的大缓存怪兽

继上一代Milan处理器推出后不到一年,AMD就发布了该芯片的6nm改进版Milan-X。今年上半年通过融合Chiplet和Die堆叠两大技术,在Ryzen桌面处理器上做了3D Chiplet架构的演示。如今第三代Epyc处理器Milan-X,将成为首个使用该技术的服务器产品。通过在Chiplet上堆叠缓存,Milan-X的L3缓存是Milan的三倍,达到了可怕的768MB。

MilanX / AMD

与英特尔一样,AMD在正式发售前并没有公布Milan-X的具体性能细节,而是通过合作伙伴的测试来展示了Milan-X在EDA和公有云应用中表现。在新思的VCS功能验证中,Milan-X在1小时内完成了40.6项任务,而同样核心数的Milan仅完成了24.4项。微软在基于Milan-X的Azure服务器中进行了早期测试,无论是在航天模拟,还是在汽车碰撞测试建模中,Milan-X都做到了50%以上的性能提升。

除此之外,AMD CEO苏资丰博士还透露了下一代5nm Epyc处理器Genoa的情报。基于Zen 4架构的Genoa将具备2倍的晶体管密度和2倍的能效,性能可以达到上一代的1.25倍以上。Genoa最高支持96个Zen 4核心,同时也将加入一系列新标准的支持,比如DDR5、PCIe 5.0和CXL。AMD还将推出基于5nm的Zen 4C核心的处理器Bergamo,专门针对要求多核多线程的云原生计算,最高核心数将达到128核,晚于Genoa发布。

Genoa计划在2022年量产和发布,届时很可能就是英特尔的Sapphire Rapids和AMD的Genoa在通用计算领域争雄了。

Instinct MI200:GPU终于迎来MCM时代了?

除了Milan-X之外,发布会的最大亮点其实是全球首个MCM GPU,Instinct MI200。同样基于台积电的6nm工艺,Instinct MI200系列单芯片的晶体管数目达到580亿,最高集成了220个计算单元。作为首个采用AMD CDNA2架构的服务器GPU,Instinct MI200的目标很明确,那就是将计算能力推向ExaScale级。

在CDN2架构和第二代HPC&AI专用矩阵核心的支持下,Instinct MI200实现了远超竞品的性能表现。数据对比环节,AMD选择拿Nvidia目前最强的A100加速卡开刀。MI250X的FP64向量计算能力达到47.9TF,FP64矩阵计算能力达到95.7TF,均为A100的4.9倍。而在AI领域常用的FP16和BF16矩阵计算中,MI250X的算力也达到了383TF,是A100的1.2倍。即便两者都用上了HBM2E,MI200的内存带宽也达到了3.2TB/s,远超A100的2TB/s。不过MI250X的功耗确实要高出不少,峰值状态下的功耗可以达到560W,而A100的峰值功耗为300W。

与英特尔这种IDM厂商不同,AMD在封装上基本吃透了与台积电合作带来的技术红利,尤其是台积电的3D Fabric封装技术集合,而Instinct MI200则是这些技术的集大成之作。作为首个采用多Die设计的GPU,Instinct MI200选用了两个SoC+8个HBM2E的方案,AMD在发布会上宣称这一设计的实现要归功于2.5D的Elevated Fanout Bridge(EFB)架构。

从图解上来看,AMD的EFB与台积电的InFO-L 2.5D封装技术可以说是从一个模子里刻出来的。在专门用于HBM集成的方案,目前可以做到这种规模的异构似乎也只有台积电的InFO-L和CoWoS-L,利用LSI(本地硅互联)芯片,为SoC到SoC与SoC到HBM提供高布线密度的互联。

其实英特尔也有类似的2.5D封装方案EMIB,只不过该方案是在基板内放入一个硅桥die。而反观AMD的EFB和台积电的LSI方案则是将其至于基板的模具中,模具内分布着一系列铜柱。相较之下,EMIB虽然可以做到更低的寄生电感,却也对于基板的加工提出了很高的要求,这也是为何只有英特尔这个基板大厂才使用EMIB的原因之一。不过随着IDM 2..0模式的展开,英特尔也将公开提供自己的制程、IP和封装技术,未来也许会有其他厂商的芯片开始用上EMIB。但目前来看,虽然增加了高度控制的挑战,但为了使用标准的基板降低成本,EFB和LSI明显是最优解。

在外观尺寸上,AMD选择了OAM和PCIe两种形式。OAM为开放计算项目(OCP)定下的通用加速器模组标准,对于想要规模化部署GPU或其他加速器来说,OAM可以提供更大的带宽。作为Facebook和微软共同推行的公开标准,OAM已经在服务器领域有了不小的规模,不仅是英特尔、AMD和英伟达这些半导体厂商,浪潮、联想、百度和阿里巴巴等其他服务器与公有云厂商也开始支持这一标准。

目前OAM的MI250和MI250X已经进入可交付阶段,从今年第三季度起,AMD就已经在为美国能源部的橡树岭国家实验室持续交付MI250X GPU了,用于组成美国首个ExaScale级别的超级计算机Frontier。除了OAM模组外,AMD也将在不久提供PCIe版本的MI210,用于非密集运算的场景。

结语

随着英特尔、三星和台积电在2.5D/3D封装技术上的逐渐成熟,服务器芯片将成为受益最大的产品,未来2+8甚至3+8的MCM GPU可能更加常见。英伟达、AMD与英特尔三家在服务器/数据中心市场上的动向,也侧面体现了IDM与Fabless厂商之间在技术选择上的差异。英特尔如果不能尽快在制程和封装上超越台积电这样的晶圆代工厂,在服务器市场的优势可能会越来越小。

在不久前结束的 “加速数据中心”发布会上,AMD正式公开了下一代服务器CPU Milan-X和GPU加速卡Instinct MI200。这两大产品系列不仅面向数据中心,也将面向一系列HPC和超算应用,把通用计算和AI性能推向极致。Instinct MI200作为GPU加速卡,更是成为超级计算机百亿亿级(Exascale)的算力的基本构成单元。

在市场合作上,AMD更是开始了新一轮的攻城略地,前不久刚和腾讯联合发布了星星海服务器产品后,如今Azure等一众公有云厂商也开始部署基于Milan-X的服务器,甚至将刚改名为Meta的Facebook也被拉拢至AMD阵营,宣布将在其数据中心部署AMD的服务器产品。

Milan-X:6nm的大缓存怪兽

继上一代Milan处理器推出后不到一年,AMD就发布了该芯片的6nm改进版Milan-X。今年上半年通过融合Chiplet和Die堆叠两大技术,在Ryzen桌面处理器上做了3D Chiplet架构的演示。如今第三代Epyc处理器Milan-X,将成为首个使用该技术的服务器产品。通过在Chiplet上堆叠缓存,Milan-X的L3缓存是Milan的三倍,达到了可怕的768MB。

MilanX / AMD

与英特尔一样,AMD在正式发售前并没有公布Milan-X的具体性能细节,而是通过合作伙伴的测试来展示了Milan-X在EDA和公有云应用中表现。在新思的VCS功能验证中,Milan-X在1小时内完成了40.6项任务,而同样核心数的Milan仅完成了24.4项。微软在基于Milan-X的Azure服务器中进行了早期测试,无论是在航天模拟,还是在汽车碰撞测试建模中,Milan-X都做到了50%以上的性能提升。

除此之外,AMD CEO苏资丰博士还透露了下一代5nm Epyc处理器Genoa的情报。基于Zen 4架构的Genoa将具备2倍的晶体管密度和2倍的能效,性能可以达到上一代的1.25倍以上。Genoa最高支持96个Zen 4核心,同时也将加入一系列新标准的支持,比如DDR5、PCIe 5.0和CXL。AMD还将推出基于5nm的Zen 4C核心的处理器Bergamo,专门针对要求多核多线程的云原生计算,最高核心数将达到128核,晚于Genoa发布。

Genoa计划在2022年量产和发布,届时很可能就是英特尔的Sapphire Rapids和AMD的Genoa在通用计算领域争雄了。

Instinct MI200:GPU终于迎来MCM时代了?

除了Milan-X之外,发布会的最大亮点其实是全球首个MCM GPU,Instinct MI200。同样基于台积电的6nm工艺,Instinct MI200系列单芯片的晶体管数目达到580亿,最高集成了220个计算单元。作为首个采用AMD CDNA2架构的服务器GPU,Instinct MI200的目标很明确,那就是将计算能力推向ExaScale级。

在CDN2架构和第二代HPC&AI专用矩阵核心的支持下,Instinct MI200实现了远超竞品的性能表现。数据对比环节,AMD选择拿Nvidia目前最强的A100加速卡开刀。MI250X的FP64向量计算能力达到47.9TF,FP64矩阵计算能力达到95.7TF,均为A100的4.9倍。而在AI领域常用的FP16和BF16矩阵计算中,MI250X的算力也达到了383TF,是A100的1.2倍。即便两者都用上了HBM2E,MI200的内存带宽也达到了3.2TB/s,远超A100的2TB/s。不过MI250X的功耗确实要高出不少,峰值状态下的功耗可以达到560W,而A100的峰值功耗为300W。

与英特尔这种IDM厂商不同,AMD在封装上基本吃透了与台积电合作带来的技术红利,尤其是台积电的3D Fabric封装技术集合,而Instinct MI200则是这些技术的集大成之作。作为首个采用多Die设计的GPU,Instinct MI200选用了两个SoC+8个HBM2E的方案,AMD在发布会上宣称这一设计的实现要归功于2.5D的Elevated Fanout Bridge(EFB)架构。

从图解上来看,AMD的EFB与台积电的InFO-L 2.5D封装技术可以说是从一个模子里刻出来的。在专门用于HBM集成的方案,目前可以做到这种规模的异构似乎也只有台积电的InFO-L和CoWoS-L,利用LSI(本地硅互联)芯片,为SoC到SoC与SoC到HBM提供高布线密度的互联。

其实英特尔也有类似的2.5D封装方案EMIB,只不过该方案是在基板内放入一个硅桥die。而反观AMD的EFB和台积电的LSI方案则是将其至于基板的模具中,模具内分布着一系列铜柱。相较之下,EMIB虽然可以做到更低的寄生电感,却也对于基板的加工提出了很高的要求,这也是为何只有英特尔这个基板大厂才使用EMIB的原因之一。不过随着IDM 2..0模式的展开,英特尔也将公开提供自己的制程、IP和封装技术,未来也许会有其他厂商的芯片开始用上EMIB。但目前来看,虽然增加了高度控制的挑战,但为了使用标准的基板降低成本,EFB和LSI明显是最优解。

在外观尺寸上,AMD选择了OAM和PCIe两种形式。OAM为开放计算项目(OCP)定下的通用加速器模组标准,对于想要规模化部署GPU或其他加速器来说,OAM可以提供更大的带宽。作为Facebook和微软共同推行的公开标准,OAM已经在服务器领域有了不小的规模,不仅是英特尔、AMD和英伟达这些半导体厂商,浪潮、联想、百度和阿里巴巴等其他服务器与公有云厂商也开始支持这一标准。

目前OAM的MI250和MI250X已经进入可交付阶段,从今年第三季度起,AMD就已经在为美国能源部的橡树岭国家实验室持续交付MI250X GPU了,用于组成美国首个ExaScale级别的超级计算机Frontier。除了OAM模组外,AMD也将在不久提供PCIe版本的MI210,用于非密集运算的场景。

结语

随着英特尔、三星和台积电在2.5D/3D封装技术上的逐渐成熟,服务器芯片将成为受益最大的产品,未来2+8甚至3+8的MCM GPU可能更加常见。英伟达、AMD与英特尔三家在服务器/数据中心市场上的动向,也侧面体现了IDM与Fabless厂商之间在技术选择上的差异。英特尔如果不能尽快在制程和封装上超越台积电这样的晶圆代工厂,在服务器市场的优势可能会越来越小。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

amd

+关注

关注

25文章

5505浏览量

134754 -

cpu

+关注

关注

68文章

10922浏览量

213281 -

gpu

+关注

关注

28文章

4795浏览量

129500

发布评论请先 登录

相关推荐

AMD集成DeepSeek-V3模型至Instinct MI300X GPU

AMD近日宣布了一项重要的技术进展,即将全新的DeepSeek-V3模型成功集成到其旗舰级GPU产品——Instinct MI300X上。这一举措标志着AMD在人工智能推理领域迈出了坚

《CST Studio Suite 2024 GPU加速计算指南》

的各个方面,包括硬件支持、操作系统支持、许可证、GPU计算的启用、NVIDIA和AMD GPU的详细信息以及相关的使用指南和故障排除等内容。

1. 硬件支持

- NVIDIA GPU

发表于 12-16 14:25

基站和雷达知识介绍

前文说到5G-A相比5G初期版本最大的杀手锏是新增的通感一体(ISAC,integrated sensing and communication)能力。

之所以被称为杀手锏,是因为通感一体第一次在通信基站上,实现了非通信的能力——感知,通感一体的感字即来源于此。

AMD发布10亿参数开源AI模型OLMo

AMD公司近日宣布了一项重大进展,推出了首个完全开放的10亿参数语言模型系列——AMD OLMo。这一举措为开发者和研究人员提供了强大的AI研究工具,有助于推动AI技术的进一步发展。

软银升级人工智能计算平台,安装4000颗英伟达Hopper GPU

达Ampere GPU。通过新增的4000颗Hopper GPU,该平台的总计算性能已跃升至每秒约4.7百亿亿次。

AMD与NVIDIA GPU优缺点

在图形处理单元(GPU)市场,AMD和NVIDIA是两大主要的竞争者,它们各自推出的产品在性能、功耗、价格等方面都有着不同的特点和优势。 一、性能 GPU的性能是用户最关心的指标之一。在高端市场

三星首度引入AMD MI300X,缓解AI GPU短缺

三星电子近日斥资约270亿韩元(约合1.42亿元人民币),购买了AMD Instinct MI300X加速器。这一举措标志着三星电子首次引入非英伟达品牌的AI GPU,以应对企业内部算

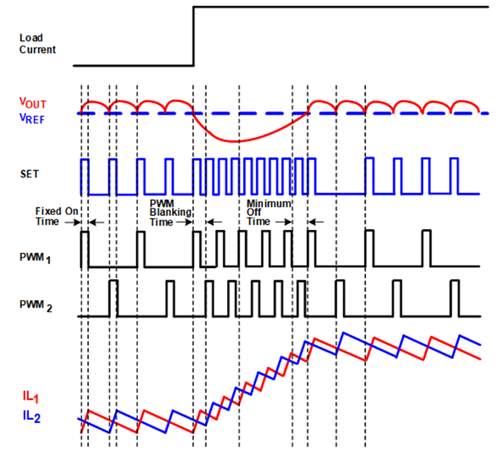

下一代GPU的预测瞬态仿真分析

图形处理单元(GPU)不断迭代更新,其中的晶体管数目也不断增加以提高处理器性能。如今这个数目已达到数百亿的级别,与此同时,功率需求也相应呈指数级增长,这让满足瞬态响应规范变得极为困难。

英国公司实现英伟达CUDA软件在AMD GPU上的无缝运行

7月18日最新资讯,英国创新科技企业Spectral Compute震撼发布了其革命性GPGPU编程工具包——“SCALE”,该工具包实现了英伟达CUDA软件在AMD GPU上的无缝迁移与运行,标志着在GPU计算领域,NVIDI

AMD雄心勃勃:计划构建百万级GPU超级计算机集群

在全球科技竞赛的舞台上,AMD近日宣布了一项令人瞩目的计划——打造一个包含多达120万颗GPU的超级计算机集群。这一宏大的举措立即引发了业界的广泛关注,许多人认为,这是AMD为了与英伟达等竞争对手一较高下而迈出的重要一步。

AMD发布ROCm更新,新增RX 8000系列GPU的Navi 44命名

首款Navi 48芯片以Gfx1201之名现身,而Navi 44则以Gfx1200之名亮相。这两款GPU的出现,至少暗示了AMD正在逐步完善RDNA 4 GPU的研发工作。

AMD计划在台投资设立研发中心

近日证实,继英伟达在台设立亚洲首个AI研发中心后,全球知名的半导体公司超威半导体(AMD)也将紧随其后,在台湾投资设立研发中心。据悉,AMD计划投资高达50亿元新台币,这一决策无疑将为

英伟达、AMD、英特尔GPU产品及优势汇总

主导地位,其销售额预计将达到400亿美元,远超过竞争对手AMD和英特尔。那么这三家公司都有哪些GPU产品,各自的产品有何优势呢? 英伟达

AMD市值首次突破3000亿美元

AMD的市值首次突破了3000亿美元,这一里程碑式的成就得益于该公司股价的大幅上涨。上周四,AMD的股价上涨了9.1%,使得其市值首次突破了3000亿美元。相较于去年10月的低点,

AMD收盘市值站上3100亿美元

AMD收盘市值站上3100亿美元 受益人工智能的热炒,相关的科技股股价大幅上涨,周四晚间美股AMD股价大幅上涨9%,AMD收盘时市值站上3100亿

AMD祭出杀手锏,首个百亿亿级GPU

AMD祭出杀手锏,首个百亿亿级GPU

评论