导语

随着互联网、大数据、云计算、高性能计算的快速发展,数据中心面临着严峻的挑战。主要归结于GPU驱动应用程序推动,使得业务和IT增长需协调一致。随着数据中心内部温度升高,运营商正争先恐后地寻找可行、更节能的散热解决方案。在此我们将讨论其中最可行和最实用的冷却方法,并对比分析风冷冷却和液体冷却。

1 冷却技术运作原理

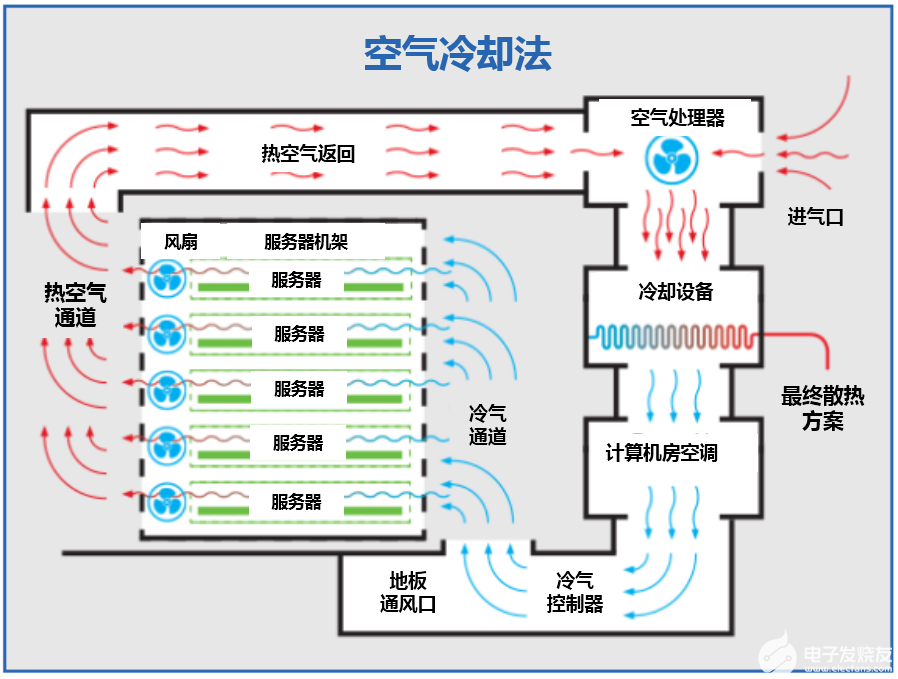

风冷冷却

传统的风冷数据中心通过空气处理机上的进气口将外部空气带入。空气被计算机房空调(CRAC)单元冷却,然后在高架地板带动下进入服务器机架"冷过道"。冷空气通过并冷却服务器,然后离开"热通道",通过充气室排放返回空气处理器。

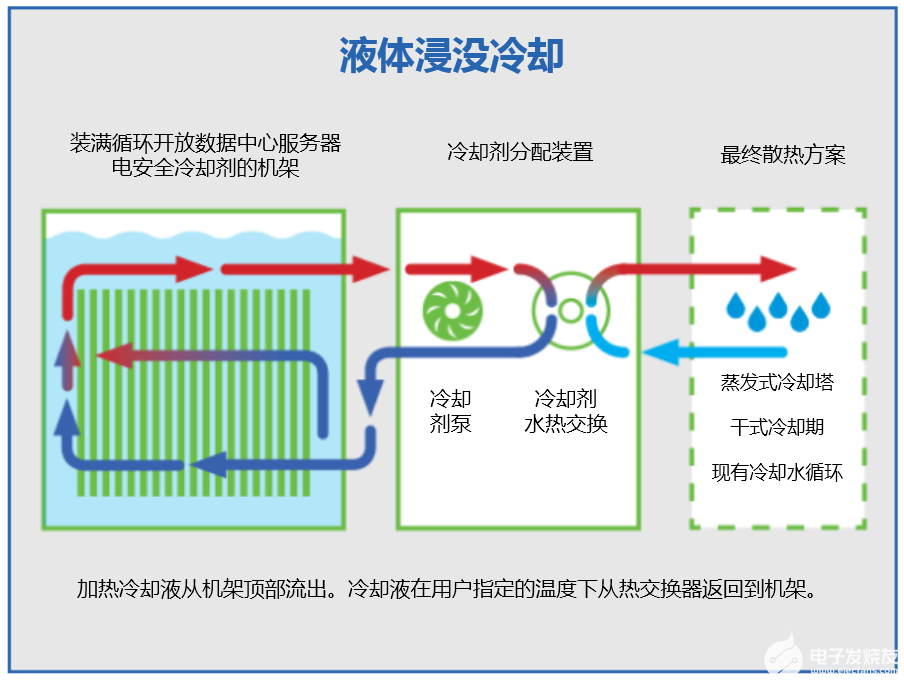

液体冷却

液体冷却的工作原理是:液体相较于空气是更好的热导体。

服务器垂直安装在水平定向的介质(电非导电)流体冷却液槽中。

冷却液通过与服务器组件的直接接触传递热量。

加热的冷却液从机架顶部流出,并在机架和连接到温水回路的冷却分配单元(CDU)之间循环。另一侧包含冷却塔或干式冷却器作为散热最终形式。

冷却的液体从热交换器返回到机架。

2 复杂性和前期成本

风冷冷却

看似简单的服务器机架系统实际上有很多活动部件:高架地板,通道遏制策略,冷却器,空气处理器,湿度控制,过滤系统和增压室的某种组合。为了支持上述功能,风冷数据中心还必须运行相对较大的辅助基础设施(特别是备用发电机、UPS和电池)。

这些必要的复杂性等同于相对较大资本支出(CAPEX)。

液体冷却

自 2009 年开创该技术以来,一直在挖掘液体冷却的最大价值(简单性)。

考虑只需三个活动部件:冷却液泵,水泵和冷却塔,干式冷却风扇,并且不需要高架地板,也不需要通过通道封闭浪费空间。液体冷却可以将数据中心的资本支出降低50%甚至更低。

由于机架可以紧密地间隔在一起,液体冷却不需要对气流进行CFD分析,甚至可放置在裸露的混凝土地板上。电气支持系统缩小尺寸。

在假设简单性会影响性能之前,补充一点说明GRC ICEraQ™系统可以轻松冷却100 kW /机架(甚至更高),远远超过最好的风冷操作能力。

3 效率和运营费用

风冷冷却

显而易见空气是比液体更有效的热导体(效率低1200倍) 。不仅使风冷数据中心本质上效率降低,而且会产生连锁反应,对运营费用产生严重影响。

风扇占服务器功耗的20%。为提高空气有效性,需冷却器和空气处理器等消耗能源的制冷组件。这些反过来又会影响电力基础设施规模。

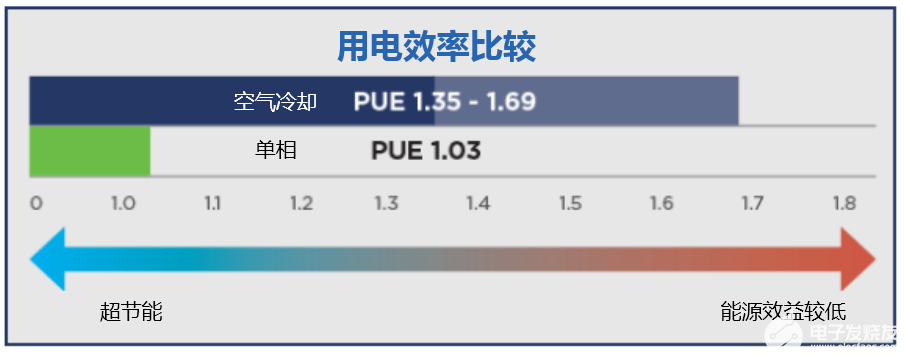

鉴于上述情况,风冷冷却需要数据中心技术中极高的运营费用,同时大约产出1.35至1.69的PUE。

液体冷却

用三个移动部件(GRC移除风扇以优化服务器浸入式),零制冷组件,大大降低基础设施要求,液体冷却使冷却能量减少90%,数据中心总能耗降低50%。因此,可以实现<1.03的PUE。

从电力角度来看,风冷冷却基础设施不仅增加成本,而且还可能附带高昂的维护费用。液体冷却则没有这些问题。

4 冷却能力和高密度性能

风冷冷却

确实,一些风冷数据中心能够冷却30-35 kW机架。但实际上,风冷数据中心在15 kW 机架以上非常低效。

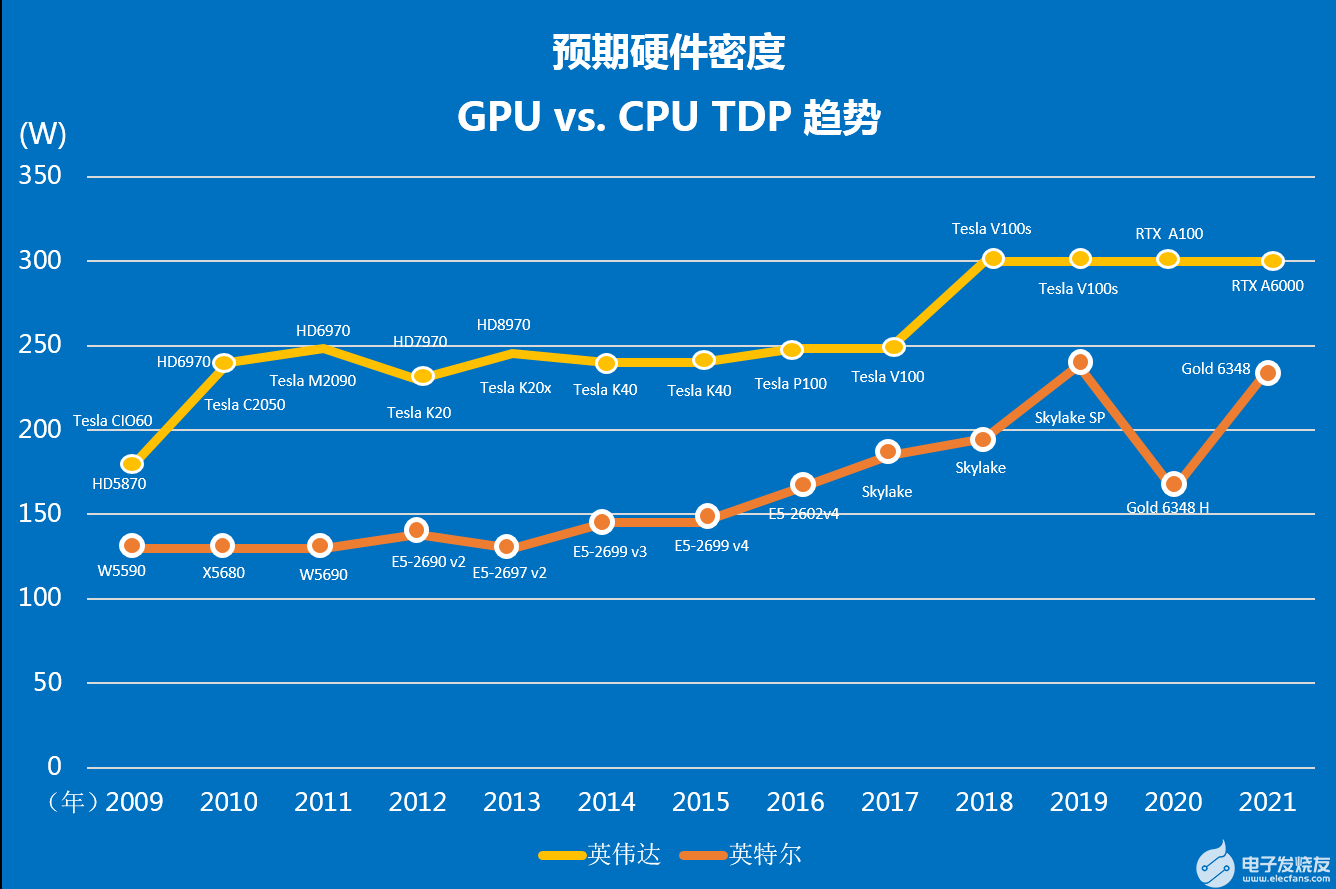

行业趋势使形势变得更为严峻。耗电 GPU 正在进军,以应对物联网和 AI 等 HPC 应用。用一个例子说明,英特尔®的新Skylake版本消耗高达250 W的能量。将其中两个放在1U服务器上,为其他电子设备添加200 W以上,乘以40服务器,基于CPU的系统则有28 kW。添加处理器和加速器,将远远超出风冷冷却的限制。

为满足以上需求,数据中心运营商倾向于创建混合密度的机架。就风冷而言,不可避免地会导致热点,从而导致硬件故障。

值得一提的是,硬件演变将为风冷数据中心的运营商(下一次硬件更新)带来真正的清算时刻。

液体冷却

GRC ICEraQ™和 ICEtank™系统通过精心设计突破热障,将数据中心计算带入下一次演进,甚至更进一步。任何一种解决方案都可以轻松冷却每个机架高达100 kW的功率,理论上与冷却液一起使用时可以冷却高达200 kW的功率。

4 可靠性和位置灵活性

风冷冷却

任何风冷冷却技术都注定要面临硬件可靠性问题。究其原因在于IT资产暴露于潜在有害的空气污染物以及空气本身的不利影响(主要指腐蚀和氧化)。

风险取决于空气质量和无调节空气本身的自然湿度水平。显然,湿度高、空气污染或风吹颗粒物的地方都可能会对数据中心造成严重破坏。随着对远程边缘部署的需求增加,这些问题也会凸显出来。

说到位置灵活性,风冷冷却固有的复杂性和巨大的基础设施要求为数据中心的放置带来重大障碍。

综上所述,即便采用最佳的通道布置方法,传统的风冷冷却也会产生导致硬件故障的热点。

液体冷却

三个主要因素使液体冷却在此类别中得分最高:

市场上最简单实用冷却形式。出错的更少:没有冷却器,空气处理器,湿度控制等;并且没有服务器风扇来产生可以增加MTBF(平均故障间隔时间)的振动。

沉浸式处理,使IT资产与外部空气完全隔离,从而消除环境问题。

数据中心中没有热点。事实上,ICEraQ或ICEtank系统中的任何两个点都在两个温度范围内工作。

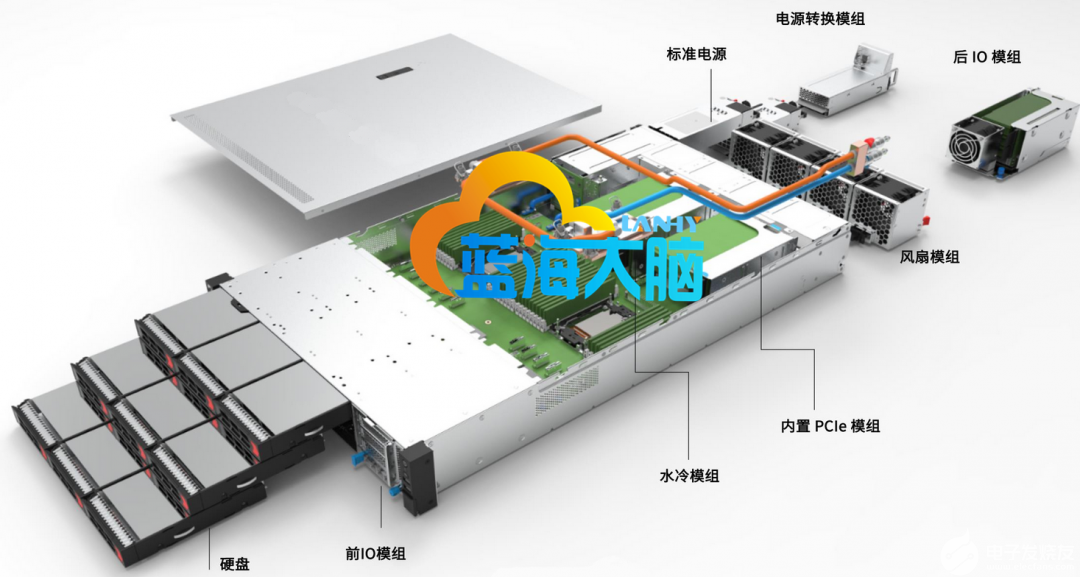

5 蓝海大脑水冷GPU服务器

基于蓝海大脑超融合平台的水冷GPU服务器及水冷GPU工作站采用 Gluster 分布式架构设计提供大存储量,拥有开放融合的特性和超能运算的能力。支持多块GPU显卡,提供出色的静音效果和完美的温控系统。借助 NVIDIA GPU计算卡可加快神经网络的训练和推理速度,更快地创作精准的光照渲染效果,提供高速视频、图像、声音等处理能力,加速AI 并带来更流畅的交互体验。

6 总结

综上所述,随着数据中心的规模越来越大,部署的机架越来越密集,对服务器负载的要求越加苛刻,传统的风冷冷却技术不再满足数据中心的制冷要求。为解决这个问题,很多企业在其数据中心开始采用液体冷却技术。

审核编辑:符乾江

-

服务器

+关注

关注

12文章

9165浏览量

85438 -

数据中心

+关注

关注

16文章

4779浏览量

72133

发布评论请先 登录

相关推荐

GPU云服务器租用费用贵吗

GPU云服务器租用多少钱

租用GPU服务器一般多少钱

GPU高性能服务器配置

GPU服务器用途

GPU云服务器架构解析及应用优势

gpu服务器与cpu服务器的区别对比,终于知道怎么选了!

算力服务器为什么选择GPU

风冷GPU服务器和水冷GPU服务器的综合分析

风冷GPU服务器和水冷GPU服务器的综合分析

评论