电子发烧友网报道(文/程文智)GTC大会自2020年开始举办后,成为了AI开发者非常关注的一个会议,每次会议,NVIDIA的CEO黄仁勋都会发布一个主题演讲,会介绍NVIDIA最新的进展,以及重磅新品。本次GTC 2022春季大会也不例外。

GTC2022依然是在线上举办,NVIDIA首席执行官黄仁勋在数字孪生技术支持下的虚拟NVIDIA总部大楼里发表了主题演讲。在他看来,随着AI技术的发展,AI的发展方向也在发生着改变,“第一波AI学习是感知和推理,比如图像识别、语音理解、推荐视频或商品;下一波AI的发展方向将是机器人,也就是使用AI来规划行动,数字机器人、虚拟形象和实体机器人将完成感知、规划,并采取行动。”

AI正在各个方向加速发展,包括新的架构、新的学习策略、更大和更可靠的模型,同时,AI也在很多新的科学、新的应用、新的行业等方面加速发展。比如说,如今的AI不仅学习理解图像、声音和语言,还正在学习生物学、化学,甚至是量子物理学等等。

“数据中心规模的加速计算于机器学习相结合,可以将计算速度提高百万倍。正式由于加速计算的推动,像Transfermer这样的革命性AI模型和自监督学习成为了可能。”黄仁勋特别指出,“各公司都在处理和完善自己的数据、开发AI软件,并使自己成为智能的生产商。他们 数据中心正在逐步演变为AI工厂。”这也意味着AI工厂时代的来临。

为了应对AI工厂时代对AI的需求,NVIDIA带来了全新的Hopper架构H100 GPU芯片、Grace CPU超级芯片、DGX H100系统、DGX SuperPOD、融合加速器H100 CNX、AI 超级计算机NVIDIA Eos、Spectrum-4、Jetson AGX Orin开发者套件等一系列新品。下面就让我们来看一看这些新品都有什么特别之处。

H100 GPU:全新Hopper架构,800亿个晶体管

NVIDIA H100 GPU集成了800亿个晶体管,它也是NVIDIA发布的首款采用Hopper架构的GPU。Hopper架构是以美国计算机领域的先驱科学家Grace Hopper 的名字命名的,它将取代两年前推出的 NVIDIA Ampere架构。

据黄仁勋介绍,H100 是全球范围内最大的性能出众的加速器,拥有革命性的 Transformer 引擎和高度可扩展的 NVIDIA NVLink互连技术等突破性功能,可推动庞大的 AI 语言模型、深度推荐系统、基因组学和复杂数字孪生的发展。

从技术角度来看,H100带来了6项突破性创新:

强大的性能 —— H100 由 800 亿个晶体管构建而成,这些晶体管采用了专为 NVIDIA 加速计算需求设计的TSMC 4N工艺,因而能够显著提升AI、HPC、显存带宽、互连和通信的速度,并能够实现近 5TB/s 的外部互联带宽。H100 是首款支持 PCIe 5.0 的 GPU,也是首款采用 HBM3 的 GPU,可实现 3TB/s 的显存带宽。20个 H100 GPU 便可承托相当于全球互联网的流量,使其能够帮助客户推出先进的推荐系统以及实时运行数据推理的大型语言模型。

新的 Transformer 引擎 —— Transformer 现在已成为自然语言处理的标准模型方案,也是深度学习模型领域最重要的模型之一。H100 加速器的 Transformer 引擎旨在不影响精度的情况下,将这些网络的速度提升至上一代的六倍。

第二代安全多实例 GPU —— MIG 技术支持将单个 GPU 分为七个更小且完全独立的实例,以处理不同类型的作业。与上一代产品相比,在云环境中 Hopper 架构通过为每个 GPU 实例提供安全的多租户配置,将 MIG 的部分能力扩展了 7 倍。

机密计算 —— H100 是全球首款具有机密计算功能的加速器,可保护 AI 模型和正在处理的客户数据。客户还可以将机密计算应用于医疗健康和金融服务等隐私敏感型行业的联邦学习,也可以应用于共享云基础设施。

第 4 代 NVIDIA NVLink —— 为加速大型 AI 模型,NVLink 结合全新的外接 NVLink Switch,可将 NVLink 扩展为服务器间的互联网络,最多可以连接多达 256 个 H100 GPU,相较于上一代采用 NVIDIA HDR Quantum InfiniBand网络,带宽高出9倍。

DPX 指令 —— 新的 DPX 指令可加速动态规划,适用于包括路径优化和基因组学在内的一系列算法,与 CPU 和上一代 GPU 相比,其速度提升分别可达 40 倍和 7 倍。Floyd-Warshall 算法与 Smith-Waterman 算法也在其加速之列,前者可以在动态仓库环境中为自主机器人车队寻找最优线路,而后者可用于 DNA 和蛋白质分类与折叠的序列比对。

具体来说,H100 将支持聊天机器人使用功能超强大的monolithic Transformer 语言模型 Megatron 530B,吞吐量比上一代产品高出 30 倍,同时满足实时对话式 AI 所需的次秒级延迟。利用 H100,研究人员和开发者能够训练庞大的模型,如包含 3950 亿个参数的混合专家模型,训练速度加速高达9倍,将训练时间从几周缩短到几天。

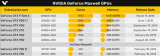

H100将提供SXM和PCIe两种规格,可满足各种服务器设计需求。NVIDIA H100 SXM 提供 4 GPU 和 8 GPU 配置的 HGX H100 服务器主板,主要用于高性能服务器,可助力企业将应用扩展至一台服务器和多台服务器中的多个 GPU。H100 PCIe相对来说更加实惠,用于主流服务器。与上一代相比,这两种外形尺寸的功率要求都显著提高。

NVIDIA为SXM版本的显卡提供了700W TDP,比A100官方的400W TDP高出了75%。官方推荐的冷却方式是风冷和液冷两种。但在如此功率下,估计液冷会更受用户青睐,毕竟这个价格不菲,要是由于散热问题而导致出问题就不划算了。

同时,H100 PCIe卡的TDP提高到了350W,冷却方式也是风冷和液冷两种。当然,如果像降低散热压力,也可以通过配置方式来降低显卡的功耗,只是这么做就要牺牲一些性能了。

为了将Hopper的强大算力引入主流服务器,英伟达推出了全新的融合加速器H100 CNX。它将网络与GPU直接相连,耦合H100 GPU与英伟达ConnectX-7 400Gb/s InfiniBand和以太网智能网卡,使网络数据通过DMA以50GB/s的速度直接传输到H100,能够避免带宽瓶颈,为I/O密集型应用提供更强劲的性能。

Grace CPU超级芯片:144个CPU核心

除了GPU产品,NVIDIA还发布了其第一款转为数据中心设计的,基于Arm Neoverse的数据中心专属CPU------ Grace CPU超级芯片,其可提供最高的性能,是当今领先服务器芯片内存带宽和能效的两倍。

NVIDIA Grace CPU超级芯片由两个CPU芯片组成,它们之间通过NVLink-C2C互连在一起。NVLink-C2C 是一种新型的高速、低延迟、芯片到芯片的互连技术。

Grace CPU超级芯片是去年NVIDIA发布的首款由 CPU-GPU 集成的“Grace Hopper 超级芯片”的模块,它将与基于 NVIDIA Hopper架构的 GPU一同应用于大型 HPC 和AI 应用。这两款超级芯片采用相同的底层 CPU 架构及 NVLink-C2C 互连。

Grace CPU 超级芯片专为提供最高的性能而打造,能够在单个插座(socket)中容纳 144 个 Arm 核心。NVIDIA宣称,在SPECrate 2017_int_base基准测试中,Grace CPU超级芯片的模拟性能得分为740,据NVIDIA实验室使用同类编译器估算,这一结果相比当前DGX A100搭载的双CPU高1.5倍以上。

Grace CPU 超级芯片依托带有纠错码的LPDDR5x 内存组成的创新的内存子系统,可实现速度和功耗的最佳平衡。LPDDR5x 内存子系统提供两倍于传统DDR5设计的带宽,可达到每秒1 TB ,同时功耗也大幅降低 ,CPU加内存整体功耗仅500瓦。

此外,Grace CPU 超级芯片基于最新的数据中心架构 Arm v9,具备最高的单线程核心性能,并支持 Arm 新一代矢量扩展。

Grace CPU超级芯片可运行所有的英伟达计算软件栈,结合NVIDIA ConnectX-7网卡,能够灵活地配置到服务器中,或作为独立的纯CPU系统,或作为GPU加速服务器,可以搭配1块、2块、4块或8块基于Hopper的GPU。

也就是说,用户只维护一套软件栈,就能针对自身特定的工作负载做好性能优化。

NVIDIA正在通过 Grace CPU超级芯片扩展其目标市场,现在涵盖超大规模计算、云、数据分析、HPC 和 AI 工作负载,有效地瞄准了通用服务器市场。Grace CPU超级芯片支持NVIDIA的整个CUDA 堆栈,并将运行NVIDIA的所有应用程序,包括NVIDIA RTX、NVIDIA AI、HPC 和 Omniverse。

关于出货方面,Grace CPU超级芯片将于 2023 年上半年开始出货。

DGX H100系统:企业级AI基础设施

第四代 NVIDIA DGX系统,是全球首个基于全新 NVIDIA H100 Tensor Core GPU的AI平台。该系统能够满足大型语言模型、推荐系统、医疗健康研究和气候科学的大规模计算需求。每个 DGX H100 系统配备8块 NVIDIA H100 GPU,并由 NVIDIA NVLink 连接,能够在新的 FP8 精度下达到 32 Petaflop 的 AI 性能,比上一代系统性能高 6 倍。

DGX H100 系统是新一代 NVIDIA DGX POD 和 NVIDIA DGX SuperPOD AI 基础设施平台的构建模块。新的 DGX SuperPOD 架构采用了一个全新的 NVIDIA NVLink Switch 系统,通过这一系统最多可连接 32 个节点,总计 256 块 H100 GPU。 新一代 DGX SuperPOD 提供 1 Exaflops 的 FP8 AI 性能,比上一代产品性能高 6 倍,能够运行具有数万亿参数的庞大 LLM 工作负载,从而推动 AI 的前沿发展。 NVIDIA 创始人兼首席执行官黄仁勋表示:“AI 已经从根本上改变了软件的功能和产出方式。利用 AI 来革新自身所处行业的公司也意识到了自身 AI 基础设施的重要性。NVIDIA 全新 DGX H100 系统将赋能企业 AI 工厂,助力其从数据中提炼出我们最具价值的资源,即‘智能’。"

除了8块 H100 GPU 以及总计 6400 亿个晶体管之外,每个 DGX H100 系统还包含两个 NVIDIA BlueField-3 DPU,以用于卸载、加速和隔离高级网络、存储及安全服务。

8个 NVIDIA ConnectX-7 Quantum-2 InfiniBand 网卡能够提供 400 GB/s 的吞吐量,可用于连接计算和存储,这一速度比上一代系统提升了一倍。第四代 NVLink 与 NVSwitch相结合,能够在每个 DGX H100 系统中的各个 GPU 之间实现 900 GB/s 的连接速度,是上一代系统的 1.5 倍。 DGX H100 系统使用双 x86 CPU,能够与 NVIDIA 网络和 NVIDIA 合作伙伴提供的存储设备相结合,使 DGX POD 能够灵活用于各种规模的 AI 计算。 借助 DGX H100 系统,DGX SuperPOD 可成为具有可扩展性的卓越的企业级 AI 中心。DGX SuperPOD 中的 DGX H100 节点和 H100 GPU 由 NVLink Switch 系统和 NVIDIA Quantum-2 InfiniBand 连接,带宽速度可达 70 TB/s,比上一代产品高 11 倍。NVIDIA 合作伙伴提供的存储设备将经过测试和认证,以满足 DGX SuperPOD AI 计算的需求。

多个 DGX SuperPOD 单元可组合使用,为汽车、医疗健康、制造、通信、零售等行业提供开发大型模型所需的 AI 性能。

NVIDIA Eos:运行速度最快的超计算机

NVIDIA 将使用突破性的新型 AI 架构来构建 DGX SuperPOD,赋能 NVIDIA 研究人员的研究工作,推动气候科学、数字生物学和 AI 未来的发展。 “Eos”超级计算机将于今年晚些时候开始运行,共配备 576 台 DGX H100 系统,共计 4608 块 DGX H100 GPU,有望成为全球运行速度最快的 AI 系统。 NVIDIA Eos 预计将提供 18.4 Exaflops 的 AI 计算性能,比日本的 Fugaku 超级计算机快 4 倍,后者是目前运行速度最快的系统。在传统的科学计算方面,Eos 预计将提供 275 Petaflop 的性能。 对于 NVIDIA 及其 OEM 和云计算合作伙伴,Eos 将成为其先进 AI 基础设施的蓝图。

其他新品

NVIDIA早已经不是一个单纯的芯片供应商了,它们已经转型成了一个全栈公司,除了GPU之外,还提供CPU、DPU产品,甚至还会跟很多OEM等合作伙伴,把整个系统都做出来,而且提供各种加速引擎,或者SDK,针对不同的领域提供不同的解决方案。比如医疗领域的Clara、智慧城市的Metropolis,自动驾驶领域的Drive等等。

在本次GTC大会上,NVIDIA也介绍了相关行业的一些解决方案,比如Clara Holoscan MGX,这是一个可供医疗设备行业在边缘开发和部署实时 AI 应用的平台,专为满足必要的监管标准而设计。

Clara Holoscan MGX 能够扩展 Clara Holoscan 平台,提供一体化的医疗级参考架构以及长期软件支持,以加速医疗设备行业的创新。它通过处理高吞吐量数据流来提供实时洞见,将最新的传感器创新带到了边缘计算。从机器人手术到研究生物学的新方法,外科医生和科学家需要医疗设备逐步发展成为持续传感系统,进而更好地推动疾病的研究和治疗。

Clara Holoscan MGX 将高性能 NVIDIA Jetson AGX Orin 工业级模块、NVIDIA RTX A6000 GPU 和 NVIDIA ConnectX-7 智能网卡整合到一个可扩展的 AI 平台中,提供高达每秒 254-619 万亿次运算的 AI 性能。 对于高吞吐量设备,ConnectX-7 能够提供高达 200 GbE 的带宽以及用于 GPU 处理的 GPUDirect RDMA 路径,有助于加快处理速度。它还集成了最新嵌入式安全模块,该模块包含负责监控关键操作、提供远程软件更新和系统恢复的控制器,以及可实现最先进嵌入式安全的硬件信任根。 医疗设备制造商可以直接嵌入 Clara Holoscan MGX,或将其连接到现有的医疗设备安装平台,从而使开发者能够加速 AI 部署和监管审批。 Clara Holoscan SDK 专为高性能流式数据应用程序而设计,用于构建新一代软件定义设备。它汇集了预训练模型和可扩展微服务框架,允许在设备和边缘数据中心管理和部署应用程序,开创了行业的软件即服务业务模式。Clara Holoscan 开发者套件现已开始供货。

此外,NVIDIA还发布了60多个针对CUDA-X的一系列库、工具和技术的更新,以加速量子计算和6G研究、网络安全、基因组学、药物研发等领域的研究进展。

来自NVIDIA、加州理工学院、伯克利实验室、普渡大学、密歇根大学和莱斯大学的研究人员,开发了一个名为FourCastNet的天气预报AI模型。FourCastNet是一种基于物理信息的深度学习模型,可以预测飓风,大气河、以及极端降水等天气事件。

FourCastNet以欧洲中期天气预报中心长达40年的模拟增强型真值数据为基础,学会了如何预测天气。深度学习模型首次在降水预测方面达到了比先进的数值模型更高的准确率和技能,并使预测速度提高了4到5个数量级。也就是说传统的数值模拟需要一年的时间,而现在只需要几分钟。

大气河是天空中巨大的水汽河流,每条河流的水量都比亚马逊河的还要多。他们一方面为美国西部提供了关键的降水来源,但另一方面,这些巨大的强风暴也会导致灾难性的洪灾和暴雪。

NVIDIA创建了Physics-ML模型,该模型可以模拟全球天气模式的动态变化。以超乎想象的速度和准确性预测大气河等极端天气事件。此GPU加速的AI数字孪生模型名为FourCastNet,由傅里叶神经算子提供动力支持,基于10TB的气球系统数据进行训练,依托这些数据,以及NVIDIA Modulus和Omniverse,我们能够提前一周预测灾难性大气河的精确路线,在一个NVIDIA GPU的助力下,FourCastNet只需要几分之一秒即可完成预测。

在黄仁勋看来,Transformer模型开启了自监督学习,并解除了人工标记数据的需求。因此,我们可以使用庞大的训练集来训练Transformer模型,学习更充分且可靠的特征。

得益于Transformer,模型和数据的规模皆已扩大增长,而模型技能和准确性也因此快速提升。用于语言理解的Google BERT,用于药物研发的NVIDIA MegaMolBart,以及DeepMind的AlphaFold,都是基于Transformer模型的突破性成果。

NVIDIA Triton是一款开源的、超大规模的模型推理服务器,是AI部署的“中央车站”,Triton支持在每一代NVIDIA GPU、X86和Arm CPU上部署模型,并具备支持AWS Inferentia等加速器的接口。Triton支持各类模型:CNN、RNN、Transformer、GNN、决策树,还支持各类框架:TensorFlow、PyTorch、Python、ONNX、XGBoost;Triton支持各类查询类型:实时、离线、批处理,或串流视频和音频。

Triton支持各类机器学习平台:AWS、Azure、Google、阿里巴巴、VMWare、Domino Data Lab、OctoML等。

Triton可以在各个地方运行,云、本地、边缘或嵌入式设备。

Amazon Shopping正在使用Triton进行实时拼写检查,而微软正藉由Triton为翻译服务提供支持,Triton已经被25000位客户下载超过100万次。

NVIDIA Riva是一种先进且基于深度学习的端到端语音AI,它可以自定义调整优化。Riva已经过预训练,具有世界一流的识别率,客户可以使用定制数据调优。使其学习行业、国家和地区,或公司的特定话术。黄仁勋认为,Riva是对话式AI服务的理想选择。

Maxine是一个AI模型工具包,现已拥有30个先进模型,可优化实时视频通信的视听效果。比如开远程视频会议时,Maxine可实现说话者与所有参会者保持眼神交流,并能将说的语言实时切换成另一种语言,而且音色听起来不变。

还有面向推荐系统的AI框架Merlin的1.0版本,Merlin可帮助企业快速构建、部署和扩展先进的AI推荐系统。比如,微信用Merlin将短视频推荐延迟缩短为原来的1/4,并将吞吐量提升了10倍。从CPU迁移至GPU,腾讯在该业务上的成本减少了1/2。

以及Omniverse,在黄仁勋看来,作为虚拟世界的仿真引擎,Omniverse平台能遵循物理学定律,构建一个趋真的数字世界,可以应用于使用不同工具的设计师之间的远程协作,以及工业数字孪生。

用于构建数字挛生的NVIDIA Omniverse 软件,以及全新数据中心NVIDIA OVX系统,将成为“以行动为导向的AI"的组成部分。

"Omniverse是我们机器人平台的核心。像 NASA和亚马逊一样,我们和机器人以及工业自动化领域的客户都意识到了数字挛生和Omniverse 的重要性。"

黄仁勋解释说,OVX将使用Omniverse数字挛生进行大规模模拟,使多个自主系统在同一时空运行。

OVX 的骨干是其网络编织架构,为此他发布了NVIDIA Spectrum-4高性能数据基础架构平台。

全球首400Gbps端到端网络平台NVIDIA Spectrum -4由Spectrum-4 交换机系列、NVIDIA ConnectX-7 SmartNIC、NVIDIA BlueField-3 DPU 和 NVIDIA DOCA 数据中心基础设施软件组成。

为了让更多的用户能够使用Omniverse, 黄仁勋发布了Omniverse Cloud。现在只需简单的点击操作,协作者就可以通过云端Omniverse 进行连接。

另外,黄仁勋认为下一波AI浪潮是机器人,NVIDIA正在构建多个机器人平台,包括用于自动驾驶汽车的DRIVE、用于操纵和控制系统的Isaac、用于自主式基础架构的Metropolis、用于医疗设备的Holoscan等。

原文标题:AI工厂时代来临,黄教主带来全新Hopper架构GPU、超级计算机和软件等新品

文章出处:【微信公众号:电子发烧友网】欢迎添加关注!文章转载请注明出处。

审核编辑:汤梓红

-

NVIDIA

+关注

关注

14文章

5087浏览量

103914 -

gpu

+关注

关注

28文章

4795浏览量

129498 -

晶体管

+关注

关注

77文章

9796浏览量

139066 -

AI

+关注

关注

87文章

31845浏览量

270671 -

H100

+关注

关注

0文章

32浏览量

315

原文标题:AI工厂时代来临,黄教主带来全新Hopper架构GPU、超级计算机和软件等新品

文章出处:【微信号:elecfans,微信公众号:电子发烧友网】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

NVIDIA全新Hopper架构H100 GPU芯片的特别之处

NVIDIA全新Hopper架构H100 GPU芯片的特别之处

评论