引言

论辩挖掘任务旨在识别文本中的论辩结构,近年来受到了广泛的关注。在信息检索等诸多领域里,论辩挖掘取得了卓越的进展。通常来说,论辩挖掘包含两个子任务:1)对于论点进行分类;2)对于论点之间的关系进行分类。

本次分享我们将介绍两篇来自ACL2021和一篇来自EMNLP2021的论辩挖掘相关论文。第一篇文章提出了一种基于神经转移的论辩挖掘模型;第二篇文章提出了一种评估论证充分性的新方法;第三篇文章对于推文的论辩挖掘定义为一种新的文本分类任务。

文章概览

1.基于神经转移的论辩挖掘模型(A Neural Transition-based Model for Argumentation Mining)

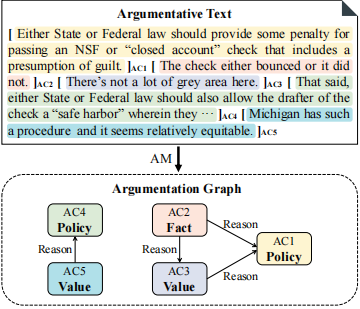

论文提出了一种针对论辩挖掘任务的新方法,该方法通过产生一系列的动作来逐步构建出一个论证图,从而有效地避免了枚举操作;此外,该方法还可以在不引入任何新的结构约束条件下处理树形(tree)或非树形(non-tree)的结构化论证。试验结果表明,该模型在两个不同结构的公开数据集上达到了最优性能。

论文地址:https://aclanthology.org/2021.acl-long.497

2.基于结论生成的论证充分性评估(Assessing the Sufficiency of Arguments through Conclusion Generation)

论文提出了一种针对论证充分性评估的新方法,即假设充分的论证所生成的结论是可以由其前提(premise)生成的。为了验证猜想,文章基于大规模预训练语言模型来探索充分性评估的潜力。实验结果表明,该方法性能达到最优,F1-score高达0.885。

论文地址:https://aclanthology.org/2021.argmining-1.7

3. 基于推文的论辩挖掘:计划生育立场辩论的案例研究(Argument Mining on Twitter: A Case Study on the Planned Parenthood Debate)

对于推文的论辩挖掘,论文用一种新的方式定义了该问题。由于主张在推文中很容易被识别出来,所以文章的重点就在于识别出支持或反对主张的前提,即将该问题定义为文本分类任务。论文提供了一个新的数据集,并且通过分析信息最丰富的文本,论文在推文中挖掘出了突出论点。

论文地址:https://aclanthology.org/2021.argmining-1.1

论文细节

1

动机

论辩挖掘(AM)其中一个子任务的目的是从文本中自动地识别出论点之间是否有关(ARI)。由于论点之间的语义关系是非常复杂的,所以论点之间的关系识别是论辩挖掘任务中最具有挑战性的。而大多数现有的方法都是通过枚举出论点之间所有可能的配对来确定它们之间是否有关。但是大多数论点之间是无关的,所以将所有的论点进行配对会使得效率极低并且会造成类别不平衡的问题。此外,对于树型结构来讲,每一个论点至多有一个“出边(outgoing)”来指向另一个论点;对于非树型结构则没有这种限制。由于论证的复杂性,到目前为止,还没有一种通用的方法可以同时解决树型或非树型的论证结构。

任务定义

由于论文假设AM任务的第一阶段已经完成,即已经将论点句子从文本中识别出来,所以论文的任务分为以下两部分:1)对论点(AC)进行分类;2)识别论点之间是否存在关联,从而得到一个有向论证图,其中论证图的节点表示论点,有向边表示论点之间的存在关联。同时,论文定义了包含了个单词的段落以及包含个论点的集合,每一个论点由论点的开始位置和结束位置来表示。

模型方法

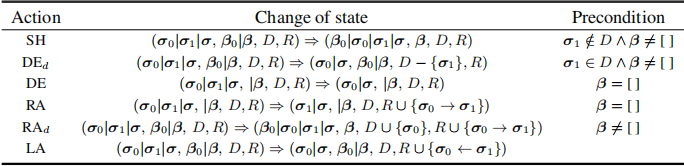

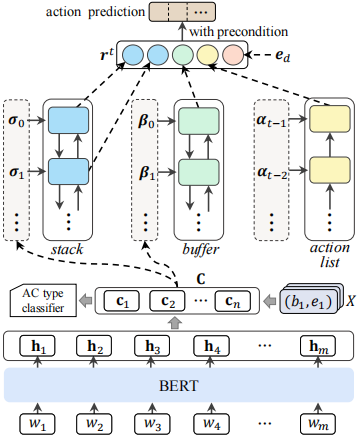

转移系统(Transition System)

转移系统包含了六种动作(actions),不同的动作将会以不同的方式改变解析状态(parser state):

:当非空并且不在之中,从弹出,然后将移到的顶部。

:当非空并且在之中,从和删除,保持不变。

:当为空,从中删除,并保持和不变。

:当为空,从中删除,并为到分配一条有向边。

:当非空,从弹出,然后将移到的顶部,并为到分配一条有向边,并且将添加到之中。这一策略有利于挖掘出更多与有关的有向边 。

:从中删除,并为到分配一条有向边。

状态表示(State Representation)

文章用BERT来获得论点的表示,用LSTM来编码、和的长期依赖。

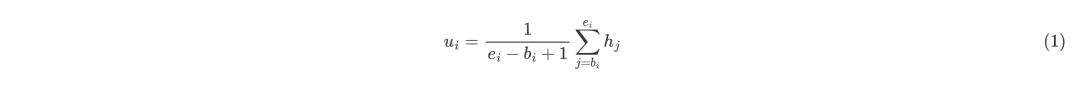

论点的表示将段落传入BERT得到文本表示矩阵,其中表示第个单词的词向量,表示BERT最后一层的向量维度。对于论点,文章通过平均池化操作来获得论点的表示,具体来说:

其中表示第个论点。另外,对于论点的表示,文章结合了一些额外的特征:词袋特征、位置编码以及段落类型编码。将其他特征归结为,此时第个论点表示为和的组合:

因此,在段落中的论点可以表示为。

解析状态的表示在每一时间步,文章将解析状态表示为,表示,存储处理过的论点;表示,存储未处理的论点;表示,记录之后需要被删除的论点;表示,记录历史动作。为了获得的文本表示,将它传递给BiLSTM:

其中,为的长度,为隐藏元的数量;同理的文本表示为:

其中,为的长度。对于历史动作信息,文中中采用单向LSTM来编码:

其中,为的长度。考虑到之间的相对距离对于确定它们之间是否有关来说是非常好的特征,所以文章将这种相对距离嵌入为,因此,解析状态可以表示为:

其中和表示中的第一个和第二个元素,表示中的第一个元素。

动作预测首先通过多层感知机将降维到,之后再通过softmax预测动作的概率。

实验

数据集

Persuasive Essays (PE)该数据集包含402篇学生议论文,1833个段落。论点分为三种:Major-Claim,Claim和Premise。PE数据集中每个论点最多只有一条“出边”,即符合树型结构。

CDCP该数据集一共包含731个段落。论点分为五类:Reference,Fact,Testimony,Value和Policy。该数据集每个论点可以有多条“出边”,属于非树型结构。

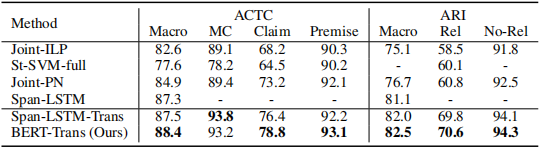

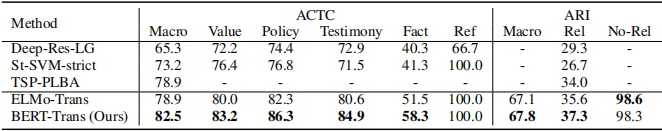

实验结果

实验结果表明,文章提出的模型在两个数据集上的结果均为最优。

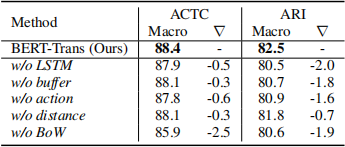

消融实验: 验证了文章提出的模型的优越性。

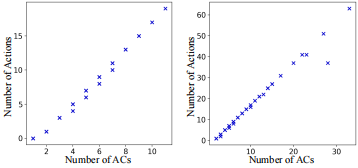

模型复杂度:之前的研究是对任意两个论点进行配对,模型复杂度高达,而论文提出的模型可以将时间复杂度降为。

2

动机

在之前的研究中,总是将论证的充分性评估建模为标准的文本分类任务,并且用传统的卷积神经网络和特征提取的方式来处理。然而为了进一步提高性能,研究者们试图将文本中直接可用的信息进行整合,但是现有的工作中既没有考虑论证的前提和结论,也没有考虑结论和前提之间的关系。由此作者提出了一种假设:只有充分的论证才可能从“前提”中推断出“结论”。由于论证质量评估任务中几乎没有考虑过大规模预训练语言模型所带来的编码信息,所以作者提出基于预训练语言模型来探索充分性评估的潜力。

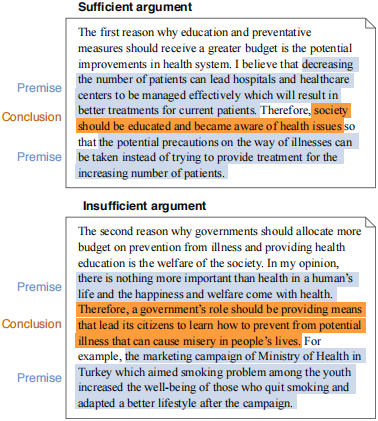

任务定义

论证的充分性是指是否可以通过论证的前提来合理地推断出结论。文章作者研究了由论证的前提自动生成结论是否有利于论证充分性的计算评估,作者旨在通过将生成的结论与原始标注相结合,进而从不充分的论证中挖掘出充分的论证。

文章贡献

语言模型可以生成与人类说话方式类似的论证结论。

文章提出的方法可以在论证充分性评估中达到SOTA效果。

深入讨论了在论证的充分性评估中结构注释的重要性。

模型方法

方法由两阶段来实现:

在对原始结论进行掩码操作的论证中得到预训练语言模型,之后通过该模型来自动的生成结论。

其次,通过对原始输入论证的的8个实验,利用生成的结论来评估论证的充分性。

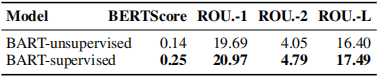

通过降噪来生成结论

BART-unsupervised 不对BART进行微调,使之作为baseline。

BART-supervised 通过在学生议论文数据集中微调BART,以便调整其降噪能力,进而生成结论。

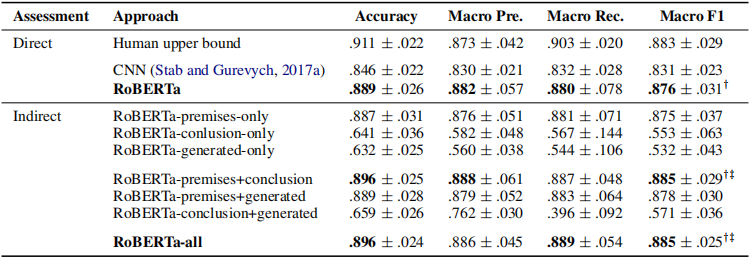

充分性评估

通过在RoBERTa之后加入一个线性层来预测论证的前提是否可以合理地推断出结论。

评估

评估生成结论的质量

自动评估:通过对比BART-unsupervised与BART-supervised,可以发现微调之后的BART性能更优。

评价充分性评估

直接的充分性评估通过比较RoBERTa与CNN以及人工评估,可以发现经过微调的预训练语言模型几乎与人工评估一致。

间接的充分性评估通过对比7种不同的输入特征可以发现,当综合了全部特征或者只包含论证的前提以及原始结论时,模型的性能最优。

RoBERTa-premises-only 将原始结论进行掩码操作之后,再作为模型的输入。

RoBERTa-conclusion-only 只是将原始结论作为模型的输入。

RoBERTa-generated-only 只用生成的结论作为模型的输入。

RoBERTa-premises+conclusion 在原始输入中对原始结论进行标记之后再作为模型输入。

RoBERTa-premises+generated 对原始的结论进行掩码操作并且加入生成的结论来作为模型的输入。

RoBERTa-conclusion+generated 将原始结论以及生成的结论作为模型的输入。

RoBERTa-all 结合所有的特征作为模型的输入。

3

动机

推特是一个很受欢迎的社交平台,很多网友会在推特上分享自己的观点。这些信息对决策者、营销人员和社会科学家来说是无价的。然而,在推特上挖掘论点的努力是有限的,主要是因为一条推文通常太短,不能包含一个完整的论点——既有主张,也有前提。由于这个原因,现有的基于推特的论辩挖掘方法通常侧重于识别主张(claim)或者是前提(premise),而不能同时识别出两者。这并不是理想的,因为作为支持主张的证据同样是非常重要的。

任务定义

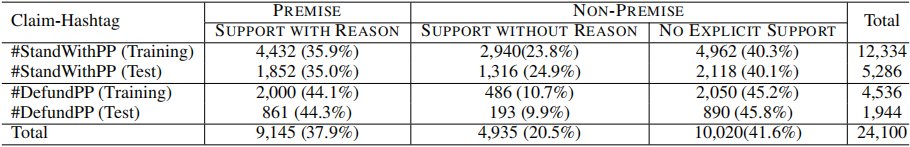

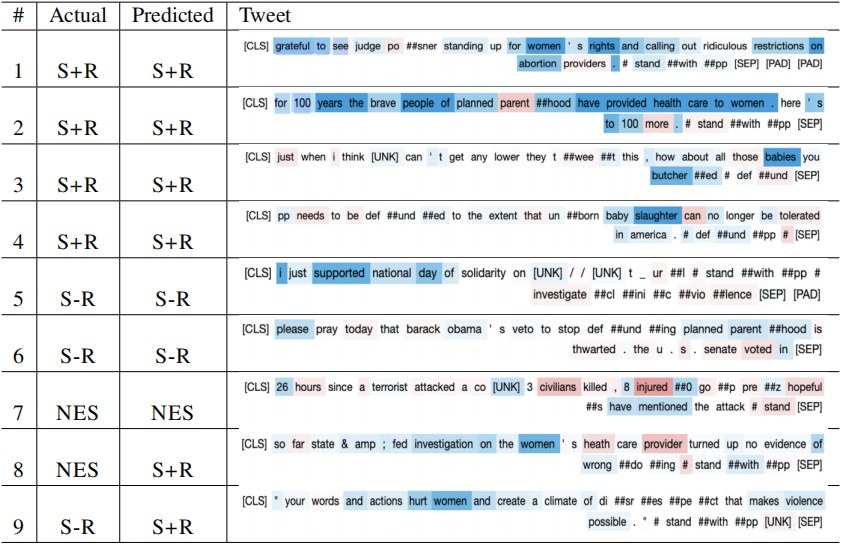

论文就是否支持计划生育问题,在推特了获得了24,100条推文作为论文数据集,并且定义了“claim-hashtag”表示带有主张的推文,“premise-tweet”表示带有前提的推文。之所以选择计划生育角度,是因为关于计划生育的辩论是多方面的,其中包括女权,人权以及健康医疗等诸多社会话题从论辩挖掘的角度来说,带有主张的推文可以通过简单的文本匹配来检索到。因此,文章的主要任务就是对于给定的推文,判断其是否为“前提”,即论文将该任务定义为文本分类任务。

文章贡献

论文提出了一个新的解决问题的方法,用来在推特上挖掘包含主张与前提的完整论点。

论文提供了一个由24,100条推文组成的新标注数据集,它的数据量是之前关于推特的数据集的10到80倍。

通过分析信息最丰富的文本,论文在推文中挖掘出了支持和反对资助计划生育的突出论点。

数据集

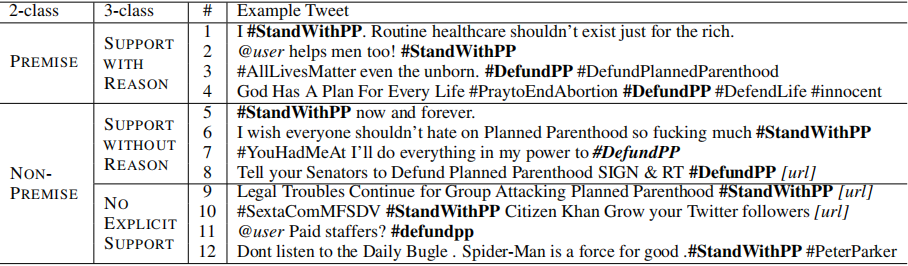

标注人员将每一条推文分类为以下三种类别之一,从而挖掘出包含完整论点的推文:

SUPPORT WITH REASON:用户支持或反对主张并且给出了原因,无论原因是否有效。

SUPPORT WITHOUT REASON:用户仅仅支持或反对主张,但是并没有给出原因。

NO EXPLICIT SUPPORT:用户对主张表示中立或者立场不明确。

模型方法

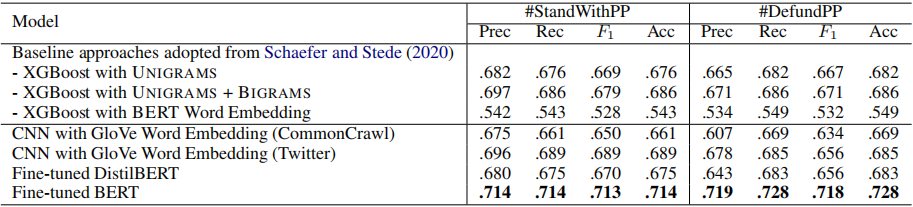

微调BERT在BERT之后加上全连接层并且用ReLu作为激活函数。此外,文章还验证了DistilBERT的性能,DistilBERT是比BERT在结构上要简单,并且在一些特殊的下游任务中,性能可以与BERT相媲美。

CNNBERT的注意力机制被证明可以有效地捕捉到文本之间的长短期记忆,但是由于推文一般都是很简短的,所以单纯使用CNN也是有效的,对于单词的嵌入操作则用GloVe词向量即可。

XGBoostXGBoost在一些文本分类任务中非常有效,论文将XGBoost的变体模型作为baseline。

实验结果

实验结果表明,微调BERT的性能最优。

SHAP值代表对于给定特征,模型对文本分类的影响程度。通过分析微调BERT的SHAP值,可以发现在SUPPORT WITH REASON中,SHAP值越高,意味着该特征越有可能成为突出特征。例如,在支持计划生育的文本中,“女权”或者“健康服务”的SHAP值排名靠前。当这类词出现时,该文本最可能被分为SUPPORT WITH REASON中。

审核编辑 :李倩

-

模型

+关注

关注

1文章

3255浏览量

48907 -

语言模型

+关注

关注

0文章

527浏览量

10292

原文标题:ACL&EMNLP'21 | 基于神经转移模型的论辩挖掘任务

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

基于神经转移模型的论辩挖掘任务

基于神经转移模型的论辩挖掘任务

评论