电子发烧友网报道(文/周凯扬)人工智能的蓬勃发展促使产业对AI基础设施提出了更高的性能要求,先进计算处理单元,尤其是ASIC或GPU,为了在机器学习、HPC提供稳定的算力表现,传统的内存系统已经不太能满足日益增加的带宽了。与此同时,在我们报道的不少AI芯片、HPC系统中,HBM或类似的高带宽内存越来越普遍,为数据密集型应用提供了支持。

提及HBM,不少人都会想到成本高、良率低等缺陷,然而这并没有影响业内对HBM的青睐,诸如AMD的Radeon Pro 5600M、英伟达的A100 等消费级/企业级GPU,或是思科的路由ASIC芯片Silicon One Q100、英特尔与AMD-Xilinx的FPGA,都用到了HBM内存。就在今年1月底,JEDEC终于正式发布了HBM的第四代HBM3的标准。

HBM3性能未来可期

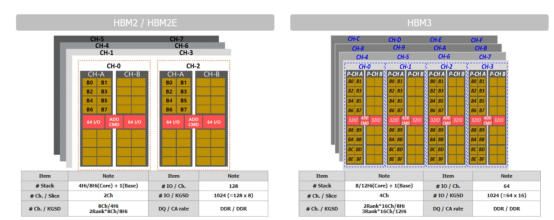

HBM2/2E与HBM3的架构对比 / SK海力士

HBM3带来的性能提升大家应该都比较清楚了,传输速率是HBM2的两倍,达到了6.4Gb/s,使得每个堆栈最高可达819GB/s的带宽。可用的独立通道也从HBM2的8个扩充至16个,加上每个通道两个伪通道的设计,HBM3可以说支持到32通道了,提供更优秀的时序来提升系统性能。

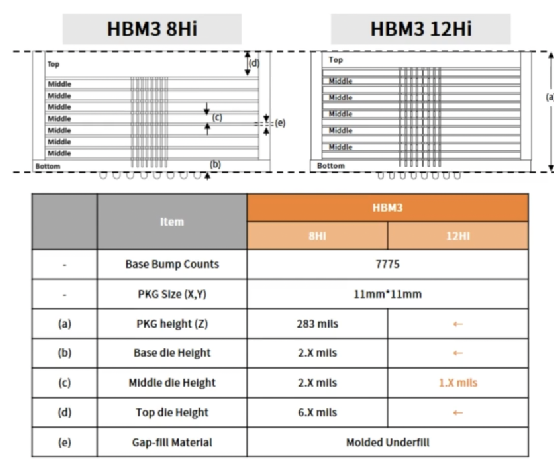

HBM3 8Hi和12Hi的机械结构对比 / SK海力士

HBM3的TSV堆叠层数支持4-high、8-high和12-high,这倒是和HBM2e没有什么差别。从SK海力士提供的机械结构图来看,无论是8Hi还是12Hi,其封装大小和高度都是一样的,只不过是减小了中间堆叠的裸片高度。这仅仅是第一代HBM3,未来HBM3会扩展至16-high的TSV堆栈,单设备的内存密度范围也将达到4GB至64GB,不过第一代HBM3设备的话,目前用到的依然是16GB的内存层。

此外,在散热上,通过增加dummy bump、增加HBM3裸片大小并降低间隙高度,HBM3成功将温度降低了25%,实现了更好的散热性能。在7位ADC的支持下,HBM3的温度传感器也能以1℃的分辨率输出0到127℃的温度信息。

首个用上HBM3的平台

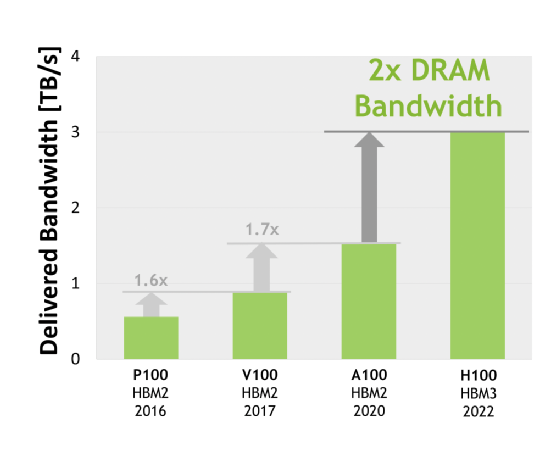

以在GTC22上亮相的H100 GPU为例,这是全球首个支持PCIe 5.0并利用HBM3的GPU,其内存容量达到了80GB。这个容量与上一代A100一致,但带宽却有了质的飞跃,与采用HBM2的A100相比,H100的内存带宽提升了两倍,达到了3TB/s。

英伟达各个系列GPU加速卡的内存带宽 / 英伟达

你可能会感到疑惑,既然HBM3可以提供每个堆栈16GB以上的内存,从H100的芯片图上看来有6个HBM3,为何只有80GB呢?是不是英伟达为了成本有所阉割?

其实原因很简单,6个HBM3的其中一个为Dummy Die,所以真正可用的HBM3内存只有5x16也就是80GB,所以英伟达在H100的白皮书也明确提到了这80GB是由5 Stacks的HBM3内存组成。如此做的原因很可能是出于良率的考量,毕竟我们已经提到了HBM良率低的包袱,而且上一代80GB HBM2e的A100也是如此设计的。

HBM找到了新的市场

根据SK海力士给出的市场预期,HBM市场正在以40%的年复合增长率席卷HPC、AI和CPU等应用,如今这其中还多出来一个特殊的应用,那就是ADAS和自动驾驶。如今的自动驾驶芯片上几乎看不到HBM的存在,即便是英伟达的Jetson AGX Orin,用的也只是256位的LPDDR5内存,带宽最高只有204.8GB/s。

这种情况再正常不过了,谁叫如今的ADAS或自动驾驶方案还用不到HBM的大带宽。花钱去设计HBM,还不如在芯片的计算性能上多下功夫。然而到了L4或L5的自动驾驶中,又是另外一幅光景了。低延迟和准确的数据处理对于激光雷达、摄像头等传感器来说,可谓至关重要,这两大自动驾驶等级下的带宽至少也要1TB/s。

据研究机构的预测,到了2030年,L4以上的自动驾驶系统将占据20%的市场,到了2035年,这一比例将上升至45%。为了不在突破L3时遇到带宽的瓶颈,引入HBM可以说是越早越好,甚至从L3就可以开始考虑了,毕竟现在不少自动驾驶芯片已经标榜着L3乃至L4以上的能力。

比如L3级别的自动驾驶,带宽要求在600GB/s到1TB/s之间,单车可以使用两个HBM2e或者一个HBM3;而L4到L5级别的自动驾驶,带宽要求在1TB/s到1.5TB之间,单车可用3个HBM2e或两个HBM3。

结语

虽然HBM3标准已经发布,芯片设计公司(英伟达、AMD、英特尔)、IP公司(新思、Cadence、Rambus)、晶圆代工厂的封装技术(台积电Cowos-S、三星H-Cube、英特尔EMIB)以及存储厂商(三星、SK海力士)都开始了相关的部署,但HBM3的普及仍然需要时间。

预计2023年到2024年,我们可以见到第一代HBM3内存在HPC上的普及,2025年到2026年第二代才会开始放量,届时我们也能看到下一代HBM4的性能前瞻。至于HBM上自动驾驶芯片倒是不必急求,汽车产品的上市周期一向很长,从HBM3的推进速度来看,估计L4和L5才能充分利用HBM3乃至HBM4的全部优势。

原文标题:HBM3首发GPU,又要进军自动驾驶

文章出处:【微信公众号:电子发烧友网】欢迎添加关注!文章转载请注明出处。

审核编辑:汤梓红

-

gpu

+关注

关注

28文章

4768浏览量

129286 -

自动驾驶

+关注

关注

784文章

13924浏览量

166891 -

HBM

+关注

关注

0文章

386浏览量

14824 -

HBM3

+关注

关注

0文章

74浏览量

163

原文标题:HBM3首发GPU,又要进军自动驾驶

文章出处:【微信号:elecfans,微信公众号:电子发烧友网】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

HBM格局生变!传三星HBM3量产供货英伟达,国内厂商积极布局

特斯拉欲将HBM4用于自动驾驶,内存大厂加速HBM4进程

重塑线控底盘技术:自动驾驶的未来支柱

自动驾驶的未来之路:智能网联与单车智能的交融

HBM上车?HBM2E被用于自动驾驶汽车

FPGA在自动驾驶领域有哪些优势?

FPGA在自动驾驶领域有哪些应用?

中国AI芯片和HBM市场的未来

全球L3自动驾驶汽车销量将破25000辆,中国市场潜力巨大

未来已来,多传感器融合感知是自动驾驶破局的关键

HBM、HBM2、HBM3和HBM3e技术对比

HBM3发力自动驾驶市场,其性能未来可期

HBM3发力自动驾驶市场,其性能未来可期

评论