在 TAO 提供的数据类范例中,每个脚本的第一个步骤都是环境配置(0. Set up env variables and map drives),包括要求用户提供在 NGC 所生成的密钥,对后面训练的模型进行保护,以及指定要使用的 GPU 数量等等,这几个设定都很直观容易处理,但接下去的环境变量配置部分,就让大部分初学者停滞不前,因为任何一项路径配置错误,都会影响后面工作的正常进行,而每个实验脚本所提供的说明,对初学者来的帮助并不大,很多新手按照其字面解释去进行设定,但总是没法调整到完全正确。

因此我们必须在大家执行实验之前,先以专文将这部分的配置说明清楚,然后提供一个最简单的步骤,让大家用最轻松的方法来进行配置。

本文使用范例的 detectnet_v2.ipynb 做示范,首先看一下第一指令块中的设定内容:

[ ] import os%env KEY=tlt_encode%env NUM_GPUS=1%env USER_EXPERIMENT_DIR=/workspace/tao-experiments/detectnet_v2%env DATA_DOWNLOAD_DIR=/workspace/tao-experiments/data# %env NOTEBOOK_ROOT=~/tao-samples/detectnet_v2os.environ["LOCAL_PROJECT_DIR"] = FIXMEos.environ["LOCAL_DATA_DIR"] = os.path.join(os.getenv("LOCAL_PROJECT_DIR", os.getcwd()),"data")os.environ["LOCAL_EXPERIMENT_DIR"] = os.path.join(os.getenv("LOCAL_PROJECT_DIR", os.getcwd()),"detectnet_v2")# The sample spec files are present in the same path as the downloaded samples.os.environ["LOCAL_SPECS_DIR"] = os.path.join(os.getenv("NOTEBOOK_ROOT", os.getcwd()),"specs")%env SPECS_DIR=/workspace/tao-experiments/detectnet_v2/specs

稍微整理一下,除了KEY与 NUM_GPUS 两个变量之外,共有7个与路径有关的变量:

-

USER_EXPERIMENT_DIR

-

DATA_DOWNLOAD_DIR

-

LOCAL_PROJECT_DIR

-

LOCAL_DATA_DIR

-

LOCAL_EXPERIMENT_DIR

-

LOCAL_SPECS_DIR

-

SPECS_DIR

其实稍微整理一下就更容易理解,下表就是将这7个变量分为两组,以 “LOCAL_” 开头的属于 “容器外” 用途,另外 3 个属于容器内用途。

|

用途 |

容器外(主机上) |

容器内(沿用TLT的习惯) |

|

项目工作位置 |

LOCAL_PROJECT_DIR |

|

|

存放模型训练输出结果 |

LOCAL_EXPERIMENT_DIR |

USER_EXPERIMENT_DIR |

|

存放数据集的路径 |

LOCAL_DATA_DIR |

DATA_DOWNLOAD_DIR |

|

配置文件存放路径 |

LOCAL_SPECS_DIR |

SPECS_DIR |

什么是容器内与容器外?前面提过 TAO 用两套独立的 Docker 容器,分别为视觉类与对话类提供模型训练功能,并透过 TAO 启动器的 CLI 指令执行各项任务。

虽然我们所有操作都在容器外的宿主机上,例如在指令终端下达 “tao detectnet_v2 train ...”,或者在 Jupyter 交互环境里执行 “!taodetectnet_v2 train ...” 指令,但是 TAO 启动器会将这些指令传递到容器,在后台为我们执行对应的任务。

这种处理方式的最大好处是,让不懂 Docker 的初学者完全无需理会容器技术,只要专注于 “模型训练” 的重点工作就行,如此就能让 TAO 的普及程度更快与更广,这也是 TAO 工具的一项非常重要意义。

但为何需要使用两套路径来处理呢?全部都在容器内执行不是更加简单?这里有个最严肃的问题是 “容器的生命周期” ,如果将数据保留在容器内处理的话,一旦容器关闭或销毁时,我们所有实验数据都将付之一炬,这是一项大家都承担不起的风险,因此我们必须将所有的数据存放在容器外面,然后透过路径映射 (mapping) 的方式来处理。

其次就是对于数据整理与文件修改的能力,在容器内操作是相对不方便的。要知道在执行模型训练之前,通常得先下载数据集的压缩文件、移动文件、进行解压缩、修改配置文件等等,这些任务在宿主机上操作是相对轻松的。

好了,当我们清楚 TAO 的视觉类模型训练脚本中,存在容器内与容器外两组环境路径的原因之后,接着就来看该如何设置与映射。

我们将前面的列表进行展开,前面 4 个是容器外的变量、后面 3 个是容器内变量:

|

环境变量 |

设定值 |

|

LOCAL_PROJECT_DIR |

需要设置 |

|

LOCAL_EXPERIMENT_DIR |

$LOCAL_PROJECT_DIR/<项目名> |

|

LOCAL_DATA_DIR |

$LOCAL_PROJECT_DIR/data |

|

LOCAL_SPECS_DIR |

<执行脚本所在目录>/specs |

|

USER_EXPERIMENT_DIR |

/workspace/tao-experiments/<项目名> |

|

DATA_DOWNLOAD_DIR |

/workspace/tao-experiments/data |

|

SPECS_DIR |

/workspace/tao-experiments/<项目名>/specs |

假如在执行格内的变量按照上表的顺序去排列,事情就会变得非常单纯。

事实上,从头到尾我们只要将 “LOCAL_PROJECT_DIR” 设置为”执行脚本所在目录”,那么后面三个容器外变量就立即建立好对应关系,我们完全不需要做任何处理理会。至于容器内的三个变量,每个脚本的配置规则都是一样,也就是不需要去改变。

把上面的对应关系了解清楚之后,整个状况就变得非常简单,现在回头看看第一个指令块,里面需要输入的变量其实只有以下三个:

-

%env KEY= <自己在NGC上申请的秘钥>

-

%env NUM_GPUS= <根据设备配置,给定调用的GPU数量>

-

os.environ["LOCAL_PROJECT_DIR"] = os.getcwd()

其他 6 个变量完全不做任何修改,这样就能够顺畅地跑动后面的指令块。

接下去的工作就是执行 “路径映射” 任务,为容器内外的路径建立对应的关系。几乎所有训练脚本都采用下面的映射方式:

[ ] # Define the dictionary with the mapped drivesdrive_map = {"Mounts": [# Mapping the data directory{"source": os.environ["LOCAL_PROJECT_DIR"],"destination": "/workspace/tao-experiments"},# Mapping the specs directory.{"source": os.environ["LOCAL_SPECS_DIR"],"destination": os.environ["SPECS_DIR"]},]}

执行这个路径映射的指令块之后,会将这些值写入 “~/.tao_mounts.json” 文件里面,这是 TAO 启动器每次调用容器时都需要参考的配置文件,但是这个文件是 “唯一” 的,也就是同一时间只会存在一组容器内外的路径映射关系,这表示系统不能同时执行两个以上的模型训练脚本,这点也请务必牢记。

紧跟着的 “1.Install the TAO launcher” 步骤可以直接跳过,因为我们在前面已经带着大家安装好 TAO 启动器,这里顶多执行 “!taoinfo” 指令,确认一下是否回应正确讯息。

现在就可以开始进行 TAO 所提供的各种神经网络的模型训练脚本。

-

神经网络

+关注

关注

42文章

4787浏览量

101455 -

NVIDIA

+关注

关注

14文章

5098浏览量

104249 -

变量

+关注

关注

0文章

613浏览量

28533

原文标题:NVIDIA Jetson Nano 2GB 系列文章(57):视觉类脚本的环境配置与映射

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

探索NVIDIA Jetson与DeepSeek融合的无限可能

NVIDIA JetPack 6.2引入Super模式

NVIDIA Jetson Orin Nano开发者套件的新功能

NVIDIA发布小巧高性价比的Jetson Orin Nano Super开发者套件

NVIDIA 推出高性价比的生成式 AI 超级计算机

u-blox深化与NVIDIA Jetson和NVIDIA DRIVE Hyperion平台合作

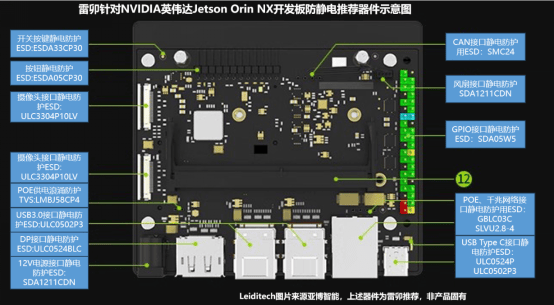

雷卯针对NVIDIA英伟达JETSON Orin NX开发板防静电推荐器件示意图

初创公司借助NVIDIA Metropolis和Jetson提高生产线效率

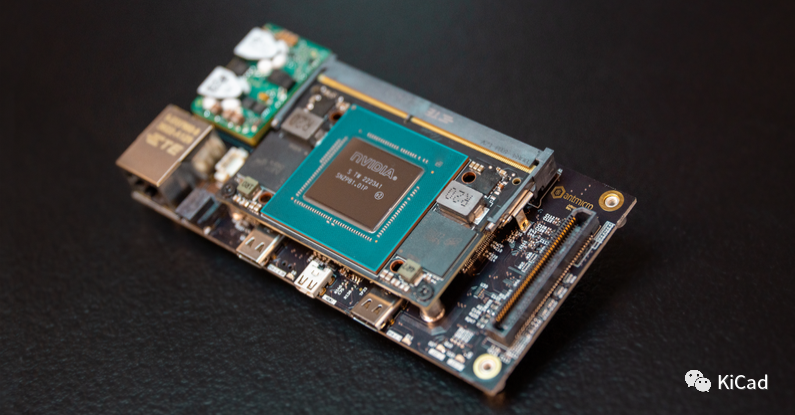

Made with KiCad(二):Jetson Origin Baseboard

使用NVIDIA Jetson打造机器人导盲犬

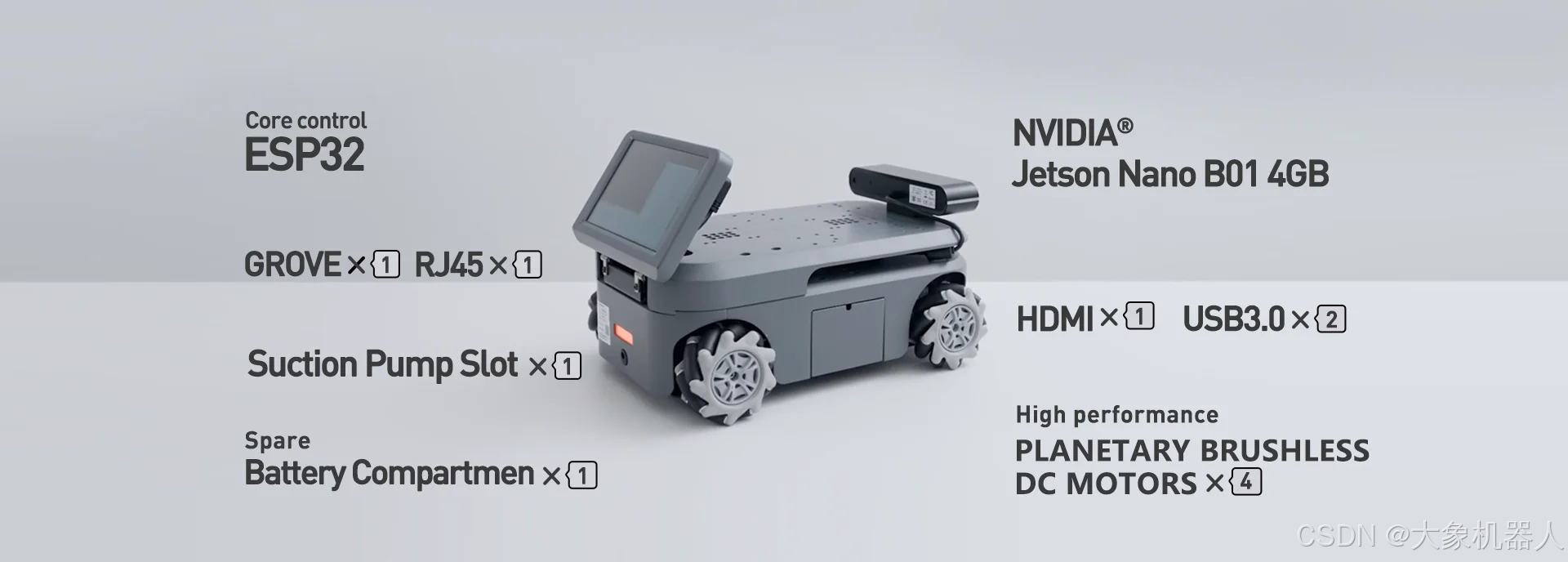

使用myAGV、Jetson Nano主板和3D摄像头,实现了RTAB-Map的三维建图功能!

NVIDIA Jetson Nano 2GB:视觉类脚本的环境配置与映射

NVIDIA Jetson Nano 2GB:视觉类脚本的环境配置与映射

评论