75 年前,宝丽来相机拍出了第一张即拍照片,实现了用逼真 2D 图像快速捕捉 3D 场景的技术突破。如今,AI 研究者正在进行相反的研究——在几秒钟内将静止的图像集合转换成数字 3D 场景。

这项被称为逆向绘制的流程利用 AI 逼真模拟现实世界中的光线特征,使研究者能够使用从不同角度拍摄的 2D 图像重建 3D 场景。NVIDIA Research 团队开发出可以瞬间完成这一任务的方法,构建了首个将超快神经网络训练和快速渲染相结合的模型。

NVIDIA 将这种方法应用于被称为神经辐射场(NeRF)的新技术。该结果被称为“即时 NeRF”(Instant NeRF),是迄今为止最快的 NeRF 技术,它在某些情况中能够将速度提升超过 1000 倍。该模型只需要几秒钟就能训练出几十张静态照片及其拍摄角度数据,并在瞬间渲染产生的 3D 场景。

NVIDIA 负责图形学研究的副总裁 David Luebke 表示:“如果把多边形网格这样的传统 3D 表示方式比作矢量图像,那么 NeRF 就像是位图图像——它们可以密集捕捉光线在物体或场景中的辐射方式。从这个意义上来说,即时 NeRF 对 3D 的重要性不亚于数码相机和 JPEG 压缩对 2D 摄影的重要性,它极大地提高了 3D 捕捉和分享的速度、便利性和范围。”

NVIDIA GTC 上的一场分会展示了如何使用即时 NeRF 为虚拟世界创建虚拟化身或场景、以 3D 方式捕捉视频会议参与者及其环境或者为 3D 数字地图重建场景。

为了向早期的宝丽来照片致敬,NVIDIA Research 重现了 Andy Warhol 拍摄即拍照片时的标志性照片,并使用即时 NeRF 将其转换成 3D 场景。

什么是 NeRF?

NeRF 使用神经网络来表示和渲染基于 2D 图像集的逼真 3D 场景。

为 NeRF 采集数据有点像红毯摄影师从各个角度拍摄盛装打扮的名人。该神经网络还需要几十张从环绕场景的多个位置拍摄的图像以及每次拍摄时的相机位置。

在包含人或其他移动元素的场景中,这些照片拍得越快越好。如果在 2D 图像捕捉过程中出现过多的运动,AI 生成的 3D 场景就会变得模糊不清。

NeRF 可以填补这方面的空白,它可以训练小型神经网络,通过预测光线从 3D 空间任何一点向任何方向辐射时的颜色来重建该场景。该技术甚至可以解决遮挡问题,比如当某些图像中的物体被其他图像中的柱子等障碍物挡住时。

使用即时 NeRF 实现 1000 倍加速

人类天生就会根据局部视图估计物体的深度和外观,但这对 AI 来说却很艰巨。

根据视图创建的复杂性和分辨率,使用传统方法创建 3D 场景需要耗费数小时甚至更长时间。AI 能够加快这项工作的速度。早期的 NeRF 模型在几分钟内就能渲染出没有伪影的清晰场景,但仍需要通过数小时的训练。

即时 NeRF 将渲染时间缩短了多个数量级。它依靠的是 NVIDIA 开发的“多分辨率哈希网格编码技术”。这项技术经过优化后,可在 NVIDIA GPU 上高效运行。研究者可以通过新的输入编码方法,利用快速运行的微型神经网络获得高质量的结果。

该模型由 NVIDIA CUDA 工具包和微型 CUDA 神经网络库所开发。由于是轻量级的神经网络,它可以在单个 NVIDIA GPU 上训练和运行,并且在内置 NVIDIA Tensor 核的显卡上达到最快运行速度。

这项技术可用于训练机器人和自动驾驶汽车,通过捕捉现实世界中物体的 2D 图像或视频片段来理解物体的大小和形状。在建筑和娱乐行业,该技术能够快速生成真实环境的数字场景表示,创作者可在此基础上进行修改和构建。

除了 NeRFs 之外,NVIDIA 研究人员还在探索如何利用这种输入编码技术来加速多个 AI 领域的发展,包括强化学习、语言翻译和通用深度学习算法。

-

神经网络

+关注

关注

42文章

4771浏览量

100767 -

NVIDIA

+关注

关注

14文章

4986浏览量

103059 -

虚拟世界

+关注

关注

0文章

81浏览量

5810

发布评论请先 登录

相关推荐

Hyper-V创建虚拟机配置IP等网络配置原理(Linux、Windows为例)

Linux下如何管理虚拟内存 使用虚拟内存时的常见问题

ar与虚拟现实的区别 如何优化ar应用的用户界面

什么是虚拟电厂?

什么是虚拟机?什么是虚拟化?

创建ubuntu虚拟机

嵌入式学习-搭建自己的ubuntu系统之创建ubuntu虚拟机

使用NVIDIA Edify助力的服务创建3D资产和虚拟环境照明

什么是虚拟机?虚拟机真的那么好用吗?

虚拟现实与完全现实的区别

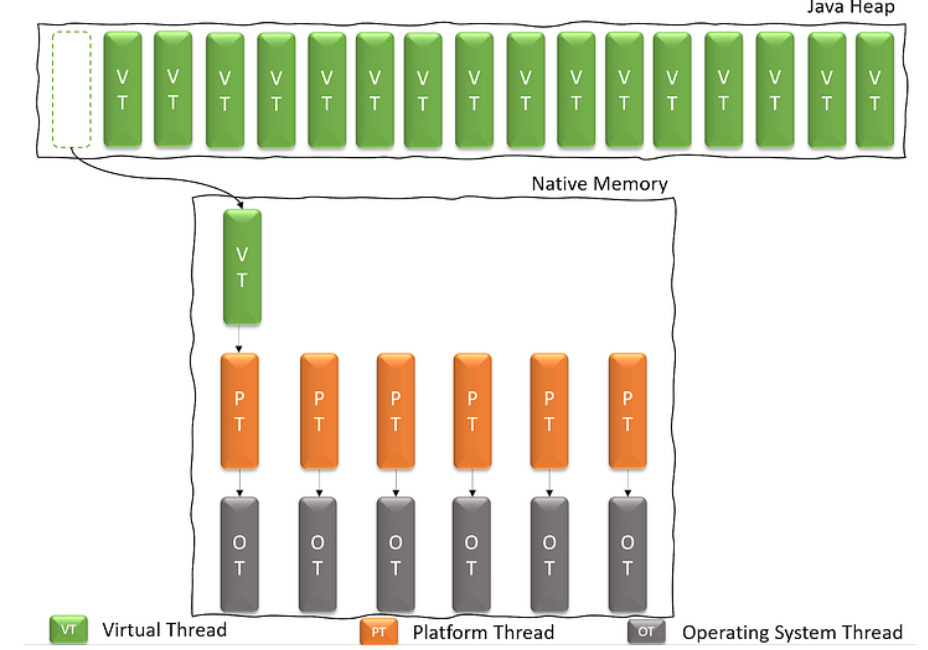

探索虚拟线程:原理与实现

如何使用即时NeRF为虚拟世界创建虚拟化身

如何使用即时NeRF为虚拟世界创建虚拟化身

评论