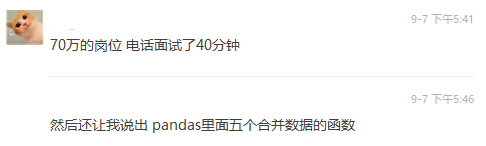

有朋友面试阿里70万总包的数据岗位,对方问Pandas的5种数据合并的函数,结果他只答出了2个。

那么,究竟是哪五个呢?今天,我们就来带大家了解一下!目录:

那么,究竟是哪五个呢?今天,我们就来带大家了解一下!目录:-

1. concat

-

2. append

-

3. merge

-

4. join

-

5. combine

-

总结

1. concat

concat是pandas中专门用于数据连接合并的函数,功能非常强大,支持纵向合并和横向合并,默认情况下是纵向合并,具体可以通过参数进行设置。

pd.concat( objs:'Iterable[NDFrame]|Mapping[Hashable,NDFrame]', axis=0, join='outer', ignore_index:'bool'=False, keys=None, levels=None, names=None, verify_integrity:'bool'=False, sort:'bool'=False, copy:'bool'=True, )->'FrameOrSeriesUnion'在函数方法中,各参数含义如下:接下来,我们就对该函数功能进行演示基础连接 In[1]:importpandasaspd In[2]:s1=pd.Series(['a','b']) In[3]:s2=pd.Series(['c','d']) In[4]:s1 Out[4]: 0a 1b dtype:object In[5]:s2 Out[5]: 0c 1d dtype:object In[6]:pd.concat([s1,s2]) Out[6]: 0a 1b 0c 1d dtype:object In[7]:df1=pd.DataFrame([['a',1],['b',2]], ...:columns=['letter','number']) In[8]:df2=pd.DataFrame([['c',3],['d',4]], ...:columns=['letter','number']) In[9]:pd.concat([df1,df2]) Out[9]: letternumber 0a1 1b2 0c3 1d4横向连接 In[10]:pd.concat([df1,df2],axis=1) Out[10]: letternumberletternumber 0a1c3 1b2d4默认情况下,objs: 用于连接的数据,可以是DataFrame或Series组成的列表axis=0: 连接的方式,默认为0也就是纵向连接,可选 1 为横向连接join='outer':合并方式,默认为inner也就是交集,可选outer为并集ignore_index: 是否保留原有的索引keys=None:连接关系,使用传递的值作为一级索引levels=None:用于构造多级索引names=None:索引的名称verify_integrity: 检测索引是否重复,如果为True则有重复索引会报错sort: 并集合并方式下,对columns排序copy: 是否深度拷贝

concat是取并集,如果两个数据中有个数据没有对应行或列,则会填充为空值NaN。合并交集

In[11]:df3=pd.DataFrame([['c',3,'cat'],['d',4,'dog']], ...:columns=['letter','number','animal']) In[12]:df1 Out[12]: letternumber 0a1 1b2 In[13]:df3 Out[13]: letternumberanimal 0c3cat 1d4dog In[14]:pd.concat([df1,df3],join='inner') Out[14]: letternumber 0a1 1b2 0c3 1d4索引重置(不保留原有索引)

In[15]:pd.concat([df1,df3],join='inner',ignore_index=True) Out[15]: letternumber 0a1 1b2 2c3 3d4 #以下方式和上述的输出结果等价 In[16]:pd.concat([df1,df3],join='inner').reset_index(drop=True) Out[16]: letternumber 0a1 1b2 2c3 3d4指定索引

In[17]:pd.concat([df1,df3],keys=['df1','df3']) Out[17]: letternumberanimal df10a1NaN 1b2NaN df30c3cat 1d4dog In[18]:pd.concat([df1,df3],keys=['df1','df3'],names=['df名称','行ID']) Out[18]: letternumberanimal df名称行ID df10a1NaN 1b2NaN df30c3cat 1d4dog检测重复如果索引出现重复,则无法通过检测,会报错

In[19]:pd.concat([df1,df3],verify_integrity=True) Traceback(mostrecentcalllast): ... ValueError:Indexeshaveoverlappingvalues:Int64Index([0,1],dtype='int64')合并并集下columns排序

In[21]:pd.concat([df1,df3],sort=True) Out[21]: animalletternumber 0NaNa1 1NaNb2 0catc3 1dogd4DataFrame与Series合并

In[22]:pd.concat([df1,s1]) Out[22]: letternumber0 0a1.0NaN 1b2.0NaN 0NaNNaNa 1NaNNaNb In[23]:pd.concat([df1,s1],axis=1) Out[23]: letternumber0 0a1a 1b2b #新增列一般可选以下两种方式 In[24]:df1.assign(新增列=s1) Out[24]: letternumber新增列 0a1a 1b2b In[25]:df1['新增列']=s1 In[26]:df1 Out[26]: letternumber新增列 0a1a 1b2b以上就concat函数方法的一些功能,相比之下,另外一个函数append也可以用于数据追加(纵向合并)

2. append

append主要用于追加数据,是比较简单直接的数据合并方式。

df.append( other, ignore_index:'bool'=False, verify_integrity:'bool'=False, sort:'bool'=False, )->'DataFrame'在函数方法中,各参数含义如下:接下来,我们就对该函数功能进行演示基础追加 In[41]:df1.append(df2) Out[41]: letternumber 0a1 1b2 0c3 1d4 In[42]:df1.append([df1,df2,df3]) Out[42]: letternumberanimal 0a1NaN 1b2NaN 0a1NaN 1b2NaN 0c3NaN 1d4NaN 0c3cat 1d4dogcolumns重置(不保留原有索引) In[43]:df1.append([df1,df2,df3],ignore_index=True) Out[43]: letternumberanimal 0a1NaN 1b2NaN 2a1NaN 3b2NaN 4c3NaN 5d4NaN 6c3cat 7d4dog检测重复如果索引出现重复,则无法通过检测,会报错 In[44]:df1.append([df1,df2],verify_integrity=True) Traceback(mostrecentcalllast): ... ValueError:Indexeshaveoverlappingvalues:Int64Index([0,1],dtype='int64')索引排序 In[46]:df1.append([df1,df2,df3],sort=True) Out[46]: animalletternumber 0NaNa1 1NaNb2 0NaNa1 1NaNb2 0NaNc3 1NaNd4 0catc3 1dogd4追加Series In[49]:s=pd.Series({'letter':'s1','number':9}) In[50]:s Out[50]: letters1 number9 dtype:object In[51]:df1.append(s) Traceback(mostrecentcalllast): ... TypeError:CanonlyappendaSeriesifignore_index=TrueoriftheSerieshasaname In[53]:df1.append(s,ignore_index=True) Out[53]: letternumber 0a1 1b2 2s19追加字典这个在爬虫的时候比较好使,每爬取一条数据就合并到other: 用于追加的数据,可以是DataFrame或Series或组成的列表ignore_index: 是否保留原有的索引verify_integrity: 检测索引是否重复,如果为True则有重复索引会报错sort: 并集合并方式下,对columns排序

DataFrame类似数据中存储起来

In[54]:dic={'letter':'s1','number':9} In[55]:df1.append(dic,ignore_index=True) Out[55]: letternumber 0a1 1b2 2s19

3. merge

merge函数方法类似SQL里的join,可以是pd.merge或者df.merge,区别就在于后者待合并的数据是

pd.merge( left:'DataFrame|Series', right:'DataFrame|Series', how:'str'='inner', on:'IndexLabel|None'=None, left_on:'IndexLabel|None'=None, right_on:'IndexLabel|None'=None, left_index:'bool'=False, right_index:'bool'=False, sort:'bool'=False, suffixes:'Suffixes'=('_x','_y'), copy:'bool'=True, indicator:'bool'=False, validate:'str|None'=None, )->'DataFrame'在函数方法中,关键参数含义如下:接下来,我们就对该函数功能进行演示基础合并 In[55]:df1=pd.DataFrame({'key':['foo','bar','bal'], ...:'value2':[1,2,3]}) In[56]:df2=pd.DataFrame({'key':['foo','bar','baz'], ...:'value1':[5,6,7]}) In[57]:df1.merge(df2) Out[57]: keyvalue2value1 0foo15 1bar26其他连接方式 In[58]:df1.merge(df2,how='left') Out[58]: keyvalue2value1 0foo15.0 1bar26.0 2bal3NaN In[59]:df1.merge(df2,how='right') Out[59]: keyvalue2value1 0foo1.05 1bar2.06 2bazNaN7 In[60]:df1.merge(df2,how='outer') Out[60]: keyvalue2value1 0foo1.05.0 1bar2.06.0 2bal3.0NaN 3bazNaN7.0 In[61]:df1.merge(df2,how='cross') Out[61]: key_xvalue2key_yvalue1 0foo1foo5 1foo1bar6 2foo1baz7 3bar2foo5 4bar2bar6 5bar2baz7 6bal3foo5 7bal3bar6 8bal3baz7指定连接键可以指定单个连接键,也可以指定多个连接键 In[62]:df1=pd.DataFrame({'lkey1':['foo','bar','bal'], ...:'lkey2':['a','b','c'], ...:'value2':[1,2,3]}) In[63]:df2=pd.DataFrame({'rkey1':['foo','bar','baz'], ...:'rkey2':['a','b','c'], ...:'value2':[5,6,7]}) In[64]:df1 Out[64]: lkey1lkey2value2 0fooa1 1barb2 2balc3 In[65]:df2 Out[65]: rkey1rkey2value2 0fooa5 1barb6 2bazc7 In[66]:df1.merge(df2,left_on='lkey1',right_on='rkey1') Out[66]: lkey1lkey2value2_xrkey1rkey2value2_y 0fooa1fooa5 1barb2barb6 In[67]:df1.merge(df2,left_on=['lkey1','lkey2'],right_on=['rkey1','rkey2']) Out[67]: lkey1lkey2value2_xrkey1rkey2value2_y 0fooa1fooa5 1barb2barb6指定索引为键 Out[68]:df1.merge(df2,left_index=True,right_index=True) Out[68]: lkey1lkey2value2_xrkey1rkey2value2_y 0fooa1fooa5 1barb2barb6 2balc3bazc7设置重复列后缀 In[69]:df1.merge(df2,left_on='lkey1',right_on='rkey1',suffixes=['左','右']) Out[69]: lkey1lkey2value2左rkey1rkey2value2右 0fooa1fooa5 1barb2barb6连接指示新增一列用于显示数据来源 In[70]:df1.merge(df2,left_on='lkey1',right_on='rkey1',suffixes=['左','右'],how='outer', ...:indicator=True ...:) Out[70]: lkey1lkey2value2左rkey1rkey2value2右_merge 0fooa1.0fooa5.0both 1barb2.0barb6.0both 2balc3.0NaNNaNNaNleft_only 3NaNNaNNaNbazc7.0right_onlyleft: 用于连接的左侧数据right: 用于连接的右侧数据how: 数据连接方式,默认为 inner,可选outer、left和righton: 连接关键字段,左右侧数据中需要都存在,否则就用left_on和right_onleft_on: 左侧数据用于连接的关键字段right_on: 右侧数据用于连接的关键字段left_index: True表示左侧索引为连接关键字段right_index: True表示右侧索引为连接关键字段suffixes: 'Suffixes' = ('_x', '_y'),可以自由指定,就是同列名合并后列名显示后缀indicator: 是否显示合并后某行数据的归属来源

4. join

join就有点想append之于concat,用于数据合并

df.join( other:'FrameOrSeriesUnion', on:'IndexLabel|None'=None, how:'str'='left', lsuffix:'str'='', rsuffix:'str'='', sort:'bool'=False, )->'DataFrame'在函数方法中,关键参数含义如下:接下来,我们就对该函数功能进行演示 In[71]:df=pd.DataFrame({'key':['K0','K1','K2','K3','K4','K5'], ...:'A':['A0','A1','A2','A3','A4','A5']}) In[72]:other=pd.DataFrame({'key':['K0','K1','K2'], ...:'B':['B0','B1','B2']}) In[73]:df Out[73]: keyA 0K0A0 1K1A1 2K2A2 3K3A3 4K4A4 5K5A5 In[74]:other Out[74]: keyB 0K0B0 1K1B1 2K2B2 In[75]:df.join(other,on='key') Traceback(mostrecentcalllast): ... ValueError:Youaretryingtomergeonobjectandint64columns.Ifyouwishtoproceedyoushouldusepd.concat如果想用key关键字, 则需要key是索引。。。指定key In[76]:df.set_index('key').join(other.set_index('key')) Out[76]: AB key K0A0B0 K1A1B1 K2A2B2 K3A3NaN K4A4NaN K5A5NaN In[77]:df.join(other.set_index('key'),on='key') Out[77]: keyAB 0K0A0B0 1K1A1B1 2K2A2B2 3K3A3NaN 4K4A4NaN 5K5A5NaN指定重复列后缀 In[78]:df.join(other,lsuffix='_左',rsuffix='右') Out[78]: key_左Akey右B 0K0A0K0B0 1K1A1K1B1 2K2A2K2B2 3K3A3NaNNaN 4K4A4NaNNaN 5K5A5NaNNaN其他参数就不多做介绍了,和other: 用于合并的右侧数据on: 连接关键字段,左右侧数据中需要都存在,否则就用left_on和right_onhow: 数据连接方式,默认为 inner,可选outer、left和rightlsuffix: 左侧同名列后缀rsuffix:右侧同名列后缀

merge基本一样。

5. combine

在数据合并的过程中,我们可能需要对对应位置的值进行一定的计算,pandas提供了combine和combine_first函数方法来进行这方面的合作操作。

df.combine( other:'DataFrame', func, fill_value=None, overwrite:'bool'=True, )->'DataFrame'比如,数据合并的时候取单元格最小的值

In[79]:df1=pd.DataFrame({'A':[0,0],'B':[4,4]}) In[80]:df2=pd.DataFrame({'A':[1,1],'B':[3,3]}) In[81]:df1 Out[81]: AB 004 104 In[82]:df2 Out[82]: AB 013 113 In[83]:take_smaller=lambdas1,s2:s1ifs1.sum()< s2.sum() elses2 In[84]:df1.combine(df2,take_smaller) Out[84]: AB 003 103 #也可以调用numpy的函数 In[85]:importnumpyasnp In[86]:df1.combine(df2,np.minimum) Out[86]: AB 003 103fill_value填充缺失值

In[87]:df1=pd.DataFrame({'A':[0,0],'B':[None,4]}) In[87]:df2=pd.DataFrame({'A':[1,1],'B':[3,3]}) In[88]:df1 Out[88]: AB 00NaN 104.0 In[89]:df2 Out[89]: AB 013 113 In[90]:df1.combine(df2,take_smaller,fill_value=-88) Out[90]: AB 00-88.0 104.0overwrite=False保留

In[91]:df1=pd.DataFrame({'A':[0,0],'B':[4,4]}) In[92]:df2=pd.DataFrame({'B':[3,3],'C':[-10,1],},index=[1,2]) In[93]:df1 Out[93]: AB 004 104 In[94]:df2 Out[94]: BC 13-10 231 In[95]:df1.combine(df2,take_smaller) Out[95]: ABC 0NaNNaNNaN 1NaN3.0-10.0 2NaN3.01.0 #保留A列原有的值 In[96]:df1.combine(df2,take_smaller,overwrite=False) Out[96]: ABC 00.0NaNNaN 10.03.0-10.0 2NaN3.01.0另外一个combine_first

df.combine_first(other:'DataFrame')->'DataFrame'当df中元素为空采用other里的进行替换,结果为并集合并

In[97]:df1=pd.DataFrame({'A':[None,0],'B':[None,4]}) In[98]:df2=pd.DataFrame({'A':[1,1],'B':[3,3]}) In[99]:df1 Out[99]: AB 0NaNNaN 10.04.0 In[100]:df2 Out[100]: AB 013 113 In[101]:df1.combine_first(df2) Out[101]: AB 01.03.0 10.04.0 In[102]:df1=pd.DataFrame({'A':[None,0],'B':[4,None]}) In[103]:df2=pd.DataFrame({'B':[3,3],'C':[1,1]},index=[1,2]) In[104]:df1 Out[104]: AB 0NaN4.0 10.0NaN In[105]:df2 Out[105]: BC 131 231 In[106]:df1.combine_first(df2) Out[106]: ABC 0NaN4.0NaN 10.03.01.0 2NaN3.01.0

总结

以上就本次介绍的关于Pandas数据合并的全部内容,相比之下我们可以发现:-

append主要用于纵向追加数据,比较简单直接; -

concat功能最强大,不仅可以纵向合并数据还可以横向合并数据而且支持很多其他条件设置; -

merge则主要用于横向合并数据,类似SQL里的join连接; -

join则比较简单,用于横向合并数据,条件相对苛刻; -

combine更像是按照元素进行合并,根据一定的条件(函数规则)来进行数据合并。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

数据

+关注

关注

8文章

7217浏览量

89895 -

concat

+关注

关注

0文章

3浏览量

1940

原文标题:5 个必须知道的 Pandas 数据合并技巧

文章出处:【微信号:DBDevs,微信公众号:数据分析与开发】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

使用ADS1281做调制器,两个调制器都是输出1位的数据流,那合并之后数据流是几位的呢?

]).

现在有以下两个问题:

1.两个调制器都是输出1位的数据流,那合并之后数据流是几位的呢?

2.如果取所有可能的情况,Y[n]的输出范围

发表于 02-05 09:10

ADS1256两个通道之间进行切换,必须需要至少5ms的延时第2通道才能正常读出数据,为什么?

:SPIBRR=250 K, DRATE=2K SPS

3. 问题:两个通道之间进行切换,必须需要至少5ms的延时,第2通道才能正常读出数据。

但项目需要至少延时到1ms以下,不知是

发表于 12-20 14:21

英国CMA有条件批准沃达丰与Three合并

推出合并后的5G网络。 CMA在审查过程中认为,沃达丰与Three的合并有可能对英国移动行业的竞争格局产生积极影响。因此,在确保合并后企业能够履行其投资承诺的前提下,CMA决定给予此次

RAPIDS cuDF将pandas提速近150倍

在 NVIDIA GTC 2024 上,NVIDIA 宣布,RAPIDS cuDF 当前已能够为 950 万 pandas 用户带来 GPU 加速,且无需修改代码。

MAX9877将数据发送到NVM中,发送数据时,必须要填满128个字节吗?

想请问一下9877将数据发送到NVM中,一页的数据传输,最多可以发送128字节。想问一下发送数据时,必须要填满128个字节吗,还是可以只要发

发表于 07-24 07:00

干货 购买无人叉车你必须知道的4条建议 都在这儿了

需求。本文将从相关配置、参数、电池容量和导航方式四个方面,为您详细解析购买无人叉车前需要了解的关键问题。 一、相关配置 叉车类型: 明确需要的无人叉车类型,如堆高式、平衡重式、搬运式等,这取决于具体的应用场景

半导体行业常用术语大全:30个专业名词详解

在半导体行业中,了解和掌握专业名词是至关重要的。这些名词不仅有助于我们更好地理解半导体的制造过程,还能提升我们在行业中的沟通效率。以下是半导体人必须知道的30个专业名词的解释。

谈谈EMC,工程师必须知道的58个EMC问答

1要对产品做电磁兼容设计?答:满足产品功能要求、减少调试时间,使产品满足电磁兼容标准的要求,使产品不会对系统中的其它设备产生电磁干扰。2对产品做电磁兼容设计可以从哪几个方面进行?答:电路设计(包括器件选择)、软件设计、线路板设计、屏蔽结构、信号线/电源线滤波、电路的接地方式设计。3在电磁兼容领域,为什么总是用分贝(dB)的单位描述?10mV是多少dBmV?答

Labview 如何将多列列表框相邻的两个单元格合并?如同Excel合并单元格

如题,Labview中 如何将多列列表框相邻的两个单元格合并?如同Excel合并单元格。请各位大神帮忙指点,谢谢。

发表于 04-25 11:12

环境试验中你必须知道的15个专业术语

三、试验箱稳定状态

当试验箱工作空间内任意点的变化量满足设备性能指标要求时,我们称试验箱处于稳定状态。这是确保试验准确性和可重复性的基础。

四、温度偏差

在试验箱稳定状态下,工作空间内各测量点在规定时间内记录的最高和最低温度与设定温度的差值。这个指标反映了温度控制的精确度。

五、相对湿度温差

类似于温度偏差,这是指工作空间内各测量点的

使用爱星物联IoT平台时,哪些参数配置是开发者必须知道的?

hello,小伙伴们,上周我们《爱星物联IoT平台正式开源啦》,感兴趣的开发者可以点击文中的链接下载和体验。在使用爱星物联IoT平台之前,有哪些参数配置是嵌入式开发者必须配置的?小安带大家一起

强调:关于变频器,你必须知道的哪些事情?

分类选型 1) 采用变频的目的:恒压控制或恒流控制等。 2) 变频器的负载类型:如叶片泵或容积泵等,特别注意负载的性能曲线,性能曲线决定了应用时的方式方法。 3) 变频器与负载的匹配问题: I.电压匹配:变频器的额定电压与负载的额定电压相符。 II. 电流匹配:普通的离心泵,变频器的额定电流与电机的额定电流相符。对于特殊的负载如深水泵等则需要参考电机性能参数,以最大电流确定变频器电流和过载能力。 III.转矩匹配:这种情况在恒转矩负

5个必须知道的Pandas数据合并技巧

5个必须知道的Pandas数据合并技巧

评论